UNIVERSITÀ DI PISA

Dipartimento di Ingegneria Civile e Industriale

Corso di Laurea in

INGEGNERIA MECCANICA

METODI DI MODELLAZIONE A

SCALA LOCALE PER LA

METEOROLOGIA

Tesi di Laurea

5 marzo 2014

Anno accademico 2012-2013

Realatori:

Prof.Ing. Paolo Di Marco

Dott.Ing Roberto Gabbrielli

Candidato:

METODI DI MODELLAZIONE A SCALA

LOCALE PER LA METEOROLOGIA

di

Stefano Bechelli

Tesi proposta per il conseguimento

del titolo accademico di

DOTTORE IN INGEGNERIA MECCANICA

presso il Dipartimento di Ingegneria Civile e Industriale

dell'Università di Pisa

5 marzo 2014

Candidato :

Stefano Bechelli …...

Relatori:

Prof. Ing. Paolo Di Marco …...

Dott. Ing. Roberto Gabbrielli ...

Indice

Cap.1

1.1 Le previsioni meteorologiche, il loro ruolo nella

società moderna... pag.1

1.2 L'evoluzione del modo di prevedere il tempo negli

ultimi decenni... pag.3

1.3 L'approccio attuale al problema... pag.8

Cap.2

2.1 L'atmosfera: il sistema termodinamico... pag.10

2.2 L'atmosfera: il sistema dinamico... pag.14

2.3 Overview sui principali modelli di simulazione

atmosferica a scala globale: i GCM... pag.17

2.4 I modelli a mesoscala quale strumento più raffinato

per la previsione su domini ristretti... pag.20

Cap.3

3.1

Il modello WRF, la struttura e le coordinate

verticali ed orizzontali... pag.31

3.2 Il core del modello... pag.34

3.3 Schemi risolutori... pag.37

3.4 La griglia... pag.41

Cap.4

4.1 Running del modello su cluster Linux... pag.50

4.2 Fruizione e disponibilità dei dati... pag.52

Cap.5

5.1 Prospettive per il futuro... pag.53

Bibliografia... pag.55

CAPITOLO 1

1.1 Le previsioni meteorologiche ed il loro ruolo nella

società moderna.

Da sempre l'uomo, così come tutti gli esseri viventi, si è dovuto confrontare per la sua sopravvivenza anche con l'ambiente nel quale si è ritrovato a vivere e da sempre, le variabili ambientali, hanno influito in modo preponderante sull'evoluzione di ogni forma di vita. Questo sicuramente basta a comprendere perché, da tempi altrettanto lontani, la necessità di studiare certe manifestazioni della natura fosse così sentita.

Quelle babilonese e greca sono state le prime civiltà a concedere una particolare attenzione all'aspetto meteorologico del vivere quotidiano: Aristotele nel 340 a.C. scrive infatti μετεωρολογικά (in latino Meteorologica) con l'intento di dare una spiegazione a certi fenomeni celesti e meteorici. Da allora di strada ne è stata fatta davvero molta ma la meteorologia ed in senso più stretto, la scienza meteorologica, è da ritenersi a tutti gli effetti una disciplina moderna.

In una società così articolata come quella in cui viviamo, l'attenzione ad una corretta valutazione della componente meteorologica sta diventando preponderante: non si tratta più di aver bisogno di sapere semplicemente “che tempo farà”, piuttosto si richiede (ad esempio) di inserire l'informazione meteorologica tra le variabili di gestione di una azienda, di un impianto, così come tenerne stretto conto nella prevenzione e salvaguardia della salute pubblica, in ambiti ove spesso in gioco ci sono anche vite umane. A tanta importante richiesta sta facendo seguito una rincorsa sempre più accelerata verso sistemi predittivi raffinati ed affidabili che possano dare una risposta scientificamente esaustiva al problema.

Figura 1.1 Alcuni dei campi in cui la meteorologia è oggi maggiormente applicata

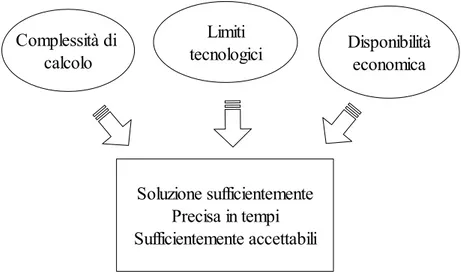

Larga parte del progresso in ambito meteorologico, ed in particolare nel suo settore di punta numerico-predittivo, deve il suo sviluppo alla costante crescita tecnologica adoperata dall'industria elettronica; i modelli di simulazione atmosferica sono infatti noti per la grande richiesta di capacità computazionale e questo, sostanzialmente, per per due motivi: il primo direttamente collegato alla complessità del modello stesso, il secondo ed ancora più gravoso del primo, legato alla necessità di avere risposte sufficientemente precise in tempi brevi. Chiariamo meglio questo aspetto: non ha nessun senso dal punto di vista predittivo, a meno in casi di re-analisi, elaborare una previsione meteorologica il cui risultato sia disponibile con ritardo rispetto alla data di previsione stessa ed ha ugualmente poco senso ottenere il medesimo risultato con scarso margine di operatività temporale. In ambito di Protezione Civile ad esempio, la necessità di conoscere l'evoluzione meteorologica con almeno 12-24 ore di anticipo è determinante per poter organizzare ed allertare il sistema preposto a fronteggiare le potenziali criticità che si potrebbero presentare sul territorio. D'altro canto, per avere corse modellistiche più snelle dal punto di vista temporale, due sono le variabili su cui poter giocare: la semplificazione dei calcoli a

Idrologia Energia Protezione Civile ... Logistica Meteorologia

discapito della precisione della previsione e l'incremento della potenza di calcolo, direttamente proporzionale all'investimento economico nell'hardware.

Figura 1.2 I principali fattori che concorrono nell'affrontare la modellazione atmosferica

Vale la pena a questo punto illustrare come e quanto sia cambiato in tempi

relativamente brevi, l'approccio alla meteorologia.

1.2 L'evoluzione nel modo di prevedere il tempo negli ultimi

decenni

Il cammino evolutivo nell'ambito predittivo atmosferico va, come già accennato, di pari passo con l'evolversi dei calcolatori e della loro potenza di calcolo. Fino alla metà del secolo scorso, la scienza meteorologica era fondamentalmente incentrata sull'osservazione, l'esame dei fenomeni atmosferici, in parte la loro misurazione ed il tentativo di spiegarne fisicamente la genesi, mentre, dal punto di vista predittivo, tutto si basava sul metodo sinottico. A parte alcuni tentativi attorno agli anni '20 di provare a risolvere manualmente alcune semplici equazioni che descrivevano in

Limiti tecnologici Complessità di calcolo Disponibilità economica Soluzione sufficientemente Precisa in tempi Sufficientemente accettabili

modo molto grossolano il sistema, i risultati migliori seguitarono per molti anni ad essere prodotti in modi empirici tra cui quello sinottico che è stato sicuramente il più efficiente. Tale metodo si avvaleva della possibilità tramite il telegrafo prima e poi della radio, di poter conoscere in tempo reale alcune delle grandezze base rilevate a terra dalle stazioni meteo, in primis, la pressione. Una volta noti i valori rilevati a scala continentale, a mano, si costruivano le prime carte del tempo sovente basate sul tracciamento delle isobare su mappa cartacea. L'andamento e la variazione di queste ultime, davano una idea degli spostamenti delle principali figure bariche facendo ipotizzare possibili scenari futuri in base ad estrapolazioni puramente empiriche dettate dall'esperienza del previsore.

Figura 1.3 Previsioni manuali con il metodo sinottico

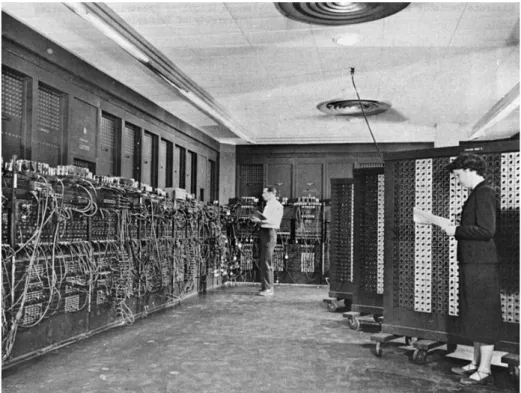

La prima previsione ottenuta con modelli numerici di un certo successo fu elaborata nel 1950 da un gruppo di meteorologi americani composto da Jule Charney, Philip Thompson e Larry Gates, oltre che dal meteorologo norvegese Ragnar Fjörtoft e dal matematico John von Neumann, che si avvalsero del computer digitale ENIAC. (fig.1.4) Per il calcolo utilizzarono una formula semplificata delle dinamiche atmosferiche basata sull'equazione della vorticità barotropica.

Tale semplificazione permise la riduzione dei tempi e della memoria richiesta dal computer, consentendo l'esecuzione dei calcoli da parte delle apparecchiature decisamente rudimentali che erano disponibili in quell'epoca.

Figura 1.4 Uno dei primi centri di calcolo dediti alla meteorologia

Di grande importanza fu poi, negli anni '60, l'arrivo dei primi modelli baroclini: questi si distinguevano da tutto ciò che era stato fatto in precedenza per la capacità di poter simulare anche i moti verticali dell'atmosfera, importantissimi per poter determinare la potenziale formazione delle nubi ed eventualmente valutarne una natura precipitativa. Tutto questo fu supportato da nuovi computer, di maggior potenza e versatilità come il modello IBM 7090 con le sue oltre 106 operazioni al

Sempre negli anni '60 e sempre grazie alle aumentate capacità di calcolo degli elaboratori elettronici, negli Stati Uniti, alla efficacia della baroclinicità fu affiancata la possibilità di risolvere in modo integrale alcune delle più importanti equazioni costituenti il sistema atmosferico. Fino ad allora, per necessità di semplificazione, queste venivano parametrizzate trascurano in modo grossolano molti termini con conseguenti forti errori tali da rendere spesso quasi inutile la previsione elaborata.

Fu poi a partire dagli anni '70 che i miglioramenti in ambito modellistico cominciarono a fare passi da gigante e questo, come già accennato, grazie in prima istanza alla vivacissima escalation delle performances dei centri di calcolo. Nella tabella 1.1 abbiamo riportato alcuni dati in merito. E' chiaro che una maggior disponibilità di potenza computazionale si può tradurre sia in un miglioramento qualitativo della previsione (modello descrivente più accurato) ma anche la possibilità di spingere i risultati verso orizzonti temporali più lunghi. Si passò infatti dall'avere previsioni a 24-48 ore fino ai 5-6 giorni a fine anni '80. Ad oggi i maggiori centri di calcolo elaborano su domini planetari previsioni deterministiche fine a 15 giorni.

Tabella 1.1 L'incremento delle prestazioni dei calcolatori

Abbiamo così già parlato di “modello atmosferico” : ma che cosa è esattamente? Per modello, in questo specifico ambito, si intende un insieme di algoritmi risolutori alla cui base stanno le equazioni che descrivono l'atmosfera, una insieme di routine

scritte in vari linguaggi di programmazione (tipicamente C, Fortran e Perl) che in output forniscono grandezze fisiche dello stato del “gas aria” in momenti futuri a partire da quello di inizializzazione e per diversi livelli di quota e spazio. Un modello si dice globale GCM (global circulation model) se il suo dominio è appunto tutto il pianeta mentre si distinguono da esso i modelli a mesoscala o scala ridotta LAM (limited area model) che sovente ereditano le condizioni sul bordo della loro griglia proprio dai modelli a scala planetaria. Ciò che viene calcolato durante la elaborazione di una previsione sono essenzialmente le equazioni differenziali con le quali si cerca di descrivere l'atmosfera per lo meno nei suoi aspetti più importanti; purtroppo tali equazioni sono di tipo non lineare dunque senza possibilità di risoluzione esatta: le tecniche di analisi numerica ci forniscono i mezzi per poterne trovare un risultato già di per sé approssimato che introduce, oltre a quelli dovuti a necessarie semplificazioni del problema, un ulteriore errore (ecco perchè ancora oggi i meteorologi sbagliano!) La principale tecnica di calcolo che viene usata nei “run” modellistici a scala ridotta è quella delle differenze finite applicata a tutte e tre le dimensioni spaziali mentre per quanto riguarda i modelli globali ci sono già diversi casi di trattazione con metodi spettrali. La necessità di operare su diverse scale è ancora una volta legata alle risorse disponibili: in linea generale ai più grandi super computer viene dato il compito di “chiudere” la simulazione su tutta la Terra mentre con i Lam si procede poi ad infittire la maglia di previsione traendo così risparmio di tempo, in modo analogo a come si procede per l'analisi di una struttura meccanica con “l'infittimento” del mesh nelle aree critiche della stessa. Oltretutto, i modelli ad area limitata, proprio per la loro principale caratteristica di presentare maglie talora molto strette (fino a 100m di lato) possono simulare fenomeni atmosferici che avvengono anche in volumi molto ridotti (es: la nascita e crescita di nubi convettive).

Un altro aspetto importante è quello che vede legato il passo temporale di risoluzione a quello spaziale, in altri termini avere una griglia spaziale più fitta permette di avere anche timestep più brevi: per avere un'idea si pensi che mediamente il passo temporale di un modello globale lavora su ∆T prossimi ai 15 min mentre un Lam, molto spesso si attesta su ∆T di qualche secondo.

Figura 1.5 Dai modelli a scala globale alle griglie più fini

1.3 L'approccio attuale al problema

I progressi evidenziati sinora solo in ambito modellistico-computazionale, si sono avuti anche in altri rami della meteorologia e della climatologia, con benefici importanti non solo, ad esempio, per la bontà e quantità dei dati da utilizzare come condizioni iniziali fornite in fase di inizializzazione dei processi modellistici ma anche nell'aver dato vita a tecniche di previsione del tutto differenti. In particolare si evidenzia tra queste il “nowcasting”, ovvero quella previsione a brevissima scadenza che non fa affidamento alla prognosi prospettata dalla risoluzione delle equazioni ma si fonda sulla osservazione dettagliata del tempo in atto; in tal senso una sorta di ritorno alle origini ma con il supporto di sofisticate apparecchiature che molto aggiungono al semplice rilievo di dati meteorologici. Si sono infatti sviluppati negli ultimi 50 anni importanti strumenti ormai diventati di uso comune ed in grado di dare indicazioni molto efficaci per l'elaborazione di una previsione in nowcasting, tra questi non possiamo non nominare i satelliti geostazionari e polari con, a bordo, radiometri sempre più potenti ed i radar doppler ormai disseminati anche su larga parte del territorio italiano.

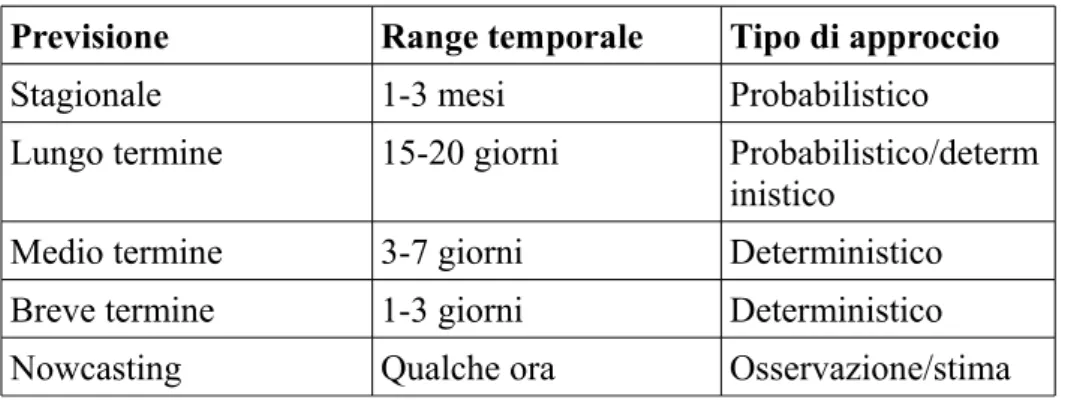

Il ramo di indagine predittivo, oggi, si muove seguendo diversi tipi di approcci al problema previsionale e questo essenzialmente a seconda del range temporale oggetto della previsione stessa. In tabella 1.2 se ne illustra una sintesi. E' immediato notare che, comunque, la maggior parte dei risultati viene affidata al metodo

deterministico ovvero quello che si occupa di risolvere, con tecniche che vedremo più avanti, le equazioni descriventi il sistema atmosferico.

Previsione Range temporale Tipo di approccio

Stagionale 1-3 mesi Probabilistico

Lungo termine 15-20 giorni Probabilistico/determ inistico

Medio termine 3-7 giorni Deterministico

Breve termine 1-3 giorni Deterministico

Nowcasting Qualche ora Osservazione/stima

CAPITOLO 2

2.1 L'atmosfera: il sistema termodinamico

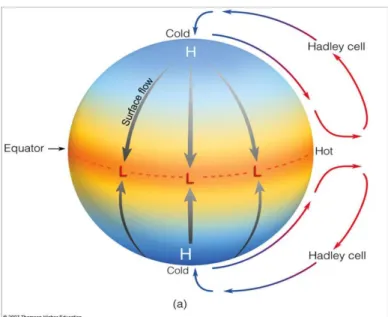

Prima di entrare nel merito della modellazione atmosferica è necessario cominciare a prendere confidenza con l'oggetto dello studio, il sistema atmosferico. In questo paragrafo se ne evidenzieranno le caratteristiche termodinamiche più importanti. E' ormai noto come tutta l'energia che determina lo spostamento delle masse d'aria in atmosfera sia dovuta al sole ed al suo irraggiamento: il riscaldamento sulle varie aree della terra non è uniforme e questo determina una differenza di temperatura tra le diverse zone che si traduce, a sua volta, in variazioni di volume e pressione dell'aria (pv=nRT) dando origine così ai venti. Quanto appena affermato risulta piuttosto evidente se consideriamo lo schema in figura 2.1 che illustra come l'irraggiamento possa essere considerato la causa principale della genesi dei venti.

Lo schema sopra riportato evidenzia in particolare la circolazione primaria dell'atmosfera ma in realtà, i movimenti al suolo sono molto più complessi ed articolati. Per capire i motivi di queste complicazioni è necessario analizzare quali fattori intervengono a mutare ulteriormente le variazioni della temperatura a scala più piccola.

• Dell'irraggiamento abbiamo già fatto cenno avendolo descritto come la modalità di scambio principe dell'energia tra sole e terra giacchè l'atmosfera è in gran parte trasparente alla luce solare.

• Una volta che la terra viene scaldata cede nuovamente energia sottoforma di radiazione infrarossa (calore) al quale il gas atmosferico è opaco: in parte assorbe una quota di questa energia, in parte ne riflette un altra quota e solo in piccola parte la disperde nell'universo.

All'interno dell'atmosfera, l'energia assorbita dalla terra viene assorbita e poi nuovamente riflessa ciclicamente, procedendo dalle quote più basse verso le aree più esterne della calotta di gas secondo un susseguirsi di scambi verticali.

• Un altro meccanismo di scambio di calore e variazione di temperature è dato dalla compressione-espansione del gas aria. A tal proposito si consideri una particella di aria che si muova verticalmente (tenda a salire di quota): facendo riferimento all'equazione di stato dei gas perfetti ed al primo principio della termodinamica possiamo descriverne la sua variazione di temperatura e di pressione

in cui p è la pressione, v il volume specifico, T la temperatura (K), R la costante dei gas, dq il calore scambiato dalla particella in moto e cv il calore specifico a

prima nella seconda otteniamo

(2.1)

nel caso di trasformazione a pressione costante possiamo scrivere dq = cp dT che

permette ricavare R =cp − cv e, con una sostituzione

(2.2)

se supponiamo che la particella durante l'ascesa non scambi calore (si muova lungo una adiabatica), possiamo scrivere

(2.3) che integrata fornisce la relazione di Poisson

(2.4)

La semplificazione di ascesa adiabatica della particella è abbastanza plausibile quando la velocità di ascesa sia piuttosto rapida, ovvero pensando che il tempo non sia sufficientemente lungo da permettere uno scambio di calore con l'esterno. Sotto questa ipotesi si ottiene un importante risultato fisico, ovvero , secondo la (2.4), la temperatura dell'aria scende di circa un grado ogni 100 m. Questo gradiente è noto anche come “gradiente di adiabatica secca” (dry adiabatic lapse rate) e lo si incontra così tanto frequentemente nella modellazione atmosferica poiché fornisce importanti informazioni sulla stabilità verticale della colonna d'aria. Prendiamo l'esempio classico di una particella che

venga spostata da una quota Z1 a quota Z2 in modo piuttosto veloce (come già

supposto precedentemente) in modo da poter supporre che si tratti di uno spostamento adiabatico, in tal caso, la stessa particella si raffredderà ad una temperatura T1 a quella T2p e si troverà a fine tragitto ad essere “immersa” in un ambiente a temperatura T2. Si possono così presentare tre casi distinti: 1. T2>T2p la temperatura del volume d'aria spostato è inferiore a quello dell'ambiente circostante, la risalita della particella verrà inibita da una spinta verso il basso con un'azione stabilizzante che riporterà la particella verso il basso;

2. T2<T2p la particella ha una temperature superiore a quella del gas circostante e dunque avendo una densità minore tenderà ulteriormente ad accelerare verso l'alto determinando condizioni di instabilità.

3. T3=T2p le temperature sono le medesime, la condizione è di neutralità.

• Altri scambi di calore e variazioni termiche si hanno per effetto dei passaggi di stato dell'acqua (evaporazione e condensazione). Ricordando la legge di Dalton pu = ps + e sappiamo che la pressione di un volume d'aria umida è data dalla somma del contributo dell'aria secca e quello del vapore acqueo. L'aria si dice satura quando contiene nel suo volume la quantità massima di vapore (dipendente dalla temperatura) la cui pressione viene denominata E. Tutto il vapore eccedente tale valore limite condensa in acqua allo stato liquido. Tornando alla particella d'aria in ascesa ed in raffreddamento, essa subirà anche una diminuzione della pressione di saturazione fino a raggiungere il limite E=e, da questo momento in poi ha inizio il processo di condensazione del vapore con cessione del calore latente di evaporazione e, quindi, una ulteriore spinta all'ascesa. Durante la fase di liberazione del calore latente di evaporazione il calo di temperatura del volumetto di aria umida in risalita è inferiore a quello che registrerebbe un volumetto di aria secca favorendo così un movimento di convezione. L'energia associata a questo fenomeno, detto anche gradiente di adiabatica satura, vale circa 6°C/Kg m.

2.2 L'atmosfera : il sistema dinamico

Analizzato in linea generale il comportamento termodinamico dell'atmosfera, si introdurranno adesso i principali aspetti dinamici della stessa. Una particella d'aria è soggetta ad una composizione di forze di cui una delle più importanti è sicuramente quella di pressione.

Figura 2.1 Le forze di pressione su di una particella d'aria

Lungo l'asse z avremo una forza −∂p/∂z così rispettivamente −∂p/∂x e −∂p/∂y lungo gli assi x ed y. Il flusso dell'aria che, specialmente a scale ampie osserva principalmente movimenti orizzontali sarà quindi determinato da −∂p/∂n ovvero dalla variazione lungo n (versore giacente sul piano x,y) della pressione in direzione perpendicolare alle linee isobare. Oltre alle forze di pressione, esistono a causa della non inerzialità del sistema atmosfera, forze apparenti che possono essere riassunte in termini di forze di Coriolis

dx dy dz (p-dp/dz dz)dx dy P dx dy (2.5) (2.6)

dove si intende con m, la massa del volume d'aria, con V la sua velocità osservata da un sistema di riferimento solidale alla terra ed Ω la velocità angolare della terra stessa. Proprio alla forza di Coriolis sono legati i movimenti rotatori che le figure alto e basso pressorie assumono.

Figura 2.2 L'effetto della forza di Coriolis

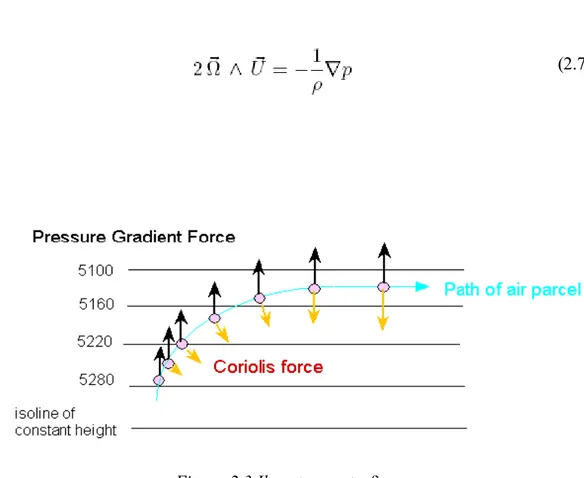

Infine un accenno alla forza di attrito. Negli strati più alti dell'atmosfera, ad una sufficiente distanza dal suolo, è possibile adottare l'approssimazione geostrofica ovvero di poter supporre che la singola particella d'aria si muova solamente per opera della forze di Coriolis e di gradiente pressorio, trascurando quindi la componente centrifuga del moto e gli effetti dell'attrito al suolo. Sotto queste ipotesi il flusso dell'aria procede parallelamente alle isobare secondo un moto stazionario detto anche vento geostrofico e rappresentato dall'equilibrio delle due forze citate (Fig. 2.3) e eq.2.7.

Figura 2.3 Il vento geostrofico

Nella condizione ideale di regime geostrofico si ricava la velocità del vento stesso secondo la seguente espressione:

L'approssimazione di non considerare gli effetti dell'attrito tra aria e terra non può essere ritenuta plausibile man mano che ci abbassiamo di quota, si individua così un limite e questa condizione detto anche strato limite atmosferico. Sopra tale limite (ABL acronimo di Atmospheric Bonduary Layer) si definisce l'atmosfera libera mentre a quote inferiori la frizione tra aria e terra determina un rallentamento ed una

deviazione del moto della corrente.

(2.7)

Figura 2.4 La deviazione dei venti in relazione alla quota

2.3 Overview sui principali modelli di simulazione

atmosferica a scala globale: i GCM (global circulation

model)

L'atmosfera, per quanto finora detto, appare senza dubbio un sistema molto complicato da studiare soprattutto perchè (e questo ancora non è stato affrontato) si compone di numerosissimi fenomeni fisici che spaziano dall'interessare aree di milioni di km2 ad aree di qualche mm2. Si pensi ad esempio ad un fenomeno vasto

come la ventilazione monsonica ad a quello decisamente a scala più ridotta del processo di condensazione del vapore d'acqua che determinerà una goccia di pioggia; ecco perchè si cerca di affrontare lo studio dell'atmosfera osservandola a diverse scale così da poter trascurare, a seconda dei casi, gli elementi quasi ininfluenti a quel livello di rappresentazione. La pratica comunque vuole individuati tre livelli di “zoom” ovvero la macroscala, la mesoscala e la microscala corrispondenti i primi

due rispettivamente alla scala sinottica e quella convettiva. E' importante sottolineare come si nota dalla figura 2.5 come ogni livello di scala sia caratterizzato anche da periodi temporali tipici: una previsione a livello sinottico, oltre coprire vaste distanze (centinaia di km) si spinge anche su lunghi periodi prognostici mentre scendendo con la dimensione spaziale si scende anche in termini di orizzonti temporali; in mesoscala difficilmente conviene andare oltre le 72 ore.

Tabella 2.1 Scala dei fenomeni meteo in relazione al tempo ed allo spazio

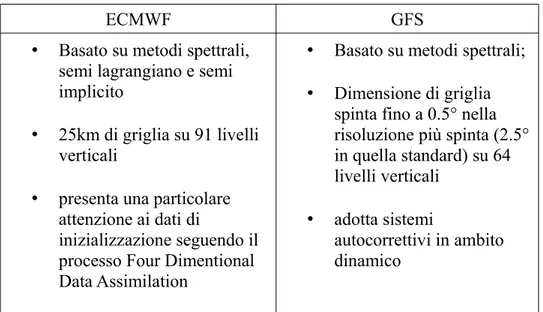

Dalle considerazioni spaziali e temporali sopra esposte discende come sia necessario, anche dal punto di vista modellistico, orientarsi in modo differente a seconda dei risultati che vogliamo ottenere: trattare la previsione dal punto di vista delle scale più grandi è tutt'oggi compito dei GCM mentre scendendo nel dettaglio (e quindi riducendo la sala) i calcoli vengo affidati ai LAM. Ad oggi i principali riferimenti in ambito di modellazione a scala globale sono due:

• l' European Centre for Mediumrange Weather Forecast (ECMWF) attivo sin dal 1973 a Reading (Uk) ove è implementato l'omonimo modello

• l’NCAR-National Center for Environmental Protection (NCEP) fondato in America nel 1988 ove viene computato il modello GFS

è interessante verificare come le peculiarità di ognuno (riportate in tabella 2.1) spesso determinino divergenze predittive anche importanti già oltre le 96 ore di previsione.

ECMWF GFS

• Basato su metodi spettrali, semi lagrangiano e semi implicito

• 25km di griglia su 91 livelli verticali

• presenta una particolare attenzione ai dati di

inizializzazione seguendo il processo Four Dimentional Data Assimilation

• Basato su metodi spettrali; • Dimensione di griglia

spinta fino a 0.5° nella risoluzione più spinta (2.5° in quella standard) su 64 livelli verticali

• adotta sistemi

autocorrettivi in ambito dinamico

Tabella 2.2 Principali caratteristiche dei due più importanti GCM

Uno dei compiti più importanti a cui assolvono tali modelli è quello di fornire le condizioni iniziali ed al contorno per le corse dei codici a mesoscala i quali, con un processo di nesting, ereditano dai GCM tali necessarie informazioni. Senza nulla togliere a centri di calcolo minori, anch'essi dotati di GCM (vd. GEOS per la Nasa, BOOM per la Cina, Navgem per la marina americana ecc...) la maggior parte delle previsioni meteo a larga scala, oggi, si basa sul confronto diretto tra i risultati dei due centri sopra citati. In figura 2.6 una mappa GFS per l'area americana.

Figura 2.6 Un esempio di output grafico GFS

2.4 I modelli a mesoscala: uno strumento più raffinato per

la previsione meteorologica su domini ristretti.

I modelli a mesoscala, a differenza di quelli a scala larga, si propongono di risolvere la previsione su domini molto più ridotti dal punto di vista spaziale ma anche di dettagliare i risultati su step temporali assai più fitti. Vale la pena fare una premessa importante: se è vero che in ultima analisi il compito dei LAM è quello di risolvere in autonomia equazioni anche molto più raffinate di quelle dei global model, è altrettanto vero che da essi, ereditandone le condizioni iniziali ed al contorno, ne ricevono anche gli errori. Capita non di rado infatti che, il medesimo LAM inizializzato con GFS e ECMWF presenti delle differenze talora non facilmente gestibili per chi poi dovrà stilare una previsione a livello regionale proprio a causa della propagazione dell'errore introdotto dalla griglia padre. Un altro punto importante che mina l'affidabilità dei modelli a mesoscala è la loro semplificazione geostrofica ed idrostatica. Entrambe le caratteristiche sono ben compatibili con le

risoluzioni sinottiche ma si adattano in modo più difficoltoso a domini localizzati ed operanti a latitudini extra tropicali: l'ipotesi geostrofica, ovvero l'equilibrio delle forze orizzontali di pressione con la forza di Coriolis, decade rapidamente al crescere della latitudine mentre quella di idrostaticità, ovvero supporre le velocità verticali dell'aria molto inferiori a quelle orizzontali, risulta inadatta a prevedere tutte le condizioni in cui i moti verticali sono importanti (sollevamento orografico, galleggiamento, gradiente di pressione verticale non idrostatico).

Un altro problema che si pone operando con la modellistica dell'atmosfera ed in quella a scala locale più in particolare, è quello della valutazione del “quanto” una griglia deve essere fitta. La risposta più immediata potrebbe essere di scegliere una griglia il più possibile densa così da osservare fenomeni di minima estensione spaziale; questo tuttavia comporta non pochi problemi, il primo dei quali derivato dalle limitate possibilità computazionali: dimezzare li lato di griglia significa aumentare considerevolmente il numero di operazioni da svolgere dato che, operando in tal senso, si quadruplicano i nodi e si dimezza il timestep con la conseguenza diretta di un allungamento più che esponenziale del tempo di risoluzione. Per quanto riguarda il numero dei livelli verticali, anch'essi devono tener conto delle grandezze da modellare e della loro estensione lungo questa dimensione: ecco perchè si ricorre ad un infittimento dei layer in prossimità della superficie ove sono più accentuati fenomeni dovuti all'irraggiamento ed evaporazione ed al top della stratosfera, al fine di valutare più finemente la corrente a getto.

Vi è poi l'aspetto altrettanto rilevante della parametrizzazione del suolo ed in particolare dell'orografia. Il maggior successo in area americana dei medesimi modelli a scala locale che vengono poi “fatti girare” anche su domini italiani è che molto spesso l'orografia Italiana risulta assai più complessa: spazi relativamente ridotti con notevoli irregolarità verticali inducono a dover spingere il dettaglio anche da questo punto di vista onde non sacrificare (e per questo incappare in ulteriori errori)componenti importanti del complesso meccanismo microclimatico che abbiamo.

Infine, un ultimo potente strumento che ci mette a disposizione la modellistica ad area limitata è la possibilità di operare con nesting di griglia più o meno spinti

potendo operare anche su domini molto piccoli (dell'ordine dei metri); tali domini “figli” o “innestati”, a loro volta, possono essere statici o mobili (si pensi all'utilità di lavorare con un nesting mobile se siamo interessati a seguire l'evoluzione di un fenomeno meteorologico piuttosto che l'evoluzione del tempo su di un'area fissa). L'operazione di nesting può avvenire secondo due tecniche: one-way e two-way a seconda di come la griglia innestata si comporta con l'eredità dai nodi del dominio su cui viene ritagliata. In tutti e due i casi il dominio superiore fornisce le condizioni al contorno ed iniziali per la griglia innestata ma, nel caso ad una via, la griglia più fine mantiene sui nodi coincidenti le soluzioni ereditate mentre nel caso a due vie, le soluzioni vengono rimpiazzate dal calcolo eseguito a livello inferiore. In figura 2.7 un esempio di infittimento dei nodi in ragione di 2:1.

Figura 2.8 Esempio di nesting geografico

Nonostante si possano adoperare raffinate operazioni di reimpianto di griglia al fine di ottenere celle sempre più piccole e di poter risolvere in modo diretto aspetti atmosferici propri delle microscale, è altrettanto vero che, nella realtà dei fatti, ci sono numerosi fenomeni che per loro estrema complessità non è possibile trattare in modo numericamente esatto; ecco perchè è sempre molto ampia anche nei modelli a mesoscala, la parte che prevede una parametrizzazione del problema. Ne riportiamo di seguito i principali ambiti.

La parametrizzazione microfisica delle nubi (dunque del vapore acqueo) è forse quella più incidente sui risultati finali di una previsione ed entra in gioco con due modalità, quella esplicita e quella implicita occupandosi rispettivamente della descrizione dei cambiamenti di fase del vapore e della sua convezione in atmosfera. Nel caso esplicito le equazioni sono incorporate direttamente all'interno del modello e tengono quindi conto dello stato del vapore in fase risolutoria, passo per passo, mentre per quanto riguarda il caso implicito si prendono soltanto i risultati della parametrizzazione convettiva delle nubi. Solitamente si tende ad utilizzare

contemporaneamente entrambi i sistemi. Le problematiche che sono legate alla microfisica del vapore d'acqua sono veramente molteplici e concatenate, se ne riassumono brevemente gli aspetti nello schema sottostante nel quale si evidenzia:

• la forte influenza del vapore nell'assorbimento del calore da parte della superficie terrestre e marina;

• la variazione che determina il medesimo vapore nella concentrazione degli aerosol nei bassi strati attraverso il meccanismo di trasferimento a terra (sia vedendo i corpuscoli come nuclei di condensazione delle microgocce sia come vero e proprio meccanismo di urto e trascinamento); da notare che, a sua volta, lo spessore delle nubi è nuovamente dipendente dalla quantità di particelle in sospensione : più particelle implicano gocce più piccole e nubi più spesse, poche particelle danno invece luogo a gocce più grandi e più facilmente precipitabili.

• La Velocità di caduta delle idrometeore ed i passaggi di fase durante la convezione nonché la variazione anche in questo processo della concentrazione del vapore stesso

Figura 2.9 Il vapore d'acqua influenza il sistema atmosferico in differenti modi, tutti non trascurabili nella parametrizzazione del fenomeno.

Attualmente si cerca di approfondire lo studio della microfisica puntando sul perfezionamento degli schemi che descrivono gli stati di mixaggio di fase e quelli relativi agli urti tra particella in caduta e nube. Entrambi gli aspetti sono ulteriormente complicati dal fatto che l'acqua, in atmosfera, si trova in svariate forme: citiamo a titolo di esempio le microgocce che stanno in sospensione, la gocce che cadono e che possono accrescere la loro dimensione urtando ed unendosi con altre gocce o microgocce mentre, in forma solida, i microcristalli di ghiaccio, cristalli, aghi, neve, neve tonda, grandine. Nel modello a scala locale che a breve analizzeremo, si possono trovare diverse tipologie di schemi parametrici di questi due ultimi aspetti visti.

Fig. 2.10 Gli stati di mix di fase ed i nuclei di condensazione

A seconda del lato di griglia a cui si opera, possono intervenire poi parametrizzazioni rappresentanti la genesi e l'evoluzione prettamente cumuliforme delle nubi. In tal caso si cerca di dare un peso ad effetti che avvengono a scale inferiori di quelle della cella (tipicamente questo avviene con maglie non più piccole di 5-7km di lato) come i moti ascendenti e di discesa nonché la caratterizzazione igrometrica e termica della colonna d'aria sovrastante la singola maglia.

Figura 2.11 Processo di formazione dei cumuli

Parametrizzazione del flusso di radiazione. Viene effettuato attraverso semplificazioni che permettano di calcolare il flusso radiante pertinente ad ogni singola maglia di dominio specialmente il flusso di radiazione al suolo per valutare gli scambi con la superficie terrestre e quello verticale, lungo la colonna d'aria, essenziale per considerare riscaldamenti o raffreddamenti della stessa. Si parla di soluzioni per radiazioni sia ad onda lunga che corta, la prima come espressione della riflessività della terra e dell'aria, la seconda come quella della radiazione solare.

Parametrizzazione degli strati si superficie. Valutano attrito, scambio di calore e vapore con la superficie sia essa intesa come area confine tra aria e suolo sia tra aria ed aria secondo i vari livelli degli strati limite atmosferici (Planetary bonduary layer).

l

CAPITOLO 3

3.1 Il modello WRF, la struttura e le coordinate verticali ed

orizzontali.

Entriamo dunque nel merito della modellazione operativa prendendo in esame WRF come modello ed ARW quale core risolutore adottato nella previsione meteorologica sui domini pisano e toscano. Innanzitutto il modello WRF è un modello di mesoscala sviluppato tra NCAR Mesoscale and Microscale Meteorology (MMM) Division, NOAA, NCEP, Forecast SystemLabortory (FSL), Air Force Weather Agency (AFWA), Naval ResearchLaboratory(NRL), Center for Analysis and Prediction of Storms(CAPS), Federal Aviation Administration (FAA) e alcune università ed il contributo diretto di studiosi e cultori della materia. I suoi core principali sono appunto l'ARW (eulerian mass solver) e l'NMM (non hydrostatic mesoscale model) il primo sviluppato e promosso dal NCAR ed il secondo dall'NCEP. Come si evince dallo schema sottostante, i due core condividono gran parte dell'architettura WRF.

Quali sono le grandezze predette dal core ARW? L’ARW risolve un sistema di equazioni euleriane, non idrostatiche, comprimibili, che sono conservative rispetto alle variabili scalari. Le variabili prognostiche sono le componenti orizzontali u e v della velocità, la componente verticale w, la perturbazione della temperatura potenziale, la perturbazione del geopotenziale e la pressione dell’aria secca di superficie. Altre variabili prognostiche sono l’energia cinetica turbolenta, il rapporto di mescolanza del vapor d’acqua, il rapporto di mescolanza della pioggia e della neve, il rapporto di mescolanza di nube in relazione all’acqua e al ghiaccio e le specie chimiche.

La coordinata verticale. Contrariamente a quanto ci si potrebbe aspettare, la coordinata verticale che descrive la colonna d'aria sopra ogni singola cella non viene misurata secondo z adottando una lunghezza, piuttosto ci si riferisce ad una coordinata “eta” di pressione idrostatica detta di tipo “terrain following”: questa scelta infatti è motivata dal fatto che in tal maniera si possono descrivere le variazioni altimetriche del suolo e, nello stesso tempo, rendere le equazioni euleriane molto simili ad equazioni idrostatiche in coordinate isobariche.

La coordinata η è definita secondo quanto segue:

mentre il termine μ rappresenta il peso della colonna d'aria sopra l'area avente baricentro in (x,y).

I calcoli ed i risultati forniti dalle equazioni di modellazione atmosferica si riferiscono a domini che appartengono sempre alla quasi sfera terrestre, c'è però poi la necessità di trasferire tali risultati su di un piano così come avviene anche per la banale rappresentazione delle grandezze geografiche. Le relazioni geometriche che legano la rappresentazione tridimensionale a quella planare sono anch'esse parte del modello. Per quanto riguarda gli scopi meteorologici, la caratteristica più importante a cui è bene che assolva una proiezione, è quella della “conformità” ovvero della conservazione degli angoli tra due curve.

Figura 3.3 Proiezioni cartografiche previste

(3.1)

Nei modelli LAM, che impiegano un sistema di coordinate cartesiano sulla superficie di proiezione e risolvono su questa le equazioni, la trasformazione tra la superficie sferica e la superficie piana di proiezione, è una parte integrante delle equazioni stesse. I valori rilevati, per esempio, in punti individuati in coordinate lat-long, devono essere applicati nei punti di opportune coordinate cartesiane sulla griglia di calcolo posta sulla superficie piana di proiezione. A causa dell’effetto di distorsione della proiezione, le dimensioni di griglia usate nelle equazioni alle differenze finite devono rispecchiare la distanza vera tra due punti sulla superficie sferica. La Fig. 3.4 mostra come la griglia di calcolo definita sulla superficie di proiezione venga distorta sulla superficie sferica: i punti di calcolo sono equidistanziati sulla griglia ma non lo sono sulla superficie fisica per cui la distanza tra di essi varia secondo la posizione. La misura di tale distorsione è introdotta nelle equazioni attraverso un un fattore di scala detto map factor

Nel caso di una proiezione stereografica, il medesimo fattore di scala si scrive

Figura 3.4 La correzione nel caso stereografico

(3.3)

3.2 Il core del modello

Vediamo dunque quali siano le equazioni che effettivamente il core ARW si propone di risolvere. Tralasciando i passaggi matematici del caso che provvedono alla trasformazione della coordinata z in coordinata η avendo considerato il fattore di mappa ed una nuova espressione delle varie velocità così riscritte in cui (u, v, w) sono le componenti controvarianti del vettore velocità ed la componente covarianteἠ della nuova velocità verticale.

Si ottiene questa serie di equazioni prognostiche

(3.5) (3.6) (3.7) (3.8) (3.9) (3.10) (3.11) (3.12) (3.13) (3.14)

mentre queste altre di tipo diagnostico

equazioni che vengono ulteriormente riviste per il calcolo modellistico riscrivendole secondo la forma delle piccoli perturbazioni delle variabili: si definiscono quindi nuove variabili funzione solo della coordinata z. Questo procedimento permette di limitare gli errori nel calcolo introdotti dal troncamento del gradiente di pressione in orizzontale e dal gradiente verticale.

Le superfici di riferimento p, φ e α saranno quindi funzioni delle coordinate x, y e della coordinata verticale terrain following η. Nell’espressione del gradiente di pressione il termine idrostatico potrà essere eliminato senza commettere nessuna approssimazione. Le Eq. (3.22), Eq. (3.23), Eq. (3.24) sono le equazioni di bilancio della quantità di moto, l’Eq. (3.26) rappresenta l’equazione di continuità, l’Eq. (2.27) del geopotenziale, l’Eq. (3.25) e l’Eq. (3.28) sono le equazioni della temperatura potenziale e di bilancio delle specie chimiche mentre le Eq. (3.29) e Eq. (3.30) sono rispettivamente l’equazione di equilibrio idrostatico e di stato.

(3.15) (3.16) (3.17) (3.18) (3.19) (3.20) (3.21)

In definitiva possiamo scrivere in forma compatta e riunendo in un unico vettore tutte le variabili che saranno risolte

(3.22) (3.23) (3.24) (3.25) (3.26) (3.27) (3.28) (3.29) (3.30) (3.31)

3.3 Schemi risolutori

Per la risoluzione delle equazioni descritte poco avanti, il modello wrf si affida ad uno schema esplicito di discretizzazione temporale. Poiché i fenomeni che si descrivono hanno una evoluzione temporale differente si fa ricorso a tecniche di time-splitting ovvero “tarando” il time step solitamente su due valori differenti: il più breve per la risoluzione delle onde acustiche e gravitazionali ed il più lungo per quella dei fenomeni più propriamente meteorologici. Più in particolare, lo schema esplicito adottato è caratterizzato dall'avere due passi (multipasso) predictor-correttor: il primo step è quello predittore ed il secondo quello correttore. Riportiamo un esempio in cui Ө* sia la soluzione intermedia (Lax-Wendroff), il passo predictor

calcola la variabile dipendente a metà del passo di calcolo mentre nella fase corrector la variabile calcolata viene utilizzata tra le forzanti .

Le due tecniche di integrazione time-splitting che vengono usate in wrf sono quelle di Runge-Kutta nelle versioni 2 e 3. Per le limitazioni di stabilità e di possibilità di scelta del timestep che derivano dal metodo RK2, l'RK3 è sempre più spesso (sebbene costi di più in termini computazionali) il procedimento più usato. I passi che segue RK3 per avanzare di uno step sono tre dove il ΔT è quello a frequenza più bassa mentre Φ è il vettore delle variabili prognostiche.

(3.32) (3.33) (3.34)

La discretizzazione spaziale è invece trattata attraverso un approccio semi-lagrangiano: si insegue come si conviene nei modelli lagrangiani la particella ma, in questo caso, ad ogni timestep essa viene ridefinita. In sostanza, di passo in passo, vengono adoperate soluzioni lagrangiane che però cambiano gli argomenti (le particelle osservate) ad ogni passo. Per procedere in tal senso si possono seguire due vie:

• si considera la posizione delle particelle nelle stato iniziale T e nel successivo passo temporale Δt, le particelle seguiranno una loro traiettoria dipendente dal campo delle velocità ma si conserverà la caratteristica X della particella. Dunque, in base alle posizioni finali si procede ad una interpolazione della grandezza stessa andando a valutarne un valore nei punti di griglia iniziali. • L'altro metodo per calcolare la grandezza x nei punti di griglia al tempo t+ Δt

è quello di partire dai punti di griglia fissi e fare un passo indietro per interpolare la grandezza x sulla griglia nella condizione di partenza (al passo precedente).

Nel caso reale, la grandezza X non si conserverà per ogni particella dunque ci troveremo nella condizione

ponendo quindi

ci troveremo o nel caso di risoluzione implicita con F calcolata direttamente nei punti del reticolo mentre nella posizione di partenza attraverso una interpolazione

(3.35)

od esplicita in cui debbono essere rispettate le condizioni di traiettorie non incrociate e la necessità che i punti finali siano ancora dentro il reticolo di griglia.

Abbiamo visto come il metodo di Rouge-Kutta nella versione 3 sia quello più usato nella risoluzione delle equazioni del WRF e come esso si basi sulla presenza di un doppio timestep al fine di descrivere più adeguatamente fenomeni meteorologici ( Δt più ampio) e fenomeni acustici e gravitazionali ( Δt più stretto). Per la scelta del passo di frequenza più basso occorre tenere conto della stabilità della soluzione e questo avviene valutando il Δt secondo questa relazione dove con CTL si indica il Courant-Friedrichs-Lewy-Number.

si noti la relazione tra il Δt il CFL ed il grado di schema di flusso.

Tabella 3.1 Stabilità degli schemi risolutori

(3.37)

(3.38)

(3.39) (3.40)

3.4 La griglia

Il modello WRF “gira” su una griglia denominata Arakawa-c, ove le componenti di velocità vengono definite sulle facce della cella mentre tutte le altre al centro della cella stessa; si parla per questo di griglia sfalsata dato che le grandezze sopra citate risultano shiftate di mezza cella.

Figura 3.5 Griglia orizzontale e verticale

Per quanto detto in precedenza inoltre, nel piano orizzontale la griglia si presenta a maglia costante mentre in verticale, le variazioni della variabile eta non sono costanti da passo a passo: si rammenti l'importanza di infittire i layer di analisi in prossimità del suolo ed al top della cella al fine di avere una rappresentazione più aderente alla realtà proprio dove si innescano i fenomeni più difficilmente calcolabili.

Una simulazione ARW coinvolge una maglia padre che può contenere più griglie nidificate (nestate o figlie). Ogni area nestata deve essere interamente contenuta all'interno della griglia superiore (la griglia principale). Le griglie figlie sono anche padri quando si utilizzano più livelli di nidificazione e possono condividere la stessa griglia padre . La griglia fine può consistere in un dominio statico o può essere un nesting dinamico con spostamenti incrementali prescritti. Non sono permesse sovrapposizioni di maglia.

Figura 3.6 Tipi di nesting permessi

Figura 3.7 Infittimento delle celle

Nell'esempio sopra si riporta l'esempio di una griglia Arkawa-C con un innesto di griglia avente rapporto 3:1. A linea piena sono indicate le celle del dominio padre mentre a linea tratteggiata quelle del dominio nestato. Si noti inoltre come anche qui le componenti u e v della velocità siano calcolati sui lati delle celle mentre le variabili termodinamiche siano definite nel centro delle medesime. Con le lettere maiuscole si rappresentano i valori calcolati con il primo dominio mentre con le lettere più piccole i valori trovati durante la fase di nesting. Sul bordo del dominio

più piccolo i valori della griglia figlia sostituiscono quelli della griglia padre.

Inizializzazione del modello con condizioni iniziali ed al contorno. La suite di codice che si occupa di fornire tutte le informazioni necessarie alla inizializzazione del modello risiede nel WPS (Wrf Preprocessing System); come illustrato nello schema riportato, in input sono previsti due tipi di dati: statici e dinamici. I dati statici sono quelli geografici comprendenti le informazioni relative all'orografia del dominio selezionato, la presenza di eventuali laghi o mari ed in genere tutto quello che in superficie non varia con il tempo. I dati dinamici sono quelli meteorologici che spesso fanno capo a set derivati da output di modelli a larga scala e poi ridistribuiti in formato GRIB (Gridded Binary Data).

Figura 3.8 La fase di preprocessamento dei dati

Il file grib è un particolare tipo codifica usata nella diffusione dei dati meteorologici georeferenziati. Ogni file contiene dei record, ciascuno per ogni parametro (es. pressione al suolo, coordinata v del vento medio a 2m...) ad ogni altezza e tempo . Le sezioni di ogni record sono 6 delle quali la sezione 4 contiene il dato vero e proprio mentre le altre sezioni danno informazioni aggiuntive al dato stesso.

Le 6 sezioni sono definite come segue: (0) La sezione Indicator

(1) La sezione Definizione del prodotto (PDS) (2) Griglia Descrizione Sezione (GDS) - opzionale (3) La sezione Bit Map (BMS) - opzionale

(4) La sezione dati binari (BDS) (5) '7777 '(caratteri ASCII)

Per quanto riguarda“'l'aggiustamento” dei dati nel caso essi siano di bordo avvenga secondo un metodo di rilassamento della griglia: si procede cioè a raccordare il dominio su cui si opera con le condizioni ereditate dai dati in ingresso attraverso celle più fitte al fine di limare discontinuità troppo evidenti e che introdurrebbero difficoltà di calcolo.

CAPITOLO 4

4.1 Running del modello su un cluster Linux

Quanto sarà esposto da ora in avanti, riguarda l'implementazione del WRF 3.5 su di un cluster linux a 6 nodi ognuno dei quali con le seguenti caratteristiche:

• processore 8-core • 8Gb ram

• 1 tera hd • lan 1000Mb

• So linux ubuntu 13.*

L'operatività del modello è continuativa dal 2005 mentre in precedenza si è operato con il codice MM5, abbandonato poi per il subentro del più performante WRF sebbene maggiormente oneroso dal punto di vista della richiesta di prestazioni . Attualmente si opera su tre domini nestati, secondo lo schema delle operazioni riportato in tabella: Dominio Copertura temporale (ore) 00Z 06Z 12Z 18Z Italia 96 x x x x Toscana 72 x - x -Provincia di Pisa 48 x - -

-Tabella 4.1 Disponibilità dei run

Gli orari riportati (00Z, 06Z, 12Z, 18Z) rappresentano l'ora di inizio run del modello globale padre, in questo caso GFS (alternativamente ECMWF), con il quale si è scelto di inizializzare il Lam. Questo processo seppur in se stesso piuttosto semplice (si tratta di effettuare un download di file grib sui server nomads.noaa.gov) rappresenta comunque un punto critico della catena. I dati sono disponibili sui server nomads mediamente dopo 5 ore dall'avvio del run stesso così che il Lam, lavorerà già su dati “vecchi” ; un altro lag di tempo è poi imputabile alla velocità di trasferimento degli stessi files che constano mediamente in circa 18Mb a tela trioraria. Rapidamente si intuisce che per una simulazione di 96 ore (4 giorni), occorre prevedere ad ogni ciclo un download di (18*8*4)Mb il chè comporta, con una connessione che solitamente non supera i 4 Mb/s un tempo di download di circa 20/30minuti. La sommatoria dei tempi di calcolo e dei tempi per le operazioni accessorie è un parametro di fondamentale importanza per definire come ripartire il carico di lavoro sul cluster.

Come evidenziato nella figura 4.2, il tempo medio di tutto il processo, dalla acquisizione dei dati all'output rielaborato, impiega circa 3.45 ore, a significare che una previsione del Lam è disponibile circa 8-9 ore dopo l'avvio del run del modello padre. In sostanza, ci confrontiamo con risultati dipendenti da condizioni osservate almeno 10/12 ore prima. Per ovviare in parte agli errori predittivi indotti da questo ritardo, si procede talora, dopo il download dei dati del modello padre per l'inizializzazione, ad un inserimento “manuale” di rilevazioni più fresche attingendo alle osservazioni di stazioni meteorologiche presenti sull'area del dominio(massimo ritardo 5 minuti) compendiate da ulteriori informazioni provenienti dal satellite (massimo ritardo 15 minuti). Con tale espediente si è vista un miglioramento della affidabilità pari a circa il 3-4% sulle prime 12 ore di previsione.

Figura 4.2 Sequenza temporale e tempi medi di esecuzione

I parametri fisici calcolati di default dal modello sono riportati in forma estesa in appendice, quelli che invece vengono usualmente trattati graficamente su mappa sono:

• precipitazioni cumulate (mm/m2) sulle 3,6,12,24,36 ore precedenti e con

discriminazione tra pioggia e neve;

Download dati 30min

Completamento catena WRF 3 ore

Diffusione ed elaborazione dati 15 min

Tempo totale 3.45 ore

• temperature alla coordinata pressoria verticale di 850hPa, 700hPa, 500hPa (°C);

• altezze geopotenziali (altezze in decametri sulla superficie del mare ) riferite ai livelli di 850 hPa e 500 hPa (gpdam);

• quota zero termico (m);

• temperature a 2 metri dal sulo (°C);

• venti (direzione e velocità, di raffica e medi) a 2m, 10m. 850hPa, 500hPa, 300hPa, 200hPa, 10hPa (m/s);

• umidità relativa % a 925hPa, 850hPa, 700hPa, 500hPa, 300hPa;

• Cape ovvero l'energia potenziale convettiva disponibile (J/Kg) e Cin, energia di inibizione (J/Kg) quali espressione della potenzialità temporalesca dell'aria.

In figura 4.2 riportiamo un esempio grafico risultante dal “plotting” delle variabili mix precipitazioni totali sulle tre ore e temperatura ad 850hPa sul dominio più ampio previsto sul cluster. Per ottenere questo tipo di elaborazione si utilizzano software esterni al modello tra i quali citiamo il noto Grads (Grid Analysis and Display System

Figura 4.4 Previsione temperatura al suolo su dominio toscano

La parte più importante dopo la modellazione su dominio è la verifica a posteriori di ciò che è stato prognosticato dal modello: in sostanza valutarne la bontà predittiva in relazione a ciò che effettivamente si è misurato ad evento accaduto. Le considerazioni statistiche in tale ambito si preoccupano di valutare aspetti diversi del medesimo problema.

• La affidabilità temporale: riguarda la precisione nel collocare nel tempo un determinato fenomeno. Tale caratteristica è fortemente connessa alle condizioni iniziali fornite dai modelli a scala globale e proprio per questo di difficile manipolazione con interventi diretti sugli schemi risolutori del LAM. Una tecnica che può essere impiegata per apportare migliorie in tal senso è quella di assumere come condizioni iniziali non quelle acquisite tout court dall'ultimo run del modello padre bensì di rielaborane di nuove attraverso una ponderazione sulle ultime 2/3 uscite. In sostanza per una inizializzazione delle 00z, si valutano i run padre delle 00z, delle 18z e delle 12z (precedenti). • La affidabilità spaziale: si valuta quanto la localizzazione delle precipitazioni

sia effettivamente corrispondente alla distribuzione sul territorio. I Lam, da questo punto di vista, sono molto sensibili a variazioni significative correlate alla bontà della rappresentazione orografica. Il modello WRF con il setup considerato fino ad adesso prevede la rappresentazione del suolo tramite dati GTOPO30 (definizione di lato 1 km circa) che hanno una buona risoluzione sia orizzontale che verticale. Nonostante ciò, un maggior dettaglio specie in certe zone geografiche, abbiamo visto possa portare notevoli miglioramenti nella previsione, sia delle idrometeore che nelle correnti di superficie.

• La affidabilità su parametro predetto: non tutte le variabili in uscita dal computo modellistico presentano lo stesso grado di affidabilità, per fare un esempio è molto più “facile” avere una previsione corretta sul vento a 500hPa che non la determinazione della quota dello zero termico in caso di precipitazioni; va da sé che l'impatto sul territorio dei due casi sia profondamente differente: se prediamo il caso di Pisa, prevedere una quota di attecchimento della nevicata a 100m o a 0m può determinare un disagio ben

diverso per la popolazione (e per chi dovrà gestire l'eventuale emergenza).

Figura 4.6 Affidabilità % di una previsione nel tempo (sono stati presi come parametri di riferimento la temperatura e la pioggia)

Figura 4.7 Affidabilità % della previsione a 24 ore su fenomeno

24 ore 48 ore 72 ore 96 ore 120 ore 0 10 20 30 40 50 60 70 80 90 100 Affidabilità* Parametro Pioggia Paramentro neve

Pioggia Neve Vento Temporali Grandine Trombe d'aria 0 10 20 30 40 50 60 70 80 90 100

Vogliamo riportare il caso specifico delle abbondati precipitazioni verificatesi durante il mese di gennaio 2014 che hanno determinato lo stato di allerta elevata per il bacino del fiume Arno ed in particolare per la città di Pisa. Naturalmente il problema non sono state le precipitazioni sulla città, bensì quelle su tutto il bacino.

Figura 4.7 La previsione elaborata il 30 gennai, cumulati totali su 24 ore

Come è intuitivo notare dai dati registrati a posteriori dalla rete di stazioni del Centro Funzionale della Toscana in figura 4.8, la proiezione sui cumulati totali nelle 24 ore fornita con un anticipo di circa una giornata, ha dato indicazioni soddisfacenti sia per quanto riguarda la quantità di pioggia caduta sia nell'individuazione delle aree maggiormente colpite dal maltempo. Lo scarto sui picchi previsti in provincia di Pistoia ed in area metallifero-grossetana (le più stressate) è stato inferiore al 10% che è una performance di tutto rispetto visto i quantitativi di pioggia in gioco e vista anche la particolare configurazione meteorologica che li ha generati (non entriamo qui nel dettaglio della questione). Dalla medesima analisi si nota invece una sottostima delle precipitazioni in area fiorentina dovuta per lo più ad una valutazione troppo esasperata dell'effetto stau offerto dalle alture chiantigiane in caso di flussi tesi meridionali; la parziale ombra pluviometrica è stata inoltre accentuata dall'aver impostato un fattore di amplificazione orografica di circa 1.2 ovvero aver amplificato l'altimetria del dominio del 20% rispetto ai dati in input di GTOPO30.

4.2 Fruizione e disponibilità dei dati.

L'uso che principalmente viene fatto dei dati grezzi da modello, siano essi in formato numerico che grafico, può essere riassunto dalla figura 4.9. Una prima destinazione è quella che vede l'impiego delle simulazione a maglia stretta come parte integrante di ulteriori codici di modellazione, in particolare nei due campi della idrologia e della dispersione degli inquinanti. In ambito idrologico, come ipotizzabile, i dati di maggiore interesse sono quelli relativi alla previsione delle idrometeore e della quantità d'acqua precipitabile al suolo mentre, nella valutazione della dispersione degli inquinanti, l'attenzione è rivolta non solo ai fenomeni precipitativi ma anche e soprattutto al vento. L'altra grande area di utilizzo dei risultati è quella più diretta delle previsioni meteorologiche, siano esse rielaborate dall'esperienza di personale addetto che formulate matematicamente da algoritmi appositamente creati. Negli ultimi 10 anni c'è stato un forte sviluppo delle previsioni così dette “automatiche” ovvero quelle che vengono proposte al pubblico senza alcun intervento diretto dell'uomo. Tale strada è tutt'ora fortemente battuta grazie all'avvento delle “app” per dispositivi mobili. Il ruolo dei Lam nella previsione

automatica che solitamente propone indicazioni sul tempo a scala comunale, è primario: si usano solitamente a tal scopo maglie con circa 1.5-2.0 km di lato e si interpolano i valori medi sulle celle che “ricoprono” l'area di interesse applicando una ulteriore correzione nella valutazione dell'orografia.

Figura 4.9 L'impiego dei dati da modello: l'utilizzo grezzo per l'avvio di nuove tipologie di simulazione e l'elaborazione di previsioni automatiche e l'utilizzo

interpretativo da parte di personale tecnico.

OUTPUT MODELLISTICO

Lam Simulazione

dispersione

Previsioni automatiche App

Inizializzazione modelli idrografici

CAPITOLO 5

5.1 Conclusioni e prospettive future

La modellazione a scala locale ha fatto sicuramente grandi passi negli ultimi 20 anni, le indicazioni che oggi possiamo ottenere attraverso le simulazioni a scala ridotta anche con risorse economiche limitate, sono di sicuro interesse e trovano svariati campi di applicazione. Come mostrato, l'indice di affidabilità di una previsione è decisamente elevato specie se consideriamo un lasso temporale inferiore alle 48 ore. Tutto questo però non deve darci l'erronea percezione di poter contare su certezze meteorologiche, sarebbe un grave errore.

Le prospettive future in ambito di modellazione dell'atmosfera stanno scommettendo di pari passo su due facce della medesima medaglia: affinare le potenzialità predittive sul medio e lungo termine fino a spingere il campo di indagine ad orizzonti stagionali ed incrementare la precisione della simulazione a breve e brevissimo termine tanto da poterla rendere disponibile come strumento di “quasi-nowcasting”.

A favore A sfavore

• Potenza di calcolo a costi più bassi

• Infittimento delle rilevazioni da terra

• Ausilio di dati dallo spazio • Possibilità di parametrizzare

in modo più efficiente

• Richieste sempre più onerose esigenti in termini di precisione ed estensione temporale

• Incremento di fenomeni ad alto contenuto energetico su piccola scala

Tabella 5.1 Prospettive future della modellazione ad area limitata, fattori a favore e sfavore.

Una grande spinta in tutto ciò seguita ad arrivare dai continui progressi in campo informatico e tecnologico: la capacità di calcolo ha un prezzo sempre più basso mentre la rilevazione dei dati atmosferici, come abbiamo visto necessari ad inizializzare i processi di simulazione, sta divenendo sempre più fine e di rapido accesso. I punti più deboli su cui intervenire a livello dei metodi di modellazione sono sicuramente le parametrizzazioni dei fenomeni non lineari, speice quelli a scala più piccola; oltretutto, proprio nell'ultimo decennio si è avuto un forte incremento di eventi meteorici “ad alta energia e piccola scala” quali ad esempio temporali particolarmente violenti, trombe d'aria, alluvioni lampo, tutti eventi di difficile previsione (se non quasi impossibile) ma di forte impatto sul territorio e le persone. La necessità di puntare alla risoluzione anche se parziale delle lacune che i modelli presentano in queste situazioni è sempre più auspicabile anche se di difficile attuazione.

E' stato molto interessante durante questa ultima stagione autunno-invernale verificare come l'istituto meteorologico americano e russo si siano fronteggiati prevedendo, a novembre, un inverno mite e piovoso il primo e freddo ed asciutto il secondo: che sia stata veritiera la previsione americana conta fino ad un certo punto, deve invece far riflettere come ancora, nonostante tutto ed a parità di risorse tecniche e di know-how, si riescano a trovare soluzioni così divergenti.

Il codice del solutore WRF di cui abbiamo trattato in questa esposizione è esso stesso oggetto di continui update grazie anche ai non trascurabili contributi degli utilizzatori; nell'ottica di un piccolo centro di calcolo, l'obbiettivo dei prossimi 3 anni sarà quello di potenziare ulteriormente la struttura hardware e la connettività così da ridurre i tempi di trasferimento dati e di calcolo al fine di compensare, almeno in parte, la maggior richiesta computazionale che, fisiologicamente, le migliorie introdotte a livello solutorio determineranno.

Un'altra considerazione dal respiro più ampio riguarda quanto oggi la nostra società sia condizionata dal tempo meteorologico: sicuramente non poco. Si affidano alle previsioni meteorologiche ruoli sempre più importanti spesso chiedendo fin troppo; questo deve far riflettere sulla necessità di potare avanti programmi di ricerca ed incentivare lo studio della materia anche sul territorio nazionale giacchè gran

parte dei risultati che oggi si sono raggiunti derivano da contributi esteri.

Saremo mai padroni del tempo? Sicuramente la previsione meteorologica conserva ampi margini di miglioramento raggiungibili anche in tempi piuttosto brevi ma la certezza matematica di poter conoscere in ogni suo dettaglio “le volontà” dell'atmosfera sarà ben difficile da ottenere: le variabili in gioco sono veramente molte, interconnesse ed in molti casi di difficile manipolazione. Mentre la Cina da tempo rende pubblici esperimenti sull'inseminazione delle nubi (ma qui si tratta di modificare il clima e non prevederne le mosse) ed il Giappone studia le previsioni per i vari quartieri di Tokyo, la verità è che la strada verso la previsione “quasi perfetta” è ancora molto lunga; del resto la sfida tra l'uomo ed il clima è sempre stata una delle battaglie più combattute e probabilmente tale rimarrà per molto tempo ancora.