Facolt`

a di Ingegneria

Laurea Specialistica in Ingegneria

dell’Automazione

Tesi di Laurea

utilizzo in tempo reale di

informazioni visive stereo per il

controllo in sicurezza di un

manipolatore robotico in presenza

di operatori umani

Candidato

Fabrizio Flacco

Relatori

Prof. Antonio Bicchi Prof. Andrea Caiti Ing. Riccardo Schiavi

Sessione di Laurea del 04/12/2007

Archivio tesi Laurea Specialistica in Ingegneria dell’Automazione nn/aa Anno accademico 2007/2008

In questa Tesi presentiamo un sistema per ottenere la piena coesistenza fra un manipolatore robotico ed un operatore umano che condividono lo stesso spazio di lavoro. Con piena coesistenza intendiamo la possibilit`a per l’operatore ed il manipolatore di condividere lo stesso spazio di lavoro nello stesso momento sen-za dover limitare (se non minimamente) il proprio task ; n´e in termini di spazio n´e di prestazioni; considerando sempre prioritaria la sicurezza dell’operatore. Manipolando le informazioni date da una coppia di videocamere in configu-razione stereo costruiamo una rappresentazione degli ostacoli seguendo la teoria del C-Space. Quindi, utilizzando un sistema di forze repulsive da noi ideato che lavora interamente sul C-Space, riusciamo a far proseguire il task assegnato al manipolatore evitando gli ostacoli (operatore umano).

Abstract

In this thesis we present a system for obtaining full coexistence between robotic manipulators and human operators who share the same workspace. Whith full coexistence we mean the opportunity for the operator and the manipulator to share the same workspace at the same time without having to restrict (if not least) his task; nor in terms of space or performance; operator’s safe is ever priority. Using the information of a stereo vision system the algorithm build a representation of obstacles following the C-Space’s theory. Then, using a system of repulsive forces we created, working entirely on C-Space, we continue the manipulator’s assigned task avoiding obstacles (incuding human operators).

Introduzione

La coesistenza di operatori umani e manipolatori robotici nello stesso spazio di lavoro ha avuto, negli ultimi anni, una crescente importanza, soprattutto in campo industriale. Conferma di tale tendenza `e l’enorme incremento della ricerca in questo campo.

La priorit`a nella coesistenza tra manipolatori ed operatori `e la sicurezza di quest’ultimo. In campo industriale vengono utilizzati manipolatori robotici ca-paci di esercitare grandi forze e di lavorare con enormi carichi a velocit`a elevate. Tali caratteristiche rendono impraticabile la coesistenza nello stesso spazio di lavoro di operatori e manipolatori, a causa della limitata sicurezza. La sicurezza dell’operatore solitamente viene garantita utilizzando dei sensori di prossimit`a (es. fasci laser) per verificare la presenza di un operatore nello spazio di lavoro; al verificarsi di tale condizione il manipolatore viene quindi fermato finch´e lo spazio di lavoro non viene ad essere nuovamente libero. Consideriamo ad esem-pio una catena di montaggio. La presenza di un operatore umano per controllo qualit`a, manutenzione o semplicemente pulizia fermerebbe il manipolatore por-tando al blocco parziale o totale della catena.

In questa Tesi abbiamo sviluppato un sistema che, utilizzando le informazioni provenienti dalla stereovisione, riesce ad ottenere la completa coesistenza fra operatore umano e manipolatore robotico. La procedura sviluppata utilizza le informazioni ricevute dalla visione stereo per costruire una rappresentazione degli ostacoli seguendo la teoria dei C-Space, quindi utilizzando un sistema di forze repulsive da noi ideato (C-Force) che lavora interamente sul C-Space, il manipolatore continua il task assegnato evitando l’ostacolo.

Stato dell’arte

In passato sono state discusse varie metodologie per garantire la sicurezza di operatori umani che condividano lo spazio di lavoro con manipolatori roboti-ci. Molti di questi utilizzano sensori che forniscono solo informazioni locali, ad esempio [8] e [9] utilizzano dei sensori che si attivano se un ostacolo `e a meno di 400mm, quando il sensore si attiva la velocit`a del manipolatore viene ridotta fino a fermarsi. In [10] viene utilizzata una videovideocamera per effettuare il path planning per`o viene presupposto l’utilizzo di sensori di prossimit`a e la conoscenza dell’immagine che si otterr`a al raggiungimento del targhet. In [11] la collisione viene evitata attraverso una forza repulsiva dipendente dalla dis-tanza fra l’end-effector e l’ostacolo, tale soluzione per`o non `e efficace a meno di porre dei pesanti vincoli sulle possibili configurazioni. In [12] viene utiliz-zato un sistema di pi`u videocamere disposte opportunamente per verificare la distanza fra il manipolatore e l’ostacolo, si deve notare come non sia proposta una manovra evasiva ma semplicemente si rallenti il manipolatore fino a farlo fermare. Con la stessa configurazione di videocamere del metodo precedente in [13] viene proposta una manovra evasiva, in particolare dato un task da svol-gere viene proiettato sul piano immagine il manipolatore nelle configurazioni

che dovr`a assumere. Andando a valutare la sovrapposizione dell’immagine del manipolatore e di quella dell’ostacolo per ogni videocamera il metodo valuta se il percorso `e libero o meno. Non avendo per`o nessuna informazione sulla profon-dit`a degli oggetti, tale metodo `e efficace solo utilizzando molte videocamere, in modo da avere immagini da pi`u angolazioni. In [14] `e utilizzata la stereovisione e, come nel nostro sistema, le videocamere sono solidali al manipolatore. Gli ostacoli vengono elusi efficacemente per`o gli oggetti devono essere posizionati su un tavolo bianco davanti al manipolatore e sono evitati aggirandoli sulla terza dimensione.

In definitiva esistono molti metodi efficaci da un punto di vista di funziona-mento. Ognuna di queste soluzioni pone per`o dei vincoli, quali ad esempio la posizione dell’ostacolo, o prevede delle limitazioni, come un numero elevato di videocamere fisse nello spazio.

Il metodo che presenteremo `e in grado di evitare ostacoli senza imporvi vincoli di alcun genere (posizione, forma, dimensioni. . . ). Vedremo inoltre come con le op-portune modifiche che realizzeremo nell’immediato futuro la nostra metodologia possa essere esportata su manipolatori mobili (spazio di lavoro variabile).

1 Panoramica del Sistema

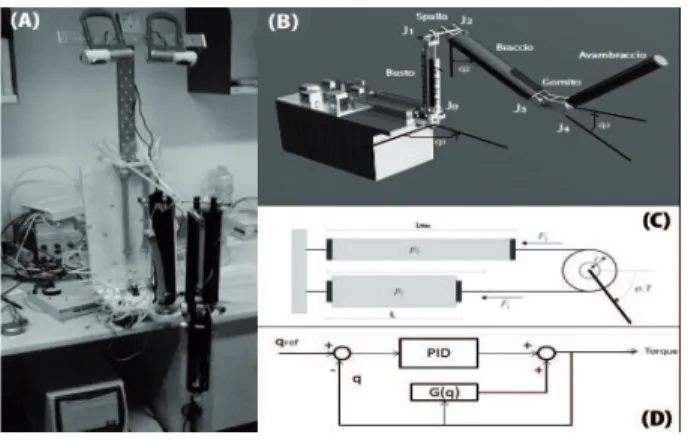

Il sistema su cui abbiamo svolto le prove `e composto da un manipolatore roboti-co seriale antropomorfo a tre gradi di libert`a e da una roboti-coppia di videocamere in configurazione stereo solidali al manipolatore (figura 1(A)).

Figura 1: Panoramica de Sistema.

Il manipolatore utilizzato, denominato SoftArm, `e stato costruito all’interno del Centro di Ricerca interdipartimentale “E.Piaggio” (figura 1(B)). Il SoftArm ha tre gradi di libert`a (q1, q2, q3). I giunti J0, J1 e J3 sono attuati da una coppia

di muscoli McKibben [7] posti in configurazione agonista-antagonista (figura 1(C)) e controllati da elettrovalvole pneumatiche ITV200 di SMC. I segnali di controllo sono generati da un PC e inviati tramite una scheda NI PCI6704 di Na-tional Instrument. La posizione dei tre giunti attuati `e ottenuta utilizzando dei potenziometri calettati direttamente sui giunti. Il segnale in uscita dai poten-ziometri `e campionato dal calcolatore utilizzando una scheda di acquisizione NI

PCI6024E.

Abbiamo controllato il manipolatore con un controllore alla Arimoto (figura 1(D)) che permette di considerare separatamente il controllo di ogni giunto. Ad ogni giunto viene applicata una coppia dipendente da: controllo PID sull’errore di posizionamento; vettore di gravit`a del manipolatore. La posizione di riferi-mento `e data nello spazio dei giunti.

La realizzazione discretizzata del controllore per il giunto n-esimo `e data da

I(0) =< stato iniziale > I(k) = I(k − 1) +Ts

2 (e(k) + e(k − 1))

T ouque(k) = Kpe(k) + Kde(k) − e(k − 1)T

s + KiI(k) + gn(q(k)), (1)

Dove e(k) = qnref − qn(k) e gn(q(k)) `e la componente n-esima del vettore di gravit`a G(p).

La stereovisione `e realizzata tramite una coppia di webcam (visio) di Logitech montate ad un’altezza di 80cm rispetto al riferimeno centrale del SoftArm. Vengono utilizzati due calcolatori, uno per il controllo del manipolatore ed il secondo per il server di visione. I due calcolatori comunicano utilizzando il protocollo TCP-IP.

2 Server di Visione

In questa parte viene introdotto l’algoritmo di autocalibrazione delle video-camere, sviluppato in questo lavoro; per poi discutere di due diverse metodolo-gie ideate per la costruzione del C-Space associato al manipolatore.

Lo spazio delle configurazioni (C-Space) [1] di un manipolatore multilink `e un

Manifold con dimensione pari ai gradi di libert`a del manipolatore. Ogni punto

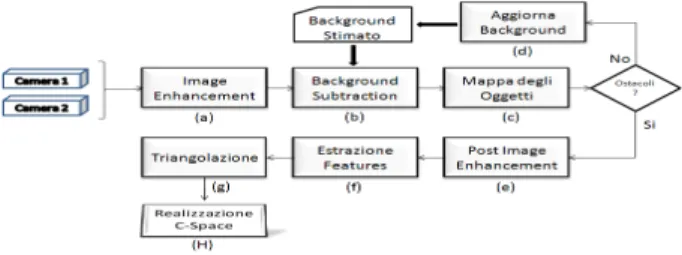

del C-Space associato al nostro manipolatore rappresenta una configurazione (q1,q2,q3). I passi compiuti per ottenere il C-Space dalle due immagini sono rappresentati in (figura 2).

Figura 2: Schema di riferimento del server di visione.

2.1 Autocalibrazione di un sistema stereo con videocamere semicalibrate

Dato un sistema di videocamere stereo per ottenere una ricostruzione metrica, ovvero dipendente solo da un fattore di scala, si devono conoscere le matrici

di calibrazione di entrambe le videocamere. Avere le matrici di calibrazione di entrambe le videocamere vuol dire conoscere sia i parametri intrinseci che estrinseci. I parametri intrinseci, che possono essere stimati usando dei pattern, rappresentano come punti nello spazio vengono proiettati sul piano immagine. I parametri estrinseci rappresentano la posizione nello spazio delle videocamere. Considerare conosciuti i parametri estrinseci di entrambe le videocamere rende troppo rigido il sistema, dato che una piccola variazione nella posizione rela-tiva delle due videocamere genera una variazione della geometria epipolare1

[3]. L’utilizzo di matrici di calibrazione che non rispettino la reale geometria epipolare delle videocamere rende praticamente errata la ricostruzione ottenu-ta con la triangolazione. L’autocalibrazione da noi realizzaottenu-ta utilizza in fase di inizializzazione usa una stima della matrice fondamentale2 ottenuta

appli-cando il RANSAC [3] sulle corrispondenze fra le due immagini catturate dalle videocamere. Considerando conosciuti i parametri intrinseci delle due video-camere possiamo ottenere una stima delle due matrici di proiezione3 in forma

canonica con riduzione della distorsione [2]. Anche se la distorsione `e ridotta non `e stata eliminata . Otteniamo una rettificazione metrica (figura 3) andan-do ad imporre il rispetto sui vincoli dell’Absolute dual quadric [3]. Il risultato ottenuto viene ottimizzato da un algoritmo iterativo di minimizzazione. La ret-tificazione Euclidea `e ottenuta stimando informazioni conosciute di tipo metrico dalle immagini (es. posizione di un punto o distanza fra due punti)

Figura 3: Ricostruzioni.

2.2 Background Subtraction

Questa `e una tecnica che permette di isolare l’immagine di oggetti che “entrano”

nell’immagine di partenza. Data una stima del background4 (figura 4(A.1))

l’immagine di un oggetto che prima non era presente (per noi `e un possibile ostacolo) `e data dai pixel che verificano la relazione

|f rame(x, y) − background(x, y)| < T h , (2) dove T h `e un valore di soglia.

Il risultato intermedio della sottrazione `e una mashera (figura 4(A.3)), a cui viene applicato un filtro con effetto Smooth per rendere pi`u uniforme il risultato finale. La maschera ottenuta viene applicata all’immagine iniziale in modo da

1Geometria su cui si basa la stereovisione.

2La matrice fondamentale rappresenta algebricamente la geometria epipolare del sistema

stereo [3].

3Proiezione dallo spazio 3D euclideo al piano immagine.

4Il background per noi `e l’immagine vista dalle videocamere quando nessun oggetto si trova

Figura 4: Metodo A.

ottenere l’immagine degli oggetti isolati. La stima del background viene fatta durante l’inizializzazione e poi viene aggiornata (figura 2(d)) utilizzando una media mobile ogni volta che non viene individuato un oggetto.

Prima di effettuare la sottrazione del background la qualit`a dell’immagine viene migliorata effettuano una regolazione della luminosit`a e contrasto. Il risultato di questa tecnica `e mostrato in figura 4(A.4).

2.3 Ricostruzione 3D dei punti

La posizione nello spazio di un punto p viene stimata attraverso la

triango-lazione della corrispondenza di feature5 fra le due immagini associate a p

(figura 4(B.1)). Per ottenere le corrispondenze fra i punti della due immagi-ni abbiamo utilizzato l’algoritmo delle SIFT forimmagi-nito dalle librerie ERSP°c. Le corrispondenze vengono cercate fra l’immagine della videocamera di sinistra a cui `e stata applicata la sottrazione del background e l’immagine della video-camera a destra. Le corrispondenze ottenute sono state filtrate utilizzando una condizione sul rispetto della geometria epipolare. Utilizzando un algoritmo di triangolazione lineare si ottiene una stima dei punti nello spazio che compon-gono gli oggetti trovati. Ogni punto ricostruito viene associato all’oggetto a cui appartiene. Il risultato di questa tecnica `e mostrato in figura 4(B.3).

2.4 Costruzione del C-Space: Metodo A

Questo primo metodo da noi sviluppato si incenta sulla creazione di una ri-costruzione 3D degli ostacoli. Il C-Space viene stimato costruendo i C-Obstacle [1] associati agli oggetti trovati. Il C-Obstacle viene creato verificando le configu-razione del manipolatore per cui il modello 3D del manipolatore collide con il modello 3D dell’oggetto.

2.4.1 Contorno

Le feature trovate dall’algoritmo SIFT sono solitamente interne all’oggetto. Per ottenere una ricostruzione 3D dell’oggetto dobbiamo conoscere anche la posizione 3D dei punti che compongono il bordo dell’oggetto. I contorni degli oggetti vengono ottenuti utilizzando l’algoritmo di Canny [6] sull’immagine di sinistra a cui `e stata applicata la sottrazione del background. I contorni cos`ı trovati sono composti da molti punti. Per ottenere una riduzione di questi punti andiamo a considerare solo il convex hull che inscrive il contorno (figura 4(B.2)).

2.4.2 Costruzione modello 3D

La proiezione 3D dei punti del contorno non pu`o essere fatta con la triango-lazione perch´e non conosciamo i punti corrispondenti nell’immagine di destra. Per ogni punto del convex hull vengono considerati tutte le features individuate in un intorno, se sono almeno 4 viene costruito il piano che minimizza la distan-za fra il piano e la proiezione 3D delle features considerate. La proiezione 3D del punto del contorno `e data dall’intersezione fra il piano costruito ed il raggio di proiezione del suddetto punto (figura 4(D)). Vengono considerati almeno 4 punti perch´e con meno la ricostruzione risulta troppo soggetta ai rumori. Se le

features nell’intorno sono meno di 4 si ipotizza che il punto del contorno sia

alla stessa profondit`a della feature pi`u vicina, da cui si ottiene la proiezione 3D (figura 4(B.3)). Tutti i punti che si trovano sullo stesso raggio di proiezione dei punti del contorno, ma con profondit`a maggiore fanno parte della “zona d’ombra”6. Consideriamo la “zona d’ombra” parte dell’oggetto. Ogni oggetto

viene rappresentato dal poliedro convesso che lo contiene. Il poliedro `e calcolato usando le proiezioni 3D delle features e dei punti del bordo pi`u le continuazioni dei punti del bordo che rappresentano le zone d’ombra (figura 4(B.4)).

2.4.3 Costrusione del C-Space

Per costruire il C-Space dobbiamo considerare tutte le configurazioni del ma-nipolatore e verificare per quali il modello 3D del mama-nipolatore collide con il modello 3D di uno degli oggetti. Il modello 3D del manipolatore `e composto da un parallelepipedo per ogni link. Per verificare la collisione utilizziamo le seguenti condizioni:

• Metodo della Sfera. Condizione Necessaria. Costruiamo la sfera a

minimo raggio che inscrive il poliedro. Se la distanza fra il link ed il centro della sfera meno il raggio del link `e minore del raggio della sfera la collisione `e possibile. Con tale tecnica si possono eliminare velocemente tutte le configurazioni che si trovano sicuramente nel C-Free7;

6Composta dai punti che non possono essere visti dalle videocamere perch´e nascosti da altri

oggetti.

• Metodo delle disequazioni del piano. Condizione Sufficiente ma non necessaria. Ogni link `e rappresentato dagli 8 vertici del parallelepipedo che lo inscrive. Se uno di questi 8 vertici si trova all’interno del poliedro che rappresenta l’oggetto la collisione `e sicura! Per verificare se il punto `e interno al poliedro, per ogni triangolo che compone il poliedro, consideri-amo l’equazione del piano su cui giace il triangolo. Un punto sar`a interno al poliedro se verifica tutte le disequazioni. Tale metodo non d`a una con-dizione necessaria perch´e non considera le intersezioni date dai bordi e dalle facce dei link;

• Metodo dei triangoli . Condizione necessaria e sufficiente. Consideran-do ogni link rappresentato dai 12 (oppure 8 escludenConsideran-do le basi) triangoli che compongono il parallelepipedo che lo inscrive. Andando a verificare l’intersezione fra i triangoli del link e quelli del poliedro verifico con certezza se tale configurazione appartiene al C-Obstacle o no;

L’utilizzo del metodo della sfera insieme a quello dei triangolo consentono un risultato veloce e sicuro. Il C-Space relativo all’immagine 4(B.1) e mostrato in figura 4(B.5).

2.5 Costruzione del C-Space: Metodo B

In questo secondo metodo viene utilizzato un procedimento alternativo da noi sviluppato. Al posto di realizzare la ricostruzione 3D dell’ostacolo realizziamo una mappa che chiameremo mappa delle profondit`a. Dal confronto fra tale

map-pa delle profondit`a e le proiezioni sul piano immagine dei punti del manipolatore

riusciamo a costruire il C-Space.

2.5.1 Mappa delle Profondit`a

Per ogni pixel dell’immagine8 la mappa delle profondit`a contiene la profondit`a9

stimata dell’oggetto. La stima viene effettuata utilizzando la profondit`a dei punti ricostruiti nei passi precedenti (triangolazione corrispondenze features). Un esempio di mappa delle profondit`a `e presentata in figura 5(A.2).

Figura 5: Metodo B.

8Consideriamo sempre quella catturata dalla videocamera di sinistra su cui `e stato applicato

la sottrazione del background.

2.5.2 Creazione del C-Space

Data una configurazione q del manipolatore. Usando la cinematica diretta pos-siamo calcolare i punti (GP

i)10 nello spazio, che compongono il manipolatore

nella configurazione data (si considera un numero finito di punti per ogni link). Applicando la rototraslazione data dalla matrice dei parametri estrinseci11della videocamera di sinistra ho la profondit`a (secondo la terminologia gi`a esposta) dei punti del manipolatore(VP

iz). Utilizzando i parametri intrinseci della

video-camera si proiettano i puntiVPi sul piano immagine.

Per ogni punto del manipolatore considero la sua posizione nell’immagine, che corrisponde ad un punto nella mappa delle profondit`a. Se per almeno un punto la profondit`a del manipolatore `e maggiore di quella nella mappa delle

profon-dit`a (considerando una soglia di sicurezza) allora la configurazione q fa parte

del C-Obstacle.

Applicando questo procedimento ad ogni possibile configurazione del manipola-tore costruiamo il C-Space.

3 Obstacle Avoidance: C-Force

Il controllo da noi sviluppato si basa su un sistema di forze repulsive12 che

abbiamo battezzato C-Force (forze nello spazio delle configurazioni), tali da costringere il manipolatore al passaggio solo su configurazioni appartenenti al

C-Free.

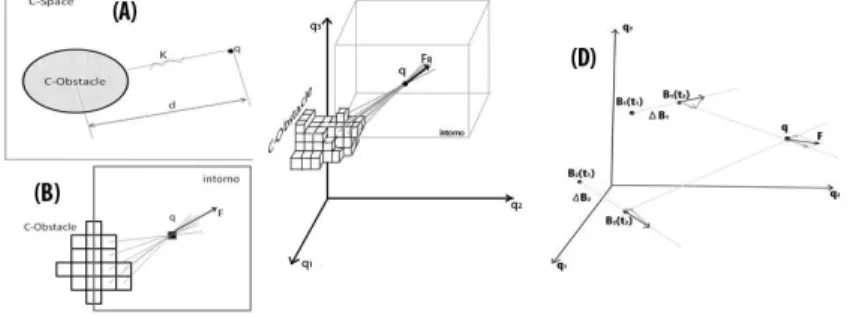

Figura 6: Forza Repulsiva.

3.1 Forza Repulsiva

Possiamo considerare senza perdita di generalit`a un C-Space di dimensione 2. La configurazione attuale del braccio `e mappata come un punto nel C-Space. La presenza di un C-Obstacle imprime sul punto una C-Forza inversamente proporzionale alla distanza ( d ) fra il punto ed il C-Obstacle e proporzionale

10GP punto in coordinate globaliVP in coordinate di visione.

11Trasformazione omogenea per passare dal sistema di riferimento globale a quello della

videocamera.

12Parliamo di forze perch´e usando la teoria delle forze si riesce a descrivere efficacemente il

ad una costante K (elastica). Tale rappresentazione pu`o essere vista come una molla compressa (figura 6(A)).

Consideriamo il C-Space diviso in celle (rappresentazione discreta del Manifold). Prendiamo un intorno della configurazione attuale (q). Ogni cella elementare

di un C-Obstacle presente nell’intorno imprime una C-Forza inversamente

proporzionale alla distanza fra la cella ed il punto q, e con direzione data dalla retta che li congiunge. Facendo la somma di questi vettori ottengo la forza respingente (figura 6(B-C)).

In un C-Space a pi`u dimensioni posso scrivere FR(q) = K1 NC X i=1 1 d(Ci, q) q − Ci kq − Cik = K1 NC X i=1 q − Ci kq − Cik2 , (3)

Dove NC`e il numero di celle appartenenti al C-Obstacle nell’intorno considerato

e Ci rappresenta la cella i-esima mentre l’operatore d( , ) restituisce la ditanza fra i due punti. Dato che in realt`a FR(q) mi esprime direttamente le coppie che devo applicare ai tre giunti azionati avr`o una coppia di controllo pari a

τC= τArimoto+ FR(q).

3.2 Movimento dell’ostacolo

Nel controllo appena presentato non si tiene conto della velocit`a a cui si muove l’ostacolo. Se l’ostacolo si muove verso il braccio ad una velocit`a superiore ad una certa soglia (relativamente piccola) non si riuscir`a ad evitare l’ostacolo. Il metodo C-Force si basa sul considerare gli spostamenti dei C-Obstacle. Ogni

oggetto viene mappato nel C-Space da uno o pi`u “agglomerati” (porzione

del C-Space composta da celle adiacenti). Di ogni agglomerato posso calcolare il Baricentro. Sia ∆Bi il vettore di variazione della posizione del baricentro

dell’i-esimo agglomerato. Se la variazione `e avvenuta in un tempo ∆t si avr`a la velocit`a Vi = ∆Bi

∆t . Tale velocit`a rappresenta come si sposta il C-Obstacle nel

C-Space, e quindi se ipotizzo la velocit`a del baricentro costante, otteniamo la

stima delle prossime configurazioni occupate, cio`e dove il manipolatore non pu`o andare nell’immediato fututo. Con riferimento alla figura (figura 6(D)) avremo la nuova forza respingente

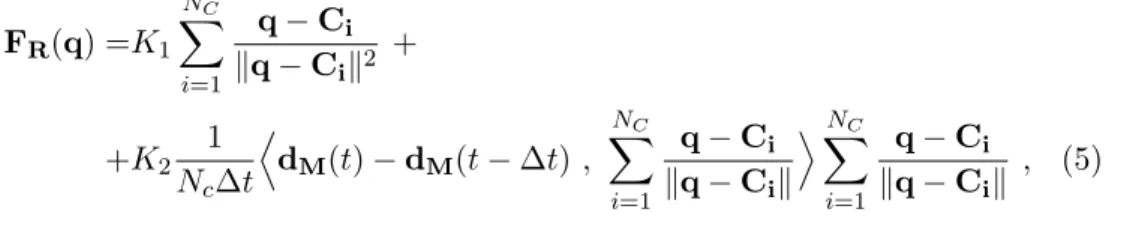

FR(q) = K1 NC X i=1 q − Ci kq − Cik2 + K2 NA X j=1 h∆Bi ∆t , q − Bjiq − Bj kq − Bjk2 . (4) 3.3 Manovra evasiva

Consideriamo anche la velocit`a con cui si muove il manipolatore. ´E chiaro che se il manipolatore si muove (nel C-Space) con direzione opposta al movimento del C-Obstacle la forza repulsiva dovr`a essere maggiore. Consideriamo anche che il calcolo dei baricentri degli agglomerati `e computazionalmente dispendioso. Possiamo valutare la velocit`a relativa fra il C-Obstacle e la configurazione del

manipolatore utilizzando la variazione della distanza media fra i due. Avremo : FR(q) =K1 NC X i=1 q − Ci kq − Cik2 + +K2N1 c∆t D dM(t) − dM(t − ∆t) , NC X i=1 q − Ci kq − Cik EXNC i=1 q − Ci kq − Cik , (5)

Dove dM(t) `e la distanza media al tempo t. Per evitare che la manovra evasiva

venga rallentata consideriamo sono valori negativi di (dM(t) − dM(t − ∆t)).

Una immagine realizzata sovrapponendo frame del video di una prova pratica `e mostrata in figura 7. Il corretto funzionamento del C-Force `e stato validato da simulazioni effettuate con Matlab°c.

Figura 7: Risultato.

4 Conclusioni e Sviluppi Futuri

Attraverso alcuni esperimenti condotti in laboratorio abbiamo dimostrato per via sperimentale la possibilit`a di ricostruire il C-Space associato ad una coppia di immagini. Abbiamo inoltre dimostrato l’effettivit`a del controllo C-Force pro-posto in questo lavoro. Nel funzionamento a ciclo chiuso abbiamo ottenuto risul-tati molto incoraggianti. Il sistema funziona correttamente ma le prestazioni in tempo reale sono al di sotto di quelle desiderate. Questo `e dovuto alla bassa velocit`a del ciclo di visione (in media circa 0.5 Hz), imposto soprattutto dalla limitata potenza di calcolo in nostro possesso.

Per migliorare le prestazioni in tempo reale del nostro sistema stiamo ideando un nuovo algoritmo per la costruzione della Mappa delle Profondit`a; questo nuovo metodo non utilizzer`a le SIFT (che non sono sempre affidabili) ed il background

subtraction (che limita l’utilizzo ad uno spazio di lavoro fisso). Secondo le nostre

previsioni, l’utilizzo di questo nuovo metodo unito ad un aumento della potenza di calcolo a disposizione consentir`a di ottenere le prestazioni in tempo reale da noi desiderate.

Il sistema realizzato (con gli sviluppi citati) esula da un’applicazione specifica e rappresenta un metodologia per l’Obstacle Avoidance con visione setereo adatta ad ogni applicazione.

Bibliografia

[1] Jean-Claude Latombe, Robot Motion Planning, Kluwer Academic

Publishers

[2] Ma Y., Soatto S., Ko˘sench´a J., Sastry S.S. An Invitation to 3-D Vision From Image to Geometric Models, Springer

[3] Hartley R.,Zisserman Multiple View Geometry in Computer Vision,2nd

Edition Cambridge University Press

[4] Sciavicco, Siciliano, Robotica Industriale, Modellistica e controllo dei

manipolatori, McGraw-Hill.

[5] Lowe, D. G. Distinctive Image Features from Scale- Invariant Keypoints. International Journal of Computer Vision Vol. 60(2), p.9. 2004.

[6] Gerhard X. Ritter , Joseph N. Wilson Handbook of Computer Vision

Algorithms in Image Algebra, 2nd Edition CRC Press

[7] Measurement and modeling of McKibben pneumatic artifical muscles,

IEEE, Transactions on robotic and automation, pag. 90-102, vol. 12, No 1, Febbraio 1996.

[8] Novak J.L., Feddema J.T.: A Capacitance-Based Proximity Sensor for

Whole Arm Obstacle Avoidance., IEEE Proceedings of the Intl. Conf. on

Robotics and Automation, pp. 1307-1314, 1992.

[9] Feddema J.T., Novak J.L.: Whole Arm Obstacle Avoidance for Teleoperated

Robots., IEEE Robotics and Automation Proceedings, pp.3303 - 3309, 1994.

[10] Noborio H., Nishino Y.: Image-based Path-Planning Algorithm on the Joint

Space., IEEE International Conference on Robotics and Automation, pp.

1180- 1187,Seoul, 2001.

[11] jih-Gau Juang : Application of Repulsive Force and Generic Algorithm to

Multi-manipulator Collision Avoidance, National Taiwan Ocean University

[12] Kuhn S., Gecks T. and Henrich D.: Velocity control for safe robot

guid-ance based on fused vision and force/torque data, IEEE Conference on

Multisensor Fusion and Integration, September 3-6, 2006, Heidelberg, Germany

[13] Gecks T., Henrich D.: Human-robot cooperation: Safe Pick-and-Place

Op-erations, IEEE International Workshop on Robots and Human Interactive

Communication, 2005

[14] Iossifidis I., Sch¨oner G. Dynamic System Approach for the Autonomous

Avoidance of Obstacle and Joint-limit for an Redundant Robot Arm, in

proceeding of the IEEE International Conference on Intelligent Robots and System, Beijing, China, 2006