Capitolo 3

Setup per lo l’osservazione in vivo di

un esemplare di Octopus Vulgaris

3.1

Introduzione

In questo capitolo si presenta una descrizione dell’ambiente di lavoro in cui si sono condotte le prove sperimentali che hanno permesso l’acquisizione dei dati e delle misurazioni a partire dalle quali sono stati sviluppati i modelli cinematici e dinamici.

Prima di tutto si descrive l’ambiente che è stato realizzato allo scopo di ricreare al meglio le condizioni di habitat naturale in cui poter allevare e gestire nel miglior modo un esemplare di Octopus vulgaris.

Si spiega quindi il setup di videocamere che è stato realizzato specificatamente per gli scopi fissati. In particolare si analizza il sistema in ogni suo componente e caratteristica, sia da un punto di vista strumentale ed elettronico, sia valutando i possibili fenomeni di riflessione e rifrazione che possono creare falsi giochi di luce e distorsione nelle immagini.

L’originalità dell’applicazione per cui è stato utilizzato il setup sperimentale e la ricerca di risultati obiettivi portano necessariamente ad affrontare un’auto-analisi di critica sul metodo utilizzato, in modo da evidenziarne i punti deboli per un futuro miglioramento.

Gli strumenti che sono stati costruiti ed utilizzati nelle singole prove per l’interazione diretta con l’esemplare di Octopus saranno invece descritti nei capitoli seguenti, inseriti all’interno della spiegazione di come si sono condotte le prove stesse per cui sono stati realizzati e in cui sono stati adoperati.

3.2

Creazione dell’habitat

Con la scelta di intraprendere uno studio diretto su un esemplare di Octopus vulgaris si è mostrato necessario lo sviluppo di un ambiente che fosse facilmente accessibile da parte dell’operatore umano e, allo stesso tempo, che lasciasse libera mobilità ed abitabilità per l’esemplare.

Le attuali tecniche adottate nel mondo attuale dell’acquariofilia permettono diverse strategie per la gestione di una vasca: si va dal più antico sistema con filtro di tipo meccanico-biologico, passando per il sistema DSB (deep sand beds), al metodo Jaubert, fino al metodo Berlinese.

In questo caso, avendo la necessità di ricreare un biotipo mediterraneo che fosse idoneo per il polpo e soprattutto che permettesse di studiarlo in maniera semplice e completa, si è optato per un sistema misto con cui mantenere costanti il più possibile i valori dell’acqua e studiare l’essere in tutta tranquillità e lasciando a sua disposizione più spazio possibile.

Per questo si è attrezzato la vasca con un forte filtro di tipo meccanico-biologico e si è riempita di rocce vive, come suggerito dal metodo berlinese, in numero sufficiente per un giusto equilibrio chimico in funzione della capacità dell’acquario, ma considerando anche i limiti dello spazio necessario allo studio.

Il volume della vasca è stato scelto in funzione dello spazio massimo a disposizione, ma sufficiente per dare ampia possibilità di movimento al polpo. Le dimensioni sono di 230(W) x 120(D) x 90(H) cm, e si è posto un vano filtro sul lato corto di profondità 30cm e lasciando esterno sia lo schiumatoio che il refrigeratore.

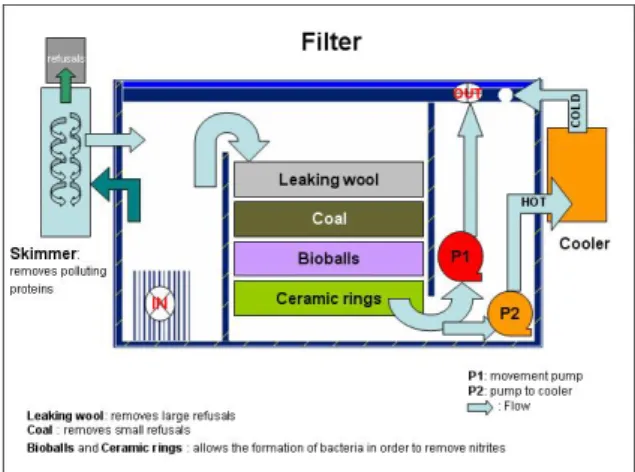

Figura 3. 1 Schema di funzionamento del sistema di filtraggio.

In figura 3.1 si mostra il filtro ed il suo funzionamento: l’acqua entra da una grata che separa il vano filtro dalla vasca (IN), viene quindi spinta nello schiumatoio (skimmer) tramite una pompa dove avviene la separazione delle proteine di rifiuto presenti in eccesso nell’acqua e immessa di nuovo nel filtro; da qui passa nel settore centrale dove inizia il filtraggio meccanico tramite l’uso di lana artificiale che rimuove le particelle grossolane di rifiuto, per poi passare attraverso due garze ripiene di polvere di carbone per la rimozione delle particelle fini. Infine l’ultimo, ma non meno importante, strato di materiale ceramico dove avviene il filtraggio biologico. Qui vi sono sia delle sfere in materiale plastico che cilindri in materiale ceramico, dove vivono le colonie di microrganismi utili per la decomposizione dei nitriti in nitrati.

L’acqua filtrata viene a trovarsi nell’ultimo settore da dove una pompa la preleva e la manda al refrigeratore per far sì che la temperatura rimanga il più possibile vicina ai valori presenti in natura (19°-20° C, nel caso del mar Mediterraneo).

All’interno della vasca (non nella zona del filtro), è stato inserito uno strato di sabbia (circa 20-30 kg) prelevato direttamente del mare, per fare in modo che i microrganismi presenti colonizzassero l’ambiente. A questa si è aggiunto sabbia di tipo aragonite (approssimativamente di 30 kg), per aumentare lo strato e rendere più stabile il pH grazie al suo tipico rilascio di calcio.

Su questo strato sono stati aggiunti circa 50 kg di rocce provenienti dalle Fiji (adeguatamente spurgate, ovvero private dei loro microorganismi) per sfruttare le loro caratteristiche di leggerezza, ma nello stesso tempo ampia superficie dove far insediare nuove colonie di microrganismi, ed altri 50 kg di rocce prelevate dal mare (della zona di castiglioncello) che invece sono state inserite con tutto il loro carico di organismi.

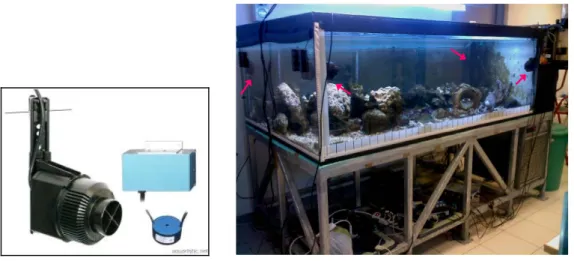

4 pompe di movimento della Tunze (figura 3.2) muovono circa 2000 litri d’acqua per ora, e sono controllate da una centralina (anche questa della Tunze) che permette di ricreare le correnti presenti in mare gestendo l’accensione delle pompe in modo alternato.

Figura 3. 2 Immagine del tipo di pompe di movimento usate nell’acquario (sinistra) e visione d’insieme dell’acquario con le quattro pompe posizionate all’interno (destra), indicate dalle frecce.

L’apporto di luce utile allo sviluppo dei microrganismi marini è fornito da una lampada della serie Aquaristic (figura 3.3), composta da 3 lampade HQI da 150 W e 4 neon t8 da 39 W in tonalità di blue.

Figura 3. 3 Illustrazione della lampada Aquaristic (sopra) e fotografia dell’illuminazione creata sull’acquario.

Il controllo dei valori dell’acqua è affidato ad un kit della IKS, formato da una centralina di monitoraggio e da 6 sensori (figura 3.4) inseriti all’interno della vasca che controllano rispettivamente: la temperatura, il pH, la conducibilità, la concentrazione dei sali, l’ossigeno e il livello dell’acqua. Tra le sue caratteristiche, il kit offre la possibilità di poter monitorare a distanza questi valori, grazie alla presenza di una centralina di raccolta e invio dei dati tramite sistema GSM. La centralina è programmabile e permette anche l’interrogazione a distanza tramite telefono cellulare.

Figura 3. 4 Centralina di controllo con i suoi componenti.

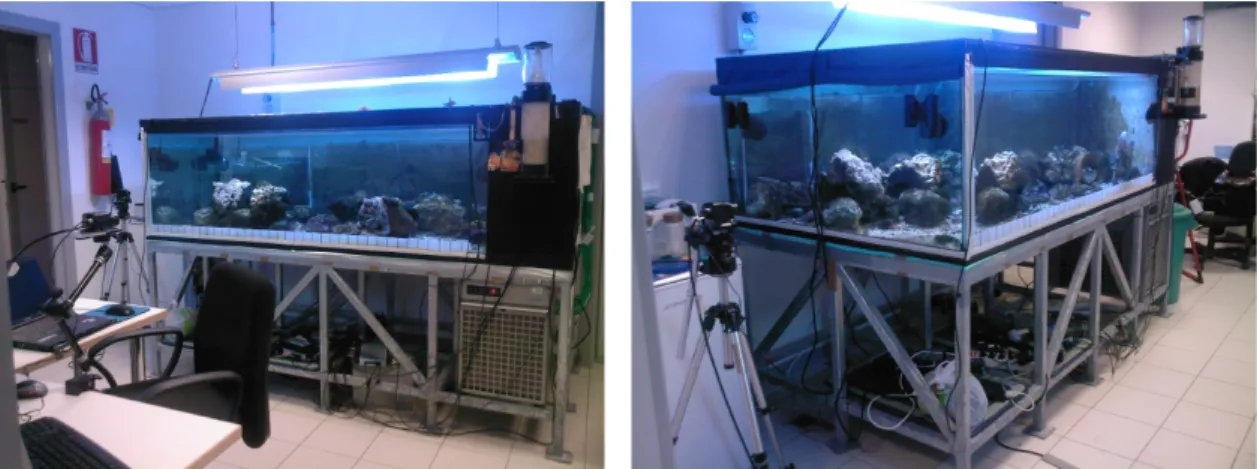

Nelle figure 3.5 si presentano due foto che mostrano, da angolazioni diverse, l’intero ambiente creato.

Figura 3. 5 Foto dell'ambiente costruito per l’allevamento di un esemplare di Octopus vulgaris.

3.3

Considerazioni generali sul setup video

È da premettere che, all’interno del nostro laboratorio, questa è stata la prima esperienza di osservazione e analisi in real-time di un esemplare di Octopus vulgaris, e per questo alcune considerazioni effettuate a priori sono state in parte modificate durante l’esperienza stessa in seguito a una maggiore consapevolezza e maturità derivate dalla pratica su campo.

Ciò che era ricercato inizialmente era di poter osservare in dettaglio e per lunghi periodi di tempo i comportamenti e la dinamica del soggetto scelto. Per far ciò era necessario un setup video che permettesse di rilevare immagini ad alta risoluzione, con un elevato frame rate e per un lungo periodo di tempo. Guardando sul mercato però non si è trovato disponibilità di sistemi con tali requisiti: in generale, infatti, l’high speed video recording viene realizzato con sistemi ad alta risoluzione, ma che permettono l’acquisizione di immagini per brevi periodi di tempo, ovvero nell’ordine delle decine di secondi.

Se si considera che la dimensione in memoria di una singola immagine è data da:

( )

x( )

y( )

ctot

N

N

P

D

=

dove Nx e Ny sono il numero dei pixel orizzontali e verticali dell’immagine e Pc è la

profondità di colore, un’immagine con una risoluzione di 1024x1024 e 256 livelli di grigio (ovvero con quantizzazione a 8 bit) occuperà 1024 kB di memoria e quindi, in 20 GB di spazio (che è una dimensione tipica per le memorie on board di una camera ad alta velocità), sarà possibile memorizzare meno di 2000 immagini o frames. Come conseguenza se si imposta un frame rate di 200 fps, si potrà registrare per soli 10 secondi, un tempo per noi decisamente insufficiente.

Il problema della registrazione video ad alta velocità è proprio che aumentando il numero di frames acquisiti al secondo è necessario scendere a compromessi: o si perde in risoluzione, o si perde in tempo di registrazione, oppure si cerca di avere una maggiore memoria di acquisizione. Ma tale memoria, come già menzionato, si trova quasi sempre integrata nella videocamera stessa, perchè è difficile costruire un sistema di acquisizione dati così rapido che permetta di trasferirli in real time su una memoria esterna, ed è quindi fisicamente limitata in dimensioni.

Ripartendo dal principio, in genere, quando si deve effettuare una scelta per la realizzazione di un sistema di acquisizione di immagini ad alta velocità le prime domande che ci si deve porre sono a quale velocità si vuole acquisire le immagini e con quale risoluzione.

Ad oggi si trovano sul mercato camere ad alta velocità con frame rate che vanno dai 60 fps ai 250.000 fps, molte delle quali possono acquisire a diverse velocità riducendo però la risoluzione o il campo visivo.

Bisogna quindi vedere quali sono i dettagli ed i particolari che si vogliono estrapolare da una certa sequenza di immagini: ad esempio, nei casi di fenomeni ciclici spesso è sufficiente acquisire 3 immagini al secondo. Se invece si vuole filmare il percorso di un proiettile, si deve considerare che viaggia con una velocità media di 500 m/s e, se si ha un campo visivo di 10 m, passerà nella finestra immagine in 20 ms, e se si vuole 100 immagini servirà un’immagine acquisita ogni 0.2 ms, che equivale ad un frame rate di 5000 fps.

Da letteratura si è visto che la ricostruzione della cinematica dei tentacoli di polpo o di calamaro era stata fatta utilizzando frame rate da 50 fps fino a 700 fps con risoluzione media di 640x480 ( [35] e [44] ) la variabilità dipende dalla diversità delle applicazioni stesse: nei primi esperimenti si utilizzava un tentacolo ex vivo che veniva mosso attraverso una stimolazione elettrica o lasciato libero di cadere nell’acqua, mentre lo studio del calamaro è stato condotto su un esemplare vivo.

A partire da questi valori ci siamo orientati per una velocità di acquisizione intermedia, diciamo che potesse variare dai 100 ai 400 fps. C’è infatti da dire che quello che a noi interessava al momento non era una ricostruzione estremamente particolareggiata della cinematica del tentacolo, nè si voleva analizzare movimenti così rapidi come l’estensione dei tentacoli del calamaro nella cattura di una preda, ma si voleva mantenere soprattutto un’elevata risoluzione dell’immagine per poter avere misure precise delle dimensioni delle strutture, anche nei dettagli di minori dimensioni come le ventose. Di conseguenza la scelta è stata quella di avere un sistema con frame rate moderatamente alto, ma con una risoluzione superiore alla media.

Un altro parametro importante, che influenza la qualità delle immagini acquisite, è la

shutter speed, ovvero la velocità dell’otturatore, che è il dispositivo che regola il tempo di

esposizione dei sensori ai fasci di luce. Un tempo era solamente di tipo meccanico, ora, con i dispositivi digitali, è basato su un controllo elettronico di specchietti o lenti. Aumentare la velocità di shuttering significa eliminare fenomeni di blurring, cioè di sfocatura dell’immagine, pur mantenendo costante il frame rate.

Come già visto, l’altro parametro importante per la scelta del sistema è il tempo di registrazione (record time), da non confondere con il trigger, che si occupa del passaggio delle immagini dalla camera al sistema.

La possibilità di acquisire e memorizzare immagini per un certo periodo di tempo dipende direttamente dalla quantità di memoria disponibile. Era ovvio che la memoria RAM integrata nelle tradizionali camere non era sufficiente per i nostri obiettivi.

Da qui la necessità di progettare un sistema ad hoc che permettesse un passaggio rapido dei dati dalle videocamere alla memoria dell’impianto fisso ed al sistema di visualizzazione

real time.

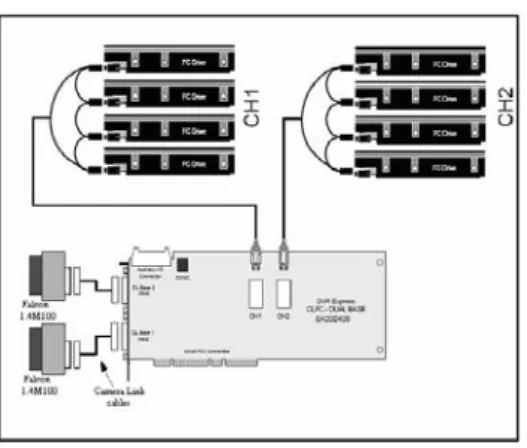

Il sistema scelto ed implementato è un prodotto della IO Industries Inc. ed è stato configurato per la gestione di video non compressi e provenienti da due videocamere ad alta velocità della DALSA tramite l’utilizzo di una scheda DVR Express® CLFC-Dual Base (1).

Nella figura 3.6 si mostra la configurazione generale dell’hardware, che sarà poi descritta e analizzata in dettaglio nel paragrafo seguente.

Figura 3. 6 Schema hardware del sistema di acquisizione immagini in cui si vedono le due videocamere connesse attraverso camera link in fibre channel alla scheda CLFC, connessa a sua volta agli 8 hard-disk.

(1)

Per maggiori dettagli hardware e software si può fare riferimento al sito della IO Industries: www.ioindustries.com .

Nell’insieme il sistema è costituito da 2 videocamere monocromatiche high speed collegate via Camera Link al frame grabber.

Il frame grabber è il cuore dei sistemi di acquisizione immagini ad alta velocità perchè permette il trasferimento e la memorizzazione in real time di tutti i dati. Nel nostro caso una scheda CLFC (Camera Link and Fibre Channel) gestisce le immagini digitali smistandole, ad una velocità di 850 Mb/s, in modo da memorizzarle in 8 hard-disk dedicati (4 per ciascuna camera) da 147 Gb l’uno (per un totale di più di un Terabyte di memoria) e permettere contemporaneamente la visione su video. Una simile coordinazione è possibile perché il sistema viaggia a 10’000 rpm (contro i 5000-7000 rpm che si trovano nei sistemi classici) e grazie all’utilizzo di collegamenti fibre channel (ITACHI ULTRI).

La gestione del sistema è affidata al software Streams™ 5.0 (IO Industries) creato appositamente per quelle applicazioni che necessitano l’utilizzo di più di un dispositivo di acquisizione dati, come nell’ high speed recording.

3.4

Il sistema nel dettaglio: the high speed cameras

Le due videocamere scelte sono le Falcon 1.4M100 (figura 3.7), che permettono l’acquisizione di immagini monocromatiche da 1.4 megapixel con un frame rate pari a 100

fps alla massima risoluzione di 1400(H) x 1024(V) (2).

Questo tipo di camera ad alta velocità è basata su una tecnologia con sensori CMOS che permettono di avere una regolazione globale dello shuttering e del reset, e di avere inoltre un’integrazione dei dati e della lettura in uscita simultanee. Si può quindi acquisire immagini di elevata qualità ad elevata velocità.

Altra caratteristica sono le dimensioni ridotte della struttura (44mm x 44mm x 44mm) che consentono di posizionarla facilmente in qualsiasi posto.

Figura 3. 7 Videocamera Falcon 1.4M100: immagine e dimensioni.

(2)

Le specifiche dettagliate relative al tipo di videocamera sono riportate nel primo paragrafo dell’Appendice A. 55

Le caratteristiche generali di questa videocamera la rendono, perciò, adatta per applicazioni in cui sono richieste immagini di ottima qualità, acquisite ad alta velocità e con un tempo di risposta rapido, e riprese in situazioni di ridotto spazio disponibile. Sono delle videocamere che vengono infatti utilizzate nel campo dell’elettronica, sia per l’osservazione di componenti, tipo wafer semiconduttori, schermi piatti, PCB-AOI, che per il monitoraggio di macchinari in generale.

Attraverso un’interfaccia software e connessione Camera Link è possibile programmare e gestire le impostazioni delle videocamere, come tempo di esposizione, guadagno, offset, etc.

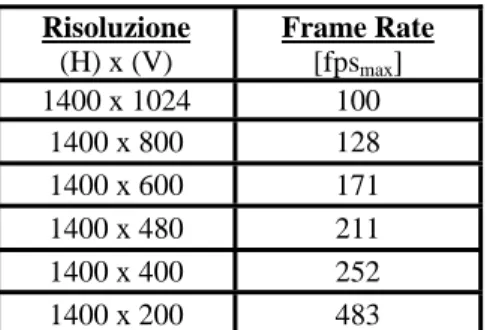

Il frame rate può essere aumentato attraverso una perdita di risoluzione solo in altezza (vertical windowing). Nella tabella 3.I si mostrano le diverse velocità di acquisizione (in

frame al secondo) e la corrispondente risoluzione, espressa in numero di pixel orizzontali (H)

per numero di pixel verticali (V).

Risoluzione (H) x (V) Frame Rate [fpsmax] 1400 x 1024 100 1400 x 800 128 1400 x 600 171 1400 x 480 211 1400 x 400 252 1400 x 200 483

Tabella 3. I Caratteristiche di risoluzione in relazione al frame rate di acquisizione per la Falcon1.4M100.

La quantizzazione dell’immagine può essere fatta a 8 o 10 bit, ma nè Windows nè lo schermo sono in grado di rappresentare immagini a 10 bit e perciò si estraggono semplicemente immagini a 256 livelli di grigio (passo di quantizzazione a 8 bit).

Va anche detto che la scelta di utilizzare camere monocromatiche basate su tecnologia al silicio è stata dettata dal fatto che queste, rispetto a delle analoghe a colori hanno una maggiore risoluzione, un maggior rapporto segnale rumore (SNR) e una maggiore sensibilità alla luce. Quest’ultima caratteristica ci è sembrata importante nel caso di dover effettuare anche riprese in notturna e sotto luce a infrarossi.

L’utilizzo della tecnologia di sensori CMOS permette di avere una riduzione del rumore e una rapidità nella raccolta dati tali da poter trasmettere le informazioni lungo cavi anche di 10m di lunghezza.

Per interesse e curiosità anche personali si è approfondito un po’ più in dettaglio la comprensione delle differenze che corrono tra la tecnologia CCD e la CMOS. La seguente

descrizione di entrambe le tecnologie ed il conseguente raffronto sono risultati utili e necessari oltre che per la scelta del tipo di sensori più adatti ai nostri scopi, anche per avere una più chiara immagine su ciò di cui, da circa una decina di anni, si discute all’interno della comunità scientifica, ovvero su quale si possa considerare la tecnologia superiore piuttosto che l’altra.

Lo sviluppo della tecnologia basata su sensori CCD (Charge Coupled Device) è iniziato a partire dagli anni ’70 e ’80. Il primo dispositivo commerciale è stato lanciato nel 1974 dalla Fairchild Semiconductor e successivamente i CCD hanno trovato largo impiego sia per la realizzazione di fotocamere e videocamere digitali, sia nel campo dell’astronomia e dell’imaging medico.

Il funzionamento di un dispositivo a CCD è basato sull’effetto fotoelettrico e su una struttura di elementi fotosensibili in silicio assemblati in array o matrici e capaci di accumulare una carica superficiale proporzionale all’intensità della radiazione elettromagnetica che ha colpito l’elemento stesso.

La superficie del sensore CCD è paragonabile a quella di un’emulsione fotografica, nel senso che alla matrice di pixel corrisponde la grana dell’emulsione.

Ma attraverso un’analisi microscopica dei due elementi sensibili risulta evidente il vantaggio nell’utilizzo della tipologia CCD. L’emulsione fotografica è infatti composta da grani di dimensioni variabili ed in genere più grandi rispetto a quelle dei pixel e distribuiti in maniera irregolare sulla superficie della pellicola. Al confronto i pixel del CCD sono tutti di identica dimensione e distribuiti in maniera uniforme e regolare all’interno della matrice.

Inoltre durante l’esposizione si ottiene una precisa mappa elettronica dell’immagine attraverso un processo di integrazione lineare delle cariche nel substrato adiacente alla matrice, che risulta esente dal cosiddetto difetto di reciprocità che si trova invece nelle emulsioni fotografiche. Una piccola nota: con reciprocità si intende il rapporto che intercorre tra l’apertura del diaframma, il tempo di esposizione e la sensibilità (velocità) della pellicola, ovvero tra i fattori che influenzano la quantità di luce che colpisce la pellicola e di conseguenza il risultato fotografico. Modificando l’apertura del diaframma si ottiene una profondità di campo più o meno ampia, attraverso il tempo si gestisce l’effetto mosso e attraverso la granularità dell’emulsione si varia la sensibilità della pellicola. Il rapporto di reciprocità è sempre lineare tranne che nelle situazioni in cui il tempo di esposizione è particolarmente breve o molto lungo: in queste condizioni gli elementi sensibili della pellicola non hanno una reazione sempre uguale, provocando risposte alla luce che sono irregolari o insufficienti.

Ultimo, ma altrettanto importante parametro di confronto è la sensibilità del sensore CCD in confronto a quella dell’emulsione in termini di efficienza quantica (ovvero di capacità di catturare i fotoni e trasformarli in elettroni), che risulta pari al 20-60% nel sensore CCD contro uno scarso 2-3% per l’emulsione.

In generale, i parametri che caratterizzano le performance di un CCD sono i fattori di maggiore importanza per la valutazione di una camera a CCD, e sono:

Efficienza quantica (Quantum Efficiency): è il rapporto tra i fotoelettroni prodotti e i fotoni incidenti, mediamente, per secondo e per ogni pixel; è quindi indice della sensibilità del sensore, ed è un numero inferiore all’unità, solitamente espresso in percentuale; è importante che sia uniforme su tutta la superficie del sensore, perchè variazioni di sensibilità tra pixel e pixel, a pari lunghezza d’onda, sono causa di rumore e riducono la qualità delle immagini; è un parametro che dipende dalla lunghezza d’onda dei fotoni incidenti ed è quindi correlata direttamente alla sensibilità spettrale.

Sensibilità spettrale: misurando l’efficienza quantica per ogni valore di lunghezza d’onda in cui si divide lo spettro di luce incidente si può costruire una curva di sensibilità spettrale per il sensore; un buon sensore CCD per l’esposizione nel campo del visibile deve avere valori di efficienza quantica non inferiori al 50% del valore di picco per lunghezze d’onda comprese tra i 400 nm e i 700 nm: in generale si hanno ottimi risultati con curve spettrali con valori di picco a 530-550 nm.

Capacità elettronica per pixel (Full Well Capacity): è il valore massimo di fotoelettroni che un sensore può accumulare in un singolo pixel, tipicamente 105-106; un valore elevato di capacità esprime un maggiore range dinamico del sensore a parità di rumore complessivo presente nel segnale: il range dinamico è infatti dato dal rapporto della Full Well

Capacity e il Readout Noise; la capacità elettronica è importante perchè quando si raggiunge

la saturazione i fotoelettroni in eccesso si spargono sui pixel adiacenti, dando luogo al fenomeno del blooming; molti CCD oggi sono comunque dotati di un filtro antiblooming, ovvero un dispositivo capace di effettuare un “drenaggio” delle cariche in eccesso, impedendo che raggiungano i pixel adiacenti.

Linearità: il CCD è quasi sempre perfettamente lineare, e quindi il numero di elettroni generati in un pixel è direttamente proporzionale alla quantità di luce incidente;

Rumore: può essere di diversa origine, ovvero si parla di Dark Current (corrente nera o rumore termico), di ReadOut Noise (rumore di lettura o rumore elettronico) e di rumore fotonico o della luce.

La corrente nera è generata dalla proprietà che hanno tutti i sensori CCD di produrre ed accumulare spontaneamente elettroni, sia quando la superficie è schermata dalla luce incidente, sia durante l’esposizione, a causa dell’agitazione termica degli elettroni stessi all’interno del CCD; quindi nei pixel si accumuleranno sia fotoelettroni prodotti dalla luce incidente, sia elettroni prodotti spontaneamente. Questo rumore può essere notevolmente ridotto raffreddando la superficie del CCD a temperature molto al di sotto dello zero Celsius, in modo da limitare tale contributo termico sul segnale; inoltre, poichè i pixel non sono tutti uguali, la dark current non si somma ad essi in modo uniforme e quindi per avere informazioni su di essa si usa la tecnica dei Dark Frames, cioè esposizioni ad otturatore chiuso con lo stesso tempo dell’immagine e alla stessa temperatura del CCD: la sottrazione del Dark Frame all’immagine permette di eliminare del tutto la dark current. Questa procedura comunque non è necessaria per esposizioni brevi, visto che a basse temperature essa si riduce ad un elettrone per ora per pixel.

Il rumore elettronico è dovuto alle componenti elettroniche necessarie per il funzionamento del CCD, ed è il responsabile principale nell’errore di misura del segnale. Può essere misurato attraverso un overscan, cioè attraverso una lettura in assenza di segnale: ad esempio per un CCD di 1000x1000 pixel si fanno leggere al controller 1200x1200 pixel, e successivamente si fanno leggere nuovamente 200 pixel per lato senza presentare segnale, ma solo con il contributo elettronico del sistema di conversione e del cosiddetto “bias” o errore sistematico.

Il rumore fotonico è dovuto alla disuniformità del flusso di fotoni incidente su una determinata superficie tra due intervalli di tempo; ha una distribuzione statistica con andamento alla Poisson e perciò con un’incertezza pari a Nfotoni .

Da circa una decina di anni i sensori CMOS (Complementary Metal Oxide Semiconductors) sono entrati a far parte del mercato come elementi per l’acquisizione delle

immagini invadendo il campo dei CCD ed innescando una disputa riguardo quale delle due tecnologie fosse la migliore. In realtà si è giunti alla conclusione che i due tipi di sensori possono facilmente coesistere dividendosi il mercato, perché ciascuno dei due possiede pregi e difetti ed è perciò più adatto a un’applicazione piuttosto che un’altra e viceversa [45], [46].

La scelta di un tipo di sensore piuttosto che l’altro può perciò essere fatta sulla base del genere di applicazione in cui sarà utilizzato, con la conoscenza delle relative caratteristiche di performance, possibilità di integrazione e costo.

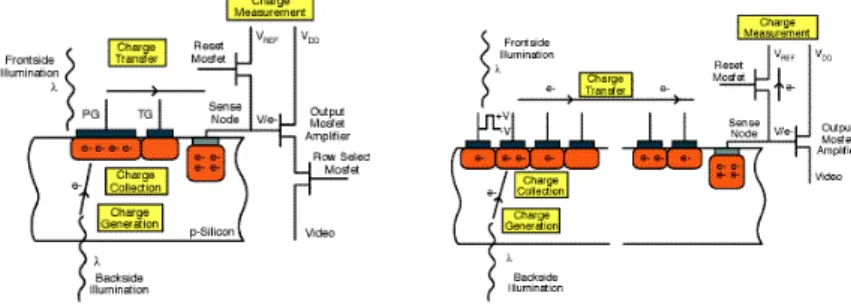

In generale i CCD e i CMOS possono essere messi a confronto considerando i quattro passi fondamentali che devono essere affrontati per l’acquisizione di un’immagine digitale: la

generazione, la raccolta, il trasferimento e la misurazione delle cariche (uno schema relativo alla sequenza è mostrato in figura 3.8).

La prima operazione, ovvero la generazione della carica, è definita come la capacità del sensore di accumulare fotoni e da questi generare il segnale elettrico sulla base dell’effetto fotoelettrico. Il parametro con cui si quantifica le performance relative a questo processo è l’efficienza quantica, descritta in precedenza. Idealmente un sensore dovrebbe avere un’efficienza quantica del 100% per tutte le lunghezze d’onda. L’efficienza quantica può essere ottimizzata nella progettazione e realizzazione del sensore minimizzando le perdite dovute ai fenomeni di assorbimento, riflessione e trasmissione. Le perdite per assorbimento sono essenzialmente dovute alle aree otticamente inerti che si possono trovare sulla superficie o all’interno dei pixel. Le perdite per riflessione e trasmissione sono invece correlate alle proprietà fisiche del silicio. In particolare, per lunghezze d’onda intorno ai 250 nm si hanno perdite per riflessione di circa il 70%, e quindi molto significative. Le perdite per trasmissione si hanno quando i fotoni incidenti attraversano il volume fotosensibile (in genere di 10 µm di spessore) senza generare alcun segnale, fenomeno che si osserva soprattutto a basse e alte frequenze, quindi nelle lunghezze d’onda vicino agli infrarossi (circa 700 nm) o ai raggi X (al di sotto degli 0.2 nm).

Figura 3. 8 Schema relativo alla sequenza di generazione, raccolta, trasferimento e misurazione delle cariche.

Per quanto riguarda le perdite di assorbimento queste sono più evidenti nei sensori CMOS perchè, mentre nei CCD non è necessario incorporare transistor attivi per la lettura, e quindi tutta la struttura è otticamente sensibile e di uno spessore di soli 0.4 µm, nei CMOS (come si può vedere da figura a sinistra) è necessario incorporare in ciascun pixel un MOSFETs (metal oxide semiconductor field effect transistors) per la lettura, che risulta come parte otticamente morta. È anche necessario che i MOSFET siano interconnessi con diversi strati di metallo, formando una struttura impilata che può diventare sede di diversi effetti ottici indesiderati come lo scattering o la diffrazione, soprattutto nel caso di fotoni a basse frequenze. L’utilizzo di opportuni schermi di luce sopra i pixel può migliorare questi inconvenienti, ma riduce

drasticamente l’efficienza quantica. Altro modo è l’utilizzo di microlenti per direzionare i fasci di fotoni sui pixel, ma non è una scelta molto pratica perchè c’è una forte sensibilità per le variazioni dell’angolo di incidenza e per la frequenza dei fotoni incidenti. Da notare che i problemi appena detti sono relativi ai sensori con pixel di dimensioni inferiori ai 10 µm: per strutture con pixel di dimensioni superiori l’efficienza quantica delle due categorie è paragonabile.

Entrambi i tipi di sensori possono avere un’ottimizzazione delle performance di efficienza quantica attraverso una riduzione dello spessore e l’utilizzo di sistemi di illuminazione posteriore, che permettono di eliminare quasi totalmente le perdite di trasmissione e di assorbimento e di raggiungere valori di efficienza quantica fino a 90%. L’applicazione di un coating di antiriflessante permette infine di eliminare le perdite per riflessione.

Nella seconda operazione per la formazione dell’immagine, ovvero la raccolta delle cariche, si deve tener conto del numero di pixels che formano il chip, della capacità elettronica per pixel, della variazione di sensibilità tra pixel e pixel (fixed pattern noise, FPN)

e della capacità di ciascun pixel di raccogliere e trasferire le informazioni ai pixel adiacenti senza perdite. Per quanto concerne i primi tre parametri le due tipologie di sensori mostrano performance paragonabili; il quarto parametro riflette la risoluzione spaziale del sistema di acquisizione ed è strettamente correlato alle considerazioni fatte in precedenza riguardo la generazione della dark current. Il rumore termico provoca una sfocatura dell’immagine come

mostrato in figura 3.9.

Figura 3. 9 Effetto del rumore termico.

La tecnologia CCD ha eliminato il fenomeno attraverso l’utilizzo di wafer di silicio ad elevata resistività ed elevati campi elettrici che si estendono dai 7 ai 10 µm, permettendo di coprire tutto lo spettro elettromagnetico fino a lunghezze d’onda di 1100 nm. Nei CMOS i campi elettrici sono limitati a coprire spessori di 1 o 2 µm, restringendo lo spettro a 650 nm, perchè si utilizza silicio a bassa resistività che richiede bassi voltaggi. Restano comunque performance paragonabile nel campo delle lunghezze d’onda della luce visibile.

Il terzo passo del processo, il trasferimento delle cariche, è piuttosto critico soprattutto per i CCD e soprattutto per array di dimensioni maggiori, in cui piccoli “pacchetti” di cariche

devono attraversare diversi strati di silicio. È quindi importante che i canali di trasferimento siano il più sgombri possibile di ostacoli al flusso di elettroni, con efficienza pari fino al 99,9%, il che richiede una particolare attenzione nella progettazione della struttura, nella scelta del metodo di fabbricazione e del tipo di silicio stesso. I CCD sono sensibili soprattutto nei casi di fonti di radiazioni ad elevata energia, che possono danneggiare il silicio o provocare interruzioni di flusso degli elettroni, come ad esempio in applicazioni di imaging protonico per l’esplorazione spaziale.

I pixel dei CMOS trasferiscono direttamente le informazioni, e la capacità del sensore di trasferire completamente le cariche dipende essenzialmente dalla robustezza dei campi elettrici tra le regioni.

L’ultimo passo del processo, la misura della carica, è identico tra le due tecnologie: un condensatore connesso all’uscita di un amplificatore MOSFET converte il segnale generato dalle cariche in una differenza di potenziale misurabile. Il condensatore deve essere di piccole dimensioni per poter aumentare il guadagno di amplificazione ed il guadagno del segnale in uscita rispetto alle fonti di rumore. È importante anche che il MOSFET sia realizzato con una geometria tale da minimizzare il rumore dovuto a fluttuazioni casuali della corrente che attraversa il transistor.

Nei CCD è possibile avere un rumore estremamente basso attraverso una accurata progettazione dell’amplificatore, dell’elettronica di processamento del segnale video e dell’utilizzo di circuiti di filtraggio digitale. Questa accuratezza è più difficile da applicare nel caso dei sensori CMOS dove tutta l’elaborazione elettronica analogica è on chip.

Un notevole punto a favore della tecnologia CMOS è stato perciò segnato dall’importante miglioramento osservato negli ultimi dieci anni per ciò che riguarda le tecnologie di microfabbricazione, della litografia in particolare, che ha dato la possibilità di avere una miniaturizzazione dei componenti tale da permettere la realizzazione di intere camere o sistemi su un singolo chip, oltre che di implementare linee di produzione per il lancio economico su larga scala.

I CMOS hanno inoltre il vantaggio di permettere un consumo di potenza nettamente inferiore e di essere quindi idonei nella realizzazione di dispositivi low-cost: c’è solo da dire

che si deve cercare un compromesso tra miniaturizzazione e costo.

Le caratteristiche di lettura in uscita dei CMOS rispetto ai CCD permettono inoltre migliori risultati nelle applicazioni scientifiche dove sono richieste alte performance, ad esempio dove è necessaria un’acquisizione high-frame-rate. Questo perchè i CCD funzionano come

dispositivi seriali, con la conversione della carica in segnale elettrico a livello del nodo di

uscita e quindi con un rate di campionamento più lento, mentre nei CMOS la conversione della carica avviene all’interno di ciascun pixel.

Nel caso di macchine che lavorano con un elevato frame-rate i sensori hanno meno tempo

per raccogliere le cariche ed è quindi importante che siano estremamente sensibili.

Un’altra caratteristica richiesta per questo genere di applicazione è l’introduzione di uno shuttering globale e di un sistema di controllo dell’esposizione indipendenti dal frame rate.

Con la tecnologia CMOS è inoltre possibile integrare on chip numerosi convertitori AD in parallelo che permettono di trasferire le informazioni all’esterno del chip a rates estremamente elevati [47].

Riassumendo: nonostante i CCD siano sensori per l’acquisizione delle immagini con capacità tali da soddisfare le esigenze del mercato in toto, i sensori CMOS risultano essere più vantaggiosi nel caso di applicazioni in cui sia necessario mantenere dimensioni ridotte degli strumenti, un basso costo di produzione ed acquisizione di immagini ad alta velocità.

3.5

Il sistema di acquisizione e gestione delle immagini

L’acquisizione delle immagini digitalizzate e la loro gestione è affidata ad un frame grabber: in particolare si utilizza la scheda DVR Express® CLFC-Dual Base (figura 3.10)

prodotta dalla IO Industries e progettata appositamente per l’acquisizione e la gestione delle immagini nel settore dell’ “high performance imaging capture”.

Figura 3. 10 Il frame grabber: la scheda DVR Express® CLFC-Dual Base.

In questo settore sono comprese le registrazioni di immagini ad alta velocità, ad elevata risoluzione, la ripresa di proiettili, di test sul comportamento dei materiali, crash tests, PIV (Particle Image Velocimetry) 2D e 3D, prove di esplosivi, la registrazione di effetti speciali e

per il cinema digitale (per un consulto delle caratteristiche della CLFC si fa riferimento alla tabella in appendice A, paragrafo A.2).

Come accennato in precedenza, la scheda utilizzata si basa sull’utilizzo di interfaccia tipo

Camera Link per l’input video.

Il sistema Camera Link è un interfaccia di comunicazione seriale che viene spesso adottato

come standard per la trasmissione di informazioni tra camera digitale e frame grabber

nell’high speed imaging. Un’alternativa possibile, ma con costo superiore e performance non

necessarie, è il GigE Vision Standard che si basa sul protocollo di comunicazione Gigabit Ethernet, e che viene usato soprattutto per portare immagini a maggiori distanze perchè

assicura il trasferimento dati oltre i 100 m di cavo, con velocità di trasferimento da 1 Gb/s a 10 Gb/s.

Camera Link è la versione dedicata ai sistemi video che si basa sullo standard Channel Link sviluppato dalla National Semiconductor e sull’utilizzo della tecnologia LVDS (Low

Voltage Differential Signaling) per la trasmissione fisica dei dati.

Il sistema è basato su un’unità di trasmissione e un’unità ricevente che comunicano attraverso 28 bit trasmessi e un segnale di clock (vedi figura 3.11). I dati sono serializzati (7:1) e trasmessi attraverso 5 LVDS: 4 per i dati e uno dedicato al clock.

Figura 3. 11 Trasferimento dati con tecnologia LVDS.

Il sistema così disposto permette una trasmissione di dati a velocità superiori di 2 Gbs. La tecnologia LVDS è un’interfaccia fisica standard per applicazioni general purpose che

permette il trasferimento di dati ad alta velocità (>155.5 Mbs) e a bassa potenza di alimentazione, sfruttando una trasmissione di dati di tipo differenziale e seriale. Lo standard su cui si basa questa tecnologia (ANSI/TIA/EIA-644 anche conosciuto come RS-644)3 è stato

3

In Appendice B si riporta una descrizione e confronto tra gli standard di interfaccia seriali RS232-RS422 e RS644 ed una descrizione dello standard di comunicazione IEEE 488.

approvato nel Marzo del 1996, e comprende dispositivi di interfaccia progettati per essere “

low noise, low power, low EMI e high speed ”.

Il differenzial signaling è un metodo di trasmissione delle informazioni in cui due segnali

complementari sono trasmessi in su due cavi separati.

Il dispositivo che riceve i due segnali legge semplicemente la loro differenza e quindi, dato che ignora la differenza di voltaggio tra filo e messa a terra, le possibili differenze che si creano tra il potenziale di massa del trasmettitore e del ricevitore non vanno ad incidere sulla capacità del ricevitore di acquisire il segnale.

Questo tipo di trasmissione è vantaggiosa anche dal punto di vista dell’immunità al rumore nel caso di sistemi a basso voltaggio. Ad oggi si cerca ormai di produrre sistemi elettronici che funzionino il più possibile a bassa potenza e con la minima emissione di radiazioni: il problema è che questi sistemi sono più sensibili al rumore. L’utilizzo di un sistema differenziale permette invece di aumentare l’immunità al rumore e quindi di diminuire la potenza di alimentazione. Confrontando con un sistema digitale single-ended alimentato con

un certo voltaggio Vs si avrà livello logico alto pari a Vs e livello logico basso pari a 0, e

perciò una differenza tra i due livelli pari a Vs. Con il sistema differenziale avrò livello logico

alto pari a Vs (un filo a Vs e l’altro a 0) e livello logico basso pari a - Vs (con i voltaggi dei fili

inversi) e quindi una differenza tra i due livelli pari a Vs-(- Vs) = 2 Vs, che significa doppia

immunità a rumore.

Il sistema di trasmissione differenziale ha anche una maggiore resistenza alle interferenze elettromagnetiche (correnti o campi indotti) che introducono rumore nel segnale. I due fili che trasmettono i dati sono accoppiati e avvolti in parallelo tra loro e hanno la stessa impedenza rispetto la messa a terra e, quindi, sono affetti dalle stesse interferenze. Ma dato che il sistema di ricezione si basa sul valore della differenza tra i due segnali, non considererà le precedenti interferenze (figura 3.12).

Figura 3. 12 Trasmissione differenziale (differential signaling).

I sistemi single-ended sono costituiti da un trasmettitore che genera un singolo voltaggio

che viene confrontato con un voltaggio fissato dal ricevitore, entrambi relativi a un valore di

massa condiviso. In questi sistemi si deve necessariamente utilizzare un livello di voltaggio alto, per evitare che fluttuazioni casuali possano trasmettere false informazioni. Hanno anche lo svantaggio di non permettere comunicazioni ad alta velocità a causa degli effetti della capacità e dell’induttanza che filtrano i segnali ad alta frequenza. Inoltre non è possibile trasmettere per lunghe distanze, perché servirebbe una potenza troppo elevata o una riduzione del voltaggio che però porterebbe ad avere troppa sensibilità al rumore e alle interferenze elettromagnetiche.

La trasmissione dati in seriale, rispetto alla trasmissione in parallelo, permette di ridurre il numero di fili per il passaggio dei dati rispetto ai classici bus paralleli. A prima vista potrebbe però sembrare una configurazione sfavorevole per ciò che riguarda la velocità di trasmissione dati: c’è invece da dire che la trasmissione differenziale e un opportuno tempo di clock permettono di raggiungere notevoli performance. Se poi la velocità di trasmissione non è sufficiente è possibile comunque disporre in parallelo più LVDS, che lavorano contemporaneamente per il trasporto dati: si costruisce di fatto un bus LVDS (o BLVDS o

Multipoint LVDS).

I collegamenti Fibre Channel seguono un protocollo per le reti di dati con velocità di

trasmissione superiori al Gbit/s. Il protocollo relativo è nato nel 1988, approvato come standard dall'ANSI nel 1994, per semplificare il sistema HIPPI allora in uso per ruoli simili. HIPPI usava delle coppie da 50 cavi e connettori di enormi dimensioni, avendo inoltre una limitata lunghezza di cablaggio. Fibre channel, primariamente, è stato quindi concepito per

semplificare il tipo di connessione ed incrementare la distanza di cablaggio, invece che la pura velocità di trasmissione. Successivamente è stato focalizzato anche per l'alta velocità e per un crescente numero di dispositivi da poter connettere.

All’interno della scheda CLFC, l’FPGA (Field Programmable Gate Array), un dispositivo

digitale programmabile via software dall’utente, si occupa dello smistamento dei bit immagine tra il sistema di visione real time e la memoria. Riprogrammando il dispositivo è inoltre possibile apportare modifiche o correggere eventuali errori.

Derivato dall’ASIC (Application Specific Integrated Circuit) ha il vantaggio di essere più

generico, proprio perché le sue funzionalità non sono programmate dal costruttore, ed ha tempi di fabbricazione inferiori. Di contro hanno prestazioni inferiori: una maggiore dissipazione di potenza, che non permette l’implementazione su dispositivi portatili, e frequenze di funzionamento inferiori (50 MHz contro i 500 MHz di un ASIC).

In definitiva comunque gli FPGA sono molto interessanti perché rappresentano il miglior compromesso tra flessibilità, prestazioni e costo.

Il sistema software IO Industries Stream™ 5.0 è stato progettato per occuparsi della

gestione dei dati registrati per le successive applicazioni.

Tra le numerose opzioni del software è possibile avere una perfetta sincronizzazione tra diversi dispositivi di acquisizione connessi al computer ed il computer stesso. Permette la manipolazione delle immagini e dei video registrati attraverso un’interfaccia grafica piuttosto intuitiva e facilmente interpretabile. È possibile controllare i device connessi e vedere le riprese in real time.

La compatibilità del software con diversi dispositive per il triggering, con diversi frame grabber (tra cui ovviamente sono le schede di videoregistrazione DVR Express CL160 e CLFC) e con vari tipi di videocamere (Dalsa, Mikrotron, Photon Focus e altre) fa sì che sia diffuso in diversi campi applicativi. Viene usato nella registrazione video in generale, nella registrazione di processi industriali, per l’ispezione di strade e ferrovie, per la video sorveglianza con alta risoluzione, la registrazione di proiettili, nei crash test, nella registrazione degli effetti speciali, per la ripresa di movimenti nelle analisi sportive o nel cinema digitale.

L’interfaccia grafica con cui si presenta inizialmente il software è mostrata nella figura 3.13: le due immagini che si vedono, realizzate durante il primo periodo delle prove, sono state prese con le videocamere in posizione stereo, con assi ottici a 90°, utilizzando due obiettivi con diversa distanza focale (16 mm per l’immagine sulla sinistra e 12 mm per l’immagine sulla destra).

Figura 3. 13 Aspetto dell’interfaccia del software Stream5 utilizzato per l’acquisizione ed elaborazione dei video ad alta velocità.

Guardando la schermata, in alto sono presenti gli strumenti per la gestione dei video (registrazione, riproduzione, selezione di una serie di frames, etc.). Sulla sinistra, in blu, sono presenti due riquadri con cui è possibile specificare e modificare i parametri relativi ai modi di registrazione. In particolare è possibile intervenire sulla qualità dell’immagine, con una LUT con cui si varia la funzione di trasferimento ed il contrasto, in termini di RGB.

Tra le caratteristiche più utili, per quello che riguarda il contesto dell’analisi svolta in questo lavoro di tesi, insieme al vantaggio di poter vedere in tempo reale la registrazione video, si annota la possibilità di rivedere e manipolare con praticità le registrazioni stesse in un successivo momento; soprattutto per selezionare un determinato frame con discreta precisione, o delimitare temporalmente le sole parti di interesse all’interno di un’intera registrazione video, con la convenienza di ricavare immediatamente i parametri temporali necessari alla ricostruzione del movimento. Oltre a questo, si è dimostrata altrettanto pratica e vantaggiosa la possibilità di ottenere con accuratezza le coordinate, in pixel immagine, di un qualsiasi punto, attraverso la digitalizzazione tramite mouse.

Si riportano di seguito alcune immagini acquisite nel corso dello studio, con l’utilizzo degli obiettivi da 12 mm, e mediante cui, grazie all’interfaccia software, è stato possibile realizzare lo studio dell’esemplare durante l’esecuzione dei tasks(figure 3.14, 3.15 e 3.16).

Figura 3. 14 Frame acquisito, con le due videocamere in configurazione stereo, in cui si vede il tipo di approccio dell’esemplare ad uno degli strumenti utilizzati che sarà illustrato di seguito.

Figura 3. 15 Una delle immagini che hanno permesso di identificare l’abitudine all’utilizzo di un tentacolo in particolare per l’esecuzione del task.

Figura 3. 16 Una delle immagini raccolte durante l’esecuzione del task di trazione, in cui è possibile vedere il tipo di posizione abituale assunta.