CAPITOLO 7: Fasi e strumenti di un progetto Six sigma

7.1 Define

Nella fase di Define si dichiarano gli obiettivi ed i limiti del progetto in funzione delle necessità del cliente, dei risultati previsti, del business dell’organizzazione e del processo.

Spesso le persone pensano che, affrontando un problema di ampia portata, si possano realizzare grandi miglioramenti e raggiungere grossi “savings”.

L’esperienza insegna che questo approccio, solitamente, ha un effetto contrario, perché è facile perdersi facendo troppe cose in una volta sola: per specificare correttamente il problema, pertanto, si deve restringere il campo di indagine a sufficienza, in modo che sia semplice identificare le cause ed introdurre azioni efficaci.

Project charter

E’ il documento in cui si definisce l’accordo stipulato tra il management ed il team [fig.7.1]. Project charter Mappa SIPOC VOC

Esso serve a:

• chiarire quanto ci si aspetta dal team,

• mantenere il team concentrato sul problema, • mantenere il team in linea con le priorità aziendali.

Se il team ha individuato più aspetti del processo in cui è necessario intervenire con progetti di miglioramento, deve effettuare una stima approssimata sull’impatto o sulle opportunità economiche potenziali, per selezionare quali di questi progetti sia effettivamente vantaggioso intraprendere. In particolare è necessario valutare:

• riduzione dei costi rispetto ad i risultati reali dei 6-12 mesi precedenti,

• prevenzione di costi, cioè si devono valutare anche i costi che attualmente l’azienda non sostiene, ma che dovrebbe sostenere se non s’interviene con il progetto di miglioramento.

SIPOC (suppliers-input-process-output-customers)

Il cliente giudica la qualità in base al risultato del processo, per migliorare la qualità è necessario quindi migliorare il processo.

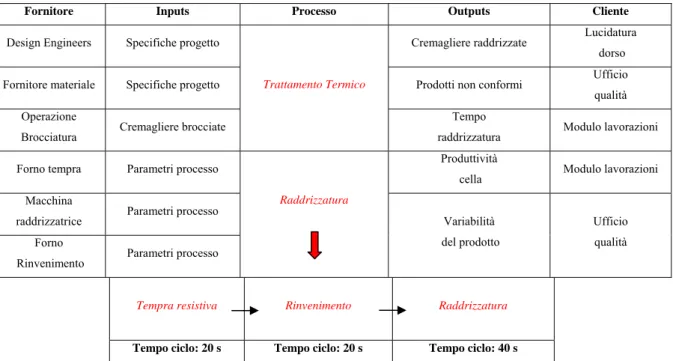

Il punto di partenza del lavoro di ottimizzazione è la redazione di una mappa del processo attuale organizzata in una tabella che ripercorre i passaggi principali del prodotto dal fornitore al cliente [fig.7.2].

Fornitore Inputs Processo Outputs Cliente

Design Engineers Specifiche progetto Cremagliere raddrizzate Lucidatura dorso

Fornitore materiale Specifiche progetto Prodotti non conformi Ufficio qualità Operazione

Brocciatura Cremagliere brocciate

Trattamento Termico

Tempo

raddrizzatura Modulo lavorazioni Forno tempra Parametri processo Produttività

cella Modulo lavorazioni Macchina

raddrizzatrice Parametri processo Forno

Rinvenimento Parametri processo

Raddrizzatura

Variabilità del prodotto

Ufficio qualità

Tempra resistiva Rinvenimento Raddrizzatura

Tempo ciclo: 20 s Tempo ciclo: 20 s Tempo ciclo: 40 s

La mappa SIPOC del progetto 199 (nome interno dell’azienda con cui è indicato il progetto di miglioramento) evidenzia che il tempo ciclo della fase di raddrizzatura è il “collo di bottiglia” della cella produttiva, quindi concentra l’attenzione del team sulla necessità di ridurre questo valore. La macchina raddrizzatrice è un dispositivo completamente automatizzato che rileva la rettilineità della cremagliera e, mediante l’azione di un maglio, esercita una pressione sui punti con freccia massima fino a portare l’asse nei limiti di tolleranza [Allegato E].

Poiché il tempo di lavoro della raddrizzatrice è, con buona approssimazione, proporzionale alla linearità della cremagliera dopo il trattamento termico, gran parte dell’attenzione del team si è focalizzata sull’analisi di questa fase cercando di trovare una soluzione per minimizzare le distorsioni.

VOC (voice of customers)

Il team deve definire chiaramente tutto quello che è importante per il cliente e tradurlo in CTQ (requisiti essenziali per la qualità).

Noraki Kano, un famoso esperto nella gestione della qualità totale, definisce tre categorie di esigenze dei clienti:

Must be: Sono le esigenze pretese dal cliente, se non vengono esaudite il cliente non è soddisfatto (per esempio la sicurezza nelle linee aeree).

More is better: Queste esigenze hanno un effetto lineare sulla soddisfazione dei clienti, quanto più esse sono esaudite, tanto più i clienti saranno soddisfatti (per esempio i biglietti aerei a prezzi contenuti).

Delighters: Quando non sono presenti, questi servizi non determinano insoddisfazione; se ci sono, il cliente è soddisfatto (per esempio una compagnia aerea che serve biscotti caldi a bordo).

Nel progetto 199 il “Modulo lavorazioni meccaniche” di TRW richiede al team Black Belt di ridurre il tempo ciclo della fase di raddrizzatura, per aumentare la produttività della cella.

Il lavoro di ottimizzazione dovrà, quindi, perseguire questo obiettivo mantenendo il prodotto nei limiti di specifica, i CTQ sono :

• errore di linearità massimo (cioè variazione massima della quota rullo): 0,04 mm, • errore di rettilineità massimo: 0,1mm,

• profondità di tempra: 0.7 - 1.3 mm,

• durezza superficiale: 51 e 59 HRC (dopo rinvenimento),

• % scarti al rilevamento cricche: il lavoro di ottimizzazione non deve influenzare la percentuale di scarti nella fase di rilevamento cricche. Infatti, poiché il processo di tempra è un trattamento altamente stressante per il materiale, potrebbe accadere che una particolare

combinazione di parametri del processo, che permette di rispettare i precedenti CTQ, comporti un incremento degli scarti al rilevamento cricche. Questa eventualità deve essere evitata.

7.2 Measure

Identificare le misure chiave, raccogliere i dati di base sui difetti

e sulle cause possibili

Sviluppare una strategia di campionamento

Convalidare il sistema di misurazione mediante Gage R&R

Analizzare il trend dei dati

Determinare gli indici di process capability

MEASURE

L’obiettivo della fase di Measure è individuare la posizione e l’origine dei problemi nel modo più preciso possibile tramite una comprensione del fenomeno basata sui rilievi sperimentali delle condizioni e dei problemi del processo attuale.

In tal modo, è possibile restringere il campo delle cause potenziali da verificare nella fase di Analyze.

Per analizzare i dati rilevati è stato utilizzato Minitab, un programma di analisi statistica e rappresentazione grafica dei risultati, che si avvale dei dati memorizzati in un foglio di calcolo.

Raccolta dei dati:

I dati raccolti devono essere:

• Sufficienti: sono necessari un numero di rilievi abbastanza grande, poiché al crescere della popolazione il campione è sempre più rappresentativo della realtà.

• Rilevanti: si devono raccogliere dati che aiutino a capire il problema che si sta analizzando. • Rappresentativi: nei dati raccolti deve essere possibile “leggere” l’intero range delle

condizioni attuali del processo.

• Contestuali: i dati vanno raccolti contestualmente con le informazioni su quello che sta succedendo nel processo.

Per ottimizzare la raccolta dei dati è necessario conoscere la tecnologia e le nozioni teoriche di base del processo produttivo, pertanto occorre pianificare una fase di studio preliminare.

Di solito le informazioni raccolte sono riassunte in un diagramma causa/effetto (Fishbone) od un diagramma ad albero [fig.7.3] che, oltre a focalizzare l’attenzione sugli aspetti più importanti, serve a correggere la naturale tendenza delle persone a saltare alle conclusioni, senza studiare adeguatamente le cause.

Diagramma ad albero

Tempo di riscaldo, se aumenta...

Si formano grani di austenite grandi Le curve di Bain si spostano a destra

Il riscaldamento è poco localizzato

Distanza d'accoppiamento, se aumenta...

Il riscaldamento è meno efficente La componente induttiva del riscaldo diventa trascurabile

Il riscaldamento è meno localizzato

Potenza di alimentazione, se aumenta...

Il riscaldamento può avvenire in tempi ridotti Si possono ottenere grani di austenite piccoli

Le curve di Bain si spostano a sinistra

Frequenza di alimentazione, se aumenta...

Il riscaldamento resistivo si localizza in superficie Il riscaldamento induttivo si localizza in superficie

Fase di Riscaldo

% Quench, se aumenta...

Si abbassa la drasticità del refrigerante Le deformazioni indotte dai gradienti termici si riducono

La profondità di tempra decresce

Geometria della doccia:

Se si realizza una doccia specifica per la cremagliera si possono ridurre le sacche di vapore a fondo dente

o ridurre l'asimmetria della curvatura

Portata refrigerante, se aumenta...

Si facilita la formazione di martensite Si elimina la fase di vapore

Si abbassa il tempo ciclo Fase di raffreddamento Tempra

Temperatura, se aumenta...

Si recuperano le deformazioni indotte nel TT Diminuisce la durezza

Rinvenimento Trattamento termico

Figura 7.3: Diagramma ad albero

Tale diagramma deve avere un layout che ne faciliti la lettura ed è molto utile per: • stimolare il pensiero del team durante il Brainstorm delle cause potenziali, • capire le relazioni tra le cause potenziali,

• focalizzare l’investigazione nelle aree di priorità.

É molto importante accertarsi che tutti coloro che sono coinvolti nella raccolta dei dati misurino una data grandezza nello stesso modo, in tal modo la dispersione dei rilievi risulta ridotta.

Se necessario si deve formulare una “definizione operativa”, ovvero una descrizione dettagliata che indica come ottenere un valore relativamente ad una caratteristica che si intende misurare.

Campionamento:

Può accadere che non sia possibile estrarre tutti i dati necessari da un processo, perché:

• la quantità di dati è eccessiva, oppure è troppo oneroso raccoglierli tutti ed analizzarli completamente,

• la raccolta dei dati è distruttiva e contemporaneamente si deve ridurre al minimo gli scarti di prodotto (caso tipico dei prodotti ad alto contenuto tecnologico).

Il campionamento è una tecnica che consente di raccogliere solamente alcuni dati: partendo da un campione relativamente piccolo, con i metodi statistici, si può giungere a conclusioni attendibili riguardanti l’intero processo (inferenza statistica).

Per migliorare la precisione di calcolo, occorre aumentare la grandezza del campione, ma ciò implica anche un aumento dei costi. TRW ha determinato dei criteri guida per stimare la grandezza del campione, che dipendono dalla caratteristica che si sta cercando di valutare (processi stabili). Se si utilizza il campione per fare inferenza sull’andamento del processo nel tempo, esso deve essere rappresentativo del processo, in tal caso:

• si estraggono campioni sistematici o per sottogruppi nel tempo,

• si effettuano campionamenti su periodi lunghi per rappresentare meglio le fonti di variabilità del processo,

• si redigono control chart e grafici di serie storiche per determinare se il processo è stabile o instabile nel tempo.

Gage R&R, validazione del sistema di misura:

Questa analisi viene generalmente usata nell’industria manifatturiera o in altre applicazioni, dove i “gage” (calibri) o altri strumenti sono usati per misurare importanti caratteristiche fisiche di tipo continuo.

Se il sistema di misura e validazione dei dati è “affetto” da un’ampia variabilità, dovuta, ad esempio, alla difficoltà di leggere il valore misurato dallo strumento, i dati raccolti risentono di tale dispersione.

I problemi più frequenti relativi alle misurazioni sono:

• distorsione ed inaccuratezza: il valor medio delle misurazioni è diverso da ciò che si ottiene con il metodo standard di misura,

• imprecisione: misurazioni ripetute sullo stesso provino variano troppo rispetto alla variabilità effettiva del processo,

• non riproducibilità: il processo di misurazione varia in funzione dell’operatore, dello strumento di rilevazione o del laboratorio che lo effettua,

• sistema di misurazione instabile nel tempo: la distorsione e la precisione variano nel tempo, • mancanza di risoluzione: la minima unità di misura leggibile è troppo grande per poter

apprezzare le variazioni del processo.

Nel progetto 199 il dato più difficile da rilevare è la profondità di tempra, la sua valutazione è fortemente influenzata dalle capacità e dall’esperienza dell’operatore, poiché si misura leggendo sulla scala graduata di un microscopio ottico lo spessore del materiale trasformato.

Sebbene la martensite venga evidenziata dalla reazione con il nital, i campioni analizzati non sempre presentano una netta linea di demarcazione, che individua la zona di transizione.

Figura 7.4: Gage R&R E’ sembrato, pertanto, opportuno indagare su questo aspetto.

Su un campione di 3 provini due operatori hanno misurato la profondità di tempra (3 volte per ogni provino). Questo test è stato eseguito con una sequenza casuale delle misurazioni: gli operatori non erano, pertanto, in grado di stimare quale provino stessero analizzando.

In fig.7.4 sono riassunti i dati della prova: ogni punto rappresenta una misura effettuata da una persona, le misurazioni effettuate dallo stesso operatore sono riunite in una spezzata. L’allineamento dei punti nella spezzata fornisce una stima della ripetitività, la differenza tra i valori medi dei dati rilevati dai diversi operatori fornisce una stima della riproducibilità.

In fig.7.5 sono riportati i dati elaborati con Minitab secondo il metodo Anova, che consente di evidenziare l’interazione tra l’operatore e la misura rilevata.

Nel diagramma “Components of variation” la variabilità del processo è stata “esplosa” in una parte (part-to-part) che è intrinseca nel processo e in una parte (gage R&R) legata alla variabilità dello strumento di misura (quest’ultima, a sua volta, è esplosa nella componente di ripetitività e riproducibilità).

Nel diagramma “R chart by metallurgista” è rappresentata la variabilità dovuta all’operatore.

Nel diagramma “Xbar Chart by metallurgista” sono riportati i valori medi delle misure effettuate: le linee rosse rappresentano la variabilità del sistema di misura, poiché i valori registrati dagli operatori attraversano tali limiti, la variabilità del sistema di misura ha un peso rilevante sulla variabilità del processo.

Nel diagramma “By provino” sono riassunti tutti i valori misurati dagli operatori, la linea rossa unisce i valori medi.

Figura 7.5

Nel diagramma “By metallurgista” sono riportate tutte le misure effettuate dagli operatori su 2 colonne distinte, la linea rossa unisce i due valori medi ed in un processo stabile deve avere pendenza nulla.

Nel diagramma “Metallurgista*Provino interaction” sono rappresentati i valori medi dei 3 provini misurati dai 2 operatori.

Queste considerazioni possono essere “condensate” in 2 indici:

σtotale σsistema_misura R & %R = Tolleranza di Campo σsistema_misura 5.15 T %P = ⋅

Nota: usando il fattore moltiplicativo 5.15 si considera che il nostro campione rappresenta la popolazione al 99%, il campo di tolleranza è 0.6mm (vedi specifica della profondità di tempra).

Il sistema di misura si può ritenere accettabile se entrambi gli indici sono inferiori al 30%.

Poiché tali indici valgono rispettivamente 25% e 31%, si è in una situazione limite che “denuncia” un sistema di misura da migliorare. Come indicato nel diagramma “Components of variation”, l’errore maggiore è imputabile alla riproducibilità [fig.7.6]: la misura della profondità di tempra è fortemente influenzata dall’operatore che la effettua.

Caratteristiche dei dati:

Per analizzare le caratteristiche dei dati si possono usare vari tipi di rappresentazioni [Allegato C]: • serie storiche,

• carte di controllo,

• istogrammi di frequenza, • diagrammi di Pareto.

Questi diagrammi sono strumenti per monitorare l’andamento del processo e permettono di distinguere due tipi di cause di variabilità.

• Cause speciali: eventi che accadono in un particolare momento o luogo, interessano i fattori che influenzano un processo, quali: la mano d’opera, le macchine, i materiali ed i metodi. Tipicamente sono temporanee, il processo affetto dalla presenza di cause speciali è instabile. La variabilità dovuta alle cause speciali non è casuale ed indica la presenza di fattori significativi che devono essere analizzati.

• Cause comuni: sono sempre presenti in un processo produttivo, rappresentano l’oscillazione naturale del processo, se la variabilità è dovuta solo a queste cause il processo è stabile. Generalmente, l’effetto di ogni singola causa è piccolo rispetto alla variabilità totale.

Se il processo è stabile si possono adottare 3 strategie per studiare le cause comuni.

• Stratificazione: i dati vengono ordinati in gruppi che hanno una caratteristica in comune, ciò permette di trarre informazioni più complete sull’origine dei problemi del processo produttivo.

• Disaggregazione: si separano i valori rilevati, cercando di individuare dei sottogruppi che facilitino la lettura del problema. Per esempio, nel caso del progetto 199, l’errore di rettilineità è stato valutato dopo ogni fase di lavorazione, ciò ha evidenziato che la fase di tempra ha un peso preponderante sulla deformazione della cremagliera.

• Sperimentazione: la variabilità dovuta ad una causa comune trae origine dall’interazione di un ampio numero di fattori. Per identificare quello più significativo, è necessario uno studio teorico del problema, convalidato da opportune prove sperimentali.

Process capability

Le misure della capacità di processo (process capability) forniscono indici statistici che sintetizzano la sua variabilità rispetto alle specifiche del cliente.

Gli obiettivi di questa analisi sono i seguenti.

• Fornire al management un’indicazione sintetica sull’andamento del processo riassunto in un unico numero.

• Fornire una scala di comparazione su cui confrontare processi diversi: si può stabilire che il processo X è migliore del processo Y se l’indice di capability del processo X è più alto di quello del processo Y. Il confronto può servire a stabilire le priorità di miglioramento.

• Mostrare se un processo nel tempo migliora le sue capacità di soddisfare le specifiche.

Figura 7.7

Per aumentare un indice di process capability, si deve diminuire la varianza del processo [fig. 7.7]. Una minore varianza produce maggiore prevedibilità e, quindi, una riduzione dei costi.

In alternativa, per aumentare questo indice, è possibile ampliare la specifica del cliente. Generalmente questa strada è difficile da perseguire poiché i clienti tendono a restringere le specifiche e non ad ampliarle.

Quando i dati continui sono distribuiti normalmente, calcolare un indice di process capability equivale a trovare l’area sotto la curva normale, che si trova all’esterno dei limiti di specifica.

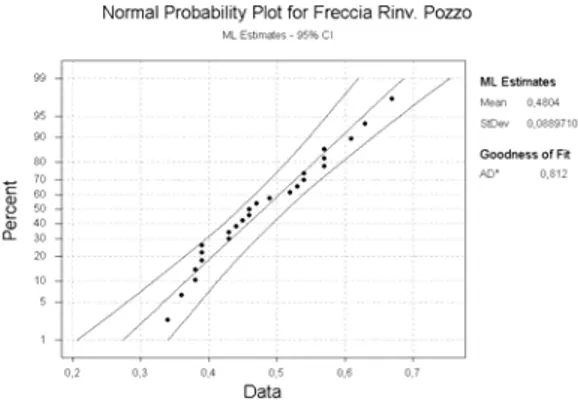

Per verificare se la distribuzione dei dati è normale, si può tracciare una carta di probabilità, che Minitab indica come “Normal probability plot” [fig. 7.8].

Sull’asse delle ordinate è riportata la frequenza cumulata in una scala scelta in modo che, se la distribuzione dei dati corrisponde a quella ipotizzata, si ha un andamento lineare.

Più in generale i dati si possono ritenere normali (con un probabilità del 95%) se cadono all’interno delle due curve (fascia di confidenza).

Un indice molto significativo per i clienti è il process sigma, che riassume in un numero le performance del processo e la capacità di soddisfare le specifiche, legandosi, inoltre, direttamente ai

Per calcolarlo, si determina il rendimento dei singoli passaggi del processo, si combinano i risultati per ottenere il rendimento totale e si calcolano i DPMO [Allegato C].

Figura 7.8: Normal probability plot, un esempio

7.3 Analyze

Questa fase del lavoro rappresenta il cuore del progetto di miglioramento. Dopo aver raccolto le informazioni sul processo attuale (Measure), è necessario indagare sulle cause della bassa performance e verificare la correttezza delle teorie proposte con prove sperimentali.

Analisi del processo

Organizzazione

delle cause Test delle ipotesi Regressione DOE

ANALYZE

Analisi del processo:

Di solito le variabili coinvolte in un processo produttivo sono molteplici, ma solo alcune influenzano significativamente i CTQ.

L’analisi sperimentale permette di formulare un’equazione (y = f(x1,x2,…..xn)) che lega le variabili di processo xi ad i CTQ (y) e, programmando una serie di prove mirate, è possibile formulare un modello comportamentale specifico, capace di spiegare e prevedere l’ andamento del processo. Questa strategia di analisi è molto diffusa nei processi industriali, dove, salvo rari casi fortunati, è impossibile effettuare cambiamenti significativi semplicemente sulla base di indicazioni teoriche. Come ampiamente descritto nella parte iniziale, nei trattamenti termici, i modelli di cui si hanno a disposizione molti dati, si riferiscono a casi semplici (barre cilindriche o lastre piane indefinite). Tali casi permettono di spiegare in modo semplice e compatto i fenomeni in gioco nel processo, ma non possono essere usati per mettere a punto un processo specifico come la tempra di una cremagliera.

Organizzazione delle cause:

I dati registrati nella fase “Measure” devono essere elaborati in modo critico, può essere utile riorganizzarli in diagrammi di frequenza stratificati, diagrammi di dispersione o altre rappresentazioni grafiche che evidenzino relazioni specifiche.

Queste informazioni, insieme alle teorie proposte dal team, aiuteranno ad avanzare ipotesi “fondate” sulle cause potenziali, che generalmente sono riassunte in diagrammi a lisca di pesce o matrici di prioritizzazione.

Test delle ipotesi

Un processo produttivo non genera mai 2 prodotti identici: attraverso questo test si può stabilire se le differenze tra i campioni sono dovute ad una variazione casuale di una causa comune o se si tratta di differenze reali.

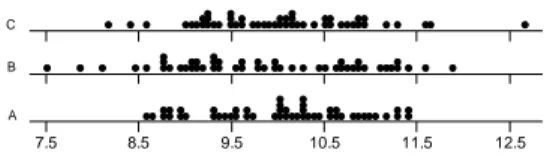

Il grafico stratificato a punti di fig.7.9 non evidenzia alcuna differenza “ovvia” tra le medie dei gruppi. Con il test delle ipotesi è possibile valutare se la lieve differenza tra le medie è dovuta ad una variazione casuale, oppure riflette una differenza reale.

Come vedremo tra breve sono stati sviluppati molti test delle ipotesi, per ognuno dei quali si possono verificare 2 situazioni:

1. H0: non si ha differenza tra le popolazioni, ipotesi nulla.

2. H1: le popolazioni sono statisticamente diverse, ipotesi alternativa.

Quando si analizzano i dati relativi a due campioni gli errori che si possono compiere sono di 2 tipi: • Errore 1° tipo: Rifiutare l’ipotesi nulla quando è vera.

• Errore 2° tipo: Accettare l’ipotesi nulla quando non è vera.

Nel test delle ipotesi si indica con P la probabilità di compiere un errore di 1° tipo, cioè la probabilità di ottenere la differenza osservata dai dati raccolti quando invece la differenza reale è statisticamente zero, il livello di tolleranza nei confronti di questo errore è, per convenzione, il 5%. Il valore di P si ricava con Minitab:

• Se P<0.05 si sceglie l’ipotesi alternativa poiché c’è una differenza reale tra i 2 campioni.

7.5 8.5 9.5 10.5 11.5 12.5

A B C

• Se P>0.05 non si può concludere che ci sia una differenza reale.

Il test delle ipotesi è stato concepito per comparare popolazioni e i presupposti perché si possa applicare sono i seguenti.

• Se i dati sono continui, si suppone che siano distribuiti normalmente. • Confrontando gruppi prelevati da popolazioni diverse si suppone che:

1. I campioni sono indipendenti.

2. I dati sono stati raccolti con campionamento casuale.

3. I dati sono rappresentativi della popolazione (senza distorsione). • Nel confronto di gruppi prelevati da processi diversi, si suppone che:

1. Ciascun processo sia stabile.

2. I dati non siano soggetti a cause speciali o scostamenti nel tempo (non si registra nessuna differenza che dipende dal tempo).

3. I campioni sono rappresentativi del processo (senza distorsione).

Nell’analisi statistica sono stati sviluppati svariati test, in funzione della caratteristica che si vuol valutare:

Test delle ipotesi Finalità

Test T Confrontare le medie di due gruppi Anova Confrontare le medie di due o più gruppi Test per varianze uguali Confrontare le varianze di due o più gruppi

Test χ2 Confrontare le proporzioni di due o più gruppi

Test T: si usa per valutare la differenza tra le medie di due gruppi ed utilizza un test statistico chiamato t- test: B -A σ ) B X A X ( ) B -A ( t = −

Date due popolazioni A e B, si estraggono dei campioni congruenti e si calcolano i valori del parametro t.

I valori di t sono distribuiti normalmente: se l’intervallo di confidenza del 95% contiene il valore “0”, si può affermare che non esiste una differenza significativa tra le popolazioni.

Questo test sostiene l’ipotesi che i gruppi hanno la stessa media, cioè: Ho: µA = µB

Se P<0.05, si deve rifiutare l’ipotesi nulla, cioè esiste una differenza statistica tra i valori medi delle popolazioni dei due gruppi.

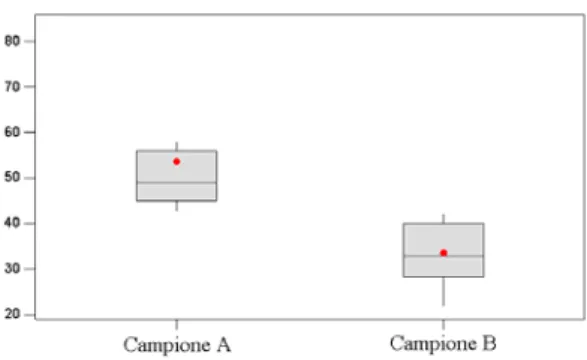

Figura 7.10: Confronto tra le medie Test per varianze uguali: si basa sul test statistico noto come F-test:

2 B σ 2 A σ F=

Date due popolazioni A e B se si estraggono svariati campioni e si calcola il parametro F, si ottiene una distribuzione con la coda “sbilanciata” verso destra [fig.7.11].

Per applicare questo test si prelevano 2 campioni, si calcola la varianza e se ne fa il rapporto. L’area di coda fornisce il valore di P.

Nel test per varianze uguali l’ipotesi nulla HO è: σ2A=σ2B cioè che i due gruppi hanno la stessa varianza, se P>0.05 HO è verificata.

Test ANOVA: dovendo confrontare i risultati di più gruppi contemporaneamente, i diagrammi a punti forniscono delle indicazioni visive d’impatto immediato, ma se è necessario effettuare un confronto numerico, si deve ricorrere al test ANOVA: un test statistico che utilizza le varianze per confrontare simultaneamente le medie di più gruppi.

Con il test ANOVA si confronta la varianza tra i gruppi con quella all’interno del gruppo [fig.7.12], se tali varianze sono uguali si può concludere che non esistono differenze statistiche tra i gruppi.

0 F

S c rap ( k g) Vendor A B C D E F G 4.5 5.5 6.5 7.5 Be tw e e n G ro u p s Wi th in G rou ps

Figura 7.12: Test ANOVA

Nel caso rappresentato in figura il test ANOVA evidenzia che il gruppo B è diverso dagli altri. Anche questo metodo si basa sul F-test, in questo caso:

2 gruppo del interno all' σ 2 gruppi dei media σ F=

L’ipotesi nulla è che le due varianze sono uguali, o, analogamente, che non c’è differenza tra le medie dei gruppi.

Test χ2: questo test serve per valutare le proporzioni tra due popolazioni, l’ipotesi nulla è che le proporzioni sono uguali.

Si basa sul teorema statistico del χ2:

∑ − = atteso valore 2 atteso) valore osservato (valore 2 χ

Anche in questo caso la funzione χ2 ha una distribuzione con coda spostata verso destra, l’area di coda rappresenta il valore di P.

L’ipotesi nulla è che le proporzioni dei gruppi sono uguali.

Un esempio può chiarire l’uso di questo test: supponiamo che un’azienda di spedizioni abbia 4 siti e vuole valutare se ci sono differenze per quanto riguarda i reclami.

A B C D

osservato atteso osservato atteso osservato Atteso osservato atteso Totale

Spedizioni con reclami 46 32.3 17 20.8 5 10.9 21 25 89

Spedizioni senza reclami 270 283.7 186 182.2 102 96.1 223 219 781

Totale 316 203 107 244 870

Nota: il valore atteso è dato dalla media pesata

Dal valore di χ2 si ricava P, se P<0.05 una delle proporzioni del gruppo è significativamente diversa dalle altre.

Regressione:

Figura 7.13

Interpolando i dati raccolti nei diagrammi di dispersione con una retta (per esempio la retta dei minimi quadrati) si ricava un’equazione che quantifica il legame tra xi e y [fig.7.13].

Essa permette di:

• effettuare previsioni: se si utilizzano i dati ricavati in un certo intervallo, per fare previsioni al di fuori di tale intervallo, è consigliabile avere una teoria di supporto che confermi l’andamento previsto.

• Controllare il processo: se la variabile xi è controllabile, può essere opportunamente variata per ottenere una determinata y.

Design of experiment (DOE):

La progettazione degli esperimenti è una tecnica per indagare in maniera efficace le relazioni causa-effetto.

Essa serve per:

• identificare poche cause essenziali della variazione (xi),

• quantificare gli effetti delle xi più importanti, comprese le interazioni, • generare un’ equazione.

Per apportare modifiche ad un processo, è opportuno adottare un approccio sperimentale ed entrare in un’ottica di apprendimento, cercando, con esperimenti mirati, di trovare conferme alle teorie. Nell’analisi tradizionale, si parte da una configurazione standard di riferimento: si modifica un fattore per volta, mantenendo costanti gli altri, e si paragonano i risultati a quelli di riferimento. In questo modo, è possibile valutare l’effetto di ogni singola variabile sul processo, ma la varianza per cause comuni rende difficile stabilire se un’impostazione data è migliore di un’altra: non è possibile valutare l’interazione delle variabili.

Nel caso in cui sono presenti molte variabili, l’analisi risulta confusa e spesso si riduce alla scelta di una combinazione di parametri migliore di quella utilizzata, senza aver compreso a fondo quali sono le variabili importanti del processo.

Spesso accade che il tempo e le risorse a disposizione non siano sufficienti per raccogliere tutte le informazioni rilevanti, in questi casi per ridurre il numero di prove si può adottare un approccio diametralmente opposto: modifica contemporanea di più fattori.

Questo metodo permette di effettuare un’analisi molto veloce che però ha i seguenti limiti. • Non è possibile identificare quali modifiche hanno prodotto un certo risultato.

• Alcune variazioni possono peggiorare il risultato ma non è possibile accorgersene a causa della sovrapposizione degli effetti di più variabili.

• Non è possibile calcolare il rapporto costo/beneficio di una singola modifica.

• Questo metodo è puramente sperimentale, poiché l’andamento di massima dei risultati non è noto a priori.

La progettazione degli esperimenti usata nei progetti Six Sigma è una versione ibrida delle 2 precedenti: l’approccio fattoriale.

Per ogni variabile del processo si impostano 2 valori (livelli), si “generano” tutte le configurazioni possibili del processo e si registra la variabile di uscita (y) [fig.7.14].

Poiché per ogni fattore aggiunto il numero di prove cresce esponenzialmente, per evitare di effettuare prove poco significative, è buona norma effettuare prove conoscitive e test iniziali per individuare le variabili più importanti del processo.

Figura 7.14

L’approccio fattoriale completo copre l’intero spazio sperimentale poiché testa tutte le combinazioni possibili e genera il quadruplo delle informazioni rispetto all’approccio “un fattore per volta”.

Può essere utile eseguire ripetizioni, cioè ripetere 2 o più volte le condizioni sperimentali, misurare i risultati (y) ed effettuare un confronto.

Le ripetizioni servono per:

• misurare l’errore puro, cioè la variabilità tra le prove eseguite nelle medesime condizioni sperimentali (variazione di una causa comune),

• osservare l’effetto prodotto da livelli diversi delle xi, non solo sulla media, ma anche sulla variabilità della risposta,

• determinare l’importanza di un fattore e stabilire se la differenza tra le risposte è dovuta alla variazione nelle condizioni del fattore (causa speciale indotta) o alla variabilità di una causa comune.

L’errore più comune che si può fare nella fase di Analyze è imbattersi in una variabile occulta, cioè una variabile che non è stata ancora inclusa tra i fattori oggetto di studio, poiché non si sa della sua esistenza o la sua influenza sul processo è ritenuta trascurabile.

Lo sperimentatore che si vuol tutelare da questo tipo di errore, deve eseguire le prove con un ordinamento casuale, senza cedere alla tentazione di ordinare gli esperimenti nel modo per lui più comodo; ciò serve a:

• bilanciare l’effetto di possibili variabili occulte su tutti i fattori di un esperimento,

• impedire che l’effetto di una variabile occulta venga attribuito erroneamente ad un altro fattore,

• convalidare le conclusioni statistiche dedotte dalle prove.

L’analisi dei dati deve essere effettuata dopo essersi accertati che questi (o il modello) non presentano anomalie (per esempio: andamenti della variabile y difficili da spiegare, che contrastano con le previsioni teoriche); l’analisi deve individuare gli effetti di grande portata e visualizzare quali ripercussioni determinano sulla risposta.

Si possono avere 2 tipi di effetto:

• Effetto principale: effetto totale prodotto da ciascun fattore sulla risposta. Rappresenta l’aumento (o il calo) medio nella risposta, quando ci si sposta da un fattore di livello basso ad uno di livello alto.

⎪ ⎭ ⎪ ⎬ ⎫ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎝ ⎛ ⎪ ⎩ ⎪ ⎨ ⎧ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎝ ⎛ − = inferiore livello nia osservaziodi tuttele media superiore livello nia osservaziodi tuttele media principale Effetto

• Effetto d’interazione: effetto sinergico di più fattori, l’interazione si verifica quando l’effetto prodotto sulla risposta y da un fattore non è uguale a tutti i livelli del fattore [fig.7.15].

)

(

2 -B con A di e interazion d' Effetto B con A di e interazion d' Effetto AB e interazion d' Effetto = +−Per decidere quali effetti si devono considerare di grande portata è possibile ricavare con Minitab: • valore di P di ogni effetto,

• diagramma di Pareto degli effetti,

• diagramma di probabilità degli effetti normali, • grafico degli effetti principali,

• grafico interazioni.

Figura 7.15

Infine è necessario riassumere le conclusioni e verificarle con:

• Prove di conferma: serie supplementari di esperimenti con le impostazioni consigliate per verificare se si ottiene il risultato desiderato.

• Modifiche al processo: si apportano le modifiche al processo e si compila una carta di controllo, per verificare di ottenere e mantenere i risultati desiderati.

A questo punto è possibile formulare l’equazione di predizione, cioè una relazione simile a quella ottenuta con l’analisi di regressione, che permette di quantificare le relazioni tra y e xi e prevedere la risposta del processo alle varie combinazioni dei parametri del processo.

7.4 Improve

Soluzioni FMEA Esperienza pilota

Implementazione delle soluzioni

IMPROVE

Soluzioni

I risultati delle prove eseguite nella fase “Analyze” hanno l’obiettivo di individuare i problemi del processo e le cause della bassa performance.

Il team, alla luce di questi risultati, deve sviluppare, pianificare e controllare le soluzioni di miglioramento.

Risolvere un progetto di miglioramento non è mai un percorso “lineare”, la soluzione può non essere unica ed è, pertanto, necessario organizzare “brainstorming” dove tutti i membri del team espongono e motivano le proprie idee.

In queste riunioni il leader ha un ruolo fondamentale: deve cercare di stimolare la creatività ed il coinvolgimento dei partecipanti, favorire il dialogo e vagliare tutte le ipotesi, anche quelle che d’impatto sembrano meno efficaci.

Le soluzioni proposte vengono riassunte in matrici di priorità: tabelle in cui si prendono in considerazione gli aspetti più importanti dell’azione di miglioramento si dà un peso ad ognuna di esse e si assegna un voto a ciascuna voce.

Il risultato è un indice numerico che individua la soluzione migliore [tab.7.2].

Criteri e pesi

Facile Rapido Tecnico Grande impatto Clienti Soluzione 2 5 2 10 6 Totale A 2 5 1 10 4 155 B 1 10 2 10 2 168 C 2 7 1 4 2 93 D 1 4 1 10 2 136

Tabella 7.2: matrice di priorità

Se la matrice delle priorità non identifica con chiarezza un’opzione migliore o se si desidera ottenere maggiori informazioni è possibile:

• modellare o simulare le soluzioni,

• raccogliere informazioni su un’azienda che ha messo in pratica un processo simile, • eseguire un test pilota su piccola scala della soluzione.

Per completare l’analisi delle soluzioni è necessario valutare i costi/benefici delle alternative, anche se questo aspetto dovrebbe essere “visibile” dalla matrice di priorità, è buona regola realizzare un documento specifico per presentare il lavoro all’esterno del team, al fine di mobilizzare le risorse per portare avanti il progetto ed ottenere il consenso degli sponsor.

FMEA (failure mode and effects analysis)

Quando si esegue una modifica del processo produttivo è necessario verificare di non aver “introdotto” delle fasi critiche, che possono provocare maggiore difettosità o renderlo più instabile. Se si riesce ad anticipare i potenziali problemi, è possibile adottare contromisure per ridurre o eliminare i rischi di fallimento.

L’analisi FMEA è un’azione preventiva sul processo per valutare gli effetti e le modalità di guasto, deve essere eseguita ogni volta che si introduce un nuovo prodotto sulla linee di produzione o si effettuano cambiamenti nel sistema produttivo.

Le fasi principali della procedura FMEA sono le seguenti [tab.7.3].

• Identificare le potenziali modalità di guasto, cioè i modi in cui un prodotto, servizio o processo possono non assolvere al proprio compito.

• Valutare i possibili effetti di ciascun fallimento e stimarne la gravità.

• Identificare le cause di tali effetti e valutare la probabilità che si possano verificare.

• Combinare i valori dei 3 punti precedenti e ricavare un indice complessivo generalmente indicato con la sigla RPN (risk priority number).

• Identificare i modi per ridurre o eliminare i rischi associati ad i valori RPN più elevati.

Probabilità di verificare il guasto: P Possibile frequenza

del guasto (indicativo) Indice Molto alta (il guasto é praticamente inevitabile) Da una volta su 3 ad una volta su 2 9-10

Elevata Da un caso su 8 fino ad un caso su 20 7-8 Moderata (guasto occasionale) Da un caso su 80 fino ad un caso su 2000 4-6 Bassa Da un caso su 50000 fino ad un caso su 150000 2-3 Remota Meno di un caso su 150000 1

Gravità del guasto: G Indice Guasto gravissimo: ha conseguenze sulla sicurezza

o sul soddisfacimento di specifiche tecniche 9-10 Guasto grave: provoca un reclamo del cliente, pur non avendo

effetti rilevanti sulla sicurezza o sul soddisfacimento di specifiche tecniche 7-8 Guasto medio: é il guasto che viene avvertito dal cliente

e provoca fastidio o irritazione 4-6 Guasto poco rilevante: viene avvertito dal cliente

ma non provoca una reazione negativa 2-3 Guasto insignificante: il guasto ha effetti trascurabili e

potrebbe non essere neppure avvertito dal cliente 1

Rilevabilità del guasto: R Frequenza del guasto

(indicativa) Indice Improbabile: la caratteristica non viene controllata. Guasti nascosti, si possono verificare in produzione o

assemblaggio < 90% 10

Molto ridotta: il guasto non é facilmente riconoscibile, è possibile rilevarlo con un controllo manuale o al

100% > 90% 9

Ridotta: guasto facilmente riconoscibile, è possibile rilevarlo con un controllo automatico al 100% > 98% 6-8 Normale: guasto riconoscibile ad occhio, è possibile rilevarlo con un controllo automatico al 100% > 99,7% 2-5 Elevata: guasto funzionale, diventa evidente nella successiva fase di lavorazione > 99,99% 1

Molti clienti richiedono a TRW di usare le FMEA per costruire piani di controllo, documenti in cui si indica le azioni intraprese dall’azienda per abbassare i rischi e “proteggere” quindi il cliente. Qualora vengano usati, i piani di controllo sono contratti tra TRW e i clienti e, come tali, non possono essere modificati senza l’approvazione del cliente stesso.

Esperienza pilota:

Si ricorre ad un test pilota quando è necessario confermare i risultati previsti e la fattibilità della soluzione poiché si devono ridurre i rischi di fallimento.

In particolare, si raccomanda questo test quando si esegue un cambiamento di ampia portata e potrebbero verificarsi conseguenze inaspettate.

Implementazione delle soluzioni:

Effettuare un cambiamento in un processo produttivo è un’operazione radicale che comporta una nuova pianificazione delle fasi di lavoro, tempi e risorse umane.

Ancora una volta, un’idonea rappresentazione grafica risulta di grande aiuto: in particolare, nella pianificazione dei progetti è molto usato il diagramma di Gantt, una tabella in cui si riassume la tempistica delle varie fasi del progetto.

Inoltre, a seguito di un cambiamento, occorre monitorare l’impatto dell’implementazione sul processo produttivo e, pertanto, si raccolgono gli stessi dati della fase “Measure” e si calcola il nuovo indice di process sigma.

7.5 Control

Standardizzare Documentare Monitorare Valutare Chiudere

CONTROL

Una soluzione può porre rimedio temporaneo ad un problema, l’obiettivo della fase “Control” è garantire che il problema non si ripresenti ed il nuovo processo possa migliorare nel tempo.

L’azione correttiva può essere intrapresa a vari livelli: • prodotto,

• processo, • sistema.

Nel progetto 199, l’azione correttiva ha interessato tutte le fasi del processo produttivo, concentrandosi sul trattamento termico.

Standardizzazione:

Prima di rendere esecutivo il progetto di miglioramento è necessario definire una procedura standard, assicurarsi che gli operatori la conoscano e la applichino correttamente.

La standardizzazione e un’idonea documentazione sono gli strumenti che permettono di mantenere alto il livello di qualità e di affidabilità del processo produttivo.

Ogni processo può essere descritto a vari livelli di dettaglio: il team deve individuare il livello più idoneo per lo sforzo di standardizzazione e scegliere di standardizzare la parte che influenza maggiormente il risultato.

Monitoraggio: carte di controllo

Per controllare la variabilità del processo è possibile monitorarlo con una raccolta continua di dati (diagramma a punti) o utilizzare le carte di controllo X-R.

Valutare:

Perché il progetto possa ritenersi concluso, è necessario dimostrare che le azioni apportate hanno risolto il problema a livello prefissato: con il test delle ipotesi si può dimostrare l’impatto statistico del progetto sul processo.

Confrontando i diagrammi di Pareto e di frequenza del processo attuale con quelli precedenti all’azione di miglioramento, si deve evidenziare l’efficacia dell’azione correttiva.

Conclusioni:

Il progetto si conclude con un dossier che riassume i risultati e le conclusioni. Questo documento è utile per:

• condividere le lezioni apprese,

• assegnare alle persone giuste la responsabilità di standardizzare e di controllare il processo, • riassumere i piani futuri e le raccomandazioni.