Capitolo 1

1.1

Il Reverse Engineering

Con il termine Reverse Engineering si indica quella disciplina, in continua evoluzione, che abbraccia molte attività e che ha come principale obiettivo quello di analizzare la forma superficiale di un qualsiasi oggetto reale, generandone un modello solido che possa essere analizzato e gestito all’interno di un moderno ambiente software CAD/CAM. Mentre l’ingegneria convenzionale trasforma idee in parti reali, nel Reverse Engineering oggetti reali sono trasformati in modelli ingegneristici.

La Reverse Engineering parte dal rilievo di un oggetto esistente in modo da poterne ottenere un modello che possa sfruttare tutti i vantaggi della tecnologia CAD/CAM. Il problema quindi consiste nell’ottenere una descrizione digitalizzata dell’oggetto, data da un certo numero di punti che ne descrivono la superficie, e dal successivo ottenimento da questi di un modello.

Questa procedura oggi si colloca all’interno di tutto il processo di progettazione di un prodotto. Fornisce uno strumento che, nell’ambito del mondo industriale e non solo, semplifica e rende efficienti i processi di design assistito al calcolatore e aumenta la qualità, l’efficienza dell’analisi della fabbricazione, e diminuisce il tempo necessario allo sviluppo del progetto stesso.

Un tempo questa pratica era adottata prevalentemente dalle aziende sprovviste di capacità creativa, ma oggi la Reverse Engineering è considerata un vero e proprio approccio ingegneristico complementare alla soluzione dei problemi di progettazione. Questa tecnica era nata con l’obiettivo di migliorare i prodotti della concorrenza, eliminando lo sforzo di progettazione originale, o per riprogettare prodotti costruiti su licenza, modificandone l’aspetto. Il processo di “riprogettazione” partiva dall’osservazione e dalla valutazione di un prodotto esistente, il quale veniva smontato ed i suoi componenti analizzati in termini di forma, funzione, tolleranze di montaggio e processo di produzione. Ciò allo scopo di ottenere un prodotto migliorato in termini di prestazioni e nei costi di fabbricazione, sia a livello di sottosistema, sia nei componenti elementari. Di qui il termine Reverse Engineering, assegnato a questo approccio progettuale, ad indicare che lo sviluppo era eseguito a ritroso partendo da un oggetto esistente.

La tendenza odierna all’abbassamento della vita media dei prodotti, favorita dalla rapida evoluzione delle mode e dello sviluppo delle tecnologie produttive, assieme all’esigenza di generare prodotti di livello qualitativo sempre più alto, hanno imposto all’industria una revisione dei processi di progettazione e di ingegnerizzazione, con l’obiettivo di ridurre i tempi di lancio dei prodotti sul mercato, il cosiddetto “time to market”. In questo ambito acquistano un’importanza sempre più strategica le tecniche dette di “Time Compression” come la Reverse Engineering.

Molti sono i campi di applicazione del Reverse Engineering, tanti dei quali sviluppatisi in questi ultimi anni, vediamone i principali:

- Importazione all’interno di sistemi CAD di prototipi e di oggetti costruiti artigianalmente. Un esempio è l’applicazione nell’industria automobilistica, in particolar modo nella fase di progettazione e modellazione di alcune parti dell’automobile. I designers possono infatti creare un modello in scala del particolare da costruire, con materiali di facile lavorabilità come la creta e successivamente digitalizzarlo, mediante un sistema di Reverse Engineering. In questo modo è possibile ottenere un modello solido da importare in ambiente CAD, per poterlo perfezionare e modificare ottenendo superfici anche di forma complessa in maniera rapida. Un altro esempio è la realizzazione di modelli digitali di prodotti artigianali realizzati per una produzione non di serie, per poterli poi adattare ad una produzione di più larga scala.

- Applicazioni speciali nel campo dell’ergonomia.

Interessa quelle applicazioni, scientifiche o sportive, nelle quali i risultati da raggiungere sono prevalenti sui costi necessari per ottenerli. Applicazioni in questo campo si trovano ad esempio nella progettazione di abbigliamento per astronauti, nella realizzazione di caschi per piloti professionisti, nello sviluppo di maschere antigas. In tutte queste applicazioni si ricerca la migliore vestibilità studiando l’interfaccia tra corpo umano ed il prodotto stesso. Benefici si sono avuti anche nello studio di protesi, sia interne che esterne, che possono essere costruite su misura del paziente.

- Cambiamenti in fase di progettazione o di produzione.

La Reverse Engineering è diventata un utile strumento affiancabile anche alla progettazione tradizionale, permettendo di apportare rapidi cambiamenti dovuti alla sovrapposizione di fasi di lavoro determinate dall’applicazione del Simultaneous Engineering.

- Replica.

In passato la duplicazione di un pezzo o un di un prototipo, richiedeva l’uso di particolari attrezzature di copiatura del pezzo. Oggi l’introduzione di sistemi di scansione automatica, che possono essere facilmente implementati in una piattaforma CAD/CAM, consentono un notevole risparmio di tempo.

L’operazione di copiatura di un pezzo può rendersi necessaria quando per esso siano persi o inesistenti i disegni originali. Ciò facilita anche le eventuali modifiche che si vogliano apportare rispetto all’oggetto acquisito.

- Produzione di pezzi di ricambio.

Se la rottura di parti di vecchi macchinari riguarda pezzi per i quali non siano più disponibili i ricambi, un sistema di Reverse Engineering risulta estremamente utile per ricostruire il modello solido del particolare danneggiato e per la sua successiva realizzazione.

- Pianificazione di un intervento chirurgico.

Benefici nell’ambito medico si riscontrano nel supporto alla pianificazione di un intervento chirurgico, infatti la digitalizzazione della parte del corpo umano soggetto all’intervento o solo ad investigazione, risulta di fondamentale aiuto. Un’applicazione ormai comune in questo campo è quello della Tomografia Assiale Computerizzata (TAC).

- Controllo di qualità (Q.C.).

In molte aree della produzione sono richiesti, sempre più frequentemente, ispezioni e controlli dimensionali dei prodotti durante la lavorazione. Quindi nell’ottica di ridurre i tempi del Q.C. e di rendelo automatizzato, sono allo studio applicazioni di tecniche di Reverse Engineering per ottenere un controllo dimensionale on-line direttamente sulla linea di produzione di oggetti il cui controllo manuale sarebbe lungo e disagevole. Le nuvole di punti acquisite sono contemporaneamente confrontate con i modelli CAD di progetto, in modo da verificare la presenza o meno di eventuali errori dimensionali e/o di forma.

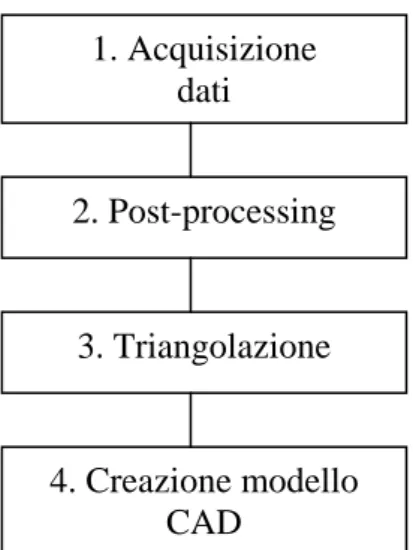

Il processo di Reverse Engineering può essere sommariamente riassunto nel diagramma di flusso di figura 1.1

1. Acquisizione dati 2. Post-processing 3. Triangolazione 4. Creazione modello CAD

Figura 1.1 Fasi del processo di Reverse Engineering

Il diagramma risulta utile per capire il flusso di informazioni, va comunque sottolineato che nella realtà risulta più complesso infatti alcune fasi si possono sovrapporre una all’altra e spesso si deve procedere iterativamente.

Il Dipartimento di Ingegneria Meccanica, Nucleare e della Produzione (DIMNP) della facoltà di Ingegneria dell’Università di Pisa è da alcuni anni impegnato in attività di ricerca riguardanti la Reverse Engineering.

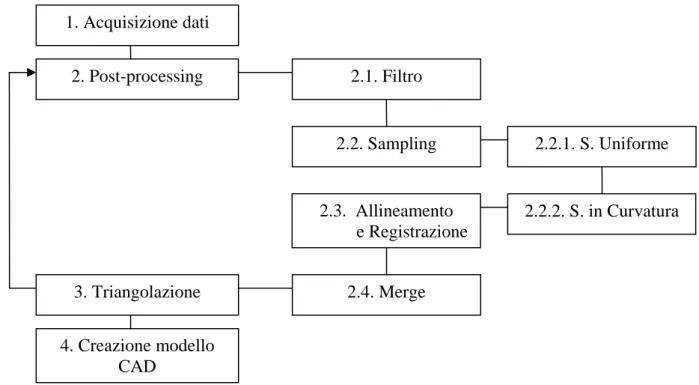

Partendo dal diagramma semplificato di figura 1.1 riguardante il flusso di informazioni nella Reverse Engineering, in figura 1.2 se ne riporta uno più dettagliato e conforme alla procedura in cui si innesta la presente Tesi.

1. Acquisizione dati 2. Post-processing 3. Triangolazione 4. Creazione modello CAD 2.1. Filtro 2.2. Sampling 2.3. Allineamento e Registrazione 2.4. Merge 2.2.1. S. Uniforme 2.2.2. S. in Curvatura

Figura 1.2 Processo di Reverse Engineering

Le sottofasi del post-processing possono essere presenti tutte o meno, e arrivati alla triangolazione può in taluni casi risultare necessario rielaborare i dati acquisiti inizialmente, nel caso la superficie ottenuta non risulti soddisfacente.

Si procede con l’analisi in dettaglio delle varie fasi, lasciando una descrizione più dettaglia del processo di semplificazione al capitolo successivo.

1.2 Acquisizione

dati

Questa fase costituisce il punto di partenza di tutto il processo, i dati acquisiti, adeguatamente elaborati, vengono registrati in un file di testo in formato ASCII. Quest’ultimo contiene le coordinate di tutti i punti registrati, ogni sua riga contiene le tre coordinate spaziali del generico punto (prima la coordinata x, poi la y ed infine la z), e costituisce l’input della successiva fase di post-processing. I punti all’interno del file possono essere o meno disposti in maniera casuale. La possibilità di disporre di dati già ordinati porta ad una diminuzione del tempo di calcolo nelle fasi successive. La procedura argomento di questa Tesi, si propone di elaborare qualunque nuvola, sia essa ordinate o meno. Ovviamente l’ordinamento dipende dalla metodologia seguita in fase di acquisizione, da questa discende quindi la procedura elaborata; nel nostro caso questa si adatta solo al sistema in studio presso il DIMNP (ordinamenti di tipo diverso verranno trattati come disposizioni casuali). La classificazione dei vari sistemi di acquisizione esistenti viene generalmente

fatta rispetto al modo con cui vengono acquisiti i dati, cioè le coordinate tridimensionali dei punti acquisiti. In figura 1.3 si riporta uno schema della classificazione dei vari metodi di acquisizione.

METODI PER L’ACQUISIZIONE DATI

SENZA CONTATTO CON CONTATTO

Metodi distruttivi Metodi non distruttivi Ottici Attivi Acustici Magnetici - Braccia Robotiche - Macchine a controllo numerico - CGI - Criotomia - Risonanza - Sonar Passivi - Stereovisione

- Shape from silhouettes - Shape from shading - Depht from focus/defocus

- Gray code - Color code - Pattern lineare - Reticolo - Metodi di Moiré Laser

Luce strutturata Interferometria

- Spot laser - Piano laser

Figura 1.3 Schema della classificazione dei metodi per l’acquisizione dati

Ogni metodo adopera un preciso meccanismo o fenomeno fisico per registrare la posizione e le dimensioni di un oggetto. Esistono “metodi senza contatto” che utilizzano sorgenti luminose, sonore o campi magnetici e “metodi con contatto” in cui la superficie viene rilevata tramite l’utilizzo di un braccio meccanico con tastatore.

Per ogni sistema si deve procedere ad un analisi per determinare la posizione dei punti appartenenti alla superficie dell’oggetto in esame, ad esempio in un sistema laser o acustico si misura il tempo di volo, mentre in un sistema a luce strutturata a viste multiple i punti sono oggetto di correlazione.

Non si può classificare un metodo migliore di un altro, ognuno di essi mostra migliori risultati in differenti casi applicativi, quindi ogni qual volta sia necessario un sistema di Reverse Engineering si deve tener conto: della morfologia dell’oggetto, della precisione richiesta, dalla economicità del processo e della velocità necessaria.

METODI CON CONTATTO

I sistemi a bracci robotizzati esplorano la superficie da misurare attraverso un attuatore o tastatore (figura 1.4) montato alla loro estremità. Questo tipo di acquisizione utilizza le classiche tecniche delle macchine di misura. Tale sistema è quindi di facile implementazione su macchine utensili, ad esempio una macchina fresatrice a tre assi può essere allestita con un tastatore al posto dell’utensile diventando così un sistema di misurazione. Queste macchine mostrano buone precisioni. Migliori risultati si ottengono con sistemi a controllo numerico, dove le macchine, impostando traiettorie predeterminate riescono a registrare dati molto accurati, quasi insensibili ai disturbi esterni. Rimangono comunque numerosi problemi quali: l’estrema lentezza delle rilevazione, la necessita di rivolgere particolare attenzione ad evitare urti del tastatore, l’impossibilita di registrare superfici concave (interne in generale), l’elevato costo della macchina. Risultano in ogni modo macchine poco sensibili a disturbi esterni, molto accurate e con alta ripetibilità delle misurazioni.

Figura 1.4 Metodo con contatto, con tastatore

Esistono anche metodi che operano in maniera distruttiva. A questa categoria appartengono sistemi come il CGI (Capture Geometri Inside) che ricava delle sezioni sottili da una matrice

polimerica in cui si “annega” il pezzo da analizzare, dopo un opportuno indurimento, a questa categoria appartiene anche la tecnica della criotomia utilizzata in campo medico con la quale sono stati ricavati modelli completi del corpo umano.

METODI SENZA CONTATTO

I sistemi senza contatto si possono dividere in metodi acustici, magnetici e ottici a seconda del fenomeno fisico che utilizzano.

Metodi acustici

Questi metodi si basano sulla misurazione del tempo di volo del suono riflesso dalla superficie in esame. Infatti conoscendo la velocità del suono e il tempo intercorso tra la sua emissione e il suo ritorno alla sorgente, riflesso dalla superficie che si sta sondando, è possibile ricavare la distanza percorsa, quindi le coordinate dell’oggetto. Questo fenomeno è usato da decenni nella misurazione delle distanze, come nel sonar e in molti sistemi fotografici autofocus. Questo metodo risulta però molto sensibile alle interferenze acustiche. Apparecchiature ad ultrasuoni sono oggigiorno utilizzate sia in campo medico che industriale, per poter analizzare sezioni interne di un oggetto.

Metodi magnetici

Questi metodi si basano sulla rilevazione dell’intensità del campo magnetico emesso da una determinata sorgente. I metodi magnetici più conosciuti sono quelli utilizzati nella diagnosi anatomica in campo medico, i quali sfruttano l’oscillazione dei nuclei degli atomi di idrogeno contenuti nelle parti molli e liquide del corpo umano (la cosiddetta risonanza magnetica, MRI). Tale metodo può essere esteso anche in campo industriale nello studio tridimensionale di membrane semipermeabili, o anche di oggetti qualsiasi che possono essere immersi in acqua e ricostruiti tridimensionalmente come l’inverso della forma assunta dal liquido che li contiene.

I metodi ottici sono quelli più in rapido sviluppo data la loro rapidità, precisione, versatilità ed economicità. Questa categoria può essere distinta in due sotto categorie principali, quella dei metodi passivi e quella dei metodi attivi.

Metodi passivi

In questi metodi non si fa uso di nessuna fonte di luce artificiale. Sono metodi che si basano sull’analisi dell’immagine. La posizione dei punti viene ricavata mediante triangolazione, dall’analisi delle immagini ottenute da una coppia di camere (telecamere o fotocamere) posizionate con angolazioni diverse rispetto all’oggetto in esame (figura 1.5). Questi metodi risultano comunque poco utilizzati data la non facile correlazione tra le coppie di immagini, spesso si ricorre infatti a riferimenti sull’oggetto (ad esempio con dei marker); in ogni modo il processo risulta lento e difficile.

Figura 1.5 Metodo ottico passivo

A questa categoria appartengono anche alcune tecniche che per ricavare le informazioni di profondità non richiedono due viste. Queste ultime utilizzano proprietà ottiche dell’oggetto quali ad esempio: l’ombreggiatura, la messa a fuoco o il contorno. Anche questi metodi risultano poco utilizzati.

Un'altra tecnica sfrutta il paragone tra un’immagine ed un modello 3D, il modello viene più volte modificato fino al combaciare dei contorni, successivamente si risale alle coordinate dei punti.

Metodi attivi

In questi metodi a differenza dei precedenti si fa uso di una fonte di luce artificiale. Essi sono quelli attualmente più utilizzati e in rapido sviluppo. Possono essere suddivisi in tre

sottocategorie in base al tipo di sorgente luminosa utilizzata: sistemi Laser (Spot o Piano Laser), sistemi ad Interferometria e sistemi a luce strutturata (emessa da un proiettore).

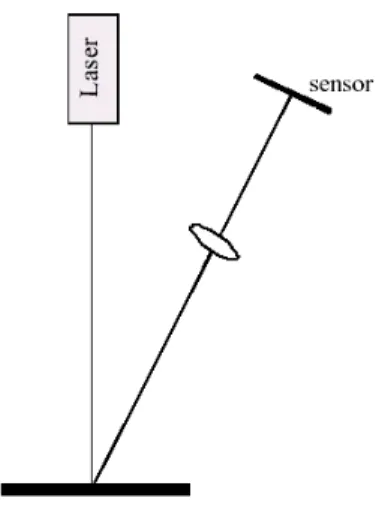

Il Laser (figura 1.6) sfrutta (similarmente ad un sistema acustico) il calcolo del tempo di volo, in questo caso ad essere riflesso dalla superficie sotto ispezione è un raggio luminoso (conoscendo tempo di volo e la velocità della luce si ricava la distanza del punto). Lo “Spot Laser” risulta lento in quanto è necessario sondare molti punti dell’oggetto uno ad uno.

Figura 1.6 Metodo ottico attivo, “Spot Laser”

Un evoluzione di tale procedimento è il “Piano Laser”, in questo metodo si proietta un piano laser e ciò velocizza la procedura di acquisizione.

I metodi ad interferometria misurano la distanza sfruttando la lunghezza d’onda della luce e ricorrendo al fenomeno dell’interferenza. Questo sistema risulta molto preciso dato che la lunghezza d’onda della luce visibile è dell’ordine delle centinaia di nanometri, mentre le applicazioni più comuni della Reverse Engineering variano in un campo che va da pochi centimetri fino anche ad alcuni metri.

I metodi basati sulla luce strutturata (SLD Structured Light Devices) sono quelli attualmente più diffusi per l’acquisizione di superfici. Essi non richiedono la movimentazione dell’apparato hardware evitando errori di riposizionamento e perdite di tempo, ed utilizzando componenti di tipo commerciale (come i proiettori) abbassando i costi del sistema. Tali metodi si basano sulla proiezione di un reticolo luminoso e sull’acquisizione dell’immagine di come questo si riflette sulla superficie dell’oggetto sotto studio.

Uno dei metodi più conosciuti è quello di Moiré (figura 1.7), dove un reticolo d’interferenza è proiettato sulla superficie producendo l’illuminazione delle linee del contorno, queste sono catturate in un’immagine ed analizzate per stabilire la distanza tra le linee. Tale distanza è proporzionale all’altezza della superficie nel punto di interesse, si possono cosi calcolare le coordinate dei punti della superficie. Questo metodo permette di acquisire una grande quantità di dati da una sola scansione dell’oggetto, me necessita di un analisi successiva sull’immagine piuttosto complessa.

Figura 1.7 Metodo ottico attivo, luce strutturata, Moiré

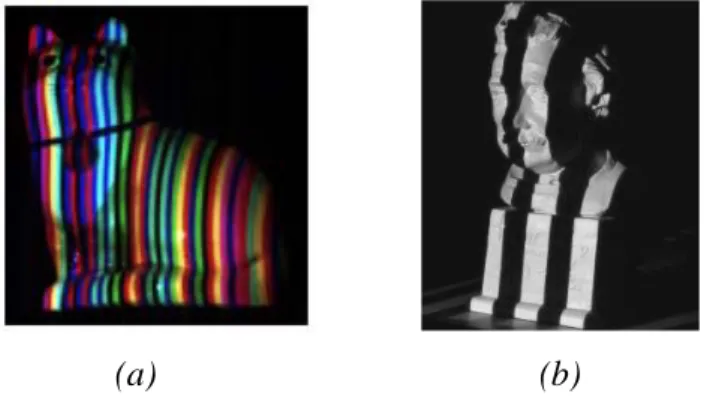

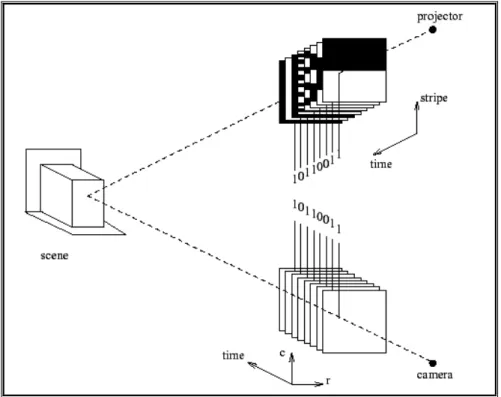

Attualmente si stanno sviluppando tecniche dette “a luce codificata”. Esse principalmente utilizzano un sistema di stereovisione (proiettore e due camere), si hanno comunque anche sistemi monovisione (un proiettore ed una camera). Questi si basano sulla proiezione di opportuni pattern luminosi che permettono di codificare i punti delle immagini mediante l’utilizzo di livelli di grigio o colore (figura 1.8a), oppure mediante particolari successioni temporali dei pattern (o anche entrambe).

(a) (b)

La codifica è importante per stabilire la corrispondenza tra i punti della coppia camera-camera o proiettore-camera, fondamentale per poter ricostruire la posizione tridimensionale dei punti della superficie scansionata. La codifica più comune è la “Gray Code” (figura 1.8b) consistente nella proiezione di una sequenza di pattern di strisce bianche o nere con una particolare successione temporale (si ottiene una codifica binaria). Il tipo di pattern proiettato influenza le prestazioni del sistema in termini di tempo, precisione e versatilità. Altri tipi di tecniche a luce codificata si basano sull’intensità di grigio o sul colore. Per un sistema di stereovisione la posizione dei punti riferita ad un piano di riferimento, quindi della superficie in esame, si ottiene per triangolazione, essendo l’angolo e le posizioni relative tra camere e proiettore note.

Il sistema sviluppato presso il DIMNP è un sistema ottico attivo a luce codificata, la rilevazione delle superfici avviene con il metodo Gray Code. Il sistema è composto da due telecamere con sensore CCD e da un proiettore video LCD (figura 1.9).

Figura 1.9 Sistema di scansione

L’LCD proietta sull’oggetto una luce strutturata, e i CCD contemporaneamente acquisiscono e memorizzano una serie di immagini a frange bianche e nere (figura 1.10), il cui periodo viene via via dimezzato.

Figura 1.10 Proiezione dei pattern di luce

Dato che le direzioni di proiezione e di acquisizione sono tra loro angolate, ciascun punto dell’oggetto inquadrato apparirà in alcune immagini della sequenza illuminato, mentre in altre no, in dipendenza dalla sua posizione nello spazio. Procedendo in questo modo si ottiene per ciascun pixel dell’immagine acquisita un codice binario, a ciascun bit del quale corrisponde una diversa immagine proiettata, ed al cui valore (0 o 1), è associato il fatto che quel pixel vada o meno ad inquadrare un’area illuminata della superficie (figura 1.11).

Figura 1.11 Determinazione corrispondenze dei punti sulle due telecamere

Attraverso questi codici è quindi possibile correlare i punti tra le due telecamere. La luce emessa del proiettore riflessa dall’oggetto va ad incidere la telecamera, attraverso le lenti colpisce il sensore CCD. Quest’ultimo non è altro che una griglia NxM di fotosensori, i quali in funzione dell’intensità luminosa con cui sono colpiti restituiscono una tensione elettrica, che verrà elaborata, ed in uscita non avremo altro che un immagine vista come una matrice NxM di pixel. L’ordine con cui esce la tensione dai fotosensori (ad esempio riga per riga della griglia) può essere utilizzata per dare un ordinamento ai punti (quindi alla nuvola di punti generata). Il generico elemento (i,j) della matrice NxM è un numero intero, compreso tra 0 e 255, indice della luminosità dell’immagine nel corrispondente pixel (0 rappresenta il nero, mentre il 255 il bianco, ho quindi 256 toni di grigio). Utilizzando le informazioni dal sistema di visione e la corrispondenza dei punti sui CCD, noto il modello matematico della telecamera, è possibile risalire per triangolazione alle coordinate spaziali dei punti.

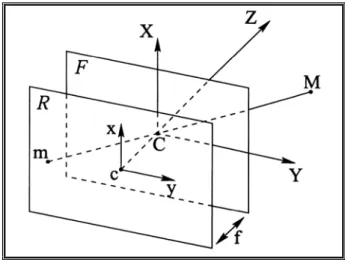

Per tarare i dispositivi costituenti il sistema di visione è richiesta una procedura, antecedente alla fase vera e propria di misurazione, che prende il nome di calibrazione. Quest’ultima serve alla ricerca di due diversi gruppi di parametri, denominati parametri intrinseci e parametri estrinseci. I primi descrivono la geometria interna e le caratteristiche ottiche della telecamera, mentre i secondi descrivono la posizione e l’orientamento della telecamera rispetto ad un sistema di riferimento prestabilito. Per usare un dispositivo come la telecamera come apparecchio di misura, si deve

sostituire alla sua costruzione interna un modello geometrico, il più utilizzato è il Pin Hole Camera (Telecamera a Buco di Spillo) [11]. Quest’ultimo è costituito da due piani, il primo dei quali presenta un foro di dimensioni infinitesime attraverso il quale possono passare i raggi luminosi, formando nell’altro piano, che è situato posteriormente al primo rispetto allo spazio di misurazione, un’immagine ribaltata dell’oggetto inquadrato (figura 1.12).

Figura 1.12 Modello Pin Hole Camera

Sebbene con tale modello si possano effettivamente ottenere delle immagini di una scena, in realtà l’intensità della luce che attraversa il piccolo foro non è sufficiente per essere rilevata dal CCD. Questo problema viene risolto ponendo davanti al piano di retina un sistema di lenti, e quindi il tutto non può più essere assimilato ad un foro di dimensioni infinitesime, ma piuttosto ad un sistema più complesso composto da un diaframma e da un sistema di lenti. Il diaframma non è altro che un’apertura variabile che regola la quantità di luce entrante nell’obbiettivo. La sua funzione è indispensabile dato che le condizioni di luminosità della scena cambiano molto a seconda delle condizioni operative. L’introduzione di un sistema di lenti porta i seguenti problemi:

- messa a fuoco necessaria per ottenere un’immagine nitida della scena

- distorsione ed all’aberrazione ottica introdotte dalle lenti reali, che non permettono più l’utilizzo diretto del semplice modello Pin Hole Camera

In particolare la non idealità del sistema ottico è dovuta ai seguenti fattori:

- le distorsioni geometriche delle lenti causano uno spostamento dei punti immagine in direzione radiale e tangenziale rispetto alla posizione ideale sul piano di retina

- aberrazioni dell’ottica, quali coma, astigmatismo ed altre sono motivo di un ulteriore blur dell’immagine

- sfuocamento, dovuto alla non perfetta messa a fuoco dell’immagine ed al fatto che, in generale, non tutti gli oggetti della scena sono alla medesima distanza dalla telecamera, e quindi non tutta la scena può essere perfettamente a fuoco

- vignetting effect, causato dalla presenza del diaframma, che fa sì che l’intensità di luce che entra nell’obbiettivo diminuisca passando dal centro ai bordi

L’algoritmo di calibrazione stima quindi i parametri estrinseci e quelli intrinseci, in modo da ricavare tutte le informazioni necessarie per trovare la relazione, che lega le coordinate di un punto dell’oggetto scansito a quelle del suo punto immagine nella memoria del Personal Computer. Si possono quindi determinare le corrispondenze e procedere alla ricostruzione.

I dati ottenuti dalla scansione risultano ordinati e vengono forniti in 3 matrici 768x1024, le cui coordinate (i, j) rappresentano l’(i, j)-pixel proiettato dall’LCD, e quindi il k-esimo punto ottenuto dalla scansione, ed il valore (i, j) riporta rispettivamente la coordinata x (figura 1.13), y, z del punto k-esimo.

1.3 Post-processing

Una volta ottenuta la nuvola di punti dalla fase di acquisizione dei dati, è indispensabile elaborarla. Ciò si rende necessario in quanto la nuvola contiene un numero estremamente elevato di dati (cioè punti), se fossero tutti processati avremmo un eccessivo dispendio di risorse con trascurabili miglioramenti della qualità. Quindi dovremo semplificare la nuvola eliminando una certa quantità di punti, in modo uniforme o in base alle curvature della superficie. Spesso la nuvola risulta affetta da rumore (dovuto alla strumentazione, a condizioni ambientali come l’illuminazione ed anche alla superficie dell’oggetto stesso) può quindi essere utile un filtro. Se si hanno più scansioni di varie parti di uno stesso oggetto può essere necessario metterle insieme al fine di ottenerne una completa rappresentazione, quindi si procede ad una registrazione ed una successiva unione (merge) delle nuvole.

A questo punto è possibile triangolare la superficie, ottenendo dalla nuvolo di punti una superficie poligonale che approssima quella reale. Potrà ora essere esportato in formato STL (solid to layer) per essere successivamente elaborato in ambienti CAD o mandato direttamente a macchine a controllo numerico capaci di leggere tali file.

1.3.1 Filtro

I dati acquisiti sono sempre, in varia misura, afflitti da rumore, che può derivare da fattori interni al sistema di rilevamento (come effetti distorcenti delle lenti) od esterni (come vibrazioni esterne o riflessi sulle superfici). Il rumore è, dove possibile, da eliminare. Alcune delle cause interne, come appunto effetti distorcenti dell’ottica in uso, costituiscono errori di tipo sistematico, cioè tali da poter essere in qualche modo compensati in fase di acquisizione. Alcuni errori esterni possono essere invece eliminati con semplici accorgimenti (postazioni isolate da vibrazioni, opacizzazione delle superfici con opportune tecniche), altri non possono essere eliminati nello stadio di acquisizione, quindi risulta spesso necessario applicare un filtro ai dati nella fase di post-processing. Tali filtri tendono quindi a ridurre il rumore nelle nuvole di punti, con un effetto di smoothing, l’entità di tale filtraggio deve comunque essere tale da non distruggere i dettagli delle superfici.

1.3.2 Sampling

Spesso la quantità di dati (numero di punti) acquisiti risulta eccessiva sia in termini di precisione richiesta per la rappresentazione delle superfici, sia in termini di domanda di risorse per i sistemi odierni di elaborazione dati. Risulta quindi necessaria una riduzione della nuvola di punti iniziale, riduzione che può essere di tipo uniforme o tale che tenga in considerazione la curvatura delle superfici. Lavorare con un numero minore di punti, ma sempre correttamente rappresentativo della superficie rilevata, porterà ad una corretta ricostruzione dell’oggetto in esame in tempi ragionevolmente brevi (senza quindi impegnare troppo il processore e la memoria RAM del calcolatore).

1.3.3 Allineamento e Registrazione

La ricostruzione di un oggetto reale tridimensionale non può essere ottenuta con una singola scansione, ma necessiterà una campagna più o meno ampia di acquisizioni, a seconda delle dimensione dell’oggetto, della risoluzione richiesta e della geometria (sottosquadri). Tutte le varie acquisizioni dovranno essere raccolte e connesse una all’altra correttamente per rappresentare in maniera continua tutta la superficie dell’oggetto, questa fase prende il nome di allineamento. Al fine di perfezionare quest’ultima si effettua la registrazione.

Questa fase, essendo l’argomento della presente tesi, verrà trattata più in dettaglio nei capitoli successivi.

1.3.4 Merge

Conclusa la registrazione si hanno ancora nuvole di punti separate, benché connesse in uno stesso sistema di riferimento. Dovranno quindi essere unite in un'unica nuvola, questa fase prende appunto il nome di merge.

In generale alla fine di questo processo si hanno delle aree di sovrapposizione (overlap), dove le diverse nuvole allineate rappresentano una stessa porzione di superfici, ciò genera in queste zone una maggiore densità di punti. A causa di quest’ultimo risultato si ha un effetto negativo nel processo di triangolazione, questo infatti basandosi sulla stima della distanza media tra i punti di una nuvola, risulta falsato dalla non uniformità di densità.

1.4 Triangolazione

E’ in questa fase che i dati che fino ad ora sono stati registrati in un file ASCII, vengono relazionati in modo da poter generare la rappresentazione della superficie acquisita. La ricostruzione della superficie è realizzata mediante elementi di tipo triangolare (da qui il termine triangolazione) che approssimano linearmente l’andamento della curvatura della superficie tra i punti che costituiscono i suoi vertici. Il numero di triangoli dipende dal numero di punti di cui è costituita la nuvola, e la loro dimensione dipende dalla risoluzione (o densità) della nuvola stessa. E’ di facile intuizione come una stessa geometria sia rappresentata in modo migliore all’aumentare del numero di triangoli che la approssimano (quindi dei punti da cui essi si generano). La triangolazione di una nuvola di punti non ha una soluzione topologica unica, non vi è quindi una relazione biunivoca tra i punti ed una loro possibile rappresentazione triangolata; esistono molte possibili strutture di dati triangolati generati da un’unica nuvola di punti, e solo una di queste rappresenta in maniera fedele l’oggetto di partenza.

Due sono i principali approcci al problema della triangolazione, quello “Triangolativo” [2] e quello “Segmentativo” [1]. Il primo di questi parte dalla generazione di una struttura chiamata “Convex Hull”, che rappresenta la minima superficie triangolata e convessa che racchiude in se o ha sulla sua superficie tutti i punti della nuvola di partenza, e prosegue con la sua modifica iterativa, con un processo di scultura, fino all’ottenimento del modello. Del secondo approccio si possono distinguere due strategie principali: la “Face Based” e la “Edge Based”. La prima parte da processi locali scegliendo dei punti “seme” e valutando la curvatura tra questo ed i punti vicini, successivamente accresce le zone in cui si riconosce un preciso andamento della curvatura. La nuvola di punti originaria viene cosi suddivisa in sottoinsiemi ognuno dei quali individua una precisa geometria. Si procede con l’assemblaggio, non semplice data la presenza di zone non organizzate e confini tra queste non sempre ben definiti. La seconda invece si basa sul riconoscimento delle degli spigoli. La triangolazione è un metodo generale, che tratta immediatamente tutti i dati a disposizione, mentre la segmentazione richiede una analisi iniziale dei dati, per avere un ordine per la definizione di un rapporto di vicinanza tra i vari punti e per avere informazioni necessarie per la scelta dei punti “seme”.

1.5 Creazione modello CAD

Questa fase rappresenta il passo conclusivo del processo di elaborazione dei dati. Si crea un file di tipo STL, in quanto in questo tipo di file i dati, che rappresentano le strutture triangolari di base del modello e le informazioni in esso contenute, sono registrati in maniera tale da poter essere

scambiate con qualsiasi sistema software CAD o fornite direttamente a macchine a controllo numerico o di prototipazione rapida.