F

ACOLTÀ DIS

CIENZEM

ATEMATICHE, F

ISICHE EN

ATURALIDOTTORATO DI RICERCA

BIOLOGIA EVOLUZIONISTICA ED ECOLOGIA

CICLO XXI

Modelli di previsione dei popolamenti ittici nei fiumi:

sviluppo e ottimizzazione mediante reti neurali artificiali

Tesi di Dottorato

Marco Quartararo

A.A. 2009/2010

F

ACOLTÀ DIS

CIENZEM

ATEMATICHE, F

ISICHE EN

ATURALIDOTTORATO DI RICERCA

BIOLOGIA EVOLUZIONISTICA ED ECOLOGIA

CICLO XXI

Modelli di previsione dei popolamenti ittici nei fiumi:

sviluppo e ottimizzazione mediante reti neurali artificiali

Tesi di Dottorato

Marco Quartararo

A.A. 2009/2010

Docente Guida: Prof. Michele Scardi

Coordinatore: Prof. Patrizia B. Albertano

Grazie alla mia famiglia e a Greta, che mi hanno supportato e sopportato con amore e fiducia in questi anni.

Grazie al prof. Michele Scardi, che con disponibilità e pazienza mi ha guidato, consigliato e insegnato tante cose.

Grazie a tutti coloro (amici, colleghi, datori di lavoro) che in forme diverse hanno contribuito a rendere più leggero il mio cammino.

I

NDICEAbstract 1

1 Introduzione 5

1.1 Inquadramento generale 6

1.1.1 Modelli predittivi in ecologia 6

1.1.2 Ecosistemi fluviali, modelli di previsione e fauna ittica 12

1.1.3 Reti neurali e modelli predittivi in ecologia 26

1.2 Obiettivi e ipotesi 46

2 Materiali e metodi 57

2.1 Il data set 57

2.2 Disegno sperimentale 64

2.3 Modello base e procedure associate 67

2.4 Misura della performance 70

2.5 Test statistici 80

3 Risultati 85

3.1 Metodi e algoritmi 85

3.2 Risultati delle prove 97

4 Conclusioni 139

Riferimenti bibliografici 153

Allegato A 157

ABSTRACT

Title: “Predictive models of fish assemblages in rivers: development and optimization by means of artificial neural networks”

Key words: predictive models, fish fauna, river ecology, artificial neural networks

The use of artificial intelligence methods for ecosystems modeling has had a considerable development in the last 20 years (Fielding, 1999; Lek, 2005; Olden et al., 2008). The work herein presented meets this research field, dealing particularly with river fish fauna prediction by artificial neural networks.

Artificial neural networks are empiric mathematical models aiming at global relations among ecosystem variables and based on general mathematical structures whose parameters need suit some given data. They typically receive one or more input variables (predictors, describing in this case abiotic environment: riverbed width, site elevation, water pH, catchment area surface, etc.) and yield the expected values of one or more output variables (presence/absence values of the species within the fish assemblage).

The relation between the ecosystems abiotic component and the structure of the connected communities is the best indicator of the ecosystems status/quality, as it represents the richest and most integrated expression of ecological processes: the ability of a physical system to support life is a direct and temporally consistent measure of the ecosystem health, more than any physical, chemical or biochemical indicator. This point of view is in agreement also with the most recent EC laws that, concerning particularly water matters, specify the adoption of biological communities as ecosystems quality indicators. Models capable of reconstructing the relations between the abiotic and biological components are then valuable work tools in ecological research and applications, supplying means for defining the characteristics and ecological status (sensu Water Framework Directive 2000/60/CE) of a site, estimating the impact of diverse strategies on the biological component, exploring the linking net of the variables involved, giving a handlable representation of the systems studied, etc. This is particularly true for the river ecosystems, today the centre of pressures potentially endangering their precious and delicate balance.

Both traditional methods (based, for example, on fish zoning or the concept of

continuum) and the modern ones, based on indexes or multivariate statistic models, partially

fail in giving reliable predictive models for river ecosystems, mostly due to simplifications or assumptions not always compatible with the real complexity of such systems and their deriving data (Fielding, 1999; Lek et al., 2005); many artificial intelligence or machine learning methods, instead, supported by suitable “learning” algorithms, are often able to build from the data effective representations of ecological systems (ivi).

The use of fish assemblage as representative elements of the biological component of ecosystems is justified by a series of considerations (Lek et al., 2005; Tancioni et al., 2005) linked to their biological activities (stay, shelter, exploration, feeding, reproduction) by which they strongly interact with both the biological and physical environment. Besides, fish are the most long-living and mobile organisms in a watercourse, therefore the information from the structure of their assemblage are spatially and temporally consistent.

The main purpose of the present work is an experimental examination of four hypotheses about as many potential strategies for model optimization (plus an additional hypothesis, ancillary with respect to the first one).

The basic model employed is a multilayer perceptron, i.e. a layered (input, internal and output layer) feed-forward neural network fully connected, with processing units (neurons) working as linear combiners with sigmoid activation function. The input layer consists of 20 neurons receiving data of as many environmental variables; each neuron of the output layer returns instead the prevision about presence or absence of one of the 32 species of the assemblage considered, on a continuous scale ranging from zero to one; this continuous value can be read as a probability of presence, but it can also be made binary by a threshold function (i.e., “absence” when the output is beneath the fixed threshold and “presence” when above); the traditional threshold is 0.5. The training was conducted by an EBP (Error Back Propagation) algorithm with early stopping and the performance assessment was based on a test set independent from the training data (obtained through a split-sample approach), so that the data were to be subdivided into three subsets (training, validation and test set) as much homogeneous as possible.

Following are the studied hypotheses:

1) regarding the threshold utilized to make the continuous output of the network binary, it is possible to determine an optimal threshold which improves (or, at most, leaves it unchanged) the performance of a model, compared with the base performance obtained with a traditional fixed threshold (0.5);

2) the optimal threshold value is linked to the species frequency within the data set through a non-decreasing function (this hypothesis is ancillary with respect to the first one);

3) with most species, the performance of the models predicting all species of the assemblage (multispecies models) is better than the one of the models predicting single species (monospecies models); with some species, however, the contrary is true;

4) models trained by a data subdivision equally distributing the presence occurrences among the subsets (training, validation and test) give a better performance than those with random distribution;

5) models trained by a data subdivision homogeneously distributing the cases relative to the elevation among the three subsets generally give a better performance than those with random distribution (the elevation, in fluvial systems, integrates a set of many covariant variables).

In order to simultaneously investigate the five hypotheses, an articulated experimental design has been arranged in order to train lots of models in the scheduled conditions; the software for the trials set up, the conduction of the experiments, the visualization of the raw outcome and the comparison of the results through statistical tests was specifically devised. A series of original algorithms and functions was developed to make data subdivisions, to find optimal thresholds, to descriptively synthesize results’ distributions and to yield a measure of performance independent from the threshold.

Since the main target was the development of a method (with related software) to experimentally test the hypotheses, it was decided not to include in the research project an original activity of data collection, but to use an already available and well known data set (Scardi et al., 2005). The sampling sites the data come from are relative to the mountain and

piedmont ranges of the watercourses in the provinces of Vicenza and Belluno. The observation of the species within the various sites was conducted by using electrofishing techniques, supported with nets in cases of sites characterized by wide riverbeds.

Cohen’s K statistics (1960), which compares observations and predictions by a

confusion matrix, was adopted to evaluate models’ performances.

The statistical comparisons were made through an original subroutine performing the Wilcoxon-Mann-Whitney test, also applying the necessary Bonferroni correction for multiple tests.

The total experimental results were 323,136.

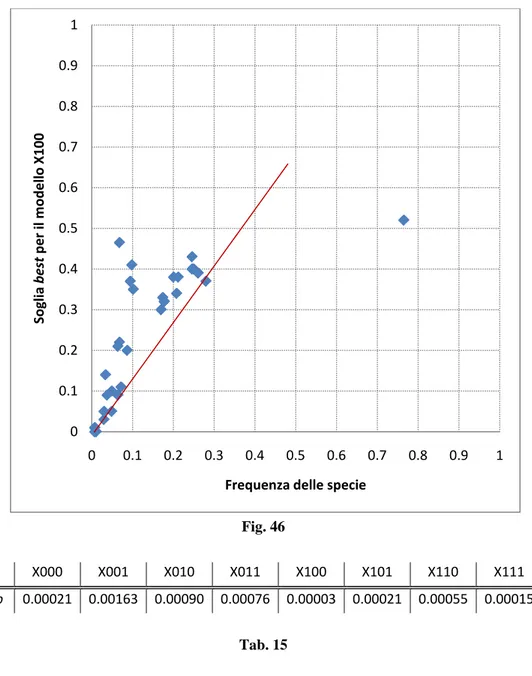

Hypothesis 1 is fully confirmed, showing that the performance of models with an optimized threshold is systematically and remarkably greater than in traditional models. It’s an important result, from both a practical point of view (the method is effective and economic and can also be applied to already trained models) and a methodological one, as it uncovers a portion of models’ predictive ability that tends to remain latent with a rigid traditional threshold. Hypothesis 2 confirms the theoretical reasons that led to the formulation of Hypothesis 1: the more a species is rare, the higher is the bias distorting the previsions (bias that it’s possible to chase by searching for an optimal threshold).

Hypothesis 3 is well confirmed in its formulation. Although determining lower performance improvements than the optimized threshold strategy, the adoption of a multispecies or a monospecies model can be critical for the prevision of some species. As expected, most of species particularly benefit of a multispecies prevision, which allows the models to use also the additional information on species associations; some species, however, prefer a single prevision, probably because strongly linked to environmental descriptors and ambiguously associated with other species. This hypothesis proposes a theme of particular interest from an ecological point of view and it’s worth further investigating.

Altogether, the strategies linked to Hypotheses 4 and 5, although generally useful, gave performance improvements less intense and significant than the ones observed for Hypotheses 1 and 3. However, the outcome encourages further studies.

In their whole, the results prove the practical and theoretical interest in working with predictive models, for both the opportunity of obtaining more effective models and the possibility of triggering a virtuous circle, where the reflections on the ecological reality produce modeling solutions that, in turn, propose new questions and ideas about the ecological reality itself. Beyond the results per se, the work done has further produced many ideas to better or to go thoroughly into some aspects or, still, to formulate new hypotheses.

The development of such an experimental work certainly implies a considerable time investment, even by only considering the necessity of writing specific software, but in the end a method and an informatic tool remain that, with the right adjustments, can test other optimization strategies and produce ecologically interesting results with any data set.

Some of the ideas herein illustrated are going to be developed in the near future, based on a broader data set (400 observations) relative to Central Italy watercourses.

1.

I

NTRODUZIONEL’uso di metodi di intelligenza artificiale per la modellizzazione degli ecosistemi ha avuto un considerevole sviluppo negli ultimi 20 anni, sollevando questioni teoriche, metodologiche, tecniche e applicative che sono state oggetto di vari studi (si vedano ad esempio le review proposte in Fielding, 1999; Lek, 2005; Olden et al., 2008). Il lavoro qui presentato si inserisce in quest’ambito di ricerca, occupandosi in particolare della previsione della fauna ittica nei fiumi tramite reti

neurali artificiali (ANN1

Le cinque ipotesi che si è scelto di studiare hanno favorito il confronto con un intreccio di tematiche tecniche (legate all’uso delle reti neurali artificiali come modelli di previsione), metodologiche (riguardanti il confronto tra misure sperimentali della performance di modelli alternativi), teoriche (legate all’ecologia dei fiumi e delle specie considerate) e applicative (connesse con gli usi potenziali dei modelli generati), che mostrano come la costruzione di modelli in ecologia sia un’attività utile e ricca di interesse.

).

Nei paragrafi che seguono, prima di illustrare le ipotesi oggetto di studio, si è ritenuto utile:

- introdurre il concetto generale di “modello”;

- illustrare il ruolo dei modelli predittivi nella ricerca e nelle applicazioni in ecologia;

- fare uno zoom sul caso particolare degli ecosistemi fluviali e della valutazione della loro qualità ecologica tramite la fauna ittica;

- introdurre i metodi di intelligenza artificiale e, in particolare, le reti neurali;

- spiegare perché tali metodi possano essere più adeguati di altri, in

alcune circostanze, per la costruzione di modelli di ecosistemi;

- far luce sul lavoro necessario per generare modelli di previsione accurati e attendibili tramite reti neurali artificiali.

1 Da “Artificial Neural Network”.

1.1 Inquadramento generale

1.1.1 Modelli predittivi in ecologia

Intesi in senso generale, i modelli sono rappresentazioni, cioè ricostruzioni di oggetti, sistemi, fenomeni o proprietà che ci permettono di visualizzarne, manipolarne, prevederne o imitarne alcune caratteristiche e comportamenti. Il concetto di modello è molto ampio: sono modelli le ricostruzioni in scala degli aerei o delle automobili, le carte geografiche, le sagome usate nelle realizzazioni artigianali, i racconti mitici che “spiegano” fatti naturali o umani, le regole culturalmente condivise, le equazioni matematiche che esprimono relazioni quantitative tra variabili, i diagrammi di flusso che descrivono procedure, le formule di struttura in chimica, gli spartiti musicali che rappresentano frequenze e durate di un insieme di suoni.

Nella scienza i modelli sono innanzitutto strumenti di conoscenza, perché permettono di formalizzare attraverso un codice che può essere grafico, linguistico, matematico, ecc. ciò che si è compreso della realtà; sono anche strumenti di previsione, perché permettono di anticipare il comportamento dei sistemi studiati sulla base di ciò che sappiamo su di essi; e sono infine strumenti di riflessione euristica, in quanto l’osservazione delle caratteristiche o del comportamento dei modelli può suggerire idee nuove sulle realtà che rappresentano, ispirando il processo di formulazione delle ipotesi. Non tutti i tipi di modello posseggono allo stesso modo queste tre caratteristiche, ma tutti le posseggono in qualche misura; pertanto, quando si parla di “modelli predittivi” o “modelli di previsione”, non si fa riferimento ad un tipo speciale di modello, ma semplicemente a modelli che rispetto ad altri si prestano in modo particolare a dire “cosa succede se…”, quale valore assumeranno alcune variabili del sistema rappresentato (variabili predette o di output) date certe condizioni di partenza (predittori o variabili di input).

I modelli possono essere molto diversi gli uni dagli altri e avere quindi ruoli diversi nella ricerca e nell’applicazione. Alcuni modelli sono più descrittivi mentre altri sono più esplicativi (si pensi alle leggi di Keplero e a quelle di Newton sul moto degli astri); alcuni si esprimono in linguaggio matematico mentre altri hanno una natura più concettuale (espressi verbalmente o tramite diagrammi) e altri ancora sono basati su relazioni geometriche (es. modelli di molecole); alcuni semplificano questioni complicate (come un grafo ad albero che rappresenta i rapporti evolutivi

tra le specie appartenenti al medesimo ordine), altri invece complicano questioni apparentemente semplici (come in meccanica quantistica); alcuni sono ben definiti, utili e dimostrabili (come quelli che descrivono il ruolo del DNA nella cellula), mentre altri possono mantenersi per anni a livello di ipotesi (come la teoria delle stringhe in fisica); alcuni sono eleganti e “trasparenti” nel loro modo di rappresentare e trattare gli oggetti studiati, ma magari si rivelano poco applicabili come strumenti di lavoro (come le equazioni differenziali di Lotka e Volterra), mentre altri sono molto più “opachi” (per questo si parla di black box) riguardo al loro modo di funzionare, ma possono rivelarsi molto utili in concreto (come le reti neurali artificiali).

Non ha molto senso chiedersi se ci siano in assoluto modelli migliori di altri, perché ognuno dialoga con particolari aspetti della capacità umana di comprendere e percepire (ad esempio, cogliere relazioni logiche tra eventi formalizzati, piuttosto che relazioni spaziali tra eventi rappresentati graficamente), costituendo un punto di vista potenzialmente utile sugli oggetti di studio. Piuttosto, quando si sceglie di sviluppare un certo tipo di modello è necessario essere consapevoli di cosa si vuol cogliere della realtà degli oggetti di studio, in modo da scegliere il canale migliore per veicolare specifici aspetti, e bisogna aver chiara la funzione che il modello sviluppato dovrà svolgere nel nostro lavoro (ad esempio, visualizzazione nitida dell’ingranaggio di un certo sistema o previsione affidabile dei suoi mutamenti di stato).

I modelli utilizzati in questo lavoro, le reti neurali artificiali, sono di tipo matematico.

Uno dei motivi per cui la formalizzazione matematica ha avuto così grande successo nel mondo della scienza è che i modelli matematici riescono spesso, rispetto ad altri, a fare bene molte cose insieme: rappresentare in modo chiaro ed elegante i rapporti tra grandezze, dar luogo a strumenti di lavoro oggettivi (cioè, condivisi e applicabili nello stesso modo da soggetti diversi), fornire previsioni precise e mostrare cosa può accadere al di là di ciò che è già stato osservato. Tra il XVII secolo e la fine del XIX la possibilità di costruire modelli matematici della realtà fu considerato un aspetto talmente caratterizzante dell’attività scientifica, da conferire una diversa dignità alle scienze hard, che erano in grado di farlo, rispetto a quelle soft, che non lo erano. Poi le cose si complicarono intorno ai primi del Novecento, quando una serie di terremoti culturali investirono il pensiero matematico (da Russell a Gödel) e quello fisico (da Planck ad Heisemberg), dando

avvio ad un percorso che rimescolerà le carte del fare scienza e valorizzerà l’uso di una pluralità di approcci e di metodi, sia in ragione della specificità degli oggetti di

studio, che dell’opportunità di osservare le cose da più punti di vista2. Tuttavia, pur

giustamente ridimensionato, l’approccio matematico trovò presto una nuova base epistemologica e fu in grado di esprimere rinnovate potenzialità applicative con lo sviluppo e la diffusione, tra gli anni ’40 e ’60, dei calcolatori elettronici.

L’ecologia nasce già, rispetto ad altre discipline biologiche, con una vocazione all’approccio matematico. Già alla fine del Settecento gli studi di Malthus sulla dinamica delle popolazioni sviluppavano con un linguaggio matematico temi che saranno poi propri dell’ecologia alcuni decenni più tardi, influenzando tra l’altro le idee di Darwin, precursore illustre del pensiero ecologico. Negli anni ’20 del secolo scorso la formalizzazione matematica delle dinamiche di popolazione di prede e predatori, compiuta indipendentemente e quasi contemporaneamente da Lotka e Volterra, prelude all’evoluzione in senso quantitativo che di lì a qualche decennio l’ecologia avrebbe compiuto, anche grazie all’affermarsi dello studio dei processi ecologici in termini di flussi energetici. Intorno alla metà del Novecento, poi, nascono la teoria dei sistemi, la cibernetica, la teoria dell’informazione e tutta una serie di altre discipline il cui principale strumento di modellizzazione è proprio il formalismo matematico e che saranno destinate ad influenzare fortemente ogni ramo della scienza o della tecnologia legato a sistemi di qualche tipo.

I modelli matematici che vengono usati oggi in ecologia sono essenzialmente riconducibili a due categorie: modelli analitici e modelli empirici (Levins, 1966). I primi scompongono i processi ecosistemici in sottoprocessi e li traducono in equazioni che rendono conto del funzionamento dei vari “ingranaggi” alla base delle dinamiche ecosistemiche. I secondi cercano di cogliere in modo più complessivo le relazioni tra le variabili in gioco negli ecosistemi e si basano su modelli matematici generali nei quali volta per volta è necessario regolare in modo empirico alcuni parametri in base ai dati. Un esempio di modello analitico è il sistema di equazioni differenziali con cui Lotka e Volterra hanno modellizzato le dinamiche di popolazione di prede e predatori. Esempio di modello empirico è invece un General Linear Model (GLM): un’impalcatura teorica generale che postula l’esistenza di

relazioni lineari tra ni variabili di input e no variabili di output e richiede che una

2 Il che permise alle discipline biologiche di affermare un proprio modo di fare scienza non meno

serie di parametri vengano regolati in funzione dei dati, per poter definire la specifica natura delle diverse relazioni lineari e conferire al modello capacità predittive (i valori assunti dalle variabili di output possono essere calcolati in funzione di quelli delle variabili di input) ed esplicative (è possibile studiare i parametri determinati per comprendere meglio le relazioni tra le variabili in gioco).

Le reti neurali artificiali sono modelli matematici di tipo empirico; dunque può essere utile spendere qualche parola in più su di essi. Quando si sviluppa un modello matematico empirico è necessario passare attraverso tre fasi successive, che spesso vengono reiterate finché il modello non rappresenti in modo soddisfacente i fenomeni rappresentati:

1) formulazione del modello – in questa fase, in base agli obiettivi, si scelgono

le variabili da considerare3; si traducono le relazioni rilevanti in una o più

funzioni matematiche interconnesse che diano luogo ad una rappresentazione astratta e generalizzata dei processi ecosistemici da

studiare; si definiscono le scale spazio-temporali a cui operare4

2) calibrazione – è la fase di regolazione dei parametri, cioè di quelle

componenti del modello che permettono di “personalizzare” il modello stesso in funzione delle caratteristiche peculiari del sistema rappresentato e dei dati da esso provenienti; nel caso della regressione lineare semplice l’intercetta a e il coefficiente angolare b della retta sono i parametri che, una volta definiti in funzione dei dati, permettono al modello lineare di specificarsi;

; si scelgono i parametri che nella fase successiva andranno regolati per consentire al modello di cogliere le peculiarità del sistema modellizzato. In molti casi si preferisce non affrontare ex novo questa fase, ma usare modelli generali già predisposti, come ad esempio quello della regressione lineare semplice per la modellizzazione di una relazione causale lineare tra due variabili; in altri casi, soprattutto quelli in cui le relazioni tra le variabili interessate non sono facilmente riconducibili a relazioni di tipo semplice (si pensi ai complessi modelli di previsione climatica o della produzione primaria), è invece necessario trovare un modo originale ed efficace per combinare in modo funzionale le variabili in gioco;

3 Non tutte le variabili coinvolte nel funzionamento del sistema sono necessariamente significative per

gli aspetti che si intende modellizzare.

4 Questo spesso influisce non solo sulla struttura del modello, ma anche sulla scelta dei dati da usare

3) validazione – è la fase di controllo, in cui il modello viene fatto “funzionare” con dati che spesso sono diversi e indipendenti da quelli usati per la calibrazione, saggiandone così le capacità predittive e di generalizzazione; se il modello ha raggiunto un optimum, il processo può interrompersi, altrimenti si torna a calibrare e il processo viene reiterato fino a quando la performance non migliora più; nel caso del modello lineare, la retta parametrizzata durante la calibrazione può essere validata con coppie di valori (x,y) noti: confrontando i valori previsionali della y con quelli osservati, si misura la capacità del modello di predire correttamente

la variabile dipendente in base alla variabile indipendente5.

Indipendentemente dal tipo di modello utilizzato, i modelli predittivi hanno spesso la caratteristica di ricevere una o più variabili in ingresso (predittori) e di fornire i valori previsionali di una o più variabili in uscita. Se le variabili in uscita sono le medesime di quelle in ingresso, allora il modello può simulare il loro modificarsi nel tempo a causa delle interazioni tra di esse nel sistema e restituire il

valore che assumeranno dopo un certo intervallo6

Questo è un tipo di compito per cui le reti neurali artificiali sono particolarmente adatte e che può contribuire a risolvere problemi come quello di conoscere la componente biotica di un ecosistema in funzione di quella abiotica. Qui le variabili di input sono i descrittori dell’ambiente abiotico (nel caso degli ecosistemi fluviali, larghezza dell’alveo, altitudine del sito, pH dell’acqua, superficie del bacino versante, ecc.), mentre quelle di output potrebbero essere la biomassa, l’abbondanza, la presenza di singole specie o coorti d’età, la loro distribuzione lungo l’asta fluviale, la diversità espressa dall’intera comunità, ecc. Nella letteratura anglosassone questo approccio è spesso definito “habitat-association” (Fielding & Bell, 1997).

. Se invece le variabili di output sono diverse da quelle di input, allora il modello potrà dirci qual è il valore assunto da queste ultime (variabili predette) in funzione del valore che hanno le variabili ricevute in ingresso (predittori).

5 A scopo esemplificativo si è proposto qui un metodo di regolazione dei parametri della retta di

regressione che è utilizzabile in linea di principio, ma è diverso da quello canonico, basato sul calcolo della varianza e della covarianza.

6 E’ questo che si fa, ad esempio, in dinamica dei sistemi (System Dynamics), un approccio simile a

La relazione tra la componente abiotica dei sistemi ecologici e la struttura delle comunità che ne fanno parte è il miglior indicatore dello status/qualità degli ecosistemi, poiché costituisce l’espressione più ricca e integrata dei processi ecologici sottostanti alle dinamiche ecosistemiche: la capacità del sistema fisico di supportare la vita è una misura diretta e temporalmente consistente della salute dell’ecosistema, più di qualsiasi indicatore di tipo fisico, chimico o biochimico (Lek et al., 2005). Questa visione concorda peraltro con la più recente legislazione

comunitaria, che in particolare in materia di acque7

I modelli che sono in grado di ricostruire i rapporti tra componente abiotica e componente biologica costituiscono dunque dei preziosi strumenti di lavoro nella ricerca e nelle applicazioni ecologiche.

prevede l’uso delle comunità biologiche come indicatori della qualità degli ecosistemi.

Sul versante applicativo, un modello di previsione di questo tipo può:

1) caratterizzare un sito sulla base di una tipologia predefinita, identificandone

la comunità potenziale in funzione dei descrittori ambientali;

2) definire lo “stato ecologico” (es. sensu Direttiva 2000/60/CE8

3) stimare l’impatto sulla componente biologica di possibili interventi sulla componente ambientale o di azioni mirate al ripristino degli ecosistemi, attraverso la simulazione dei cambiamenti attesi nella componente biologica (supporto all’elaborazione di strategie tramite la costruzione di scenari potenziali).

) di un sito attraverso il confronto tra la componente biotica attesa (fornita dal modello calibrato su siti imperturbati) e quella riscontrata tramite campionamento;

Sul versante teorico, i modelli di previsione costituiscono, già nella fase di formulazione, dei potenti strumenti di riflessione sul funzionamento degli ecosistemi, sull’intreccio tra variabili al loro interno e sui processi che ne sostengono gli equilibri. Ma in modo più specifico essi permettono anche di:

1) esplorare la rete di relazioni tra variabili, identificando cosa influisce

maggiormente, e come, su particolari variabili di interesse9

7 Direttiva Quadro sulle Acque, 2000/60/CE del Parlamento Europeo e del Consiglio, del 23 ottobre

2000, che istituisce un quadro per l'azione comunitaria in materia di acque ed è nota anche con il suo acronimo inglese, WFD (“Water Framework Directive”).

;

8 La Direttiva prevede il raggiungimento dello status “Buono” per tutte le acque superficiali e

sotterranee degli Stati aderenti entro il 2015.

9 Uno degli strumenti più usati per fare questo è l’analisi di sensibilità, che variando uno per uno i

2) disporre di una rappresentazione manipolabile dei sistemi studiati, con la quale è possibile condurre “esperimenti simulati” in cui si osservano i comportamenti del sistema allorché alcune variabili vengono modificate in un certo modo; questa possibilità di “giocare” con i modelli dei sistemi ha una grande potenzialità euristica, perché permette di riprodurre condizioni mai osservate direttamente e di mettere in risalto meccanismi non ancora

teorizzati, guidando così il processo di generazione di nuove ipotesi10.

1.1.2 Ecosistemi fluviali, modelli di previsione e fauna ittica

La costruzione di modelli di previsione per gli ecosistemi fluviali è oggi un’attività di notevole interesse teorico e applicativo, sia per le ragioni descritte in generale nel paragrafo precedente, applicabili a tutti gli ecosistemi, che per alcune peculiarità legate in particolare a questi sistemi ecologici.

Innanzitutto, la crescita della popolazione umana e il conseguente incremento delle attività produttive e di uso del territorio determinano oggi nel mondo un continuo aumento sia del fabbisogno di acqua dolce, che della pressione antropica

sui bacini idrogeologici11

di queste ultime dipenda da ognuno dei predittori. Si veda Olden et al. (2008), p. 181, per una veloce rassegna dei vari metodi utilizzati a questo scopo.

(Lek et al., 2005). Quest’ultima si esprime in forme estremamente varie, dall’artificializzazione degli alvei, alla costruzione di barriere necessarie per la produzione idroelettrica, al prelievo di acqua e materiali di vario genere, alla deforestazione, alla pressione edilizia o agricola sui versanti, alle attività estrattive, allo scarico di acque reflue da uso privato o industriale, alla pesca sportiva

10 Questo è particolarmente importante nelle scienze come l’ecologia o l’astronomia che non possono

basarsi come altre su un vero e proprio approccio sperimentale.

11 Il bacino idrogeologico è la porzione di ambiente fisico che ospita l’ecosistema fluviale, il quale non

si limita alla zona inondata dalla massa d’acqua corrente, ma coinvolge l’intera superficie di dilavamento delle acque che naturalmente convergono verso l’alveo. Se si considera solo lo scorrimento superficiale delle acque, si parla di “bacino idrografico”, mentre il concetto di bacino idrogeologico è più ampio e tiene conto della superficie impermeabile su cui può verificarsi uno scorrimento anche sotterraneo delle acque. Nel caso del bacino idrografico è possibile determinare in modo abbastanza preciso un “limite spartiacque”, detto anche displuvio, che costituisce il margine entro cui le precipitazioni meteoriche restano confinate nel bacino stesso e dilavano verso il corso d’acqua. Nella maggior parte dei casi, comunque, il concetto di bacino idrografico è sufficiente a rappresentare in via generale il contesto fisico dell’ecosistema fluviale.

e commerciale, ecc12. Dunque è di primaria importanza comprendere e monitorare i vari aspetti del funzionamento di questi ecosistemi, non solo perché essi rappresentano un valore naturale in sé, ma anche per poter continuare ad interagire produttivamente con essi senza comprometterli. I fiumi costituiscono infatti un comparto fondamentale per il ciclo dell’acqua, interagiscono in modo profondo con il territorio, modellandolo e influenzandone le caratteristiche climatiche, e posseggono potenti sistemi di autodepurazione che li rendono fonti preziose di acqua dolce per tutti gli organismi. Per quanto molti studi nel secolo scorso abbiano contribuito ad identificare i processi ecosistemici operanti nelle acque dolci,

l’approccio modellistico di tipo top-down13 da essi proposto non ha condotto ai

risultati attesi, cioè a modelli deterministici che in base ai determinanti ambientali e al disturbo antropico forniscono previsioni del comparto biologico ad un livello tassonomico o funzionale rilevante (ivi). La ricerca in questo campo resta dunque

aperta e l’approccio bottom-up14, legato a modelli come le reti neurali, è ancora tutto

da esplorare.

La costruzione di modelli di previsione per gli ecosistemi fluviali è inoltre esplicitamente raccomandata dalla Direttiva Quadro sulle Acque (ivi) per completare il set di strumenti per la valutazione dello stato ecologico dei fiumi, attualmente rappresentati quasi esclusivamente da indici come l’IBE (Indice Biotico Esteso) e l’IFF (Indice di Funzionalità Fluviale). Questi hanno buone basi teoriche, praticità di utilizzo e una discreta capacità di integrare informazioni su variabili sia biotiche che abiotiche; non sempre però riescono a tenere conto in modo adeguato delle condizioni di riferimento specifiche di un particolare corso d’acqua o di una specifica tipologia fluviale (sensu Direttiva Acque), tendono a semplificare drasticamente il sistema rappresentato e non permettono simulazioni per proiettare nel futuro le conseguenze di potenziali strategie gestionali, né si prestano ad analisi di tipo euristico. Lo sviluppo di modelli di previsione può dunque essere affiancato agli indici per completarne le potenzialità.

12 Alcune informazioni sono state tratte da documenti prodotti nell’ambito delle attività dell’Autorità di

Bacino del fiume Magra (http://www.adbmagra.it/).

13 La struttura del modello esprime le conoscenze teoriche circa il funzionamento del sistema

rappresentato. In System Dynamics, ad esempio, si costruiscono modelli di questo tipo.

14 La struttura del modello esprime le conoscenze empiriche, ricavate dai dati, circa il funzionamento

Infine i sistemi ecologici fluviali, nonostante la loro complessità di ecosistemi aperti, presentano una struttura particolare che ne favorisce la modellizzazione: con una ipersemplificazione si può dire che essi hanno una sagoma nastriforme, con i due capi estremi posti ad altitudini diverse e una sezione trasversale concava verso l’alto. Questo determina l’elemento più caratterizzante del sistema, lo scorrere unidirezionale della corrente d’acqua, e fa sì che molte variabili fondamentali di tipo geo-morfologico, chimico-fisico e trofico (Gelosi & Colombari, 2004), nonché biologico (comunità), varino in modo associato man mano che ci si sposta da monte a valle. Ad esempio, con l’allontanarsi dalla sorgente diminuiscono l’altitudine, la pendenza, la velocità della corrente, la turbolenza, la concentrazione di ossigeno, il trasporto solido, la granulometria media del sedimento, l’ombreggiatura dovuta alla vegetazione riparia, mentre aumentano la temperatura, la torbidità, l’ampiezza dell’alveo, la portata, il trasporto di materiale in sospensione, la concentrazione di

sali e nutrienti, l’ordine dell’asta fluviale15

Su questa sorta di “informazione portante” che aggrega un gran numero di fattori, il modello potrà poi rappresentare le modulazioni prodotte da altre variabili, come i tipi di roccia che caratterizzano il bacino idrografico, la sinuosità e variabilità morfologica dell’alveo, la durezza dell’acqua, il pH, il genere e la quantità di copertura vegetale sui versanti, il disturbo antropico, ecc. Questi descrittori hanno a

; altre variabili seguono andamenti diversi ma comunque legati alla dimensione longitudinale del sistema, come il rapporto produzione/respirazione, che dalla foce al mare determina una U rovesciata. La polarità monte-valle costituisce una sorta di organizzatore attorno al quale molte variabili covariano in modo relativamente ordinato ed identificabile, determinandosi reciprocamente. Se un modello è in grado di integrare non solo la complessa rete di relazioni tra le diverse variabili, ma anche l’informazione implicita riguardo al loro variare congiunto da monte a valle, la dimensionalità (cioè il numero di fattori indipendenti da considerare) del problema predittivo risulterà notevolmente ridotta e con essa la sua complessità.

15 La complessità dei bacini idrografici, spesso articolati in sottobacini, dà luogo ad un reticolo fluviale

costituito da “aste” che si strutturano in forme dendritiche. Queste sono caratterizzate da alcuni rami privi di affluenti (detti aste di primo ordine) e da altri generati dalla confluenza di due o più rami a monte, che saranno di ordine immediatamente superiore a quello dei rami che in essi confluiscono. Così, ad esempio, la confluenza di due rami del primo ordine dà luogo ad un ramo del secondo ordine e così via. L’ordine massimo viene raggiunto dall’asta fluviale che si getta direttamente in mare (il Po, ad esempio, è di settimo ordine). L’ordine di un tratto fluviale può fornire indirettamente molte informazioni sulle sue caratteristiche ecologiche, mentre l’articolazione dei rami di un reticolo idrografico nei vari ordini che li caratterizzano contribuisce a defnire la complessità del sistema idrografico stesso.

che fare con le altre tre dimensioni del sistema fluviale (Fig. 1)16, che fino ad ora abbiamo considerato solo implicitamente; il fiume infatti non è caratterizzato solo da uno sviluppo longitudinale.

Fig. 1

Attraverso la dimensione trasversale (o laterale) l’acqua corrente entra in contatto con l’ambiente circostante, che viene bagnato e modellato dal fiume e riversa in esso detrito, nutrienti, particolato di vario genere, ostacoli solidi (tronchi,

rocce), inquinamento e artefatti di origine antropica (Fig. 2)17.

Fig. 2

16http://www.provincia.terni.it/caccia/laboratorio/didattica/fiumi.pdf

Le interazioni tra la dimensione longitudinale e trasversale (alveo curvo) determinano inoltre variazioni nei pattern di dinamismo nella corrente.

Poi c’è la dimensione verticale, che a livello della superficie mette in contatto il fiume con l’atmosfera permettendo, ad esempio, l’ossigenazione delle acque; a contatto con l’alveo si osservano invece dinamiche di interramento ed emersione dell’acqua, nonché tutta una serie di fenomeni legati all’attrito, al trasporto solido e alle variazioni di profondità, che hanno importanti conseguenze sullo strutturarsi della corrente e del paesaggio.

Infine è necessario ricordare la dimensione temporale, che con periodo

circannuale dà luogo a variazioni cicliche della portata, della temperatura, ecc.18, ma

che a medio e lungo termine permette lo sviluppo di una profonda azione di modellamento del territorio.

Sulla comunità biologica la direttrice monte-valle esercita un’azione strutturante che ad un livello macroscopico induce il configurarsi di tipologie associate al corso alto, medio o basso dei fiumi. Questo ha dato luogo, ad esempio, a modelli teorici che identificano una “zonazione ecologica” nei corsi d’acqua. Illies e Botosaneanu (1963) fanno corrispondere ad una serie di caratteristiche ambientali tipiche del corso superiore dei fiumi (detto Crenal), del corso medio (Rhithral) e del corso inferiore (Potamal) le relative comunità macrobentoniche (dette, rispettivamente, Crenon, Rhithron e Potamon). Ancora prima, Thieneman e poi Huet (1949) avevano proposto una zonazione basata sui popolamenti ittici (Stoch, 2002), che nella sua versione finale riconosce quattro zone, ognuna caratterizzata da una o

più specie “guida” e da diverse “specie di corteggio” (Fig. 3)19

1) zona a trota, con acque fredde, turbolente e ben ossigenate, substrato eterogeneo (roccia, massi, ciottoli, ghiaia, ecc.) e assenza di vegetazione acquatica; in questa zona la trota fario (Salmo trutta trutta) è tipicamente associata con lo scazzone (Cottus gobio), ma possono essere presenti anche ciprinidi reofili (bene adattati alla corrente) come la sanguinerola (Phoxinus

phoxinus), il vairone (Leuciscus souffia) e il barbo canino (Barbus meridionalis);

:

18 Non è difficile immaginare come l’ampiezza delle oscillazioni di queste variabili possa costituire un

vincolo potente per i sistemi ecologici presenti in un certo contesto fluviale. Vi sono inoltre eventi particolarmente intensi e imprevedibili, come piene o secche di particolare entità, che possono condizionare notevolmente i sistemi ecologici.

2) zona a temolo (detta anche “zona inferiore della trota”), caratterizzata ancora da acque fredde e ben ossigenate, ma da una minore velocità della corrente, substrato di ghiaia omogenea, alghe e poche macrofite; il temolo (Thymallus thymallus) è qui spesso associato alla trota marmorata (Salmo

trutta marmoratus) e a ciprinidi reofili;

3) zona a barbo, in cui la corrente è ancora più lenta e la temperatura più elevata, ma l’ossigenazione dell’acqua ancora buona; la granulometria è più fine (sabbia e ghiaia) e la vegetazione si fa più consistente; insieme al barbo (Barbus plebejus) troviamo la lasca (Chondrostoma genei), il cavedano (Leuciscus cephalus), il gobione (Gobio gobio) e altri ciprinidi;

4) zona ad abramide20

, con acque lente, substrato fangoso e copertura macrofitica importante; qui si trovano, oltre all’abramide (Abramis brama), ciprinidi limnofili (o a deposizione fitofila) come la carpa (Cyprinus

carpio), la scardola (Scardinius erythrophtalmus), il triotto (Rutilus erythrophtalmus), l’alborella (Alburnus alburnus alborella), la tinca (Tinca tinca), il carassio (Carassius auratus) e altre specie come il luccio (Esox lucius).

20 In Italia l’abramide non è autoctono, anche se presente; la specie guida di questa zona diventa

quindi la carpa, anch’essa non autoctona, ma introdotta oramai da molti secoli, probabilmente in epoca romana.

Fig. 3

Le prime due zone possono essere ricondotte ad un’unica “zona a salmonidi”, caratteristica dei torrenti di montagna, mentre le ultime due identificano una “zona a ciprinidi”, tipica delle zone pedemontane, collinari e planiziarie. Ad esse si può

aggiungere una “zona dei pesci eurialini” o “zona della foce”, caratteristica del tratto finale dei fiumi e in cui sono presenti specie che soprattutto per motivi trofici si spostano tra il mare e il fiume (cefali, spigole, passere, ecc.).

L’approccio zonale discretizza l’ecosistema fluviale riconoscendo al suo interno tipologie significative e utili. Tuttavia ignora gli aspetti di continuità presenti nell’andamento di molte variabili che si modificano da monte a valle e non tiene conto di tipologie zonali intermedie e di passaggio, né del fatto che molte specie presentano preferenze specifiche non del tutto sovrapponibili e distribuzioni che travalicano la zona tipica di appartenenza (si pensi ai ciprinidi reofili o ad Anguilla

anguilla, che è possibile trovare tanto nelle zone a ciprinidi reofili, quanto in quelle

a ciprinidi limnofili). Inoltre non rappresenta la connessione funzionale tra zone a monte e a valle e non è facilmente estendibile a contesti (come quello dei corsi d’acqua italiani) diversi da quelli per cui è stato elaborato (fiumi del centro Europa).

Una risposta teorica a questo approccio discreto è il “River Continuum Concept”, un modello che rappresenta l’ecosistema fluviale come una successione di ecosistemi determinata da una modificazione graduale dei fattori morfologici, idrodinamici, fisico-chimici, trofici e delle comunità ad essi associate. Elaborato da Verneaux, Vannote e Cushing tra la fine degli anni ’70 e l’inizio del decennio successivo, questo modello esprime una visione funzionale nelle variazioni della

comunità da monte a valle (Fig. 4)21.

Fig. 4

Ad esempio, essendo i tratti alti dei fiumi caratterizzati da acque povere di nutrienti e da un’ampia copertura vegetale circostante, essi godono di discreti apporti di detrito da terra e di una consistente ombreggiatura; questo favorisce l’instaurarsi di un metabolismo di tipo eterotrofico, con una grande presenza di organismi raccoglitori e frammentatori e una limitata presenza di produttori autotrofi

(che necessiterebbero di luce solare e nutrienti) e pascolatori22

Il concetto di continuum è uno strumento teorico utile per la comprensione globale del funzionamento ecosistemico fluviale, ma la sua capacità di superare l’artificiosità della discretizzazione zonale è basata sull’introduzione di un nuovo elemento artificioso: quello di una gradualità che negli ecosistemi naturali si osserva solo parzialmente. Entrambi i modelli permettono di fare previsioni di massima sulla comunità attesa in un certo sito, ma nessuno di essi rende conto in modo adeguato di quel mosaico che è la struttura ecologica di questi sistemi, in cui macrozone o variazioni continue significative ad una certa scala (quella delle variazioni longitudinali di ampia portata), si fratturano in molteplici microambienti (patch) a scale di maggior dettaglio. In un unico sito può osservarsi un alternarsi di pozze (pools) e rapide (riffles), di aree di fondale con massi grossolani e altre con ghiaia fine o sabbia, di zone ampiamente vegetate e di altre spoglie, tratti rettilinei e anse pronunciate, sponde in erosione e sponde in accumulo. Una buona variabilità ambientale a questo livello di scala, ad esempio, è importante per i pesci, che necessitano, anche come singole specie, di un’ampia tipologia di microambienti per trovare rifugio, nutrirsi, accoppiarsi, deporre le uova, ecc. Se un modello non tiene conto della variabilità ambientale a questo livello di scala, rischia dunque di essere grossolano e poco utilizzabile praticamente, anche se a livelli di minor dettaglio può costituire un buon riferimento di massima a livello sia teorico che pratico.

. Scendendo verso valle queste caratteristiche cambiano gradualmente, con una riduzione dell’ombreggiatura dovuta alla vegetazione e l’apporto da monte di materiale organico relativamente ricco e fine; questo induce una progressiva riduzione dei frammentatori e un aumento di produttori primari e pascolatori, passando ad un metabolismo autotrofico. Avvicinandosi ancora alla foce, l’aumento del particolato organico (prodotto dalle attività dell’ecosistema a monte e trasportato dalla corrente a valle) incrementa la torbidità riducendo nuovamente il rapporto produzione/respirazione e favorisce una preponderante presenza di organismi raccoglitori (metabolismo nuovamente di tipo eterotrofico).

A questi modelli tradizionali vengono oggi affiancati metodi matematici basati soprattutto su modelli di statistica multivariata, che permettono di superare le categorie di zona e di continuum e di tenere conto contemporaneamente di molte

22 A parte i produttori autotrofi, costituiti da microrganismi bentonici, alghe e macrofite acquatiche, le

variabili ambientali e biologiche a varie scale; lo scopo è trovare classificazioni o

ordinamenti efficaci per i siti23

Il metodo di classificazione più rappresentativo è l’analisi dei cluster, che in base ai valori assunti dalle diverse variabili considerate assegna ogni sito ad una “classe”, ad un “tipo”, in modo da garantire la massima somiglianza (omogeneità) tra siti appartenenti allo stesso tipo e la massima differenza (eterogeneità) tra siti appartenenti a tipi diversi. Può essere usato con funzioni predittive, ad esempio analizzando in tempi diversi eventuali scostamenti dal “tipo atteso”, ma non è questa la sua specifica vocazione.

studiati o approssimare relazioni funzionali tra variabili ad un livello appropriato di dettaglio. I metodi di classificazione e ordinamento non generano modelli predittivi, ma piuttosto descrittivi delle strutture presenti nei dati; sono usati soprattutto per “esplorare” le informazioni raccolte, cioè per far emergere somiglianze e differenze tra i siti campionati, che ci aiutino a caratterizzarli e a comprenderne le variazioni.

I metodi di ordinamento24

Considerazioni diverse vanno fatte invece per i metodi di tipo regressivo, come il GLM

fanno una cosa simile, esprimendo però somiglianze e differenze tra i siti non in base all’assegnazione ad una classe, ma attribuendo ad ogni sito un valore su una o più variabili astratte; avendo misurato i valori di n descrittori in ogni sito, l’idea qui è quella di ridurre le dimensioni su cui rappresentare le differenze tra i vari siti ad una, due o, massimo, tre dimensioni astratte, tre fattori in grado di rendere immediatamente conto delle variazioni più significative tra i siti. Riguardo alle potenzialità predittive, vale quanto detto per i metodi di classificazione.

25

23 Un “sito” è un tratto più o meno lungo di corso d’acqua (in genere si tratta di decine o poche

centinaia di metri) nel quale sono stati rilevati i valori di tutti i descrittori abiotici e biotici ritenuti necessari per caratterizzare l’ecosistema.

, che danno luogo a modelli che nascono già con una vocazione predittiva.

24 Tra di essi, l’Analisi delle Componenti Principali (PCA), l’Analisi delle Coordinate Principali (PCoA),

l’Analisi delle Corrispondenze (CA), l’Analisi delle Corrispondenze Canoniche (CCA), il Multidimensional Scaling Non Metrico (NMDS).

25 General Linear Model: è una generalizzazione della regressione lineare multipla ad un modello

multivariato, che tiene conto di più di una variabile dipendente. Il modello matematico alla base di questo metodo può essere facilmente sintetizzato con l’equazione Y=BX+A, in cui Y è una matrice con

s righe, tante quante le variabili dipendenti considerate, ed n colonne, tante quante le osservazioni

condotte; X è una matrice con t righe, tante quante le variabili indipendenti considerate, ed n colonne, tante quante le osservazioni condotte; B è la matrice s x t con i coefficienti di regressione da trovare in base ai dati; A è la matrice sxn, anch’essa da determinare in base ai dati, che rappresenta Y quando la matrice X è la matrice nulla. L’equazione esprime la struttura generale del modello, che postula l’esistenza di relazioni lineari tra le variabili indipendenti e quelle dipendenti e si propone di regolare i parametri (elementi di B e A) in modo da adattare il modello alle caratteristiche delle relazioni lineari tra

Se le variabili indipendenti sono i descrittori ambientali e quelle dipendenti sono, ad esempio, le abbondanze delle varie specie che compongono la comunità, il modello sarà in grado di prevedere la struttura di comunità in base ai descrittori. Nel prossimo paragrafo vedremo che questi metodi hanno comunque dei limiti importanti per le applicazioni in ecologia e che la scelta del “tipo” di modello da utilizzare richiede una serie di riflessioni.

Ma in cosa consiste la “componente biotica” da prevedere? Idealmente sarebbe utile costruire modelli predittivi che a partire dai descrittori ambientali prevedano l’intera comunità! Tuttavia si incontrerebbero problemi sia tecnici che pratici nel realizzare un’impresa simile: la mole e la qualità dei dati che si dovrebbero ricavare da ogni sito sarebbero notevoli e richiederebbero una grande quantità di tempo e risorse; la complessità del sistema da rappresentare sarebbe elevatissima e potrebbe non essere facile regolare opportunamente i parametri del modello (quand’anche se ne avesse già una formulazione generale) per incorporare tale complessità; probabilmente sarebbe difficile anche andare a “leggere” la struttura del modello per ricavare informazioni sull’ecosistema modellizzato; inoltre si perderebbe ogni praticità nella valutazione dello stato ecologico, perché ogni volta, per conoscere la comunità effettiva e confrontarla con quella prevista, si dovrebbe fare un lavoro di campionamento molto impegnativo. Per queste ragioni è opportuno scegliere come target di previsione solo un gruppo limitato di organismi tra tutti quelli presenti, un gruppo la cui struttura costituisca un valido indicatore dello stato dell’ecosistema nel suo complesso.

In letteratura si evidenziano due tendenze generali: concentrarsi su alcune specie particolari (specie vulnerabili, specie indicatrici, specie ombrello, specie bandiera, ecc.) o su gruppi di specie che giocano nell’ecosistema un ruolo abbastanza integrato con il funzionamento generale, da poterne essere considerati indicatori. La classica visione dell’ambiente fluviale come un’organizzazione di sottosistemi depuranti, ad esempio, mette in evidenza l’esistenza di gruppi funzionali interdipendenti che spesso sono stati scelti come target di previsione.

Un primo gruppo funzionale di organismi è quello che costituisce il perifiton, quella pellicola scivolosa che riveste ciottoli e altri substrati duri presenti nei fiumi. Ne fanno parte batteri, funghi, ciliati, microalghe, amebe, rotiferi, nematodi,

le diverse variabili che si possono trarre dai dati. Una volta regolati i parametri (fase di calibrazione), il modello sarà in grado di calcolare (prevedere) i valori delle s variabili dipendenti in funzione dei valori delle t variabili indipendenti, sotto l’ipotesi che le relazioni tra di esse siano di tipo lineare.

gastrotrichi, tardigradi, ecc., ognuno con un proprio ruolo di demolizione, mineralizzazione o riutilizzo della sostanza organica prodotta in acqua o proveniente da terra (foglie, rami e tronchi, escrementi, resti animali, liquami di produzione antropica, ecc.). Come in ogni altro ecosistema, il loro ruolo è cruciale. Data la brevità del loro ciclo vitale e la varietà tassonomico-funzionale che esprimono, la loro risposta ai fattori ambientali può costituire un indicatore flessibile e rapido dello stato ecologico.

Poi ci sono i macroinvertebrati bentonici26

Un terzo gruppo è costituito dai vertebrati, e in particolare dai pesci. Nutrendosi di organismi del macrozoobenthos e di vegetazione acquatica, i pesci contribuiscono anch’essi alla depurazione e al riciclo della sostanza organica, ma hanno la peculiarità di porsi complessivamente, come popolamento

, tra cui troviamo crostacei, molluschi, vermi e larve di vari ordini di insetti. Le specializzazioni alimentari, anatomiche, fisiologiche e comportamentali di questi organismi fanno sì che essi siano presenti in tutte le nicchie disponibili a livello di microhabitat e che rispondano in modo flessibile e specifico a variazioni stagionali o occasionali di diverse variabili. Costituiscono una sorta di sistema di regolazione per il perifiton, sia perché se ne nutrono, mantenendone le popolazioni in stato di elevata attività, sia perché sminuzzano i detriti organici grossolani facilitandone il consumo da parte dei microrganismi.

27

26 Invertebrati di dimensioni non inferiori al millimetro, che passano almeno una parte della vita legati

al substrato.

, a vari livelli nella rete trofica, integrandone una serie di variabili. Attraverso le loro attività biologiche (sosta, rifugio, esplorazione, alimentazione, riproduzione) essi interagiscono in modo molto ricco sia con la componente biologica che con quella fisica dell’ambiente. Le esigenze ambientali legate a ciascuna attività possono differire molto tra una specie e l’altra o tra stadi diversi dello sviluppo di una stessa specie; inoltre, ogni specie richiede la presenza di diversi elementi ambientali per compiere tutte le attività legate alla propria biologia. Dunque, eterogeneità del substrato, sequenze buche-raschi, sinuosità del tracciato e barre di meandro, rive dolcemente digradanti o ripide, ostacoli locali alla corrente (massi, rami incastrati, radici arboree sommerse), vegetazione acquatica rada o consistente, aree di infiltrazione dell’acqua nel sottosuolo e aree di risorgiva, ecc., costituiscono una

27 Si usa il termine “popolamento” come traduzione del termine inglese “assemblage”, che indica un

sottoinsieme di una comunità determinato da un gruppo tassonomico (es. artropodi, diatomee, primati, pesci).

base di variabilità ambientale alla quale il popolamento ittico è complessivamente e specificamente sensibile. Inoltre i pesci sono gli organismi più longevi e mobili in un corso d’acqua per cui le informazioni tratte dalla struttura del popolamento sono molto consistenti a livello sia spaziale che temporale. Infine, il numero totale di specie da considerare (qualche decina) è abbastanza ampio da essere informativo, ma non tanto ampio da divenire ingestibile a livello di monitoraggio o nella costruzione del modello.

L’ultimo gruppo è costituito dall’insieme di organismi, soprattutto vegetali, che popolano l’ambiente circostante al corso d’acqua. Essi producono innanzitutto il detrito che costituisce l’unico apporto energetico almeno nel corso alto dei fiumi. Inoltre la vegetazione svolge una funzione di filtro meccanico e biologico: rallentando le acque di dilavamento e facilitando la sedimentazione del carico solido, impedisce il riempimento degli interstizi tra i ciottoli, microambiente di massima importanza per il perifiton e il macrozoobenthos; favorendo la sedimentazione o il riassorbimento di fosforo e azoto, protegge inoltre il sistema dall’eutrofizzazione. Le fasce riparie possono infine presentare un ricco mosaico ambientale che determina una transizione ecotonale complessa tra ambiente acquatico e zone emerse.

La struttura di ognuno di questi gruppi può costituire un valido indicatore dello stato ecologico del sistema fiume, così come possono farlo, almeno in parte, singole specie chiave; fare una scelta piuttosto che un’altra dipende dalle caratteristiche peculiari che le specie o i gruppi di specie posseggono in relazione agli scopi per cui il modello di previsione viene costruito. In questo lavoro abbiamo scelto di adottare il popolamento ittico a causa della complessità di interazioni che attraverso ogni specie esso esprime nei confronti dell’ambiente fisico e della comunità biologica ad una certa scala, a causa della consistenza spaziale e temporale delle informazioni che da esso si possono trarre e a causa della relativa facilità con cui è possibile catturare

e riconoscere le varie specie (Tancioni et al., 2005)28.

28 Mirando ad un modello in grado di rappresentare lo stato dell’ecosistema in un sito estremamente

localizzato o in risposta a rapidi mutamenti delle condizioni ambientali, si sarebbe probabilmente scelto un gruppo di microrganismi (come le diatomee); mentre se l’interesse si fosse concentrato su scale di maggiore dettaglio (ad esempio, di microhabitat) si sarebbero potuti scegliere i macroinvertebrati bentonici.

1.1.3 Reti neurali e modelli predittivi in ecologia

Creare un modello predittivo di una porzione di comunità in un sistema ecologico non è banale.

Innanzitutto c’è il problema della complessità. In un sistema ecologico c’è: 1) una grande quantità di entità biologiche a vari livelli (individui, specie, popolazioni, comunità) che interagiscono nei modi più diversi; 2) una grande eterogeneità dell’ambiente fisico a varie scale (nel caso dei fiumi, dai microambienti popolati dalla fauna interstiziale, all’articolazione dell’intero bacino idrogeologico); 3) una grande quantità di variabili in gioco (climatiche, fisiche, chimiche, idrogeologiche, etologiche, ecc.); 4) una fitta rete di relazioni tra le varie componenti; 5) confini spesso incerti o sovrapposizioni tra sottosistemi diversi. Questo esclude spesso che si possano formulare modelli analitici per descrivere i rapporti quantitativi tra i descrittori ambientali rilevanti e un popolamento target. Ma anche la formulazione di un modello empirico può rivelarsi macchinosa e improduttiva, perché la regolazione dei parametri in funzione dei dati è comunque subordinata alla possibilità di cogliere a sufficienza il modo in cui interagiscono le diverse variabili in gioco e di riuscire a tradurre questa intricata rete relazionale in un opportuno sistema di equazioni. Come si accennava nel primo paragrafo, un’alternativa è quella di non impegnarsi nella fase di formulazione, ma di adottare un modello generale già formulato e testato; in tal modo si potrebbe passare direttamente alla fase di calibrazione, che attraverso la regolazione dei parametri adatta il modello allo specifico problema predittivo di cui ci si sta occupando. Tuttavia questi modelli generali determinano a priori e in modo univoco la forma delle relazioni tra variabili indipendenti e dipendenti e spesso sono molto limitati nel tenere conto degli effetti di eventuali interazioni tra variabili. I General Linear Models, ad esempio, sono basati su relazioni di tipo lineare, soffrono della presenza di legami tra le variabili indipendenti (es. multicolinearità) e hanno una ridotta capacità di considerare le diverse interazioni tra i regressori nel determinare le variabili dipendenti. Se un sistema è caratterizzato, come nel caso degli ecosistemi, da relazioni di forme eterogenee tra variabili spesso intercorrelate, allora un modello generale è una soluzione insufficiente.

L’altro problema fondamentale è che l’approccio statistico tradizionale, sofisticato e flessibile quando si ha a che fare con dati ottenuti da campionamenti ed esperimenti ben controllati, perde in validità ed attendibilità con dati di natura più eterogenea e meno controllabile, come sono spesso quelli legati alle osservazioni in

ecologia (Fielding, 1999). I metodi statistici, infatti, si basano su una serie di assunzioni che sono necessarie per garantire che le distribuzioni teoriche di probabilità usate come riferimento siano valide. Anche i metodi non parametrici, meno esigenti di altri da questo punto di vista, restano tuttavia legati a modelli di riferimento che richiedono distribuzioni di frequenza di un certo tipo nei dati (ad esempio, distribuzioni unimodali e/o simmetriche), relazioni riconducibili a modelli lineari o di altre forme note, assenza o limitata presenza di valori nulli, indipendenza delle osservazioni, quantità di dati che non vadano al di sotto o al di sopra di una massa critica e che siano stati acquisiti in modo omogeneo e controllato. In ecologia, invece, ci si ritrova spesso ad avere distribuzioni di frequenza multimodali e asimmetriche; relazioni tra variabili molto complesse e soggette ad influenze esterne da parte di altri fattori; presenza di molti valori nulli che non è sempre facile attribuire ad una reale determinazione della variabile misurata o ad assenza di informazione (es. i valori di abbondanza relativi a specie rare); osservazioni non indipendenti a causa di pseudoreplicazione o autocorrelazione spaziale e temporale; squilibrio nella quantità di informazioni disponibili per diverse variabili o grande abbondanza generale di informazione in certi ambiti (si pensi ai dati telerilevati); presenza di dati non sempre omogenei rispetto ai metodi di acquisizione. Anche qui esiste un’alternativa, che tuttavia è da ritenere scorretta nella maggior parte dei casi: ignorare il fatto che i sistemi e i dati con cui si lavora in ecologia presentano caratteristiche formalmente incompatibili con i metodi statistici tradizionali e fidarsi della robustezza di questi ultimi, cioè della loro capacità di fornire analisi e modelli attendibili anche al di fuori delle condizioni di validità fissate dalla teoria in base alla quale sono stati formulati.

Negli ultimi vent’anni, però, alcuni ecologi hanno cominciato ad affrontare il problema in un modo diverso, legando alcuni aspetti numerici e metodologici del loro lavoro a tecniche elaborate nell’ambito dell’intelligenza artificiale.

L’intelligenza artificiale nasce tra gli anni ’40 e gli anni ’50 del Novecento, intercettando i percorsi di riflessione e ricerca provenienti da molte discipline: filosofia, fisiologia, psicologia, biologia, matematica, logica, tra quelle che esistevano già, e informatica, cibernetica, ingegneria dei calcolatori, teoria dell’informazione, tra quelle che si venivano sviluppando in quegli stessi anni. Il 1943, in particolare, fu un anno importante per varie ragioni, tra cui un fondamentale articolo di McCulloch e Pitts in cui veniva teorizzato per la prima volta il neurone

artificiale29

In Fig. 5 è mostrato un modello un po’ più sofisticato di quello originario di McCulloch e Pitts, ma l’essenza è la stessa: il neurone artificiale è una funzione

matematica del tipo 𝑦𝑦(𝑥𝑥̅, 𝑤𝑤�), che ha per variabili indipendenti il vettore 𝑥𝑥̅, con i

segnali provenienti dall’esterno del neurone, e il vettore 𝑤𝑤�, con i pesi sinaptici delle

connessioni che portano i segnali al neurone; la variabile dipendente, cioè l’output

del neurone, è lo stato di attivazione 𝑦𝑦 di quest’ultimo, che può costituire l’output

definitivo desiderato oppure essere usato a sua volta come segnale di ingresso per altri neuroni.

. Warren Sturgis McCulloch era uno studioso di psicologia e neurofisiologia, mentre Walter Pitts era un logico che lavorava nell’ambito della psicologia cognitiva; essi si chiesero come le funzioni base del pensiero potevano essere determinate dall’attività nervosa. Lo sviluppo di un modello artificiale estremamente semplificato di cellula nervosa permise loro, tra l’altro, di dimostrare che già un’unica unità di elaborazione elementare era in grado di risolvere semplici problemi di logica, ricevendo come input alcune informazioni (premesse) e fornendo come output la soluzione del problema (conclusioni).

29 La storia dell’intelligenza artificiale non si riduce a quella delle reti neurali, ma qui si farà riferimento

soprattutto a quest’ultima, in modo da introdurre progressivamente tutti i concetti necessari alla comprensione degli aspetti tecnici dello studio presentato in questa tesi.

Fig. 5

La funzione 𝑦𝑦(𝑥𝑥̅, 𝑤𝑤�) risulta dalla composizione di due diverse funzioni.

Innanzitutto una funzione 𝑝𝑝𝑎𝑎 che calcola il potenziale di attivazione del neurone

combinando i segnali in ingresso e usando i pesi sinaptici per decidere l’effetto che il segnale trasmesso tramite una particolare connessione avrà nel determinare l’attivazione finale del neurone; quest’ultima operazione in genere viene compiuta calcolando il prodotto scalare (detto anche prodotto interno) tra il vettore dei segnali

e quello dei pesi, cioè moltiplicando il generico segnale xi (che varia tra 0 e 1) con il

peso della connessione relativa wi (che varia tra -1 e 1). Se il peso wi della i-esima

connessione è elevato, allora gran parte di xi passerà alla funzione di attivazione e

contribuirà all’attivazione finale del neurone; se invece wi è vicino o uguale a zero,

poco o nulla di xi passerà; se wi è negativo, avremo una connessione inibitoria e il

valore di xi contribuirà a diminuire l’attivazione del neurone artificiale. Tra le

possibili funzioni per combinare i segnali in ingresso, la funzione 𝑝𝑝𝑎𝑎 riportata in

figura, che determina una combinazione lineare degli input, è quella più usata per

calcolare il potenziale di attivazione30

30 Le unità neurali di tipo RBF (Radial Basis Funtion) o quelle di tipo Sigma-Pi costituiscono esempi di

neuroni artificiali che fanno uso di una diversa funzione di combinazione per il calcolo del potenziale di