3

INDICE

Introduzione

4

CAPITOLO 1

La logica di condivisione della conoscenza 1.1 La cultura partecipativa 71.2 Un nuovo modello di comunicazione scientifica: l'open access 14

1.3 Il free/open software 26 1.4 L'open content 36

CAPITOLO 2

Wikipedia 2.1 Origini 42 2.2 Funzionamento 49 2.3 Comunità 54 2.4 Attendibilità 58CAPITOLO 3

Un caso di studio: le biografie su Wikipedia 3.1 Le biografie di persone viventi su Wikipedia 653.2 Le biografie dei parlamentari italiani su Wikipedia 3.2.1 Metodologia 71

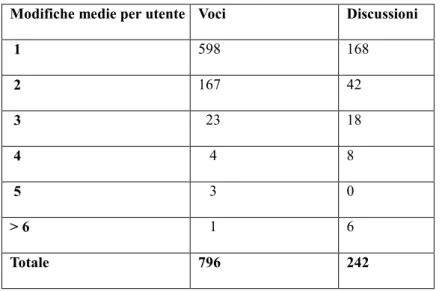

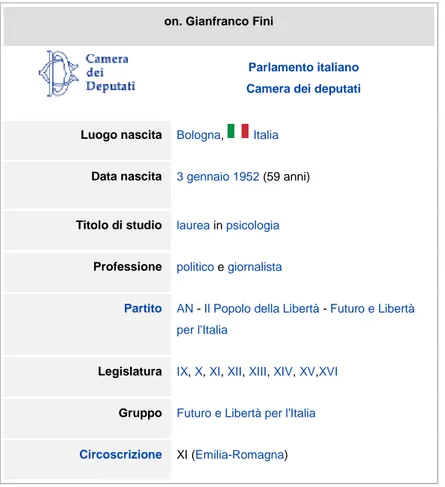

3.2.2 Parlamentari italiani su Wikipedia 72

Riflessioni conclusive 98

4

INTRODUZIONE

La diffusione delle nuove tecnologie informatiche avvenuta negli ultimi decenni ha portato alla nascita di forme di comunicazione impensabili precedentemente e alla realizzazione di nuove comunità “virtuali”. Le relazioni tra real life e web life sono diventate talmente strette da rendere a volte quasi inscindibile l'una rispetto all'altra.

In una società sempre più frammentata, influenzata costantemente da una logica economica basata sul profitto, nascono nuove forme di comunità, intese nell'accezione classica di cum munus, condivisione di un dono. Queste nuove forme di comunità non sorgono attorno ad ambienti geografici bensì ad ambienti virtuali, nati grazie alle nuove tecnologie dell'informazione, che hanno abbattuto i confini fisici permettendo a chiunque, in qualsiasi parte del mondo, di comunicare, condividere, produrre conoscenza e distribuirla.

La prima parte della presente tesi tratta appunto, della nascita di una forma di creazione della conoscenza che cerca di oltrepassare non solo i confini fisici, ma anche quelli imposti dalla logica che soggiace al “denaro”. La conoscenza viene prodotta tra pari; la cultura diventa più trasparente e malleabile: gli individui partecipano attivamente ai cambiamenti culturali e alla ricerca di significato. Questa partecipazione degli individui porta a una maggiore libertà di intervenire e modificare le creazioni culturali degli altri e alla democratizzazione della cultura che diventa autoriflessiva e partecipativa.

I tre strumenti principali attraverso cui si configura la nuova forma di produzione della conoscenza sono l'Open Access, l'Open Source e l'Open Content. L'aggettivo

Open, aperto, insieme a quello Free, libero, indicano l'essenza della rivoluzione a cui si

sta assistendo negli ultimi anni.

La conoscenza e la sua creazione, per la prima volta nella storia, diventano libere e aperte. Tutti coloro dotati di un computer e di un accesso alla Rete, possono, non solo fruire della conoscenza, ma contribuire a essa. Secondo Franco Carlini, nell'introduzione all'edizione italiana dell'opera di Benkler “La ricchezza della rete”:

‹‹i cittadini della rete considerano di nuovo ovvio quanto peraltro era ovvio nei secoli passati, e cioè che la conoscenza nuova si costruisce a partire da quella che c'è, copiando, incollando e migliorando (Carlini in Benkler, 2007, p. XI)››.

5 Attraverso l'Open Access, gli utenti della Rete possono avere accesso alle nuove scoperte scientifiche, e i ricercatori possono pubblicare le loro opere gratuitamente. L'Open Source invece riguarda quel software i cui autori ne permettono il libero studio e l'apporto di modifiche, così da mantenere un'alta qualità del prodotto. L' Open Content si riferisce ai contenuti aperti, siano essi musicali, letterari, cinematografici. Tutti questi strumenti hanno alla base il principio secondo cui la conoscenza, sia essa scientifica, tecnica o tecnologica, debba essere intesa come bene comune, cioè appartenente all'intera comunità, e per questo non rivale e non esauribile. A differenza dei beni fisici che sono rivali ed esauribili, l'utilizzo dei beni comuni non implica la rinuncia degli stessi da parte di altri individui.

Per dare vita a questa nuova forma di partecipazione e produzione della conoscenza, gli individui sviluppano nuove abilità collettive scaturite dalla collaborazione. Tra queste abilità è fondamentale quella dell'intelligenza collettiva, teorizzata da Pierre Lévy. L'intelligenza collettiva fa sì che i contributi intellettuali di una moltitudine di individui diversi tra loro, possa dar vita a una conoscenza intesa come bene comune.

L’intelligenza collettiva, la libertà dei contenuti, l’apertura nei confronti di chiunque sia dotato di una connessione alla Rete e di un computer, sono tutti elementi costitutivi di Wikipedia, l’oggetto di studio della presente tesi. Wikipedia, la più grande enciclopedia online mai esistita, nasce nel 2001 dal genio di Jimmy Wales. I suoi principi sono molto semplici e si basano fondamentalmente sulla totale apertura e libertà dei contenuti. Chiunque può creare e modificare le voci, purchè vengano rispettati il punto di vista oggettivo e la neutralità, elementi necessari per un’enciclopedia. All’interno di Wikipedia esiste un sistema di controllo costante delle voci, così che qualsiasi violazione delle norme venga corretta, ma tali forme di controllo si trovano nelle mani di tutti gli utenti, nonostante sia presente una gerarchia. Non mancano le critiche all’Enciclopedia, ma è comunque fuori da ogni dubbio l’importanza che essa riveste nella produzione di conoscenza tra pari. Wikipedia racchiude in sé la libertà di contenuti, la libertà di intervento nella produzione delle voci e la nascita di una comunità che si fa portatrice dei principi su cui essa si basa.

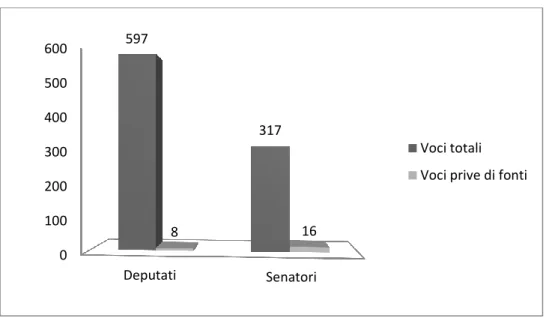

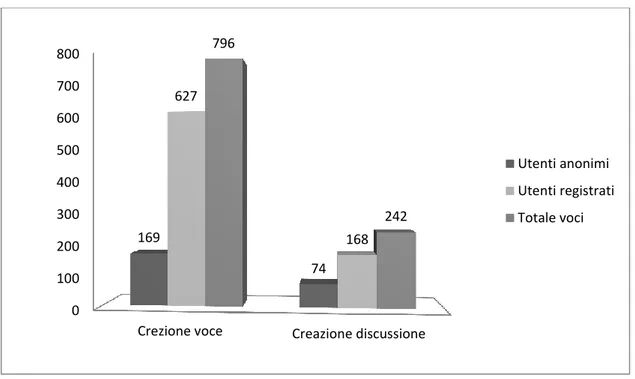

6 analizzato i problemi derivanti dall’attendibilità dei contenuti, verrà analizzata la presenza delle biografie dei 951 parlamentari italiani della XVI Legislatura su Wikipedia. Lo scopo della ricerca è quello di osservare come gli utenti di Wikipedia collaborino tra loro nella creazione delle voci riguardanti la classe politica che li governa, e il loro sforzo nel cercare di creare voci che siano complete e neutrali, nonostante spesso, l’oggetto delle voci possa essere controverso. Sono state analizzate le discussioni, la sezione di Wikipedia in cui forse maggiormente sono presenti le forme di confronto e spesso scontro tra gli utenti, dal momento che le discussioni prescindono dall’enciclopedicità richiesta per le voci. È stata data particolare attenzione ai modi attraverso cui la comunità di Wikipedia agisce in maniera collaborativa, a dimostrazione del fatto che l’intelligenza collettiva basata sulla condivisione e sulla partecipazione degli utenti, possa dar vita ad un Enciclopedia online contenente voci neutrali ed enciclopediche.

7

CAPITOLO 1

La logica di condivisione della conoscenza

1.1 La cultura partecipativa

La crescente semplificazione nell’accesso alle tecnologie informatiche che si sta verificando negli ultimi anni, dovuta alla rapida diffusione della banda larga e dei personal computer e al relativo calo dei costi, ha permesso potenzialmente a chiunque di collaborare per creare valore, conoscenza e innovazione. Gli individui diventano sempre più critici e partecipi delle culture in cui vivono rendendo la cultura più democratica, autoriflessiva e partecipativa.

Lo spettatore non è più passivo e il consumo si trasforma in un processo collettivo e aperto (Jenkins, 2007, p.XXVI). I consumatori si stanno trasformando in utenti, stanno

diventando più attivi e produttivi dei consumatori dell'età dell'informazione industriale (Benkler, 2006, p. 2). Le informazioni vengono manipolate e rappresentate in modi nuovi e potenti tramite l'ausilio dei nuovi media, le capacità cognitive vengono ampliate grazie a nuove forme di simulazione che permettono di trattare maggiori quantità di informazione, di sperimentare configurazioni più complesse di dati e di formulare rapidamente ipotesi e metterle alla prova in tempo reale rispetto a diverse variabili (Jenkins, 2010, p. 105).

Questa nuova forma di libertà informazionale, impensabile durante il periodo dell'economia dell'informazione industriale tipica del XX secolo, secondo Benkler (2006) porta con sé grandi promesse: può essere considerata fattore di ampliamento della libertà individuale, piattaforma per una democrazia più partecipata, strumento per la crescita di una cultura più critica e autoriflessiva, infine meccanismo di sviluppo umano in qualsiasi parte del mondo, essendo l'economia globale sempre più dipendente dall'informazione.

Cambiano le condizioni di produzione e diffusione della conoscenza e nascono nuove forme di socializzazione e di comunità: la Rete digitale si presenta come un'estensione delle relazioni sociali con una potenzialità elaborativa mai conosciuta prima nella storia dell'umanità (Cortiana in Hess, Ostrom, 2009 p. XIII ), gli individui

8 informazione, possono associarsi liberamente con gli altri senza dipendere dai tradizionali modelli gerarchici tipici delle organizzazioni sociali ed economiche, infine possono organizzarsi in organizzazioni formali che operano al di fuori della sfera del mercato:

‹‹le persone stanno usando la recente espansione della propria libertà effettiva, per agire e cooperare con gli altri in forme che migliorano l'esperienza pratica della democrazia, della giustizia e dello sviluppo, nonché della cultura critica e della vita in comunità›› (Benkler, 2006, p. 11).

Il protagonista principale di questa rivoluzione è Internet, e a questo proposito Elionor Ostrom e Charlotte Hess (2009, p. 51) descrivono le caratteristiche della trasformazione in atto:

‹‹ 1. sempre più spesso l'informazione- anche quella culturale e scientifica “standard”- nasce in formato digitale;

2. sempre più spesso l'informazione digitale è distribuita attraverso Internet; 3. si sono potenziati enormemente i motori di ricerca e database, oltre ai word processor, html e altro software;

4. esiste la possibilità di scambio sincrono di informazioni;

5. l'accesso all'informazione digitale avviene attraverso i personal computer››.

Questa nuova modalità di innovazione e creazione del valore diffusa tramite Internet viene chiamata peer production, termine coniato da Yochai Benkler, che letteralmente significa produzione tra pari e si riferisce a un fenomeno di cooperazione su larga scala dedicato a un determinato progetto e agevolato dal calo dei prezzi dell’accesso alle nuove tecnologie.

La peer production rappresenta un modello alternativo di organizzazione rispetto a quello proprio del mercato e delle aziende, per questo viene anche chiamata produzione orizzontale, proprio perché i “produttori orizzontali” organizzano le loro attività tramite motivazioni sociali e comunicative, non perchè qualcuno ha offerto loro un compenso. La modalità di organizzare la produzione è radicalmente decentrata, collaborativa e non proprietaria, basata sulla condivisione delle risorse e degli output tra individui lontani nello spazio ma connessi alla Rete che cooperano senza dipendere dal mercato né dagli ordini di qualche superiore.

9 possibile l'emergere della produzione dell'informazione che non è necessariamente basata sulla logica di mercato o su diritti proprietari esclusivi: primo fra tutti il fatto che il macchinario fisico per produrre informazione e cultura, il computer e la connessione alla Rete, è distribuito universalmente tra la popolazione delle economie avanzate. Secondo, le materie prime dell'economia dell'informazione, cultura e conoscenza esistenti, sono beni pubblici, a differenza di quelle dell'economia industriale ed hanno un costo marginale reale pari a zero. Terzo, i modelli organizzativi e le dinamiche sociali di scambio e produzione di informazione su Internet si sono sviluppati in modo da risolvere problemi in forma altamente modulare, così che le persone possano agire per diverse ragioni a creare nuova informazione, conoscenza e beni culturali.

La peer production può assumere diverse forme: può diventare un sistema per la costruzione collaborativa della conoscenza in cui individui e gruppi generano sapere sociale all'interno della galassia dei siti di social networking del Web 2.0, diffondendo al di fuori dei circuiti tradizionali conoscenza e relazioni comunitarie di nuovo tipo, ad esempio Wikipedia; può portare al miglioramento del software e delle piattaforme digitali, come nel caso di Linux; può creare un'alternativa ai media tradizionali, come nell'esempio di Current TV, il programma nato negli Stati Uniti nel 2005 trasmesso via cavo e creato quasi interamente da collaboratori dilettanti e i servizi che vanno in onda sono determinati dalle votazioni degli spettatori (Tapscott, Williams, 2008, p. 36); oppure può essere utilizzata dalle imprese per attingere nuove idee, come nel caso della Procter & Gamble, e migliaia di altre imprese che si rivolgono a piattaforme online, per trovare idee, invenzioni ed esperti altamente qualificati che consentano loro di estrarre nuovo valore dai mercati in cui operano (Tapscott, Williams, 2008, p. 35).

E' importante sottolineare il fatto che la produzione tra pari, non si basi tanto sull'inter-attività1, che è una proprietà della tecnologia, quanto piuttosto sulla

partecipazione, che è invece proprietà della cultura (Jenkins, 2010, p. 69), inoltre il prodotto della collaborazione orizzontale in Rete non diventa mai una proprietà esclusiva, bensì viene sottoposto all'etica della condivisione, aperta a tutti coloro che vogliono costruire sopra qualcosa che a sua volta verrà condiviso.

Jenkins (2010, p. 67) descrive il profilarsi di una cultura partecipativa che è una cultura con:

1L' interattività è la caratteristica di un sistema il cui comportamento non è fisso ma varia al variare

10 • ‹‹barriere relativamente basse per l'espressione artistica e l'impegno civico;

• un forte sostegno per la creazione di materiali e la condivisione di creazioni con altri; • una qualche forma di tutoraggio informale attraverso cui i partecipanti più esperti condividono conoscenza con i principianti;

• individui convinti che contribuire sia importante, e

• individui che sentono un qualche tipo di legame sociale che li connette gli uni con gli altri (perlomeno sono interessati a ciò che le altre persone pensano di quello che hanno creato)››.

La cultura partecipativa richiede la nascita di nuove competenze da parte degli individui che scaturiscono dal coinvolgimento nella comunità e implicano abilità sociali sviluppate attraverso la collaborazione e il networking e non semplicemente abilità individualizzate da utilizzare per l'espressione personale (Jenkins, 2010). Tra queste abilità, è fondamentale quella dell'“intelligenza collettiva” espressione che Jenkins riprende dall'opera di Pierre Lévy “L'intelligenza collettiva” (1994) per indicare

‹‹la capacità delle comunità virtuali di far leva sulla competenza combinata dei loro membri. Quel che non possiamo sapere o fare da soli, possiamo essere in grado di fare collettivamente. […] Emergono nuove forme di comunità, che si definiscono attraverso affiliazioni volontarie, temporanee e tattiche, rinsaldate da intraprese intellettuali comuni e da comuni investimenti emotivi. […] Questi gruppi mettono a disposizione dell'intellettuale collettivo l'insieme delle conoscenze esistenti e pertinenti per lui in un dato momento; cosa ancora più importante rappresentano luoghi fondamentali di discussione, negoziazione ed elaborazione collettiva e spronano i singoli a reperire nuove informazioni per il bene comune: le domande, gli interrogativi senza risposta mettono in tensione segnalano le zone che richiedono invenzione, innovazione›› (Jenkins, 2007, p. 4).

Secondo Lévy l'intellettuale collettivo ‹‹è una sorta di società anonima alla quale ogni azionista contribuisce con il capitale delle proprie conoscenze, delle proprie navigazioni, della propria capacità di imparare e di insegnare. Il collettivo intelligente non sottomette né limita le intelligenze individuali, al contrario le esalta, le fa fruttare e apre loro nuove possibilità›› (Lévy, 1994, p. 113).

Le condizioni necessarie per ricevere il massimo beneficio dall'intelligenza collettiva sono, secondo Suroweicki (2004, cit. Jenkins, 2010, p. 163):

‹‹Ha bisogno di essere diversa al proprio interno, in modo che le persone portino sul tavolo elementi informativi variegati. Ha bisogno di essere decentralizzata, in modo che nessuno dall'alto detti la risposta della folla. Ha bisogno di un modo per sintetizzare le opinioni dei cittadini in un unico giudizio collettivo. E le persone che fanno parte della folla devono essere indipendenti, così che possano prestare attenzione soprattutto alle informazioni senza preoccuparsi di ciò che pensano le persone intorno a loro››.

11 È esattamente ciò che accade nel momento in cui un utente della Rete inserisce o modifica una voce di Wikipedia; inserisce una foto su Flickr; condivide la propria musica su piattaforme peer to peer di condivisione di file; o quando gruppi di fan, formatisi attorno a trasmissioni televisive, libri o film creano e diffondono sul Web parodie, storie incentrate sui personaggi, e giochi di ruolo online.

La collaborazione in rete permette dunque il diffondersi capillare della conoscenza, e le motivazioni che spingono chi partecipa a questa diffusione sono molteplici: dalla semplice passione personale, alla ricerca di visibilità, fino ad arrivare agli introiti economici.

Il ruolo attivo dei fruitori della rete è una delle conseguenze del fenomeno che viene chiamato Web 2.0. Per Web 2.0 si intende l'insieme delle modalità di approccio a Internet caratterizzate da facilità di accesso e di utilizzo e, soprattutto, dalla possibilità di interagire con i siti intervenendo sui dati in essi contenuti: l'informazione diventa così una realtà dinamica, e la rete un ruolo in cui l'interazione sociale si realizza grazie all'evoluzione della tecnologia. Non si tratta tuttavia solo di nuovi software o di prodotti tecnologicamente più avanzati, ma di un cambiamento strutturale, che si concretizza in nuove modalità di fruizione, basate sulla reale condivisione dei dati. Scrive Wikipedia:

‹‹Da un punto di vista strettamente tecnologico, il Web 2.0 è del tutto equivalente al Web 1.0, in quanto l'infrastruttura di rete continua ad essere costituita da TCP/IP e HTTP e il meccanismo ipertestuale è ancora il concetto base delle relazioni tra i contenuti. La differenza, più che altro, risiede nell'approccio con il quale gli utenti si rivolgono al web, che passa fondamentalmente dalla semplice consultazione (seppure supportata da efficienti strumenti di ricerca, selezione e aggregazione) alla possibilità di contribuire, popolando e alimentando il Web con i propri contenuti ››2.

Nel Web 2.0 i contenuti digitali sono rimodellabili e non si configurano mai per loro natura come definitivi, conservano la plasmabilità che consente ad altri utenti di appropriarsene, apportarvi modifiche e rimetterli in circolo.

Nella realtà attuale assistiamo, secondo Paccagnella, (2010) al profilarsi di due modelli di gestione della conoscenza: un modello “aperto” e uno “chiuso”, rifacendosi all'opera di Himanen che contrappone la gestione della conoscenza dell'accademia a

12 quella del monastero (Himanen, 2001, cit. in Paccagnella, 2010, p. 114):

‹‹nel monastero medievale la conoscenza è gestita secondo logiche chiuse: il sapere è qualcosa di esoterico, riservato a pochi, da non diffondere presso chi non è destinato a riceverlo. Le grandi biblioteche benedettine sono luoghi polverosi e inaccessibili; il libero confronto intellettuale e l'accumulazione della conoscenza sono difficoltosi, guardati con sospetto e procedono con estrema lentezza. […] Al contrario, il modello dell'accademia platonica si propone come luogo aperto in cui la circolazione della conoscenza è sostenuta attraverso logiche inclusive. Trasparenza, riproducibilità dei risultati e accessibilità sono le caratteristiche che preludono alla nascita della scienza moderna e alla sua differenziazione da altri domini della conoscenza come la religione, la magia o l'alchimia››.

Non mancano le critiche nei confronti dei nuovi modelli di produzione e diffusione della conoscenza: la prima critica è che il contenuto online prodotto dagli utenti non possa mantenere un alto livello di qualità, ordine, veridicità e originalità, ‹‹è più probabile che dalla folla scaturisca ignoranza che saggezza›› (Tapscott, Williams, 2008, p. 458), è la cosiddetta “obiezione di Babele” (Benkler, 2006, p. 13), secondo cui quando a tutti viene data la possibilità di esprimersi non si riesce a sentire più nessuno provocando una cacofonia da cui ci si può liberare solamente affidandosi al denaro come fattore che permette di distinguere ciò che viene ascoltato e ciò che rimane nell'oscurità.

In realtà, come spiega Benkler (2006, p. 15), stanno emergendo fonti alternative che permettono di testare l'affidabilità delle informazioni, come ad esempio filtri utilizzati nella Rete o pratiche di peer review per selezionare e verificare l'attendibilità delle informazioni prodotte in ambito orizzontale, essendo l'attendibilità e la rilevanza considerate esse stesse beni informazionali L'ordine è garantito dal fatto che i siti si raggruppano attorno a comunità di interesse in modo da permettere alle persone di orientarsi nel migliore dei modi tra l'infinità di siti proposti dalla Rete: le persone non seguono il gregge bensì, a seconda dei loro interessi opteranno per una serie di siti suggeriti dagli altri utenti.

La Rete è basata sull'approccio “verifica tu stesso” (Benkler, 2006, p. 277) attraverso cui gli utenti danno fiducia a un'osservazione in base alla reputazione dell'autore, alle fonti che cita e alla loro verificabilità, e alla consapevolezza che per ogni affermazione o fonte citata ci sono persone che possono esprimere il loro disaccordo. Benkler (2006, p. 95) riporta tre esempi significativi di rilevanza e attendibilità delle informazioni in un modello di produzione orizzontale, nonché di

13 facilità offerta agli utenti di trovare efficacemente le informazioni che cercano nel web: Amazon, Google e Slashdot.

Amazon ricava giudizi di rilevanza e attendibilità dall'azione di molti individui che acquistano prodotti dal sito tramite il semplice avviso “I clienti che hanno comprato gli articoli da Lei visti, hanno comprato anche questo”. Permette anche di creare liste bibliografiche per argomento e di seguire gli altri utenti classificati come “amici e preferiti”, infine offre agli utenti la possibilità di votare i libri che comprano generando delle classifiche.

Google invece utilizza giudizi di rilevanza peer-based: il motore di ricerca considera voti di fiducia i link che puntano a un sito a partire da altri siti web, ciò significa che ogni volta che l'autore di una pagina web linka la pagina di qualcun altro, dichiara esplicitamente che la pagina in questione merita di essere visitata. Il conteggio dei link porta a un voto sulla qualità della pagina e i voti espressi dalle pagine più linkate pesano di più.

Slashdot è una newsletter web sulla tecnologia costruita principalmente da utenti che scrivono e commentano articoli che riguardano diverse aree della tecnologia. La rilevanza e l'attendibilità degli articoli è data dai commenti degli utenti ed è un perfetto esempio di come la produzione orizzontale sia utilizzata per produrre accreditamento e attendibilità delle informazioni, aggregando un gran numero di brevi giudizi che richiede agli utenti un lavoro minimo ma fondamentale per la rilevanza della qualità degli articoli.

La seconda critica è che i nuovi modelli di conoscenza “aperta” starebbero impedendo di proteggere, da una parte i diritti di proprietà intellettuale, e dall'altra la capacità di produrre ricchezza nell'ambito di un'economia basata sulle conoscenze. Anche in questo caso la realtà dei fatti è ben diversa da ciò che sostengono i critici della produzione orizzontale e della libera diffusione dell'informazione. I modelli aperti di produzione e diffusione dell'informazione sono dotati di particolari licenze che, come verrà descritto in seguito, riescono a conciliare la libera diffusione della conoscenza con la tutela della proprietà intellettuale.

In generale, ad ogni modo va ricordato che aumentare le restrizioni per tutelare il diritto di proprietà intellettuale porta all'arresto della produzione di conoscenza futura, scrive Benkler (2006, p. 48):

14 ‹‹ Per scrivere un articolo scientifico o una notizia oggi, devo avere accesso agli articoli e alle notizie di ieri. Per scrivere un romanzo, un film o una canzone, devo usare e rielaborare le forme culturali esistenti, come le trame e gli intrecci di altri romanzi. Questa caratteristica è nota agli economisti come l'effetto “sulle spalle dei giganti”››.

Per quanto riguarda l'argomentazione secondo cui i modelli di conoscenza aperta impediscano la creazione di ricchezza, Benkler (2006, p. 59) cita l'esempio dell'IBM, il colosso mondiale nel settore informatico, che ha visto raddoppiare il proprio fatturato utilizzando servizi di free software rispetto alle entrate derivanti da brevetti o altre forme di proprietà intellettuale.

Di seguito verranno descritti i tre modelli “aperti”, i quali, basati sulla collaborazione di massa, stanno rivoluzionando il mondo della cultura, della scienza, dell'economia e della politica: l'Open Access, l'Open Source e l'Open Content.

1.2 Un nuovo modello di comunicazione scientifica: l’open access

Come si è detto precedentemente, ci troviamo in un'epoca in cui la produzione e diffusione della conoscenza sono aperte a chiunque abbia accesso a una Rete Internet.

In realtà, spesso le stesse tecnologie che permettono di avere un accesso illimitato alle risorse condivise allo stesso tempo “le recintano” (Kranich in Hess, Ostrom, 2009), attraverso restrizioni o filtri (ad esempio le leggi sul copyright o i vincoli legali sul codice informatico) imposti dai governi o dalle grandi aziende, i quali si trovano ad essere in competizione tra loro per il predominio del fiorente mercato delle idee e della conoscenza.

Il dibattito sulla libera diffusione e fruizione delle informazioni ruota attorno al concetto di “bene comune della conoscenza”. I beni comuni (commons) vengono definiti dalla tradizione giuridica anglosassone

‹‹quei beni che sono proprietà di una comunità e dei quali la comunità può disporre liberamente; si tratta cioè di beni che appartengono allo stesso gruppo di individui e di cui i membri possono liberamente disporre, […] tutti quei beni materiali e immateriali (l'ambiente, le foreste, il mare, le infrastrutture e i servizi di pubblica utilità, la fiducia sociale, la solidarietà, la sicurezza), che costituiscono un patrimonio collettivo di una comunità e il cui sfruttamento deve essere regolato›› (Ferri in Hess, Ostrom, 2009, p. XXIII).

15 Il problema dei beni comuni tradizionali, cioè fisici, è che essi sono esauribili e rivali: esauribili nel senso che le risorse del mare o della foresta, nel momento in cui vengono sfruttate, tenderanno ad esaurirsi, essendo limitate; rivali dal momento che l'utilizzo delle risorse da parte di una persona riduce i benefici disponibili per gli altri, da cui scaturirebbe la “tragedia dei beni comuni” di cui parla Hardin (1968, cit. in Ferri in Hess, Ostrom, 2009 p. XXIII):

‹‹Se posso portare le mie bestie al pascolo sul prato comune, rispetto alla mia utilità individuale è per me razionale cercare di sfruttarlo il più possibile, perchè è gratis; ma in questo modo esaurisco il pascolo stesso, a danno di tutti gli altri. A chi viaggia piace trovare la strada libera; ma se tutti la usano contemporaneamente perchè è gratis, viaggiare diventa impossibile. Ecco la tragedia dei commons: i beni comuni, in quanto vengono usati in comune, tendono a venir sfruttati fino all'esaurimento. Tendono, cioè, se rimangono comuni, a cessare di essere beni››.

Secondo Charlotte Hess e Elinor Ostrom (2009) anche la conoscenza, intesa come ‹‹tutte le forme di sapere conseguito attraverso l'esperienza o lo studio, sia esso espresso in forma di cultura locale, scientifica, erudita o in qualsiasi altra›› (2009, p.10), può essere considerata un bene comune non esauribile e non rivale dal momento che ‹‹una volta compiuta una scoperta, è difficile impedire ad altre persone di venirne a conoscenza. L'utilizzo della conoscenza da parte di una persona non sottrae nulla alla capacità di fruizione da parte di un'altra›› (2009, p. 11).

La scienza è dunque un commons che sfugge alla tragedia dei beni comuni: ‹‹Una teoria scientifica è un commons non competitivo, perchè chiunque può apprenderla senza che nessun altro sia depauperato nel suo patrimonio di conoscenze. Una strada o un pascolo sono commons competitivi, perchè un loro uso incontrollato li deteriora e li impoverisce. Non bisogna fare l'errore di confondere i pascoli di erba con i pascoli delle idee: le idee, a differenza dell'erba, crescono se vengono condivise, e il loro valore aumenta, perchè la condivisione dà loro la possibilità di svilupparsi e di migliorarsi›› (Pievatolo, 2004, cit. in Di Donato, 2009, p.99).

Nonostante la non esauribilità e non rivalità dei beni comuni della conoscenza, paradossalmente, con l'avvento delle nuove tecnologie digitali sono aumentate le restrizioni, nel momento in cui, a partire dagli anni '90 le pubblicazioni governative sono diventate un business e le informazioni inaccessibili, mentre in ambito accademico le fusioni tra gli editori di riviste scientifiche avevano lasciato il mercato nelle mani di

16 pochi gruppi internazionali (Kranich in Hess, Ostrom, 2009, p. 84).

Gli effetti diretti di queste “recinzioni” furono in primo luogo l'aumento dei prezzi degli abbonamenti delle riviste che arrivarono a costare anche 20000 dollari generando profitti oltre il 40% e costringendo le biblioteche a disdire gli abbonamenti o a risparmiare sull'acquisto dei libri; d'altra parte, gli editori e gli aggregatori di informazioni richiesero a consumatori e biblioteche di firmare accordi restrittivi di licenza per poter acquisire o usare materiali digitali, sia protetti da copyright sia di pubblico dominio. Il controllo sul flusso delle informazioni venne così centralizzato facendo sì che l'utente perdesse i diritti di uso legittimo relativi alla visione, riproduzione e citazione di materiali tutelati da copyright, e le biblioteche successivamente all'interruzione degli abbonamenti, furono costrette a restituire tutto il materiale, dal momento che molti abbonamenti venivano concessi in uso e non venduti per possesso (Kranich in Hess, Ostrom, 2009, p. 87).

Kranich (2009, p. 89) elenca tra le misure di restrizione tecnologica negli Stati Uniti il Digital rights management, un insieme di software di codifica e criptaggio di files, sia audio che video che impediscono agli utenti di copiare i dati; il Digital

Millennium Copyright Act (1998) che impone sanzioni penali a chi elude la crittografia;

il Broadcast Flag (2003) che impedisce la copia dei programmi nella TV digitale. Successivamente all'11 settembre le restrizioni si inasprirono ulteriormente fino ad arrivare ad accordi tra i funzionari e gli editori di riviste con peer-review per promuovere la rimozione volontaria di articoli e il rifiuto di inserire contenuti che avrebbero potuto compromettere la sicurezza nazionale.

Di fronte a queste restrizioni nella diffusione della conoscenza i bibliotecari e i membri del mondo accademico cercano di garantire l'accesso a risorse essenziali per la ricerca seguendo il principio secondo cui:

‹‹i beni comuni della conoscenza permettono ai ricercatori di rivendicare le proprie risorse intellettuali e svolgere ruoli cruciali: il progresso della conoscenza, l'innovazione e la creatività attraverso la partecipazione democratica nella creazione libera e aperta e nello scambio di idee. Considerare la conoscenza come bene comune offre la possibilità non solo di contrastare le sfide all'accesso poste dai processi di recinzione, ma anche di costruire un'istituzione fondamentale per la democrazia del XXI secolo, tale da facilitare non soltanto l'espressione variegata come il pensiero umano, ma anche la peer production […] L'emergere dei beni comuni della conoscenza offre un modello nuovo per condividere le informazioni, stimolare l'innovazione, favorire la creatività e costruire un movimento unitario che si batta per l'accesso paritario alle informazioni da parte di ogni membro di una

17 comunità›› (Kranich in Hess, Ostrom, 2009, p. 96).

Una delle reazioni alle “recinzioni” imposte alla conoscenza è la nascita del movimento Open Access, strettamente legato all'idea delle conoscenza come bene pubblico che rappresenta la via “aperta” alla gestione e alla diffusione della conoscenza scientifica (Paccagnella, 2010, p. 135).

Con il termine Open Access (OA) si intende l’accesso aperto, tramite Internet, alle produzioni intellettuali dei ricercatori e degli studiosi di tutto il mondo, i quali sono incoraggiati a divulgare i propri lavori scientifici rendendoli liberamente accessibili alle altre comunità di ricerca, o a chiunque sia interessato ad essi.

L'OA promuove dunque la possibilità di leggere, scaricare, stampare, distribuire, creare link al testo pieno, e indicizzare tutti quei documenti che transitano attraverso canali di comunicazione “aperti”. Nel 2009 gli articoli pubblicati secondo le modalità Open Access erano in media circa il 20,4% con differenze tra le varie discipline (es. 13% chimica, 33% scienze della terra, ecc.).3

Secondo Antonella De Robbio (2006), responsabile del CAB, Centro di Ateneo per le Biblioteche dell’Università di Padova, l’OA oltre ad essere un movimento, cioè un insieme di iniziative internazionali con al centro gli scienziati e i bibliotecari coalizzati insieme, è una strategia pensata per garantire la più ampia disseminazione e la libera fruizione delle risorse scientifiche attraverso canali indipendenti, anche se complementari al circuito commerciale.

L’interesse della comunità bibliotecaria internazionale a sostegno dell’OA, è dovuto principalmente al fatto che esso possa avere delle ricadute effettive sul cosiddetto serial crisis pricing, ovvero sull’aumento vertiginoso dei prezzi dei periodici del settore scientifico-tecnico-medico (STM).

Fin dall'inizio degli anni Novanta, la comunità scientifica prese atto degli alti costi degli abbonamenti delle riviste legate al mondo della ricerca, denunciando il crescente divario tra i costi delle riviste accademiche e gli stanziamenti destinati alle biblioteche per il loro acquisto.

A condizionare la diffusione dell'informazione non sono solo i costi, ma anche il

18 controllo che gli editori esercitano sulla proprietà e l'uso delle risorse. Malgrado gli editori si assicurino gratuitamente proprietà e diritti, gli autori scientifici non pretendono royalties4, avendo un esclusivo interesse rivolto alla più ampia diffusione

delle loro ricerche, legato anche a esigenze di avanzamento e di carriera. Si arriva, dunque, al circolo vizioso che contraddistingue l'attuale modello di diffusione dell'informazione scientifica, in cui gli attori sociali più influenti, scienziati ed editori, perseguono strategie e finalità che sembrano non trovare punti di convergenza. Se i primi sono interessati principalmente alla diffusione dei loro lavori scientifici ed al fatto che siano resi disponibili per l’importanza che le citazioni e l’impact factor5 hanno sulla

valutazione qualitativa di quello che si pubblica, gli editori, dal canto loro, una volta acquisiti a titolo gratuito i diritti, mirano ad ottenere i massimi profitti e ad incrementare i ricavi, scegliendo quindi di agire sui prezzi e attuando una politica restrittiva nell’accesso all’informazione.

In proposito Francesca Di Donato scrive:

‹‹Per essere accessibile, una rivista deve acquistare visibilità, essere cioè nella giusta vetrina ed avere buona pubblicità. E nelle vetrine migliori finiscono quelle riviste che le biblioteche non possono acquistare perché è su di esse che vengono calcolati gli indici bibliometrici. Si crea così un circolo vizioso in cui a ricevere più citazioni non possono che essere i testi maggiormente accessibili, che restano tali perché continuano ad essere i più citati. In questo modo la scienza

mainstream, così come si è andata configurando dal secondo dopoguerra a oggi,

viene creata come artefatto del Science Citation Index, che dietro alle sue funzioni bibliometriche e scientometriche nasconde un potere ben più ampio e pervasivo›› (Di Donato, 2010).

Si assiste dunque a un rafforzamento dell'“effetto San Matteo”, individuato da Merton, il quale tra la fine degli anni Sessanta e i primi degli anni Settanta, diede vita a numerose ricerche sulle inuguaglianze della distribuzione delle ricompense scientifiche. Secondo Merton esiste una sorta di “struttura di classe” nella scienza, per cui gli scienziati famosi avrebbero più opportunità degli scienziati poco noti di accrescere la propria reputazione (Rigney, 2011):

‹‹Gli scienziati altamente produttivi di una grande università ricevono un pubblico apprezzamento più spesso di scienziati altrettanto produttivi che lavorano

4Con il termine royalty si intende il pagamento di un compenso al titolare di un brevetto o una proprietà

intellettuale, con lo scopo di poter sfruttare quel bene per fini commerciali. (http://it.wikipedia.org/wiki/Royalties ).

5L'impact factor (fattore d'impatto) è un parametro che valuta numericamente, in base alle citazioni che un

articolo riceve e al numero di lavori pubblicati nello stesso periodo, la posizione della rivista rispetto ad altre della stessa categoria o disciplina (http://it.wikipedia.org/wiki/Impact_factor ).

19 in un'università più piccola›› (Merton 1973, cit. in Rigney, 2011, p.32).

Ciò significa che quando due scienziati sono ugualmente produttivi, quello con credenziali più prestigiose ottiene un apprezzamento maggiore rispetto al collega con credenziali meno prestigiose. In questo modo un nome già prestigioso diventa ancora più prestigioso. A livello istituzionale l'“effetto San Matteo” fa sì che i centri di eccellenza scientifica ottengano più risorse e più prestigio, attraendo docenti più qualificati e studenti più brillanti e quindi rafforzando ed espandendo le loro posizioni iniziali. Rigney (2011) riprende Cole e Cole (1973) nel dire che ‹‹gli scienziati ottengono visibilità attraverso la pubblicazione di ricerche significative. Una volta ottenuta questa visibilità, gli scienziati beneficiano di un effetto alone perchè le loro ricerche ricevono maggiore attenzione grazie alla loro visibilità, allargando ulteriormente il gap tra scienziati d'élite e scienziati medi›› (Cole e Cole 1973, cit. in Rigney, 2011, p. 35).

L'effetto San Matteo non si riferisce solamente alle discriminazioni tra scienziati prestigiosi e non, ma anche tra uomini e donne, in questo caso si parla di “effetto Matilda” teorizzato dalla storica della scienza Margaret Rossier (1993), che ha promosso storicamente un vantaggio cumulativo maschile e uno svantaggio cumulativo femminile in campo scientifico tramite l'aiuto reciproco fra ex alunni della stessa scuola e altre pratiche discriminatorie (Rigney, 2011).

Un altro caso in cui può essere applicato l'“effetto San Matteo” è quello concernente il divario nella pubblicazione scientifica tra paesi ricchi e paesi poveri: i paesi ricchi, soprattutto nordamericani ed europei, che hanno strutture scientifiche consolidate e abbondantemente finanziate, in cui operano ricercatori di alto profilo, ricevono una quota di citazioni statisticamente superiore alle aspettative nelle riviste scientifiche, mentre i paesi meno sviluppati ricevono una quota di citazioni inferiore alle aspettative (Rigney, 2011), questo significa che mentre nelle economie ricche aumenta la ricchezza, considerato che innovazione e informazione promettono vite più lunghe e più sane, grazie a un più ampio accesso al sapere e alla cultura, nei paesi poveri a causa della scarsità di informazione e sapere e dunque di innovazione, sta aumentando la diffusione di epidemie e dell'analfabetismo.

Per ovviare a questo circolo vizioso, che porta la discriminazione e l'esclusione dalla visibilità in ambito scientifico, oltre che l'impossibilità della diffusione delle

20 ricerche scientifiche, nel 1999 nacque a Santa Fe, negli Stati Uniti, l'OAI, Open Archive Initiative, un progetto che rendeva disponibili gli archivi contenenti documenti prodotti in ambito accademico, il quale pose le basi per la nascita dell'Open Access, predisponendo gli standard e i protocolli per l'interoperabilità tra archivi.

L'espressione Open Access fu utilizzata per la prima volta nel manifesto ufficiale della Budapest Open Access Initiative (BOAI), nata nel febbraio 2002, dalla volontà di un gruppo di studiosi e di editori già impegnati in progetti di editoria alternativa, e volto alla creazione di una rete globale in grado di assicurare la piena accessibilità alla letteratura scientifica e di ricerca6 :

‹‹Un'antica tradizione e una nuova tecnologia convergono per rendere possibile un bene pubblico senza precedenti. La tradizione antica è la disponibilità di scienziati e ricercatori a pubblicare i frutti delle loro ricerche in riviste scientifiche senza compenso, per il bene della ricerca stessa e della conoscenza. La nuova tecnologia è Internet. Il bene pubblico che rendono possibile è la distribuzione elettronica a livello globale della letteratura pubblicata su riviste con

peer review e il suo accesso, in modo completamente gratuito e senza restrizioni di

sorta, per tutti gli scienziati, i ricercatori, gli insegnanti, gli studenti e altre menti curiose. Rimuovere le barriere all'accesso di questa letteratura stimolerà la ricerca, arricchirà l'istruzione, renderà possibile condividere il sapere del ricco con il povero e del povero con il ricco, massimizzerà l'utilità di questa letteratura e getterà le fondamenta per unire l'umanità in una conversazione intellettuale e in una comune ricerca della conoscenza›› (Boyle, in Hess, Ostrom, 2009, p. 145).

Il manifesto BOAI indicò i due strumenti da adottare per favorire la diffusione dell'accesso aperto (Di Donato, 2009, p. 103):

1. Gli archivi elettronici aperti, che non richiedono che i risultati depositati siano stati preventivamente sottoposti a peer review7 e che possono essere istituzionali

(come quelli di università e centri di ricerca) o disciplinari. Tali strumenti rientrano nella cosiddetta strategia verde (Green Road) per l'accesso aperto il cui principale sostenitore è Steven Harnad, professore di psicologia cognitiva all'Università del Southampton e tra i massimi esponenti del movimento. Tra i più noti archivi disciplinari troviamo: ArXiv, RePec per le scienze economiche e E-LIS per le scienze biblioteconomiche e

6La BOAI fu finanziata dalla Fondazione Soros e sottoscritta da un gruppo eterogeneo di sostenitori,

composto da studiosi, università, fondazioni, editori, società scientifiche.

7Nell'ambito della ricerca scientifica la valutazione tra pari, revisione dei pari, o revisione paritaria

(comunque meglio nota con il termine inglese di "peer review") indica la procedura di selezione degli articolio dei progetti di ricerca effettuata attraverso una valutazione esperta eseguita da specialisti del settore per verificarne l'idoneità alla pubblicazione scientifica su riviste specializzate o, nel caso di progetti, al finanziamento degli stessi (http://it.wikipedia.org/wiki/Peer_review).

21 dell'informazione. A partire dall'ottobre 2009, la quasi totalità delle università e dei centri di ricerca dei paesi sviluppati si è dotata di archivi istituzionali.

2. Le riviste ad accesso aperto non sono diverse dalle riviste tradizionali se non in quanto rendono gli articoli da loro selezionati liberamente disponibili al mondo. Le riviste rientrano nella strategia definita come strada aurea (Gold Road) per l'accesso aperto, tra queste troviamo PLOSone, uno strumento essenziale per la ricerca biomedica pubblicato dalla Public Library of Science.

In questo contesto archivi e riviste non sono alternativi ma complementari: i primi consentono la certificazione dei risultati e l'archiviazione di lungo periodo anche di quegli articoli che vengono pubblicati su riviste ad eccesso riservato, e non effettuano il

peer review, mentre le seconde effettuano il peer review, assolvendo al compito della

disseminazione e restano strumenti essenziali ai fini della valutazione. (Di Donato, 2009, pag. 105).

Jean-Claude Guédon, docente dell'Università del Quebec, tra i primi promotori dell'Open Access, offre le argomentazioni a favore della diffusione dell'Open Access

Initiative:

‹‹1. Essa è l'unica alternativa che ha una possibilità di svilupparsi senza gli svantaggi economici propri delle attuali pubblicazioni digitali spacciate sotto forma di licenze locali.

2. È l'unica alternativa che, malgrado poggi su una certa misura di finanziamento pubblico, ha una possibilità di sostenere nel medio e lungo periodo la concorrenza dei grandi editori, a differenza della maggior parte delle società di studiosi e di simili, generalmente ineccepibili, istituzioni.

3. È l'unico modo che i bibliotecari hanno di recuperare la responsabilità e il controllo su compiti tradizionali quali la classificazione e la conservazione delle fonti. In questo modo essi possono anche essere coinvolti nello sviluppo di strumenti che aggiungano valore alle raccolte di articoli scientifici (quella che chiamo “ingegneria epistemologica”).

4. È l'unico modo di assicurarsi che un potente effetto panottico, tanto già scoperto quanto da scoprire, non resti dominio di aziende private irresponsabili e mosse dal profitto, molte delle quali operano offshore.

5. Gli archivi aperti offrono una buona occasione per sviluppare nuove e positive relazioni con gli scienziati, in particolare con gatekeeper ed amministratori, e per rivedere in profondità il processo di valutazione degli scienziati, ora che tali questioni possono essere trattate indipendentemente dai limiti posti dalla stampa›› (Guédon, 2004, trad. a cura di Pievatolo, Casolini, Di Donato, p. 94).

La BOAI ha inaugurato una stagione densa di iniziative ed eventi che hanno dato un contributo fondamentale alla diffusione del movimento OA. Tra questi hanno avuto un'importanza particolare gli incontri di Bethesda e di Berlino del 2003, che hanno

22 prodotto le due dichiarazioni conosciute come il Bethesda Statement on Open Access

Publishing e la Berlin Declaration on Open Access to Knowledge in the Sciences and Humanities. Il primo ha affermato una serie di principi che sanciscono l’impegno

assunto dagli aderenti, istituzioni, funding agencies, biblioteche, editori, società scientifiche e studiosi, coinvolti direttamente nella elaborazione del documento all’interno di tre distinti gruppi di lavoro, ad operare concretamente a sostegno dell’Open Access della letteratura scientifica di area biomedica.

La seconda, siglata da importanti istituzioni di tutto il mondo, e tuttora aperta a nuove adesioni, ma anche documento di riferimento per successive dichiarazioni da parte di comunità scientifiche nazionali, tra cui quella italiana8, ha inteso sancire il

sostegno delle istituzioni aderenti al paradigma dell'OA, ed alle strategie indicate da BOAI, e incoraggiare i ricercatori a pubblicare secondo i principi dell'accesso aperto. Nella dichiarazione si afferma il principio secondo cui la versione finale delle pubblicazioni scientifiche sia depositata in archivi digitali, pubblici e liberamente accessibili. Tali archivi devono essere gestiti dalle università, dagli enti di ricerca, da agenzie governative o da altre istituzioni che sostengono l'accesso aperto. All'autore è richiesto di depositare nell'archivio aperto, istituzionale o disciplinare, le versioni finali delle proprie pubblicazioni scientifiche, una volta che siano state accettate per la pubblicazione.

Sono dunque tre le dichiarazioni che hanno portato alla nascita e alla diffusione del movimento Open Access, e vengono considerate comunemente unitarie, come tappe di un progetto condiviso, tanto che Peter Suber, docente di filosofia all'Earlham College (USA), tra i primi firmatari delle dichiarazioni, conia la formulazione BBB Definition (Budapest, Berlin, Bethesda), per evidenziare gli aspetti comuni delle definizioni di OA presenti nei loro testi.

Attorno alla BBB Definition si schierano i principali promotori dell'OA, Stevan Harnad, Jean-Claude Guèdon e Peter Suber (De Robbio, 2006).

Harnad propone un modello fondato sui principi di Budapest, basato

8 Nel novembre 2004 è stata firmata presso l'Università di Messina la dichiarazione di Messina, a cui

hanno aderito settantaquattro atenei su settantasette in Italia. I firmatari dichiarano “di aderire alla

Dichiarazione di Berlino, a sostegno dall'accesso aperto alla letteratura scientifica, con l'auspicio che questo gesto costituisca un primo ed importante contributo dato dagli Atenei italiani ad una più

rapida ed ampia diffusione del sapere

23 sull'autoarchiviazione e sul metodo dell'author pays senza nessun compromesso. L'OA dovrebbe concentrarsi principalmente sugli aspetti legati all'autoarchiviazione e per questo motivo critica il movimento fondato da Suber, il FOS (Free Online Scholarship) che insieme ad altri soggetti come Creative Commons, si occupa di un numero più ampio di aspetti legati all'editoria digitale, ai diritti di ripubblicazione o di creazione di opere derivate. Suber e Guédon propongono invece un modello di OA in evoluzione basato su una combinazione equilibrata tra la strada verde e la strada aurea, e sulla realizzazione di riviste OA i cui costi sarebbero coperti in prevalenza da finanziamenti statali, enti pubblici, università e altri soggetti.

Al di là delle dispute interne al movimento Open Access sull'interpretazione delle Dichiarazioni, tutti i promotori dell'OA concordano sul fatto che stia nascendo una nuova scienza collaborativa la quale accelererà il passo della ricerca e dell'apprendimento scientifico, e permetterà il superamento delle divisioni tra scienza

mainstream e scienza periferica. L'apparizione di strumenti editoriali basati sul libero

accesso e di nuovi servizi web metterà a disposizione degli individui un patrimonio sconfinato di conoscenze e contribuirà allo sviluppo di comunità di condivisione sparse in tutto il mondo.

Man mano che le collaborazioni scientifiche su vasta scala entreranno a far parte della norma, gli scienziati si baseranno sempre più su metodi distribuiti per la raccolta dei dati, la verifica delle scoperte e il testing delle ipotesi, non solo per velocizzare il processo ma anche per accrescere la veridicità delle stesse conoscenze scientifiche. La pubblicazione rapida, interattiva e liberamente accessibile coinvolgerà una parte molto più ampia della comunità scientifica nel processo di peer review, e ciò consentirà di tradurre più rapidamente le nuove conoscenze in soluzioni pratiche e nuove iniziative.

Si pensi ad esempio al settore biomedico, in cui l'OA ha significativi risvolti etici e un impatto sociale molto forte: per la ricerca sul cancro o quella sull'influenza aviaria è di vitale importanza la diffusione ampia ed immediata dei progressi fatti nelle scienze. Un altro esempio che rivela l'importanza dell'Open Access è quello che vede come protagonista l'équipe di fisici che ha scoperto l'esistenza di particelle che possono viaggiare più veloci della luce, chiamate neutrini. I ricercatori dell'esperimento Opera il 23 settembre 2011 (Internazionale, 30 settembre/6 ottobre 2011) hanno pubblicato online, su ArXiv i risultati dei loro esperimenti, con tutti i dettagli e i dati grezzi,

24 offrendo alla comunità scientifica i mezzi per verificare la validità del loro lavoro.

Esiste una banca dati gestita dall'Università di Lund (Svizzera) che censisce tutte le riviste Open Access di qualità in ogni settore disciplinare. A oggi DOAJ Directory Open Access Journal enumera oltre 1500 e-journal open access.

Il problema principale che soggiace al movimento Open Access è quello del finanziamento degli archivi e delle riviste ad accesso aperto: la letteratura Open Access è gratuita per lettori e utenti, ma non per i produttori, i quali hanno bisogno di introiti e sussidi per coprire i costi di digitalizzazione dell'opera, pubblicazione online e autorizzazione a pubblicarla, e infine per la peer review. Sebbene Internet consenta una diffusione più ampia e a costi più bassi rispetto ad ogni precedente forma di pubblicazione, questi costi, per quanto bassi, devono essere coperti perchè l'OA sia sostenibile (Suber in Hess, Ostrom, 2009, p.179).

Suber (in Hess, Ostrom, 2009) dichiara che circa la metà delle riviste Open Access impone una tariffa di elaborazione su ogni articolo accettato, che va pagata dall'autore o dal datore di lavoro dell'autore, da chi sovvenziona le sue ricerche o dallo stato. Se la tariffa di elaborazione dell'articolo copre tutti i costi di revisione e pubblicazione, allora la rivista è in condizione di fornire libero accesso online al testo integrale senza subire una perdita economica. Il modello di finanziamento anticipato impone un pagamento allo sponsor dell'autore per gli articoli in uscita, non allo sponsor del lettore per gli articoli in entrata: il pagamento è richiesto per la diffusione, non per l'accesso. Il modello funziona perchè gli autori sono disposti a rinunciare alle royalty per far passare il loro messaggio, e sempre più istituzioni che impiegano ricercatori o fondi di ricerca sono disposte a considerare i costi di diffusione come parte del costo della ricerca, dunque:

‹‹la pubblicazione ad accesso aperto può diventare economicamente praticabile e addirittura conveniente se le istituzioni accademiche e di ricerca intervengono direttamente, preferibilmente in forma consortile, a sostenere i costi di pubblicazione di riviste ad alto profilo scientifico›› (CRUI, Commissione Biblioteche Gruppo Open Access, 2009, cit. in Di Donato, 2009, p. 105).

Tra gli esempi si possono ricordare la Public Library of Science e la BioMed Central (Benkler, 2006, p. 409).

Nel caso della Public Library of Science, che è no profit, le entrate sono garantite dagli autori, dalle donazioni e dalle università che fanno parte dell'organizzazione.

25 Invece BioMed Central, che è for profit, combina pagamenti da parte di autori e università con una varietà di prodotti personalizzati, come abbonamenti a sistemi di review della letteratura o servizi di update elettronici. I costi sostenuti dagli autori, che devono pagare per vedere pubblicato il loro lavoro, rientrano nei costi della ricerca scientifica e vengono inclusi nelle richieste di sovvenzioni pubbliche. Inoltre sia PLOS che BioMed Central sono dotate di sistemi di esenzione per i ricercatori che non possono permettersi di pagare i costi di pubblicazione,

Ma la domanda che sorge spontanea è: come si può conciliare l'accesso aperto con la proprietà intellettuale? Che vantaggio trarrebbero i ricercatori nel pubblicare gratuitamente e apertamente le loro ricerche?

Secondo Suber (2009) l'Open Access non solo non intaccherebbe il reddito dei ricercatori, ma addirittura potrebbe incrementarlo. Agli autori in generale, non interessano tanto le royalty (anche perchè, come si è detto in precedenza, rinunciano ad esse) quanto piuttosto la visibilità data dalla pubblicazione:

‹‹Gli autori vogliono che il loro lavoro sia notato, letto, ripreso, approfondito, utilizzato e citato. Vogliono anche che sulla rivista sia ben evidente la data, per stabilire la precedenza rispetto ad altri scienziati che lavorano allo stesso argomento. […] queste ricompense intangibili (rese poi tangibili mediante cattedre e promozioni) compensano i ricercatori dell'aver rinunciato alle royalty sui loro articoli›› (Suber, 2009, in Hess e Ostrom, 2009, p. 183).

Oltre a non intaccare il reddito degli autori, l'Open Access garantisce anche la tutela del diritto di proprietà intellettuale, dal momento che solitamente in una rivista ad accesso aperto gli autori mantengono il copyright potendo fruire liberamente della propria produzione intellettuale. L'autore può dunque depositare la sua opera in un archivio aperto, rendendola immediatamente disponibile anche prima del processo di referaggio, per una libera e aperta discussione con tutta la comunità, inoltre i detentori del copyright che autorizzano l'OA rinunciando a certi diritti possono sempre revocare l'autorizzazione, anche se sarebbe poco conveniente dal momento che l'edizione OA della sua opera è già online (Suber, 2009, in Hess e Ostrom, 2009, p.205).

L'Open Acces si sta rivelando un utile strumento sia per l'abbattimento dei costi di pubblicazione e circolazione della conoscenza scientifica sia per la rimozione delle barriere d'accesso alla produzione intellettuale, come nota Suber (2009) l'OA ‹‹non vuol dire solo accelerare la ricerca e risparmiare soldi; significa anche libertà da barriere

26 inutili, equità per i contribuenti, restituzione ai ricercatori del controllo sulla propria ricerca, eliminazione delle recinzioni intorno a un bene comune, nonché un servizio a chi è poco servito (Suber, 2009, in Hess, Ostrom, 2009, p. 216).

Nonostante ciò ci vorrà ancora del tempo per far sì che vengano abbattute tutte le barriere prima di poter considerare la conoscenza come un bene comune universale a pieno titolo. Le barriere che permangono sono quattro (Suber, 2009):

‹‹1. barriere per i disabili: gran parte dei siti web non sono ancora pienamente accessibili agli utenti disabili;

2. barriere linguistiche: gran parte della letteratura online è in lingua inglese, o in una sola lingua, e la traduzione automatica ha molti difetti;

3. barriere connesse al filtraggio e alla censura: sempre più scuole, datori di lavoro e governi vogliono porre dei limiti a ciò che possiamo vedere;

4. barriere di connettività: il digital divide costringe offline miliardi di persone, tra cui milioni di ricercatori seri.›› (Suber, 2009, in Hess e Ostrom, 2009, p. 196).

1.3 Il free software e l'open source

L'emblema principale della produzione orizzontale basata sui beni comuni è rappresentato dal free software e dal software open source.

Il concetto di free software si basa sul fatto che il codice sorgente del software, cioè il DNA del programma, è aperto ed accessibile in modo tale che chiunque, con le adeguate conoscenze, possa mantenerlo, adattarlo, implementarlo e modificarlo secondo le proprie necessità. Linux, Firefox e Wikipedia sono tre esempi di successo della pratica di software libero.

Il software libero nacque per mano dell'hacker Richard Stallman che, nel 1984 entrò in un progetto per la costruzione di un sistema operativo non proprietario chiamato GNU (GNU is not Unix 9). Dal momento che Stallman non poteva scrivere un

sistema operativo tutto da solo, ne rilasciò alcune parti sotto una licenza che permetteva a chiunque di copiare, distribuire e modificare il software. Tutto quello che chiedeva, a chi lo avesse modificato, era di distribuirlo agli altri esattamente alle stesse condizioni.

Nacque così il software libero che poteva essere utilizzato, modificato e

9 Unix, creato nel 1969 da Ken Thompson fu il primo sistema operativo portabile della storia.

27 migliorato da chiunque, a differenza del software proprietario che limita il numero di macchine su cui l'utente lo può installare, ed è distribuito in forma binaria, compilata o eseguibile (Schweik, 2009, in Hess, Ostrom, 2009, p. 302). Per promuovere questi ideali di libertà diede vita alla Free Software Foundation o FSF, un'organizzazione no profit mirata alla raccolta di fondi, al coordinamento dei progetti e alla sensibilizzazione del popolo dell' informatica.

Nel marzo 1985, Stallman scrisse il leggendario Manifesto GNU che apparve sul “Dr. Dobb's Journal of Software Tools” un'importante rivista dedicata a un pubblico di esperti di tecnologia10, in cui difese fortemente i principi della condivisione e

cooperazione propri dell'etica hacker:

‹‹Io credo che il punto fondamentale sia che, se a me piace un programma, io debba condividerlo con altre persone a cui piace. I venditori di software usano il criterio “divide et impera” con gli utenti, facendo sì che non condividano il software con altri. Io mi rifiuto di spezzare così la solidarietà con gli altri utenti. La mia coscienza non mi consente di firmare un accordo per non rivelare informazioni o per una licenza d'uso del software. Ho lavorato per anni presso il laboratorio di intelligenza artificiale per resistere a queste tendenze e ad altri atteggiamenti sgradevoli, ma col tempo queste sono andate troppo oltre: non potevo rimanere in una istituzione dove ciò viene fatto a mio nome contro la mia volontà. Per poter continuare ad usare i computer senza disonore, ho deciso di raccogliere un corpus di software libero in modo da andare avanti senza l'uso di alcun software che non sia libero. Mi sono dimesso dal laboratorio di Intelligenza Artificiale per togliere al MIT ogni scusa legale che mi impedisca di distribuire GNU [...]Una volta scritto GNU, ognuno potrà avere liberamente del buon software di sistema, così come può avere l'aria. Questo significa molto di più che far risparmiare a ciascuno il costo di una licenza Unix: vuol dire evitare l'inutile spreco di ripetere ogni volta lo sforzo della programmazione di sistema. Queste energie possono essere invece impiegate ad avanzare lo stato dell'arte. I sorgenti completi del sistema saranno a disposizione di tutti. Di conseguenza, un utente che abbia necessità di apportare dei cambiamenti al sistema sarà sempre in grado di farlo da solo o di commissionare i cambiamenti ad un programmatore o ad un'impresa. Gli utenti non saranno più in balia di un solo programmatore o di una impresa che, avendo la proprietà esclusiva dei sorgenti, sia la sola a poter fare le modifiche. Le scuole avranno la possibilità di fornire un ambiente molto più educativo, incoraggiando gli studenti a studiare e migliorare il software di sistema. I laboratori di informatica di Harvard avevano una politica per cui nessun programma poteva essere installato nel sistema senza che i sorgenti fossero pubblicamente consultabili, e la praticarono rifiutandosi effettivamente di installare alcuni programmi. Questo comportamento mi è stato di grande ispirazione. Infine, scompariranno le necessità burocratiche di tener conto di chi sia il proprietario del software di sistema e di chi abbia il diritto di farci cosa››. (Stallman, 1985)

28 Per evitare il rischio di appropriazione e chiusura che poteva verificarsi con il software di dominio pubblico, tutte le applicazioni di GNU vennero protette da una particolare licenza, la GNU GPL (General Public Licence), e chiamata anche provocatoriamente copyleft11, che richiedeva a chiunque modificasse il software e ne

distribuisse una versione modificata di rilasciarla sotto lo stesso tipo di licenza che aveva il software originale.

Una delle sezioni più importanti del copyleft era la clausola riguardante le opere derivate, ossia le varianti che si possono ottenere a partire da un'opera già esistente: la licenza copyleft afferma che le opere derivate debbano essere liberamente disponibili, restando sottoposte allo stesso tipo di licenza, la quale viene considerata, per questo motivo, una licenza “virale” (Lih, 2009, p.32)

Inoltre, per evitare possibili impedimenti per l'uso libero, la distribuzione e la modifica delle copie, le licenze copyleft includono delle condizioni aggiuntive:

• assicurarsi che la licenza copyleft non possa essere revocata:

• assicurarsi che il lavoro e le sue versioni derivate siano distribuite in una forma che ne faciliti le modifiche, distribuendo il codice sorgente e prevedendo che la compilazione di questo possa avvenire senza impedimenti di sorta;

• assicurarsi che il lavoro modificato sia accompagnato da una descrizione per identificare tutte le modifiche apportate all'opera originaria, per esempio mediante manuali utente12.

Il software libero non è dunque privo di copyright, esso viene semplicemente ribaltato: il copyright non viene utilizzato per impedire il diritto di copia, ma per garantire a chiunque tale diritto ed evitare che qualcuno possa impedirlo in futuro.

Secondo il progetto GNU un software è libero quando garantisce:

• ‹‹libertà di eseguire il programma, per qualsiasi scopo (anche commerciale) e da parte di qualsiasi soggetto, pubblico o privato, anche qualora questi fossero in qualche modo sgraditi all'autore del programma;

• libertà di studiare il programma e di modificarlo per adattarlo alle proprie esigenze; • libertà di adattare e distribuire copie del programma, in qualsiasi numero e con

qualsiasi modalità, gratis o a pagamento;

• libertà di migliorare il programma, derivarne nuove versioni e distribuirle pubblicamente›› (Paccagnella, 2010, p.50).

11Con un gioco di parole che sottolineava il contrasto con il tradizionale copyright. 12http://it.wikipedia.org/wiki/Copyleft

29 Tra gli esempi di utilizzo di software libero e delle licenze GPL si possono annoverare il fatto che più dell'85% dei progetti di free software in corso includono una versione della GPL o di una licenza simile, il 70% circa dei servizi web funzionano grazie ad Apache, un software libero, Google, Amazon e CNN.com fanno girare i loro server con sistemi operativi GNU/Linux, e lo fanno perchè credono che questo sistema operativo prodotto in modo orizzontale sia più affidabile dei rivali, non perchè è libero (Benkler, 2006, p. 81).

Va precisato inoltre che il software libero è una questione di libertà e non di gratuità13. Per ovviare al malinteso terminologico, Stallmann chiarì che il termine free

andava inteso pensando alla “libertà di parola” e non alla “birra gratis”: ‹‹Il software libero è il software che gli utenti sono liberi di distribuire e modificare. Alcuni lo avranno gratuitamente, altri dovranno pagare per ottenere le loro copie, e se dei finanziamenti aiutano a migliorare il software tanto meglio. La cosa importante è che chiunque ne abbia una copia sia libero di cooperare con altri nell'usarlo›› (Stallman, 1985).

La licenza GNU GPL a proposito della non gratuità del software sottolinea che : ‹‹ È possibile richiedere un pagamento per il trasferimento fisico di una copia del programma, è anche possibile a propria discrezione richiedere un pagamento in cambio di una copertura assicurativa›› (Licenza Pubblica Generica del Progetto GNU, 1991, trad. Bassi, 2000, p. 10).

Deve essere puntualizzato che parlare di software libero non significa parlare semplicemente di programmazione informatica, il discorso è molto più ampio, dal momento che la rivoluzione che si sta svolgendo in Rete sta modificando la diffusione del sapere, portando Paccagnella a sostenere che il software libero rappresenta un nuovo fenomeno sociale “totale”, in quanto racchiude in sé elementi culturali, organizzativi ed economici (Paccagnella, 2010, p.49).

Per ciò che concerne gli aspetti organizzativi del movimento del software libero Paccagnella (2010, p. 71) menziona l'opera di Eric Raymond (1999, trad. it. 1999) “La

cattedrale e il bazar”, in cui il modello di produzione del software proprietario viene

associato alla struttura di una cattedrale gotica medievale: un'opera progettata da

13La parola free in inglese viene utilizzata in maniera indifferente riferendosi sia al concetto di libertà che