4 Analisi

dell’immagine

4.1 Le tecniche di analisi dell’immagine

Per molto tempo la microscopia è stata utilizzata come una tecnica di indagine prevalentemente qualitativa: la caratterizzazione morfologica dei campioni avveniva esclusivamente in termini descrittivi (“profilo più grande”, “nucleo frastagliato”, “apparenza globosa” ecc.) e anche le caratteristiche istochimiche venivano espresse in termini analoghi (reazioni “deboli”, “buone”, “forti” ecc.).

La combinazione occhio-cervello umani è infatti insuperabile nell’osservare una scena, nel comprenderla e nel classificarne in qualche modo i contenuti. Ciò che l’occhio umano trova difficile è un’accurata e riproducibile quantificazione di ciò che vede. È su questo piano della quantificazione che si colloca l’analisi delle immagini, termine che useremo qui nel suo senso più esteso, indicando con esso quella disciplina che mira appunto a precisare gli strumenti e i metodi con cui estrarre le caratteristiche quantitative contenute in un’immagine microscopica.

Da sempre infatti i microscopisti hanno avvertito tale esigenza, consapevoli che l’immagine fornita da un microscopio, fosse esso ottico o elettronico, portava con sé tutta una serie di informazioni sul materiale osservato che sfuggivano alla semplice ispezione visiva.

Già Van Leeuwenhoek nel diciassettesimo secolo stimava la dimensione degli oggetti che osservava attraverso quei suoi primi microscopi per comparazione con altri oggetti e in certi casi, pur non esistendo all’epoca una scala standardizzata di unità di misura, tentò anche una valutazione in termini assoluti utilizzando come unità il “pollice olandese” e un metodo di comparazione con un oggetto di dimensione nota (lettera a Huygens del 1679). Un approccio analogo condusse Jurin nel 1718 a una stima (anche piuttosto accurata) del diametro dei globuli rossi.

L’interesse per una descrizione quantitativa dell’immagine microscopica proseguì nel diciottesimo secolo e portò allo sviluppo di accessori per il microscopio, come ad esempio il micrometro a vite di Adams (1771), atti a effettuare delle misurazioni. Il grande sviluppo tecnologico conosciuto dal microscopio nel diciannovesimo secolo vide un ulteriore raffinamento degli accessori per la misurazione, mentre cominciavano a essere messi a punto i principi metodologici con cui condurre una misurazione al microscopio: del 1847 è, ad esempio, il principio di Delesse, che consente la valutazione della frazione di volume occupata da un determinato componente in una struttura mediante la misurazione dell’area occupata dai suoi profili in sezioni infinitamente sottili attraverso la struttura stessa.

È solo nel ventesimo secolo, tuttavia, che si assiste a un enorme sviluppo sia metodologico che strumentale dell’approccio quantitativo in microscopia.

Da un punto di vista metodologico meritano di essere ricordati i pionieristici contributi di Chalkey, Floderus, Abercrombie degli anni ‘40 e di Weibel degli anni ‘60 che posero i fondamenti su cui si sviluppò rapidamente la moderna morfometria.

Da un punto di vista strumentale, invece, l’innovazione senza dubbio più radicale in questo campo fu l’introduzione di sistemi computerizzati e in particolare dei sistemi per l’elaborazione e l’analisi di immagini digitali (1969), tanto che oggi si tende spesso (erroneamente) a identificare l’analisi delle immagini con questo specifico approccio.

Il rapido sviluppo di questi strumenti ha condotto negli ultimi due decenni alla messa a punto e all’applicazione di un’ampia varietà di metodi quantitativi. Grazie a essi il microscopio è oggi in campo biomedico uno strumento che consente non solo di indagare in termini rigorosi caratteristiche morfologiche di un campione, ma anche di compiere accurate analisi biochimiche in sito, cioè su un substrato anatomicamente intatto, contribuendo così in modo unico ad aumentare la nostra comprensione del rapporto struttura-funzione.

4.1.1 Gli strumenti per l’analisi delle immagini

4.1.1.1 Micrometria

Alcuni parametri geometrici di base (sostanzialmente misure lineari, angolari, conteggi e densità) possono essere stimati direttamente dall’immagine al microscopio mediante dispositivi ottici o meccanici (Bradbury, 1991), oppure ottenuti mediante opportune strategie di campionamento guidate da semplici strumenti costituiti da retini di linee o di punti che vengono sovrapposti all’immagine microscopica o a una sua registrazione fotografica (Weibel, 1979).

Si tratta degli approcci strumentali più semplici al problema della quantificazione delle caratteristiche di un’immagine, ma che meritano una, sia pur breve, discussione, in quanto tuttora utilizzati in svariate situazioni applicative.

4.1.1.2 Dispositivi ottici e meccanici

Tutte le misure si basano sul confronto tra l’oggetto da misurare e le dimensioni note di una scala standard. Questo principio vale, ovviamente, anche per gli oggetti visualizzati attraverso un microscopio anche se, in questo caso, si devono escogitare dei sistemi particolari al fine di effettuare il confronto con la scala di misura.

Per quanto riguarda le misure lineari esistono vari dispositivi, disponibili quali accessori del microscopio, che consentono di leggere su una scala graduata la distanza tra due punti di un’immagine microscopica.

Quasi tutti i microscopi ottici sono ad esempio equipaggiati con un tavolino traslatore meccanico i cui spostamenti lungo x e y possono essere misurati tramite due scale calibrate in unità assolute di lunghezza (usualmente millimetri) ciascuna affiancata da due scale ulteriori dette “vernier” (da Pierre Vernier che le inventò nel 1631) mediante le quali si apprezzano le frazioni di millimetro: l’accuratezza del sistema diventa così di 0.1 mm. L’operazione di misura consiste semplicemente nell’attraversare l’oggetto da misurare in modo tale che le sue estremità passino successivamente attraverso qualche preciso punto di riferimento (in genere un traguardo a croce o un reticolo inserito nell’oculare del microscopio); le coordinate di ciascuna estremità possono così essere rilevate e la distanza tra esse facilmente calcolata. È evidente che sebbene l’accuratezza teorica del sistema sia di 100 micron è in pratica piuttosto difficile con questo approccio misurare strutture di lunghezza inferiore a 0.15-0.20 mm. Risultati accettabili sono inoltre ottenibili solo per oggetti le cui dimensioni siano dell’ordine del millimetro o maggiori. L’introduzione di tavolini porta campione motorizzati controllati elettronicamente ha consentito in tempi più recenti di migliorare l’efficienza di un tale dispositivo aumentandone di 100 volte il limite di accuratezza (1 micron).

Un sistema analogo è disponibile anche in molti moderni microscopi elettronici a trasmissione. In questo caso è possibile, agendo su appositi comandi, spostare elettronicamente l’immagine e portare successivamente i due punti di interesse al centro del piatto di osservazione: una volta registrate le due posizioni, la distanza viene in genere calcolata automaticamente e visualizzata su un display. Un approccio diverso alle misure di lunghezza è quello ottenibile mediante i cosiddetti micrometri oculari, costituiti da speciali oculari progettati in modo da accomodare una scala graduata che appare nel piano dell’immagine primaria. In alcuni modelli (micrometri oculari filari) oltre alla scala graduata sono presenti anche elementi mobili (una linea o una coppia di linee, un riferimento a croce ecc.) che è possibile spostare nel campo di osservazione mediante una vite micrometrica calibrata. Questi possono dunque essere allineati con le estremità dell’oggetto da misurare e la lettura della distanza apparente tra i due punti può essere effettuata.

Un metodo alternativo è quello consentito dai cosiddetti oculari a divisione di immagine. Si tratta di dispositivi ottici in grado di generare, mediante un sistema di prismi, due immagini identiche del campo microscopico, una delle quali può essere spostata a distanze note (leggibili su una scala esterna) rispetto all’altra: la distanza apparente tra due punti si avrà dunque quando lo spostamento sarà tale che l’immagine del primo punto sia andata a sovrapporsi a quella del secondo.

È ovvio che in approcci di questo tipo la distanza reale dipende dall’ingrandimento utilizzato. È pertanto necessaria una calibrazione preventiva, cioè una procedura mediante la quale si ottiene il valore, in unità reali, che ogni divisione della scala graduata fornita dall’oculare assume a un dato ingrandimento. Ciò avviene mediante un micrometro oggetto, in genere costituito da un vetrino contenente una scala accuratamente graduata (solitamente in divisioni di 10 micron) che va posizionato al posto del preparato. Una volta scelto l’ingrandimento e focalizzata l’immagine di tale scala, questa va allineata allo zero con quella fornita dall’oculare micrometrico e il valore reale assunto da ogni divisione di quest’ultimo può così essere calcolato.

La misura di angoli è talvolta necessaria in microscopia (soprattutto in campo cristallografico). A tale scopo esistono due semplici metodi micrometrici.

Il primo si basa sull’utilizzo di un reticolo goniometrico inserito nell’oculare. Esso è costituito da un semicerchio suddiviso in settori di un grado e l’operazione di misura consiste nell’allineare la base del reticolo con uno dei lati dell’angolo da misurare, avendo cura di posizionarne il vertice al centro del semicerchio (indicato con un riferimento a croce). L’altro lato intersecherà così la scala graduata in un punto che fornirà l’ampiezza angolare cercata.

In microscopia ottica un metodo alternativo consiste nel montare sul microscopio un oculare con un riferimento a croce e un tavolino porta campione rotante come quelli utilizzati per le osservazioni con luce polarizzata: la maggior parte di tali dispositivi è calibrata in gradi, anche se alcuni, incorporando uno o due vernier consentono di aumentare l’accuratezza a (usualmente) sei minuti d’arco. La misura viene effettuata centrando innanzitutto il tavolino con l’asse ottico e quindi allineando uno dei lati dell’angolo da misurare con la linea orizzontale dell’oculare, sempre ponendo il vertice al centro del campo.

In questa situazione si effettua una prima lettura della posizione del tavolino. Una seconda lettura viene effettuata dopo aver ruotato il tavolino fino ad allineare il secondo lato dell’angolo con l’asse orizzontale. La differenza tra le due letture angolari successive fornirà così l’ampiezza dell’angolo. In molti moderni microscopi elettronici a trasmissione, misure angolari possono essere effettuate anche procedendo (come si è già descritto) alla rilevazione delle posizioni di tre punti: l’angolo da essi individuato viene calcolato automaticamente e l’ampiezza risultante visualizzata sull’apposito display.

4.1.1.3 Sistemi di campionamento

Un’ampia classe di parametri quantitativi può essere ottenuta da un’immagine microscopica anche senza l’uso di particolari dispositivi, bensì applicando precise strategie di campionamento e di rilevazione di dati cui far seguire opportune elaborazioni di natura statistica che forniranno la stima dei parametri cercati. La fase di campionamento e di acquisizione dei dati viene normalmente guidata da strumenti (detti sistemi di campionamento o test system) costituiti da reticoli di linee o di punti che vengono sovrapposti in vario modo all’immagine da analizzare.

Sono di questo tipo strumenti come le camere di conteggio, tuttora utilizzate in microscopia ottica per la valutazione del numero e della densità di elementi in sospensioni cellulari. Esse sono costituite dall’assemblaggio di un porta oggetti, caratterizzato dalla presenza di un incavo a fondo piatto su cui è inciso un reticolo millimetrato e da un vetrino copri oggetto che

Figura 4-1: Sistemi di campionamento. a: Camere di conteggio: camera contaglobuli di Burker (sn.) e camera contaglobuli di Thoma (ds.). b: Test systems: reticolo quadrato (so.) e reticolo di Weibel (ds.).

funge da soffitto alla camera stessa. Si crea così uno spazio di altezza nota in cui possono essere introdotte e lasciate sedimentare diluizioni predefinite delle sospensioni cellulari da analizzare. La successiva osservazione al microscopio permette la conta delle cellule depositatesi in una determinata area della camera (valutabile con precisione in funzione delle caratteristiche del reticolo inciso sul pavimento) e quindi il calcolo del numero di cellule per unità di volume della sospensione originale. I principali tipi di camera di conteggio sono illustrati in Figura 4-1 a. Concettualmente sono tutte simili e differiscono tra loro solo per lo spessore della camera e per le caratteristiche del reticolo.

In Figura 4-1 b sono invece rappresentati alcuni sistemi di campionamento cosiddetti coerenti: essi sono costituiti da un insieme di linee e di punti costruito in modo tale che la lunghezza totale delle linee (LT), l’area totale coperta (AT) e il numero di punti presenti (PT) siano grandezze

quantitativamente legate l’una all’altra dalle seguenti relazioni: d k P LT = T⋅ 1⋅ 2 2 d k P AT = T ⋅ ⋅

ove k1 e k2 sono delle costanti e d è la distanza tra i punti del reticolo.

Tali sistemi di campionamento hanno giocato e giocano un ruolo particolarmente importante nell’analisi morfometrica di campioni costituiti da sezioni attraverso un materiale o un tessuto biologico.

Essi infatti una volta sovrapposti direttamente all’immagine della sezione (inserendoli nell’oculare) o, più frequentemente a una riproduzione fotografica dell’immagine stessa, consentono di rilevare con facilità vari dati primitivi (quali ad esempio il numero di punti che cade sopra un determinato componente o il numero di intersezioni che un determinato contorno ha con le linee del reticolo ecc.) necessari all’esecuzione delle procedure stereologiche. Queste (come si discuterà nel paragrafo seguente), a partire dai dati ottenuti sulle sezioni conducono alla stima di caratteristiche “tridimensionali” del campione, quali ad esempio la frazione di volume occupata da un determinato componente, il numero di cellule per unità di volume di tessuto ecc.

4.1.1.4 Analisi computerizzata delle immagini

L’insieme delle tecnologie e dei metodi di analisi computerizzata delle immagini rappresenta attualmente lo strumento di indagine quantitativa forse più potente tra quelli disponibili in microscopia, essendo, come vedremo, l’unico approccio che consente di accedere in forma quantitativa all’intero spettro di informazioni che un’immagine contiene.

Attraverso tali strumenti è possibile, infatti, non solo una maggiore rapidità di esecuzione delle metodologie “classiche” prima sommariamente descritte, ma anche lo sviluppo di nuovi approcci analitici, ampliando così la gamma di caratteristiche del campione biologico che è oggi possibile misurare a partire dalle immagini ottenute dai microscopi.

Dal punto di vista strumentale possiamo distinguere due grandi categorie di sistemi per l’analisi computerizzata delle immagini, che verranno qui descritte e discusse.

4.1.1.5 Sistemi videograflci

Lo schema a blocchi di un sistema videografico tipico è illustrato in Figura 4-2, nella quale sono evidenziati gli elementi fondamentali che costituiscono gli strumenti di questo tipo.

• Innanzitutto una unità di elaborazione, costituita normalmente da un personal computer, al quale tramite apposite interfacce vengono collegate le altre parti del sistema.

• Tra queste di particolare importanza è la tavoletta grafica (o digitizer), un dispositivo elettronico la cui superficie piana è in relazione (elettrica o magnetica) con un dispositivo di puntamento (detto cursore) a essa collegato. Ogni punto della tavoletta corrisponde a una precisa coppia di coordinate cartesiane (x, y) cosicché essa genera un segnale che rappresenta la posizione che il cursore, via via assume sulla superficie, con una risoluzione in genere superiore a 0.1 mm. Ogni qual volta viene premuto un apposito tasto funzionale situato sul cursore le coordinate relative alla posizione del cursore, in quel momento vengono inviate al computer per essere utilizzate dal software.

• Oltre al monitor standard del computer (su cui appaiono i messaggi, i risultati, gli elementi dell’interfaccia con l’utente ecc.) è in genere presente un video monitor ausiliario su cui, mediante una telecamera montata sul microscopio, può essere visualizzata l’immagine da analizzare. Sovrapposta a essa compare un’immagine grafica indicante la posizione del cursore. Muovendo questo sulla tavoletta grafica è possibile portarsi in qualunque punto dell’immagine video e inviarne le coordinate al computer mediante la pressione del tasto funzionale.

Figura 4-2:Schema a blocchi di un sistema videografico per l’analisi di immagine. Luminanza (cd/m2) < 10-4 10-4 – 10-2 10-2 – 10 10 – 102 102 – 104 Telecamere ISIT MCP SIT Isocon Newicon Chalnicon CCD Plumbicon Saticon Vidicon Fluorescenza Campo scuro Contrasto di fase Contrasto interferenziale Campo chiaro

Le telecamere utilizzate in microscopia devono essere caratterizzate da buona linearità di risposta e dall’assenza di difetti difficilmente correggibili come le distorsioni geometriche. Una caratteristica importante da considerare nella scelta della telecamera è la sua sensibilità. Non esiste infatti una telecamera in grado di coprire efficientemente l’intera gamma di luminosità che è possibile ottenere dalle diverse tecniche microscopiche ed è quindi necessario, a seconda della tecnica di formazione dell’immagine utilizzata, scegliere la telecamera più adatta. Nella tabella sopra riportata sono illustrate alcune modalità di osservazione con i corrispondenti livelli di luminosità approssimativi e le telecamere utilizzabili nei vari casi.

Tutti i software per l’analisi di immagine mediante questi sistemi prevedono l’esecuzione di tre procedure fondamentali.

• Innanzitutto la procedura di calibrazione mediante la quale viene calcolato (sulla base dell’ingrandimento dell’immagine da analizzare) il fattore di scala da applicare a ogni misura che verrà effettuata al fine di convertirla in unità di misura reali.

• In secondo luogo la definizione della modalità operativa. Al fine di condurre la successiva fase di misura nel modo più conveniente possibile sono infatti generalmente disponibili diverse modalità operative, le più comuni delle quali sono riportate nella tabella successiva. Qualora si operi su un’immagine a video, in questa fase è in genere possibile anche definire eventuali primitive grafiche (come retini, riquadri ecc.) che si desidera appaiano sovrapposte all’immagine come ausilio al campionamento.

Modalità operativa

Descrizione

Lineare Misura dei parametri geo-metrici di contorni chiusi Lineare Misura della lunghezza di

linee curve

1 punto Conteggio di elementi 2 punti Misura della lunghezza di

linee rette o della distanza tra due punti

3 punti Misura di due segmenti li-neari e dell’angolo tra essi compreso

Punti continui Rilevazione a intervalli re-golari delle coordinate dei punti durante il traccia-mento

Infine la procedura di acquisizione dati durante la quale l’operatore usando il cursore rileva, a seconda della modalità operativa scelta, coordinate di punti notevoli o contorni di strutture presenti nell’immagine a video o in fotografie poste sulla tavoletta grafica. A partire dall’insieme di coordinate così rilevate il software di misura procede al calcolo di vari parametri geometrici relativi agli oggetti analizzati (come quelli descritti nello schema seguente) e alla visualizzazione dei risultati.

Il software disponibile su questi strumenti consente inoltre un’organizzazione dei dati secondo le specifiche dell’operatore, una loro memorizzazione su disco e numerose possibilità di analisi statistica e di calcolo.

Si tratta di sistemi che presentano degli indubbi pregi: non esistono problemi di riconoscimento delle strutture da misurare, in quanto questo compito è lasciato al giudizio dell’operatore, e sono caratterizzati da una notevole facilità d’uso. Presentano naturalmente alcuni limiti quali un’accuratezza dipendente dalla manualità dell’operatore e la possibilità di quantificare con essi soltanto caratteristiche strutturali di un campione, in quanto, come si è già sottolineato, consentono di ricavare esclusivamente parametri di tipo geometrico.

4.1.1.6 Sistemi per l’analisi di immagini digitali

Un sistema per l’analisi delle immagini digitali è costituito da diversi componenti (Figura 4-3 a), ognuno con una sua funzione specifica, come indicato nel diagramma a blocchi di Figura 4-3 b.

Figura 4-3: a: Configurazione di un moderno sistema per l’analisi di immagini digitali. b: Schema a blocchi di un analizzatore per analisi digitali.

La caratteristica tipica di questi strumenti è la presenza di un dispositivo, chiamato convertitore analogico-digitale (ADC), che opera la digitalizzazione dell’immagine. Tale dispositivo campiona a intervalli regolari ogni linea del segnale video che, tramite una telecamera o un altro tipo di rivelatore, proviene dal microscopio e crea una matrice di numeri in cui ogni numero, detto pixel, rappresenta l’intensità luminosa media dell’areola di immagine ottica originale che gli corrisponde. Si ottiene così un’immagine digitale monocromatica (Figura 4-4 a). I colori eventualmente presenti nell’immagine originale possono anch’essi essere codificati in maniera analoga. La digitalizzazione in questo caso viene ottenuta campionando separatamente le tre componenti fondamentali R (Rossa), G (Verde), B (Blu) del segnale video generato da una telecamera a colori. L’immagine digitale finale sarà in questo caso costituita da tre matrici numeriche, corrispondenti rispettivamente alle intensità nei vari punti delle tre componenti cromatiche fondamentali come illustrato in Figura 4-4 b.

Figura 4-4:Procedura di digitalizzazione dell’immagine per ottenere un’immagine digitale monocromatica (a) o un’immagine digitale in colori reali (b).

Il risultato è dunque la traduzione dell’immagine ottica di partenza in una codifica che può contenere in sé, in forma numerica, l’intero spettro di informazioni che un’immagine contiene: l’informazione tonale (cioè relativa all’intensità luminosa dei vari punti dell’immagine), quella cromatica (cioè relativa al colore nei vari punti) e quella spaziale (cioè relativa alla distribuzione bidimensionale di tali grandezze).

Due caratteristiche dell’immagine digitale determinano l’accuratezza con cui essa rappresenta l’immagine ottica da cui è stata tratta.

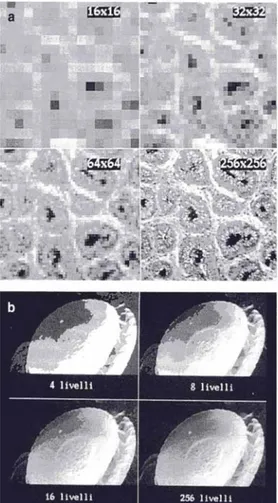

Figura 4-5: Aumento dell’accuratezza dell’immagine all’aumentare della risoluzione spaziale (a) e della risoluzione tonale (b).

La prima è la risoluzione spaziale ovvero la dimensione dei pixel di cui è composta. Il “teorema del campionamento” afferma infatti che possono essere risolti particolari non più piccoli di due volte la dimensione del pixel, per cui al diminuire di tale dimensione la rappresentazione diventa più accurata come illustrato in Figura 4-5 a. In Figura 4-5 b è invece mostrato l’effetto della cosiddetta risoluzione tonale dell’immagine digitale, cioè il numero massimo di livelli di grigio con cui l’intensità luminosa può essere codificata in ogni pixel: se tale numero è troppo basso può comparire un artefatto (presenza di falsi contorni), mentre l’accuratezza della rappresentazione aumenta all’aumentare ditale numero.

Una tipica immagine digitale monocromatica è costituita da 512x512 pixel, ove ogni pixel può assumere 256 livelli di grigio, il che corrisponde a un contenuto informativo pari a 262144 bytes. Un’immagine digitale di pari risoluzione spaziale, ma a colori, corrisponde (per quanto descritto prima) a 786432 bytes. Usando risoluzioni spaziali o tonali superiori tale valore naturalmente aumenta.

Le immagini digitali vengono per questo memorizzate dal sistema in un’area di memoria dedicata a esse (memoria video) e un’elettronica specifica (in genere integrata in una scheda video) ne permette la visualizzazione su un normale monitor televisivo. Il contenuto della memoria video normalmente viene gestito attraverso un particolare tipo di processore (array processor) in grado di manipolare a velocità elevata grandi matrici numeriche, quali sono appunto le immagini digitali. Il controllo dell’array processor, così come di tutte le altre parti del sistema è affidato a un microprocessore convenzionale (host computer) tramite un software appropriato.

La caratteristica più importante del software per questi strumenti è costituita dalla disponibilità di un’ampia libreria di funzioni con cui operare sulle immagini digitali [Fabbri, 1991].

Possiamo separare tali operazioni in tre grandi classi.

Vi sono innanzitutto operazioni di elaborazione dell’immagine (o di image processing) il cui risultato è sempre una nuova immagine digitale ricavata da quella di partenza tramite una qualche trasformazione. Gli algoritmi fondamentali per eseguire tali elaborazioni sono sostanzialmente di quattro tipi.

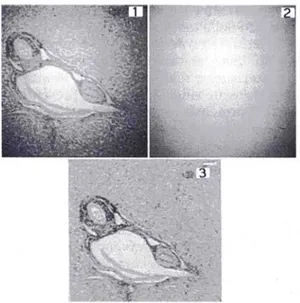

• Algoritmi puntuali, che modificano il valore di ogni pixel basandosi solamente sul valore che esso ha prima della trasformazione (talvolta anche sulla sua posizione). Sono gli algoritmi più semplici e probabilmente più frequentemente usati nel corso di una procedura di analisi di imma-gine.

Figura 4-6: Esempi di algoritmi puntuali. 1: Immagine originale. 2: Innalzamento del contrasto mediante normalizzazione dell’istogramma. 3: Inversione delle luminosità. 4: Operazione di soglia per l’estrazione della componente cellulare.

Un algoritmo di questo tipo è ad esempio quello di normalizzazione della distribuzione dei livelli di grigio di un’immagine, usato per aumentare il contrasto dell’immagine stessa (Figura 4-6). Esso trasforma l’immagine in modo che i livelli di grigio che la compongono occupino l’intero intervallo di valori disponibile: in pratica ciò si ottiene individuando i valori di grigio minimo e massimo presenti nell’immagine di partenza e trasformando il valore gr, di ogni pixel secondo la seguente

trasformazione lineare:

(

)

min max min 255 r r r r r g g g g g − ⋅ − = ′ove gr min e gr max sono i valori di grigio minimo e massimo nell’immagine di partenza e si assume

che la risoluzione tonale sia di 256 livelli di grigio.

Un importante algoritmo puntuale è l’operatore di soglia che converte a 0 (nero) i pixel il cui valore sia sotto una certa soglia e al valore massimo (bianco) quelli con valore superiore al valore di soglia. Tale algoritmo è spesso alla base di procedure mirate a estrarre dal contesto di un’immagine regioni aventi specifiche caratteristiche densitometriche.

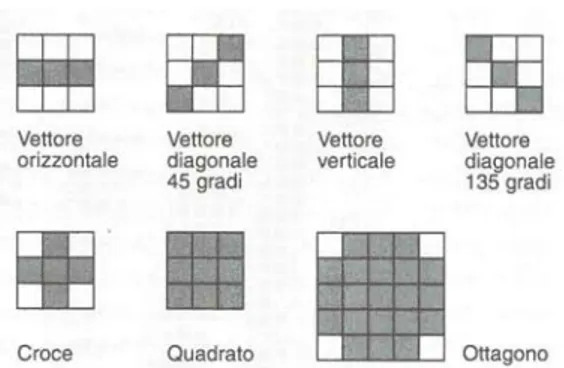

• Algoritmi locali, che usano i valori riscontrati in un gruppo di pixel per effettuare la trasformazione. Il gruppo di pixel utilizzato è, nella maggior parte dei casi, una matrice di dimensioni più o meno grandi avente come elemento centrale il pixel da trasformare. Tali algoritmi, pertanto, producono modifiche del livello di grigio in ciascun pixel dell’immagine di partenza sulla base del valore dei pixel a esso adiacenti.

Figura 4-7: Esempi di algoritmi locali. 1: Immagine originale. 2: Applicazione di un filtro passa-basso. 3: Operatore di Sobel per l’estrazione dei contorni. 4: Applicazione all’immagine precedente di un operatore di dilatazione mediante un elemento strutturale quadrato (3x3 pixel).

Un algoritmo di questo tipo è ad esempio la convoluzione, con il quale si realizzano i cosiddetti “filtri” (Figura 4-7), operazioni utilizzate per raggiungere vari obiettivi, quali ad esempio quello di eliminare la presenza di rumore dall’immagine, o di estrarre contorni di strutture ecc. Esso è così definito: il pixel centrale (con livello di grigio g,) viene modificato sulla base del valore di un certo numero di pixel circostanti (un intorno 3x3 in questo esempio) dalla formula:

iI hH fF eE xg dD cC bB aA gr′ = + + + + r + + + +

ove il valore assegnato ai coefficienti (a, ..., i) determina il risultato. Algoritmi di tipo locale particolarmente importanti sono gli operatori di erosione e di dilatazione (Figura 4-7). In questo caso il gruppo di pixel utilizzato per la trasformazione (detto “elemento strutturale”) può essere disposto secondo varie forme intorno al pixel da modificare (cfr. schema). Questo, dopo la trasformazione, assumerà il valore minimo (nel caso di erosione) o massimo (nel caso di dilatazione) tra quelli presenti nei pixel dell’elemento strutturale applicato. Queste due operazioni stanno alla base di tutta una classe di algoritmi più complessi, noti come operatori morfologici [Serra, 1982].

• Algoritmi geometrici, che, come illustrato in Figura 4-8, modificano la posizione o la disposizione dei pixel all’interno dell’immagine secondo alcune trasformazioni geometriche (rotazioni, riflessioni ecc.). Vengono utilizzati ad esempio per correggere eventuali aberrazioni spaziali presenti nei dispositivi di visualizzazione o per allineare in maniera precisa immagini che devono essere successivamente comparate.

Figura 4-8: Esempi di algoritmi geometrici. 1: Immagine originale. 2: Rotazione di 90 gradi. 3: Riflessione rispetto a un asse verticale. 4: Riduzione di scala.

• Algoritmi di combinazione, che (Figura 4-9) producono una nuova immagine a partire da due o più immagini digitali ricombinate opportunamente secondo modalità aritmetiche convenzionali o booleane. Esempi del loro utilizzo sono la sottrazione di background da un’immagine o la correzione di disomogeneità di illuminazione.

Questi algoritmi fondamentali possono essere concatenati per formarne di più complessi o per costruire procedure che conducano al riconoscimento (cioè all’estrazione dal contesto dell’immagine) delle strutture da misurare.

Figura 4-9: Esempio di algoritmo combinatorio (shading correction). 1: Immagine originale con notevole disomogeneità di illuminazione. 2: Immagine di un’area vuota nelle stesse condizioni di illuminazione. 3: Correzione della disomogeneità mediante sottrazione di 2 da 1 e ripristino della luminosità media originale.

Nella maggior parte dei casi ogni procedura di elaborazione dell’immagine finalizzata al riconoscimento di strutture che dovranno poi essere misurate consta di alcune fasi tipiche:

a) miglioramento dell’immagine (o “image enhancement”), in cui l’immagine viene modificata in modo tale che la nuova versione risulti più conveniente dell’originale ai fini dell’applicazione specifica. In tale fase, ad esempio, si aggiustano luminosità e contrasto, si rimuove rumore eventualmente presente, si accentuano o si riducono certe caratteristiche ecc.;

b) segmentazione dell’immagine (o “image segmentation”), in cui dall’immagine si estraggono le regioni effettivamente significative ai fini della specifica applicazione. Il risultato è in genere un’immagine cosiddetta binaria in cui le regioni di interesse appaiono come profili con un tono di grigio uniforme (normalmente bianco) su un fondo vuoto (normalmente nero). Esistono varie strategie disponibili (eventualmente combinabili tra loro) per raggiungere tale risultato e che ci limitiamo qui a nominare almeno in parte, rimandando alla letteratura specializzata per i dettagli: operatori di soglia (di cui si è già parlato), che segmentano l’immagine su base densitometrica, algoritmi di identificazione di contorni, tecniche di” accrescimento di regioni”, che suddividono l’immagine in regioni “omogenee” secondo un criterio predefinito, operatori morfologici e di deagglomerazione ecc.;

c) marcatura dei componenti (o “component labeling”), in cui ogni oggetto di un’immagine binaria, qualora si voglia misurarlo separatamente dagli altri, viene marcato con un’etichetta diversa (generalmente un livello di grigio).

La seconda classe di operazioni disponibile nel software di un analizzatore di immagini è costituita dunque dalle operazioni di valutazione.

Esse, a differenza delle operazioni di elaborazione dell’immagine, non hanno come risultato un’altra immagine, bensì dei numeri (come le stime dei vari parametri misurati) o delle decisioni logiche (relative ad esempio alla presenza o assenza di certe caratteristiche o alla classificazione in categorie degli oggetti misurati).

I parametri misurabili con questi strumenti sono fondamentalmente di due tipi: • parametri geometrici, quali quelli già descritti nella Tabella 4-1.

• parametri densitometrici, che forniscono una valutazione quantitativa delle caratteristiche tonali di aree di immagine digitale o di singole strutture presenti in essa. I principali parametri densitometrici sono elencati nella tabella successiva.

La terza classe di funzioni che consentono di operare sulle immagini digitali sono quelle grafiche. Attraverso tali operazioni è possibile sovrapporre all’immagine digitale, o inserire in essa, primitive

grafiche (quali linee, rettangoli, circonferenze, reticoli ecc.) oppure intervenire interattivamente a modificare il contenuto dell’immagine digitale stessa.

Il software per gli analizzatori di immagini digitali comprende poi un insieme di funzioni che non riguardano direttamente le immagini. Tra queste, ovviamente, tutte le funzioni per la gestione e l’elaborazione dei dati (calibrazione, memorizzazione, stampa, analisi statistica ecc.). Di particolare interesse è inoltre la possibilità, generalmente offerta su questi strumenti, di essere opportunamente interfacciati ai microscopi onde poterne gestire tramite software alcune funzioni, quali ad esempio la messa a fuoco e i movimenti del campione.

Un elemento importante del software è infine la cosiddetta interfaccia utente, ovvero l’insieme delle modalità attraverso cui l’operatore viene messo in grado di utilizzare quest’ampia libreria di funzioni. In genere essa è costituita da un grande menù (che appare sul monitor) dal quale l’opera-tore, tramite un dispositivo di puntamento (un mouse o un cursore su una tavoletta grafica), seleziona la funzione di interesse ne precisa eventuali parametri e la manda in esecuzione.

Da menù è inoltre possibile procedere a una prima, semplice, modalità di programmazione dello strumento. La sequenza di operazioni che l’utente seleziona ed esegue per arrivare a risolvere un determinato problema applicativo viene infatti registrata dallo strumento e, una volta messa a punto, l’operatore può memorizzarla su disco al fine di riutilizzarla ogni qual volta debba effettuare quello stesso tipo di analisi. Il massimo della flessibilità e delle prestazioni si ottiene comunque attraverso una programmazione convenzionale, in genere realizzabile tramite tutti i tradizionali linguaggi di programmazione (Basic, C, Pascal, Fortran) o tramite linguaggi funzionali specifici per la programmazione di applicazioni di analisi di immagine.

Si tratta, in conclusione, di strumenti estremamente flessibili, con i quali è possibile affrontare un’ampia gamma di problemi applicativi, e che consentono oggi, in molti casi, di concepire strategie di analisi completamente automatiche con notevoli vantaggi in termini di tempo e di oggettività delle procedure. C’è da dire, tuttavia, che si tratta di strumentazioni di uso non banale e che, quindi, per essere sfruttate appieno richiedono l’acquisizione di alcune competenze specifiche che spesso non fanno parte del curriculum formativo biomedico classico.

Livello medio di grigio GREYVA

Coefficiente di trasmissione TRASM = (GREYVA/MaxG1) x 100 Coefficiente di assorbimento 100 — TRASM

Densità ottica OD = — Log10 (1/TRASM)

Densità ottica integrata IOD = OD x AREA

4.1.2 I metodi per l’analisi delle immagini

L’ esistenza di strumenti di indagine flessibili e potenti è senza dubbio un aspetto importante per qualsiasi disciplina quantitativa. E tuttavia evidente che, al fine di estrarre in maniera corretta le informazioni desiderate. ancora più importante è la messa a punto di metodologie specifiche per il loro uso.

Negli ultimi decenni è venuto sviluppandosi un ampio insieme di metodi di indagine specifici per l’analisi di immagine. Sebbene una rassegna completa ditale corpus metodologico sia qui impossibile, cercheremo di puntualizzarne gli aspetti fondamentali, articolando la discussione attorno ad alcune metodologie di particolare interesse per la microscopia in campo biomedico. Prima di iniziare vale la pena di ricordare che anche nell’analisi di immagine, così come in tutte le discipline quantitative, vanno rispettati i criteri metodologici generali relativi al campionamento. Campionamento significa selezionare una piccola parte di un insieme di enti (ad es. un certo numero di soggetti, un certo numero di sezioni per soggetto ecc.) in modo tale che le osservazioni raccolte in questo “campione” siano rappresentative dell’intero insieme da cui questo è stato tratto.

1

Le modalità con cui predisporre un campione rappresentativo sono ampiamente descritte in letteratura: un eccellente riferimento bibliografico di base sul campionamento è ad esempio Stuart (1976).

4.1.2.1 Analisi dimensionale

L’analisi dimensionale, cioè la misura delle caratteristiche geometriche delle strutture visualizzate al microscopio, costituisce l’obiettivo di moltissime applicazioni di analisi delle immagini.

A questo proposito, tuttavia, c’è subito da osservare come in microscopia si abbia sempre a che fare con immagini piane di strutture in realtà tridimensionali.

In alcuni casi (colture cellulari, cellule in sospensione, inclusi in una matrice di spessore grande rispetto alle inclusioni stesse ecc.) tale immagine contiene le proiezioni delle strutture di interesse sul piano di osservazione: dalla misura di tali proiezioni è spesso possibile risalire immediatamente ad alcuni parametri geometrici (ad es. il diametro medio, la densità cellulare di una coltura ecc.) caratteristici degli oggetti analizzati.

Figura 4-10: Effetto dell’operazione di sezionamento di strutture tridimensionali: oggetti dotati di volume daranno luogo a profili bidimensionali (aree), superfici appariranno come profili monodimensionali (linee) e oggetti lineari formeranno profili zero-dimensionali (punti).

Nella maggior parte dei casi si ha invece a che fare con immagini delle sezioni attraverso il materiale oggetto dell’indagine (Figura 4-10). L’estrapolazione delle informazioni tridimensionali a partire da quelle bidimensionali è in questo caso più complessa e costituisce l’oggetto di un ramo della matematica applicata, detto stereologia, i cui metodi sono di fondamentale importanza nell’analisi delle immagini.

La stereologia ha le sue basi nella teoria della probabilità geometrica: più grande è il volume di un “componente” A o più frequentemente esso ricorre all’interno di un volume contenente (o “struttura” di riferimento) B, più probabilmente esso apparirà in una sezione casuale operata attraverso B. Le dimensioni relative dei profili bidimensionali di A rispetto a quelle dei profili di B osservate sulle sezioni saranno pertanto correlate alle dimensioni relative reali dei due oggetti.

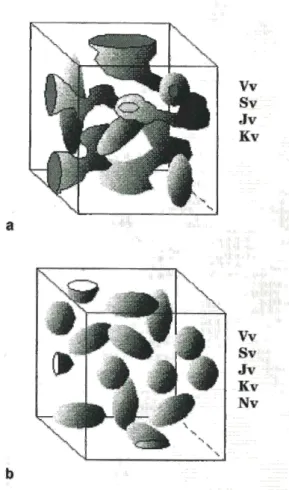

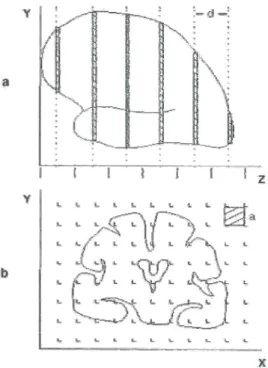

Figura 4-11: Modelli tessutali fondamentali della stereologia e parametri classicamente valutabili nei due casi.

Tali metodi sono applicabili quando sono soddisfatte alcune condizioni e cioè in tutte le situazioni che possiamo descrivere attraverso due modelli fondamentali (Figura 4-11):

nel primo modello (Figura 4-11 a) gli elementi che formano il componente da misurare sono uniformemente disposti all’interno del volume contenente, possono avere forma arbitraria ed essere variamente connessi; nel secondo modello (Figura 4-11 b) il componente è invece costituito da parti discrete disposte casualmente nel volume contenente.

I metodi stereologici partono sempre dalla misura di alcuni parametri relativi ai profili bidimensionali presenti in un insieme di sezioni indipendenti. Questi valori sono poi utilizzati nelle equazioni stercologiche per calcolare alcuni parametri relativi agli oggetti in quanto tali.

I parametri stereologici classici così ottenibili sono illustrati di seguito.

• Frazione di volume (VV,), che esprime la porzione di volume di riferimento occupata da un

determinato componente. La stima di tale parametro si basa su un principio, noto come “principio di Delesse”, in base al quale VV può essere calcolato tramite la seguente formula:

A

V A

V =

ove AA rappresenta il rapporto, misurato sull’immagine microscopica, tra l’area occupata dai profili

Figura 4-12: Valutazione della frazione di volume (Vv) mediante planimetria (a) e mediante “point counting” (b).

L’acquisizione dei dati necessari alla valutazione di VV, può essere fatta sia con dispositivi

computerizzati, nel qual caso vengono misurati direttamente i due valori di area necessari (Figura 4-12 a), che attraverso l’uso di sistemi di campionamento coerenti, quali quelli descritti precedentemente.

In questo caso (Figura 4-12 b) si tratta di rilevare il numero di punti del reticolo che cadono sui profili del componente (P(c)) e il numero di punti che cadono sull’intero volume di riferimento (P(r)). Si avrà:

( )

( )

r P c P A VV = A =• Densità di superficie (Sv), che descrive la quantità di superficie esibita da un componente per unità

di volume della struttura di riferimento. In sezione, la superficie del componente apparirà come pe-rimetro dei suoi profili ed è possibile dimostrare (Underwood, 1970) che vale la:

A V B S ⎟⋅ ⎠ ⎞ ⎜ ⎝ ⎛ = π 4

ove BA è il rapporto, valutato sull’immagine della sezione, tra il perimetro totale dei profili dovuti al

componente da misurare e l’area totale dovuta alla struttura di riferimento.

Anche SV può essere facilmente stimata, oltre che attraverso un approccio computerizzato con

valutazione diretta dei perimetri, mediante l’uso di sistemi di campionamento coerenti. In tal caso si tratta di contare il numero (1(c)) di intersezioni che i profili del componente in esame formano con le linee del reticolo e il numero (P(r)) di punti del reticolo che cadono nella struttura di riferimento. Da quest’ultimo dato è immediato stimare la lunghezza totale delle linee del reticolo sovrapposte alla struttura di riferimento (come descritto precedentemente, si ha L

( ) ( )

r =P r ⋅k1⋅d) e si applica infine la seguente relazione:( )

( )

L V I r L c I S =2⋅ =2⋅• Densità di lunghezza (JV), che esprime il rapporto tra la lunghezza di un componente

unidimensionale e il volume che lo contiene. Un oggetto di questo tipo in sezione apparirà costituito da profili puntiformi. Detto allora Q(c) il numero di tali profili e A(r) l’area generata dalla struttura di riferimento, si può dimostrare (Hennig, 1963) che si ha:

( )

( )

A V Q r A c Q J =2⋅ =2⋅• Densità di curvatura (KV), che esprime la curvatura media della superficie del componente

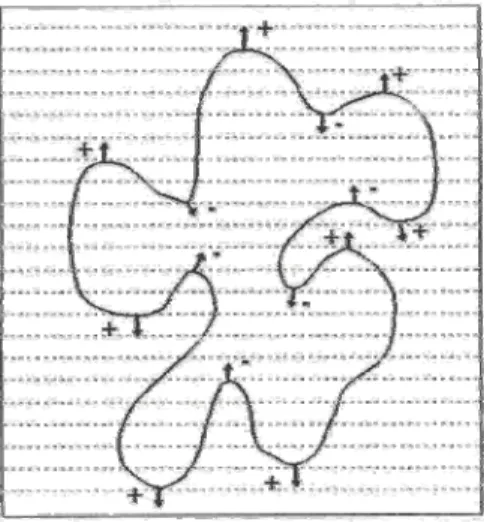

in esame per unità di volume della struttura di riferimento. Anche tale parametro può essere stimato, almeno in parte, a partire dalle sezioni attraverso il componente stesso. Si tratta in tal caso di contare il numero di tangenti (T) che il contorno dei profili del componente formerebbe con una linea orizzontale che percorresse l’intera immagine dall’alto al basso. Come illustrato in Figura 4-13, tali tangenti possono essere sia positive che negative, per cui si considera il conteggio netto dato da T(c) =T+-T-.

È possibile dimostrare (De Hoff e Cahn, 1967) che:

( )

( )

A V T r A c T K =π⋅ =π⋅Figura 4-13: Punti di tangenza sia positivi che negativi di un profilo con una linea orizzontale che scorre dall’alto verso il basso.

• Densità numerica di oggetti (NV), parametro valutabile nel caso il componente in esame sia

costituito da elementi discreti e che esprime la quantità di tali elementi per unità di volume della struttura di riferimento. Maggiore è tale densità, maggiore sarà il numero di profili per unità di area osservabili in sezione e, nello stesso tempo, maggiori saranno le dimensioni degli elementi da contare, maggiore sarà la probabilità che essi generino un profilo su una sezione casuale attraverso la struttura. E quindi intuitivo pensare che il numero di profili che si osserva per unità di area (NA)

sulla sezione dipenda sia dal numero di elementi per unità di volume che dalla loro dimensione. In effetti è possibile dimostrare (De Hoff e Rhines, 1961) che si ha:

D N

N A

V =

ove D rappresenta il diametro medio degli oggetti, quantità la cui stima può porre delle difficoltà per oggetti di forma arbitraria.

Un notevole avanzamento metodologico è stato, a questo proposito, l’introduzione di un metodo per la valutazione di NV, denominato disector (Sterio, 1984), che rimuove tali difficoltà, essendo

indipendente dalla forma e dalle dimensioni degli elementi da contare. Esso consiste nel considerare due sezioni parallele attraverso la struttura da analizzare, poste a una distanza d tra loro, inferiore alla dimensione tipica degli oggetti di cui valutare la densità numerica (1/3 o 1/4 di tale dimensione). Presa una di queste come sezione di riferimento e definita un’area di conteggio (in genere mediante un frame quadrato di area A) si conta il numero di elementi che generano un profilo in tale area, ma non nell’area corrispondente dell’altra sezione. Tale valore convenzio-nalmente chiamato Q-, consente di calcolare NV tramite la seguente formula:

d A Q NV ⋅ = −

Tutti i metodi fin qui descritti (ad eccezione del disector) partono dall’ipotesi che le misure siano state ottenute su sezioni ideali di spessore nullo. Tale condizione, ovviamente, non si realizza mai nella realtà e dà luogo a un errore noto come effetto Holmes, che consiste in una sovrastima (dovuta allo spessore finito della sezione) dell’area dei profili generati dal componente in esame.

Tale errore può essere reso trascurabile utilizzando sezioni di spessore sufficientemente piccolo (almeno 10 volte) rispetto alle dimensioni tipiche della struttura analizzata.

Esso può eventualmente essere corretto applicando opportuni fattori di correzione (ampiamente descritti in letteratura) basati su approssimazioni circa la geometria dei profili e sullo spessore delle sezioni utilizzate.

L’effetto Holmes può essere in pratica ignorato anche nel caso si sia interessati solo a valutazioni comparative tra situazioni sperimentali in ciascuna delle quali esso pesa allo stesso modo.

Una seconda difficoltà può nascere dall’ipotesi di distribuzione omogenea del componente da valutare all’interno della struttura di riferimento. In biologia esistono molte strutture che presentano ben definite disposizioni e orientazioni nello spazio, che, se non considerate, possono essere alla base di stime non corrette dei parametri stereologici.

Il superamento di tale difficoltà si ha solamente attraverso un aggiustamento delle procedure di campionamento.

Nell’ultimo decennio sono state sviluppate strategie di sezionamento e campionamento particolarmente efficienti in questi casi, quali i metodi di generazione di sezioni isotrope o il metodo delle sezioni verticali. Essi sono ben documentati in letteratura alla quale si rimanda per una descrizione (per esempio Reith e Mayhew, 1988 o Mayhew, 1992).

Un’ulteriore osservazione da fare è che tutti i parametri stereologici classici sono delle densità, cioè dei valori relativi. In molti studi comparativi questo modo di esprimere i risultati della misura è tuttavia insoddisfacente, in quanto può accadere che nelle diverse situazioni sperimentali cambino sia il valore del numeratore che del denominatore del rapporto e quando ciò avviene la comparazione delle densità è priva di significato. Questo critico problema di interpretazione fu notato già da Loud negli anni ‘60 [Loud et al., 1965] e portò allo sviluppo di strategie per la stima di parametri dimensionali assoluti.

Figura 4-14: Illustrazione del principio di Cavalieri, a:L’oggetto da misurare viene sezionato sistematicamente con sezioni separate da una distanza d. La posizione della prima fetta deve essere scelta in maniera casuale tra O e d. b: L’area della faccia posteriore di ogni sezione viene quindi valutata mediante planimetria o mediante “point counting” dato che ogni punto del reticolo applicato corrisponde a un’area a (indicata dal quadratino tratteggiato). Il volume dell’oggetto sarà infine dato da V =

∑

Ai⋅d , ove Ai sono i valori di area così misurati.A questo scopo distinguiamo due approcci possibili.

• Metodi diretti. Vi sono importanti parametri valutabili direttamente. È questo il caso, ad esempio, del volume di un oggetto. Questo può infatti essere stimato sfruttando il cosiddetto principio di Cavalieri come schematizzato in Figura 4-14.

Il volume medio di una popolazione cellulare può essere anch’esso determinato direttamente tramite alcuni metodi recentemente proposti, quali il selector [CruzOrive, 1987], o il nucleator [Gundersen, 1988] anch’essi basati sull’uso di un insieme di sezioni seriali.

Metodi diretti possono essere considerati anche le cosiddette procedure di “unfolding” proposte da Wicksel negli anni ‘20 [Weibel, 1979] attraverso le quali è possibile ricavare la distribuzione dei diametri di un insieme di oggetti a partire dalla distribuzione dei diametri dei profili da essi generati in sezione. Il limite di tali procedure consiste nel fatto che esse si basano su precise ipotesi riguardanti la forma (sfere, ellissoidi ecc.) degli oggetti in esame, ipotesi che raramente ben approssimano la situazione reale.

Un metodo (il fractionator) per la stima diretta del numero di oggetti presenti in una determinata regione è stato proposto nel 1986 da Gundersen. L’idea base è quella di partire con l’intera popolazione di elementi da contare e di suddividerla in maniera completamente arbitraria in blocchi praticamente uguali. Una frazione nota (1/f di tali blocchi viene sezionata in maniera esaustiva e per ricavare il numero di elementi in ogni blocco si procede contando in ogni sezione del blocco gli oggetti che non sono presenti nella sezione successiva. Chiaramente, f volte il numero di oggetti contato tra tutti i blocchi selezionati costituirà la stima cercata del numero totale di elementi nella regione analizzata. Le modalità con cui ottimizzare tale procedura sono ampiamente discusse nella letteratura specializzata.

• Metodi indiretti. Tutti i parametri come superfici, lunghezze, curvature ecc. possono comunque essere stimati in maniera indiretta a partire dalle loro densità una volta noto il volume della struttura di riferimento. Questo o è misurabile direttamente o si può procedere alla sua stima mediante un approccio costituito da un campionamento gerarchico, quale quello schematizzato in Figura 4-15.

Figura 4-15:Esempio di impostazione gerarchica di uno studio morfometrico per la valutazione indiretta di parametri dimensionali assoluti di componenti tessutali.

4.1.2.2 Analisi della forma

Il problema di caratterizzare in maniera quantitativa la forma dei profili bidimensionali di una struttura vista in sezione o in proiezione viene tuttora spesso affrontato utilizzando un semplice approccio parametrico basato sulla stima di quantità adimensionali chiamati fattori di forma. Sebbene la loro utilità pratica sia evidente in molte situazioni applicative, essi vanno considerati solo come indicatori di alcuni aspetti della geometria di un oggetto (ad es. il suo grado di non circolarità, di convoluzione ecc.), e non delle vere e proprie descrizioni della sua forma. Sebbene, infatti, tali parametri possano descrivere, anche in maniera efficiente, variazioni di forma subite da una struttura, è anche evidente (Figura 4-16) che profili aventi forma palesemente diversa possono avere fattori di forma pressoché identici.

Figura 4-16: Oggetti di forma palesemente molto diversa, ma caratterizzati dallo stesso valore di un classico fattore di forma (il fattore di circolarità).

La caratterizzazione della forma di un profilo è in gran parte ancora un problema aperto, anche se alcuni validi approcci metodologici, richiedenti tutti l’uso di strumenti computerizzati di analisi, sono emersi in tempi recenti. Possiamo dividere tali metodologie in due tipi di procedimento fonda-mentali, la cui scelta dipende dal tipo di oggetti da esaminare e anche da altri fattori quali il costo computazionale richiesto.

• Metodi di scomposizione. La filosofia generale di questi metodi è quella di descrivere la forma di un oggetto complesso scomponendolo in configurazioni elementari.

Figura 4-17: Estrazione dell’albero delle concavità. Sopra: a partire dal calcolo dell’involucro convesso minimo di un oggetto è possibile estrarre le concavità del primo ordine, che, sottoposte alla stessa elaborazione

forniranno le concavità di secondo ordine e così via. Sotto: albero delle concavità, che esprime il risultato della decomposizione; come si può vedere, oggetti con piccole differenze di forma possono dare origine ad alberi delle concavità molto diversi.

Uno dei primi approcci di questo tipo fu la determinazione dell’albero delle concavità [Batchelor, 1979], valido per oggetti non convessi. Tale metodo (Figura 4-17) si basa sul calcolo dell’involucro convesso minimo di un oggetto complesso. Ciò consente di individuare ed estrarre le concavità che, considerate oggetti a sé stanti, vengono a loro volta elaborate allo stesso modo. Il risultato è un grafo con struttura ad albero: come si riconosce dall’esempio in Figura 4-17, piccole differenze di forma possono condurre a vistose differenze nell’albero risultante. I parametri topologici del grafo possono dunque essere usati per caratterizzare la forma analizzata.

Tecniche più recenti sono invece quelle basate sui principi della morfologia matematica e sull’uso degli operatori morfologici digitali. Esse consistono nel calcolo di opportune (ad es. devono essere quantità indipendenti dalla dimensione dell’oggetto) funzioni morfologiche su un oggetto bidimensionale [Chermant et al., 1987]. Tali funzioni esprimono variazioni subite dall’oggetto quando viene sottoposto a gradi crescenti di erosione e/o dilatazione mediante elementi strutturali noti. Una volta ottenute, e possibile derivare da esse un insieme di parametri (ad es. i momenti di vario ordine) da usare come descrizione quantitativa della forma di quell’oggetto.

• Metodi di analisi del contorno. Si tratta di metodologie che richiedono l’acquisizione delle coordinate dei punti che formano il contorno della struttura da analizzare. Tali valori, dopo essere stati opportunamente normalizzati per renderli indipendenti dalla dimensione dell’oggetto, vengono sottoposti ad algoritmi mirati a ricavare una descrizione analitica della curva che costituisce il contorno in esame.

La maggior parte di tali procedure utilizza l’analisi armonica di Fourier, che consente di decomporre un segnale complesso (in questo caso la curva irregolare che costituisce il contorno di un profilo) in una serie di curve sinusoidali (le armoniche) ciascuna delle quali descrive un aspetto elementare del segnale di partenza. Il numero di armoniche che compone tale serie è teoricamente infinito. Nella pratica, tuttavia, solo le prime 10 armoniche della serie hanno un’utilità per descrivere la forma: ampiezza e fase delle prime 4 veicolano informazioni relative alla forma fonda-mentale dell’oggetto, mentre le successive 6 descrivono le irregolarità più minute del profilo.

Figura 4-18: Analisi della forma mediante analisi del contorno. Schema della procedura utilizzata dal sistema SAM (Shape Analytical Morphometry).

Una parte significativa, l’analisi di Fourier, la gioca anche nel raffinato approccio multiparametrico proposto da Pesce Delfino e collaboratori [Pesce Delfino et al., 1992]. In tale metodo (schematizzato in Figura 4-18) in una prima fase si determina (mediante regressione polinomiale applicata separatamente alle coordinate x e y dei punti del contorno) la forma fondamentale del profilo (cioè un nuovo contorno che approssima quello originale introducendo un effetto di smoothing): un primo set di parametri che descrivono la distorsione totale della figura può così essere ottenuto. Nella seconda fase l’analisi di Fourier viene applicata alla curva che si ottiene dalla differenza tra la curva originale e quella fondamentale: le ampiezze e le fasi delle prime 15-20 armoniche rappresentano il secondo set di parametri descrittori delle caratteristiche fini del profilo.

Un algoritmo alternativo a quello di Fourier è quello indicato da Puccio e collaboratori [Puccio et al., 1992], che ricavano la descrizione analitica del contorno mediante approssimazione con splines cubiche. Anche tale tecnica (meno onerosa in termini di calcolo) fornisce come risultato un insieme di parametri per descrivere la forma analizzata.

Sviluppi promettenti nel campo dell’analisi della forma potranno inoltre derivare dall’applicazione della geometria frattale.

4.1.2.3 Ricostruzione tridimensionale

Le tecniche di ricostruzione tridimensionale, rese facilmente accessibili dai moderni sistemi computerizzati per l’analisi di immagine, sono uno strumento che certamente non si presta a un uso routinario, ma che è di grande utilità qualora sia necessario visualizzare l’architettura di una strut-tura, studiare le relazioni spaziali tra i suoi componenti e misurarne direttamente Caratteristiche geometriche, come superfici e volumi.

Sebbene raffinate metodologie di ricostruzione a partire da proiezioni, cioè da immagini prese a diversi angoli di osservazione, siano state proposte [Radermacher, 1988; Lanzavecchia et al., 1993] e utilizzate in microscopia elettronica, le tecniche maggiormente diffuse sono quelle che fanno uso di sezioni seriali [Cookson e Whimster, 1993].

Queste constano tutte di alcuni passi fondamentali.

• Allestimento delle sezioni. Il punto di partenza sono le sezioni seriali attraverso la struttura da ricostruire: in microscopia si tratta normalmente di sezioni fisiche (ottenute al microtomo o all’ultramicrotomo) o di sezioni ottiche (come avviene in microscopia confocale). Qualunque sia la metodologia di sezionamento utilizzata è comunque necessario valutare accuratamente la distanza tenuta tra i piani di sezione: tale parametro determina infatti sia la risoluzione ottenibile in direzione perpendicolare al piano di sezione, che l’accuratezza del risultato finale.

• Allineamento delle sezioni. L’insieme delle immagini bidimensionali relative alle varie sezioni va quindi allineato in modo che i componenti della struttura mantengano le corrette relazioni tridimensionali. Ciò può essere fatto sfruttando punti di riferimento interni che non cambiano nel passaggio da una sezione all’altra o marker introdotti appositamente nel campione (corpi estranei, fori ottenuti con un laser ecc.). I software disponibili per la ricostruzione generalmente mettono a disposizione delle procedure che facilitano questa operazione, traslando e ruotando le immagini in base alle posizioni di punti di riferimento che l’operatore indica tramite un dispositivo di puntamento (un mouse, un cursore o una penna ottica).

Alcuni programmi più sofisticati consentono anche l’esecuzione di procedure automatiche di allineamento basate su algoritmi di cross-correlaziOne tra le immagini.

• Acquisizione dei dati. I dati necessari alla ricostruzione dipendono dal tipo di ricostruzione che verrà poi effettuata.

Una prima classe di tecniche richiede fondamentalmente l’individuazione dei contorni delle strutture di interesse. Questi possono essere tracciati dall’operatore o essere il risultato di operazioni di image processing finalizzate alla loro estrazione dal contesto di un’immagine digitale.

Una seconda classe di tecniche esige invece che dalle immagini (digitali) vengano estratti i profili delle strutture da ricostruire con l’intera gamma di toni di grigio con cui appaiono; ciò al fine di un tipo di ricostruzione più complessa finalizzata a ricostruire non solo le caratteristiche morfologiche, ma anche quelle densitometriche della struttura.

Figura 4-19: Ricostruzione tridimensionale ottenuta da sezioni seriali attraverso un encefalo di ratto. Con due diverse modalità di visualizzazione sono rappresentate la superficie esterna del cervello (soli contorni) e la struttura dell’ippocampo (ombreggiatura).

• Modellazione. In questa fase i dati bidimensionali ottenuti in ogni sezione vengono integrati tra loro per formare il modello tridimensionale della struttura esaminata [Cookson e Whimster, 1993]. Il risultato (Figura 4-19) viene visualizzato su un monitor, con modalità di resa delle superfici e dei volumi definibili dall’operatore. Le modalità principali sono schematizzate nella tabella successiva. Il modello tridimensionale è una rappresentazione dei dati che consente, naturalmente, rotazioni della struttura ricostruita per consentirne l’osservazione da vari punti di vista, nonché procedure di valutazione quantitativa di superfici e volumi.

Nelle modalità di ricostruzione che sfruttano l’intera gamma dei toni di grigio, il modello risultante è una vera e propria immagine digitale tridimensionale, nel senso che la struttura ricostruita non è altro che una matrice tridimensionale di valori di grigio ciascuno corrispondente a un elemento di volume elementare (detto voxel): le dimensioni ditale matrice determinano la risoluzione della ricostruzione. Su tali oggetti è possibile operare anche sezioni virtuali arbitrarie che consentono di esplorare l’interno della struttura ricostruita.

Tabella 4-2: Riepilogo

Modalità Descrizione Contorni Vengono visualizzati, in corretta relazione spaziale, tutti i

con-torni dei profili bidimensionali acquisiti.

Wire frame Le superfici esterne delle strutture ricostruite vengono rappre-sentate mediante una rete a maglie di larghezza definibile, con o senza rimozione delle linee nascoste.

Surface Le superfici esterne delle strutture ricostruite appaiono di colo-re compatto con sovrapposte curve di livello.

Ombreggiatura La tridimensionalità delle superfici ricostruite viene resa con appropriate ombreggiature rispetto a una sorgente luminosa virtuale in posizione definibile.

Trasparenza La resa delle superfici avviene con la tecnica

dell’ombreggiatura, ma immaginandole trasparenti: eventuali oggetti sottostanti risultano così visibili.

4.1.2.4 Analisi della distribuzione spaziale di oggetti

La caratterizzazione quantitativa della citoarchitettura di un campione biologico è un problema che richiede l’analisi del modo con cui un insieme di elementi discreti si dispone nello spazio. Tale problema è affrontabile seguendo due approcci fondamentali.

• Approccio statistico. Le linee generali delle metodologie di questo tipo sono state descritte ampiamente in letteratura [Diggle, 1983]. Esse partono tutte dall’acquisizione delle coordinate degli oggetti che costituiscono la popolazione da analizzare rispetto a un sistema di riferimento anatomi-camente consistente.

Tali valori di posizione vengono poi utilizzati per quantificare una serie di caratteristiche dell’insieme di oggetti, quale ad esempio la distanza media tra i punti, parametro che può essere utilizzato per verificare quanto la distribuzione nello spazio degli oggetti in esame si discosti da una distribuzione puramente casuale o per confrontare tra loro le distribuzioni di due tipi di oggetti nella stessa regione anatomica [Diggle, 1986].

Su questa linea di sviluppo si collocano anche le metodologie fondate sulla cosiddetta stereologia del secondo ordine estensivamente studiata dalla scuola tedesco-orientale [Stoyan et al., 1987]. Tali approcci conducono alla stima di una serie di funzioni stocastiche (funzioni K, pair correlation functions ecc.) che consentono di descrivere sinteticamente la disposizione di strutture nello spazio. Un insieme di strumenti pratici per l’analisi delle distribuzioni spaziali di elementi è quello proposto da Zoli e collaboratori [Zoli et al., 1992] e diretto alla caratterizzazione quantitativa di aspetti quali l’estensione della regione anatomica interessata dalla popolazione in esame, il grado di uniformità della distribuzione degli oggetti in tale area, l’identificazione di eventuali raggruppamenti e l’entità di coesistenza di due popolazioni.

Figura 4-20: a: Popolazione serotoninergica del nucleo dorsale del rafe a due diversi livelli anatomici.

Identificazione del profilo dell’area interessata dalla popolazione cellulare. b: Modalità di calcolo dell’indice di Gini (o concentration ratio) a partire dalla distribuzione bidimensionale (o griglia delle densità) dei centri di gravità dei profili.

In Figura 4-20 a è ad esempio illustrata una delle procedure proposte per l’individuazione dell’area occupata dalla popolazione di elementi. Questa viene scandita per settori angolari (centrati nel baricentro dell’intera popolazione) di ampiezza opportuna e in ogni settore si considerano le coordinate dei punti che cadono in esso. Mediante tali coordinate è possibile calcolare la proiezione di ogni punto sulla bisettrice del settore e individuare su tale bisettrice il punto che lascia al suo interno il 95% delle proiezioni. L’insieme ditali punti costituisce una poligonale chiusa che individua l’area cercata, della quale è semplice calcolare i parametri geometrici fondamentali.

Il grado di uniformità può invece essere stimato mediante il cosiddetto indice di Gini, il cui calcolo è schematizzato in Figura 4-20 b. Tale parametro vale 0 per una distribuzione rigorosamente uniforme e tende a i quanto più la distribuzione è raggruppata.

• Approccio morfologico. Operazioni di tipo morfologico su immagini digitali sono invece alla base di questo secondo tipo di strategie.

Figura 4-21: Schema di calcolo dell’indice di uniformità. Gli N profili vengono ridotti a elementi circolari di raggio r posti nel centro di gravità. Tali elementi vengono sottoposti a K-1 dilatazioni, ove K è il numero di dilatazioni necessario a fondere tra loro tali elementi qualora fossero distribuiti uniformemente. Il numero N’ di oggetti distinti a questo punto identificabile viene utilizzato per il calcolo dell’indice.

Mediante l’adeguata applicazione di operatori di erosione e dilatazione è possibile infatti identificare raggruppamenti di oggetti all’interno di una popolazione o calcolare parametri atti a caratterizzare il grado di uniformità con cui gli elementi si distribuiscono nella regione analizzata, come esemplificato in Figura 4-21.

Un approccio di tipo morfologico allo studio della citoarchitettura può essere considerato. In tale metodologia una regione viene campionata esaustivamente campo per campo ad alto ingrandimento e in ogni campo viene misurata la frazione di area occupata dalle strutture oggetto dell’indagine. L’insieme ditali valori viene quindi utilizzato per produrre una mappa digitale della regione scandita: i livelli di grigio in ogni punto di tale immagine sono proporzionali al valore del parametro misurato in quel punto. Si ha così sia un’immediata percezione del modo con cui gli elementi analizzati si distribuiscono nella regione, sia la possibilità di elaborare ulteriormente la nuova im-magine al fine di estrarre caratteristiche quantitative relative a tale distribuzione.

4.1.2.5 Analisi densitometrica

Scopo dell’analisi densitometrica è l’estrazione, in forma quantitativa, delle caratteristiche tonali (o cromatiche) presenti in un’immagine. Queste, infatti, veicolano spesso informazioni di carattere compositivo.

La quantità di luce (di una data lunghezza d’onda) assorbita da un campione è ad esempio direttamente proporzionale alla massa o alla concentrazione della sostanza responsabile dell’assorbimento (legge di Lambert-Beer). Analoghe relazioni esistono spesso per emissioni fluorescenti e osservazioni in luce riflessa o per le intensità di alcuni segnali ottenibili in microscopia elettronica a scansione.

Si è già osservato che l’estrazione dell’informazione densitometrica mediante tecniche di analisi d’immagine richiede la digitalizzazione dell’immagine e può pertanto essere effettuata soltanto con strumenti che consentano tale tipo di approccio.

Da un punto di vista metodologico vanno fatte, a questo proposito, alcune osservazioni.

Si può innanzitutto dire che il livello di grigio assunto da un pixel dopo il processo di digitalizzazione dipende da una molteplicità di fattori, uno solo dei quali è costituito dalle caratteristiche del campione osservato. L’intensità luminosa trasmessa attraverso il preparato o emessa da esso, viene infatti innanzitutto convertita in un segnale elettrico da un rivelatore (ad es. una telecamera), segnale successivamente digitalizzato dal convertitore analogico-digitale. A ognuno di questi passaggi possono essere introdotte delle non linearità nella relazione tra le luminosità presenti nell’immagine ottica e i livelli di grigio finali dell’immagine digitale.

È pertanto fondamentale per una corretta valutazione densitometrica un’attenta calibrazione del sistema di analisi.

A questo scopo l’attenzione va rivolta innanzitutto alla telecamera. Per applicazioni densitometriche questa deve essere caratterizzata da una risposta stabile e pertanto bisogna assicurarsi che eventuali dispositivi elettronici di controllo automatico del guadagno o della sensibilità siano disattivati.

Figura 4-22: Correlazione tra misure microdensitometriche mediante analisi di immagine e parallele valutazioni mediante fotometria eseguite su un preparato istochimico osservato in luce trasmessa.

In secondo luogo è necessario operare tre correzioni fondamentali.

• In primo luogo si tratta di far coincidere il 100% di trasmittanza con la risposta massima fornita dal sistema di acquisizione dell’immagine. Ciò si ottiene inquadrando un’area di massima luminosità e aggiustando l’illuminazione fino a ottenere in quell’area il livello di grigio massimo.

• In secondo luogo si tratta di calibrare il sistema sull’intensità nulla, ad esempio interponendo tra il sensore e il campione un oggetto opaco e aggiustando l’output del sistema al valore 0.

• Infine si tratta di rendere lineare la risposta sull’intera gamma di luminosità. Ciò avviene automaticamente se la telecamera utilizzata è di per sé caratterizzata da una buona linearità di risposta o può essere effettuato utilizzando standard di densità ottica nota [Baldock e Poole, 1993]. Seguendo un’accurata procedura di calibrazione è possibile osservare (Figura 4-22) un’ottima correlazione tra le misure effettuate mediante densitometria e mediante una tecnica di riferimento quale la fotometria. Se l’approccio fotometrico presenta senza dubbio maggior sensibilità e preci-sione, la strategia densitometrica presenta, rispetto a esso, il notevole vantaggio di consentire la