Capitolo 1

IL PROGETTO SPADA:

NUOVI ORIZZONTI

DELL’ASTRONOMIA

L’indagine della volta celeste e dei fenomeni che vi hanno luogo ha, fin dall’antichità, stimolato la curiosità dell’uomo, di scienza e non; il primo ricercava nella volta celeste risposte ad un imperscrutabile Disegno Divino, le leggi che governavano l’universo, l’origine del mondo e del tempo. L’altro vi ritrovava riscontri divini, fascinose costellazioni e, non da ultime, fervide ispirazioni che hanno dettato pagine e versi di singolare bellezza.

E’ al XVI secolo, con la rivoluzione copernicana, che si può far risalire la nascita dell’astronomia moderna, che vede succedersi, nell’esplorazione di questo universo così seducente, personalità illustri quali Keplero, Galilei, Newton. Ed è a quest’epoca che nasce, con l’utilizzo del cannocchiale in ambito astronomico, anche il sodalizio tra questa scienza e la tecnologia.

E’ proprio nell’ottica di una corretta e più approfondita indagine dei fenomeni stellari, che nasce l’esigenza di ricercare, nell’ampio ventaglio delle possibilità che la tecnologia al giorno d’oggi offre, quelle che maggiormente rispondono ai requisiti richiesti. In quest’ambito si colloca il progetto di ricerca ˝Development of Monolithic PHOTON-COUNTER ARRAYS for TRANSIENT HIGH-ENERGY PHENOMENA and ADAPTIVE OPTICS in ASTROPHISICS1˝, che ha come scopo la realizzazione di un sistema innovativo per:

1

¾ l’acquisizione di radiazioni elettromagnetiche nella banda del visibile; ¾ la possibilità di ridurre le distorsioni focali introdotte dall’atmosfera;

¾ lo studio delle proprietà ottiche nonché di quelle fisiche dei vari strati che compongono quest’ultima.

Nel presente capitolo si descrivono brevemente le tre applicazioni astronomiche appena citate e si prende visione del sistema SPADA.

1.1 Astronomia: cenni storici

Le origini dell’astronomia presso i popoli primitivi si confondono con quelle della civiltà e della religione. Non è tuttavia da pensare che la psiche collettiva degli aggregati umani abbia dovunque reagito in eguale misura, e con effetti tra loro paragonabili, alle impressioni suscitate dalla vista del cielo stellato e dalla contemplazione dei movimenti regolari che vi si osservano.

E’ ai Babilonesi che si deve la divisione del cielo in costellazioni nonché la creazione dei primi semplici quanto preziosi strumenti per lo studio astronomico, che si limitava, a quell’epoca, a stabilire la posizione dei diversi corpi nella volta celeste. E già circa 5000 anni fa i Cinesi poterono ideare un calendario di 365 giorni basandosi solo sull’osservazione del Sole ad occhio nudo. Fu anche loro il merito di scoprire che cinque stelle si muovevano rispetto alle altre costellazioni che invece rimanevano fisse. I Greci chiamarono queste stelle astères

planètai che significa “stelle vaganti” da cui l’attuale nome pianeti (vaganti). Ed è figlia di questa

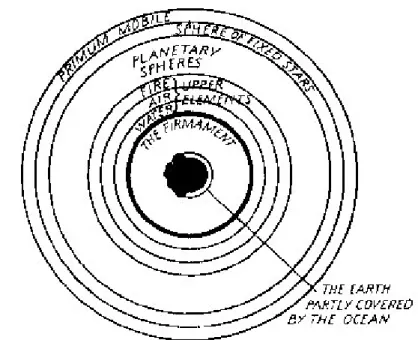

civiltà la teoria che per secoli fu di riferimento agli studiosi di astronomia: quella Tolemaica. Già precedentemente Anassimandro, dimostrando un ingegno profondo ed originale, aveva affermato che la terra occupava, isolata e senza alcun sostegno, il centro dell’universo, e aveva riconosciuto il continuo cambiare del parallelo diurno solare e il moto spirale tra i due tropici come risultato del moto diurno della rotazione celeste, combinato con il moto annuo del Sole tra le stelle in un cerchio obliquo. Non si può, infine, fare un rapido salto nel tempo senza ricordare la teoria delle sfere omeocentriche completata da Aristotele e Callippo; questa teoria tenne il campo fino al tempo in cui, ad opera di Ipparco prevalentemente, invalse la teoria degli eccentri e degli epicicli, molto meno elegante, quanto più atta però a dare spiegazione dei fenomeni celesti.

Fig. 1.1 : L’universo di Aristotele secondo uno scrittore medioevale.

Nel XV secolo inizia il grande movimento riformatore iniziato da Copernico e in cui si inquadrano le eccellenti figure di Brahe, Keplero, Galilei e Newton. Nei secoli successivi, gli studi condotti sulla volta celeste saranno basati tutti sull’opera newtoniana “Philosophiae naturalis

principia matematica”, e ancora ai nostri giorni nessuna concezione teoretica, è stata seriamente

opposta alle sue. Né si può affermare che le nuovissime idee sulla relatività e sulla meccanica quantistica abbiano scalzato dalle fondamenta l’edificio galileiano e newtoniano che, nella peggiore delle ipotesi, rimarrà ancora lungamente a modello di un’approssimazione largamente sufficiente nel maggior numero dei casi, e certamente, in tutti quei casi che l’astronomia studia.

Fig. 1.2 : a ) 1672 : Telescopio di Newton.

1.2 Le tre applicazioni astronomiche

Si descrivono, di seguito, le tre applicazioni astronomiche, alla cui realizzazione è rivolto il progetto SPADA:

¾ acquisizione veloce delle immagini da processare, mediante un sistema di Fast Transient Imaging (FTI)

¾ compensazione delle distorsioni introdotte dall’atmosfera, tramite un sistema di ottica adattiva (AO)

¾ analisi degli strati che compongono l’atmosfera, tramite degli esperimenti di layer sensing (LS)

1.2.1

Fast Transient Imaging

Anche se spesso osservando il cielo si avverte una sensazione di immutabilità ed eternità, ognuno di noi è perfettamente cosciente che si tratta di una sensazione fallace: l’universo, come tutto in natura, è in continua evoluzione, e ciò significa che in ogni momento si creano nuove galassie all’interno delle quali nuove stelle nascono, vivono e muoiono per dare vita a nuove entità.

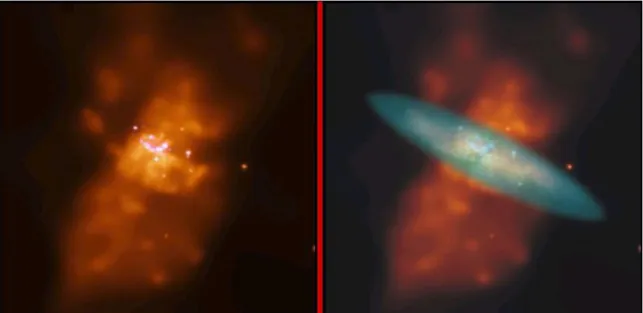

Fig. 1.3 : La M82, galassia situata a 11 milioni di anni luce dalla nostra, è costituita da stelle di notevole massa che nascono e muoiono ad una velocità dieci volte maggiore rispetto a quanto osservabile nella Via Lattea. Da ciò scaturisce il numero elevato di supernovae in essa osservabili.

L’apparente immobilità cui assistiamo è dovuta ai lunghissimi tempi necessari perché tutto ciò avvenga; tuttavia tale staticità è, seppur raramente, interrotta da eventi strepitosi quali l’accensione repentina di astri di luminosità eccezionale e la sua scomparsa dopo alcuni giorni o mesi. Questo evento chiamato dagli astronomi supernova, costituisce, secondo la corrente teoria dell’evoluzione stellare, la conclusione della vita di stelle aventi masse (finali) pari a circa 1,4 volte quella del Sole.

L’intera esistenza di una stella è legata all’azione contrapposta della forza gravitazionale, che tende a far collassate la stella su se stessa, e la forza esercitata dalla pressione della radiazione prodotta all’interno che tende a farla espandere. Tale radiazione è prodotta dalle reazioni nucleari che avvengono nel nucleo stellare (più propriamente denominato core). Quando queste reazioni si esauriscono la gravità prende il sopravvento sull’equilibrio stellare ed in questa fase il nucleo si contrae raggiungendo densità elevatissime: si crea così una nana bianca, o se la massa della stella è elevata la contrazione continua fino a dare origine ad un buco nero. La stella in pochi istanti precipita sul proprio nucleo che ha ormai raggiunto densità elevatissime ed il violento impatto che ne deriva produce un’onda d’urto generando un’esplosione che coinvolge la maggior parte della materia che costituisce la stella, la quale viene espulsa a grandissima velocità.

Fig 1.4 : a ) Crab Nebula ( Nebulosa Del Granchio ): rappresenta il residuo fossile di una esplosione di supernova avvenuta nel 1054.

Questo provoca un immane rilascio di energia sull’intera banda elettromagnetica, dalle onde radio ai raggi gamma, che trasporta con sé una mole notevole di informazioni di interesse rilevante per gli astronomi. La rapidità con la quale avvengono questi ed altri fenomeni astronomici, nonché la loro stessa rarità, fanno nascere l’esigenza di disporre di apparecchiature per l’acquisizione di transitori ad alta velocità (FTI: FAST TRANSIENT IMAGING).

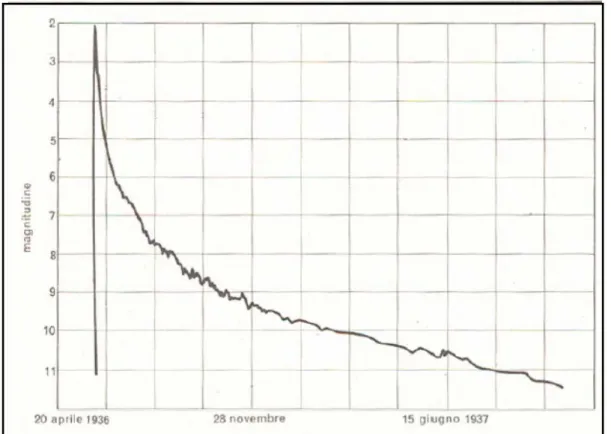

Altri fenomeni di breve durata e di notevole intensità che richiedono tali apparecchiature sono le evoluzioni delle novae, stelle dotate inizialmente di una luminosità molto debole e che, in seguito ad una esplosione di enormi proporzioni, aumentano anche di migliaia di volte la propria magnitudo. La curva di luce osservabile in corrispondenza di entrambi i fenomeni è molto simile: è visibile un picco iniziale della durata di poche ore, cui segue una coda che rimane visibile più a lungo, talvolta anche mesi, come risulta visibile dalla fig. 1.5.

Fig 1.5 : Curva di luce della nova CP Lacerate.

Infine, tra le potenziali applicazioni del FTI si ricorda l’osservazione di fenomeni che, seppur periodici, hanno durata molto breve: le pulsar. Queste sono stelle aventi, a grandi linee, la stessa massa del Sole, ma un diametro di circa trenta chilometri. Una dimensione così

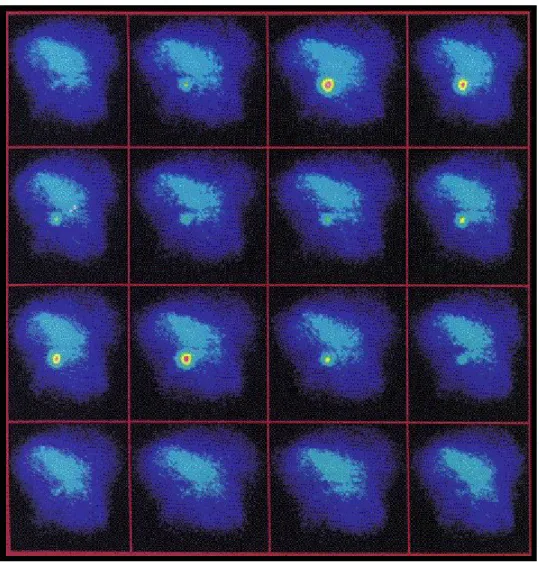

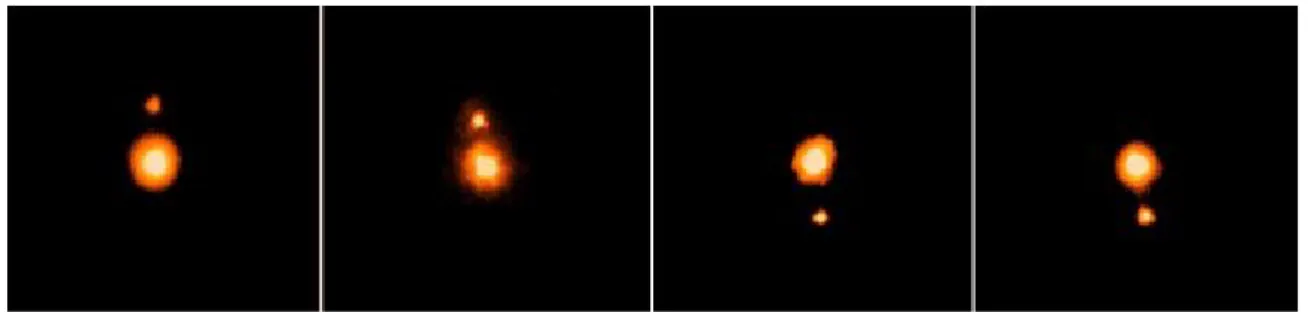

piccola, limita la dispersione termica a causa dell'esiguità della superficie; queste stelle pertanto emettono quantità ridotte di radiazione termica e sono di conseguenza invisibili a grande distanza. Sono però osservabili per un tipo di radiazione completamente differente: un segnale radio che si ripete, come una pulsazione (da cui il nome pulse star), ad intervalli regolari di alcuni millisecondi per le più veloci, di alcuni secondi per quelle più lente. Se ne conoscono, attualmente, circa trecento, ma solo due, la pulsar del Granchio e quella della Nebulosa Vela emettono impulsi visibili; un esempio è evidenziato in fig. 1.6.

La regolarità degli impulsi può essere così spiegata: la stella, ruotando, emette un fascio di radiazioni che ‘illumina’ il cielo come la luce di un faro, puntando nella direzione dell’osservatore una volta ogni giro. L’unico oggetto che può sopportare una velocità così elevata senza distruggersi per effetto della forza centrifuga è una stella di neutroni.

Fig 1.6 : Immagini di raggi X provenienti da Crab Nebula in un tempo di esposizione di 5 ore, pari ad un intero ciclo della pulsar.

Questi impulsi vennero intercettati per la prima volta nel 1967, e già l’anno seguente fu possibile osservare la sorgente di tali emissioni proprio grazie ad un pionieristico sistema di FTI.

1.2.2

Adaptive Optics

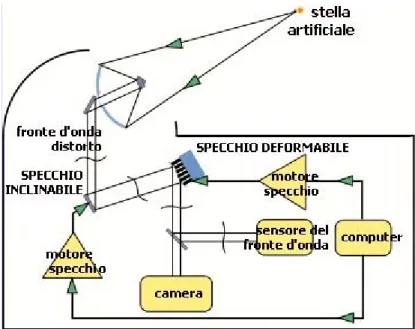

Normalmente si ritiene che il potere separatore di un telescopio sia governato unicamente dalle leggi della diffrazione, ovvero, praticamente, dal diametro del telescopio. Purtroppo, l'atmosfera fa sì che questo assunto sia tutt'altro che veritiero. Quando infatti la luce generata da un corpo celeste passa attraverso le turbolenze dell’atmosfera, i fotoni vengono deviati dalle sacche d’aria in movimento producendo sul rilevatore fotosensibile un’immagine distorta ed in rapido mutamento. Tale effetto è noto con il nome seeing. Conseguenza di ciò è che le immagini catturate dai telescopi astronomici risultano aberrate. Ebbene, l’ottica adattiva consente di correggere i disturbi dei fronti d’onda rapidi che si verificano nelle suddette circostanze. In figura 1.7 è mostrato un esempio di sistema di ottica adattiva.

Fig. 1.7 : Schema di funzionamento di un sistema di ottica adattiva.

La luce stellare viene confrontata con quella di una ‘stella artificiale’ al fine di misurare la distorsione introdotta dagli strati atmosferici. Grazie ad un analizzatore di immagini

estremamente veloce, viene misurata la qualità dell’immagine e, al ritmo massimo di cento volte al secondo, vengono inviati segnali correttivi ad un secondo piccolo specchio deformabile, situato di fronte al rilevatore nel percorso della luce nel telescopio. Poiché lo specchio cambia continuamente forma, l’effetto della turbolenza viene corretto ed il telescopio raggiunge una qualità delle immagini quasi pari a quella ottenibile se ci si trovasse nello spazio.

L’ottica adattiva convenzionale già da diversi anni è utilizzata da un discreto numero di telescopi a terra, e sta spingendo la risoluzione e il rapporto segnale-rumore verso le prestazioni che si avrebbero nello spazio. Nel giugno del 1999 il telescopio Gemini North è riuscito a separare l’immagine di Plutone da quella della sua luna Caronte, usando Plutone stesso come stella guida: fig 1.8.

Fig. 1.8 : Immagine di Plutone e della sua luna, Caronte, riprese presso il Gemini Observatory con tecniche di ottica adattiva.

1.2.3

Layer Sensing

L’ultima applicazione che il progetto SPADA si propone di realizzare è il Layer Sensing, grazie al quale sarà possibile studiare le caratteristiche, ottiche e fisiche, dei vari strati costituenti l’atmosfera e, ancora una volta, tutto ciò si potrà effettuare da postazioni terrestri.

Tale applicazione astronomica è strettamente connessa alla precedente di ottica adattiva, in quanto la caratterizzazione degli strati atmosferici rende possibile la previsione di fenomeni di scattering ed assorbimento della radiazione elettromagnetica durante l’attraversamento di questi ultimi, e costituisce un elemento di ausilio per la correzione delle aberrazioni delle immagini che ne derivano.

L’esperimento viene condotto nel seguente modo: ad intervalli regolari un impulso laser viene emesso verso l’atmosfera percorrendone in meno di un millisecondo tutti gli strati. I

fotoni di ritorno pervenuti in istanti successivi consentono di desumere le proprietà dei vari layer. Un esperimento di questo tipo è attualmente in corso presso l’installazione telescopica di William Herschel, sull’isola La Palma (Canarie) da un team dipendente dall’inglese University of Durham.

1.3 Caratteristiche generali del progetto SPADA

Come già anticipato, il progetto SPADA. si propone di soddisfare le richieste degli astronomi in merito ad alcune applicazioni il cui sviluppo si rivela di fondamentale importanza per l’acquisizione ed elaborazione di immagini ad opera di telescopi terrestri. In particolare l’Osservatorio Astrofisico di Catania e i quattro VLTI (Very Large Telescope Interferometer) dell’ ESO (European Southern Observatory) presso l’osservatorio di Paranal in Cile saranno le piattaforme di prova del sistema complessivo, che vede tutt’oggi impegnate nella sua realizzazione, oltre i sopra citati Osservatori, le seguenti unità di ricerca: il Dip. di Ingegneria dell’Informazione dell’Università di Pisa, per quel che riguarda l’acquisizione e l’elaborazione dei dati (DPE: Data Processing Electronics), ed il Politecnico di Milano che si è occupato della realizzazione del sistema di rivelazione e controllo (DEB: Detection Electronic Board).

Il progetto vanta, in particolare, l’utilizzo di un sistema di rivelazione d’avanguardia, basato su una matrice circolare di sensori SPAD, caratterizzato da un’elevata sensibilità anche alle fonti luminose più deboli, e da basse tensioni di utilizzo. Queste caratteristiche, unite all’impiego di un sistema di acquisizione molto veloce, fino a 20 Mcps, e di elaborazione dati in tempo reale, lo rendono concorrenziale nei confronti di altri sistemi rivolti anch’essi ad applicazioni astrofisiche.

1.3.1

Il sistema SPADA

La fig. 1.9 evidenzia l’architettura del sistema SPADA. In esso, una matrice di sensori SPAD (Single Photon Avalanche Diode), realizzata su silicio monolitico, è preposta all’acquisizione del segnale luminoso; ad essa è affiancata una scheda di controllo (DEB) che

fornisce, su 60 linee d’uscita attraverso due connettori SCSI a 68 pin con uscite differenziali (RS422), i dati da processare alla seconda scheda di elaborazione (DPE). Quest’ultima, in particolare, affiancata da altre schede ausiliarie, effettua il conteggio degli impulsi provenienti dalla DEB su ogni canale, ciascuno dei quali è relativo al rilevamento effettuato da un singolo sensore, genera segnali di sincronizzazione e sinusoidali, si occupa di gestire segnali generici di I/O ( Gate ed Interlock ). Inoltre tramite un’interfaccia utente su computer remoto, in cui vengono visualizzate le immagini rilevate dall’array di sensori, è resa possibile l’impostazione di parametri, quali la finestra temporale di acquisizione, e le elaborazioni richieste da ciascuna delle applicazioni. Infine una connessione firewire consente l’upload dei dati processati al computer remoto. Per ulteriori dettagli sul funzionamento del sistema e dei suoi componenti si rimanda alla bibliografia [1, 2, 27].

SP

ADA ho

usi

n

g

Detection electronic board

Data-Processing electronic board RS232

Firewire

remote Computer

1.3.1.1 Lo SPAD Array

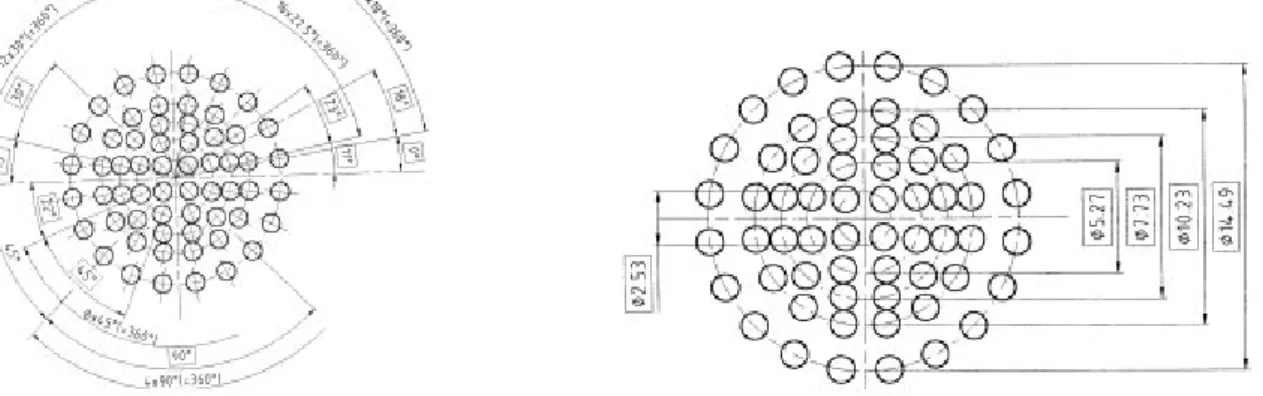

Particolare attenzione, per lo sviluppo del presente lavoro, merita l’elemento preposto all’acquisizione del segnale luminoso: l’array di sensori SPAD. Esso è costituito da 60 elementi SPAD posizionati nel centro di piccole sferette, come evidenziato in fig. 1.10, poste, a loro volta, sul piano focale di un array, di circa 16 mm di diametro, formato da piccole lenti. I pixel sono sufficientemente distanziati tra loro, così da evitare indesiderati fenomeni di crosstalk tra pixel adiacenti. Ai lati del die quadrato, fig. 1.11, in cui l’array circolare di SPAD trova la sua collocazione, vi sono altre strutture di test.

Fig. 1.10 : Punti focali che ospitano i sensori SPAD.

Fig. 1.11 : a ) Il chip SPADA

b) Ciascun wafer può contenere fino a 16 chip.

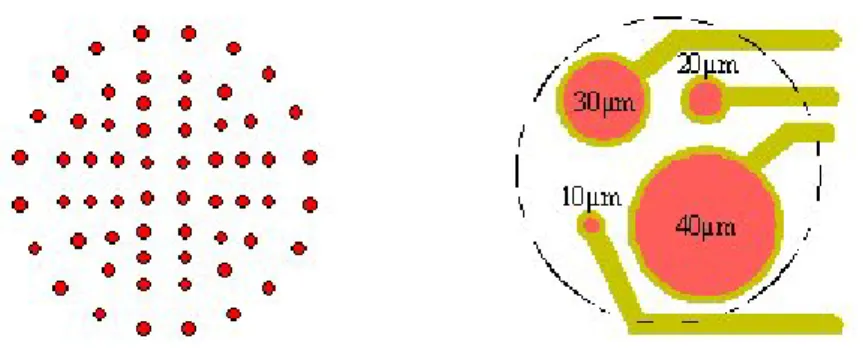

Al fine di ottimizzare lo sfruttamento dell’area di silicio disponibile, sono stati realizzati quattro sensori per ciascun pixel, come visibile nella fig. 1.12, aventi aree attive differenti.

Fig. 1.12 : Ciascun pixel ( sinistra ) è costituito da quattro SPADs aventi diametri differenti (destra).

Il supporto dello SPADA è un substrato ceramico di dimensioni 50 mm x 50 mm con piste metalliche e pin, venti per ciascun lato; questo è, a sua volta, posizionato in stretto contatto termico con una cella di Peltier, fig. 1.13.

Fig. 1.13 : a ) Supporto ceramico del chip Spada. b) Stadio di Peltier.

Infine, un sistema di ottica dedicata, provvede alla focalizzazione dei fronti di luce incidenti su ciascuno SPAD; questa è basata sul già citato sistema di microlenti e di 60 microsfere, distanziate dalla superficie dello SPADA di circa 66 µm, fig. 1.14.

Fig. 1.14 : a ) Microlenti.

Fig. 1.15 : Sistema di rivelazione SPADA.

Una visione globale del sistema di rivelazione è data in fig. 1.15 ; il rivelatore è realizzato in modo da consentire un accoppiamento diretto con il sistema MACAO (Multi-Application Curvature Adaptive Optics) dell’ESO.

1.3.1.2 Il sistema di acquisizione ed elaborazione

La Data-Processing Electronic Board, sviluppata dall’unità di lavoro dell’Università di Pisa, è collocata tra la Detection Electronic Board ed il computer remoto. Ad essa sono affidate l’acquisizione e l’elaborazione dei segnali provenienti dal sensore SPADA; in particolare deve provvedere a:

¾ contare i fotoni segnalati su ciascuno dei 60 ingressi (la durata tipica di un impulso è di 10ns, il massimo counting-rate di 20 Mcps);

¾ generare segnali di sincronizzazione e sinusoidali;

¾ gestire, insieme alla DEB, segnali di gate ed interlock hardware e software;

¾ gestire le finestre temporali, di durata programmabile dall’utente, e le elaborazioni dati richieste dalle tre applicazioni cui è preposta: FTI, AO, LS.

Infine effettua l’upload dei dati processati al computer remoto, via Firewire.

L’elevata sensibilità nonché l’estrema flessibilità, fanno di questo sistema un ottimo strumento in applicazioni, anche non strettamente astrofisiche, in cui la velocità risulta un parametro critico, quale si rivela nel presente caso.

1.4 Validazione di un sistema complesso

La realizzazione contestuale, tra le diverse unità di ricerca coinvolte nel progetto SPADA, dei sistemi di rivelazione ed acquisizione, ha fatto sorgere l’esigenza di collaudare quest’ultimo anche in fasi antecedenti la completa realizzazione del primo, al fine di rivelare tempestivamente eventuali suoi malfunzionamenti.

Si delineano, nel seguito, gli aspetti fondamentali del collaudo di un sistema elettronico e le nuove direzioni verso le quali si sta indirizzando.

1.4.1

Il collaudo di sistemi digitali

Il collaudo è un passo di progetto che riveste un ruolo fondamentale nella realizzazione di circuiti integrati (VLSI). Infatti se in ogni ambito produttivo è necessario verificare la funzionalità di un oggetto pensato per adempiere ad un determinato scopo, questa necessità risulta oggigiorno acuita dal processo industriale, in cui è prevista una produzione in larga scala dei dispositivi ideati che, peraltro, diventano sempre più complessi e difficili da collaudare.

Per test si intende l’insieme di tutte le procedure di controllo atte a verificare, con un predefinito margine di errore, la rispondenza del dispositivo sia alle specifiche di progetto logico (funzionali) che alle specifiche parametriche.[31]. Si definisce ‘guasto’, invece, un qualunque evento che determina l’impossibilità di un sistema a comportarsi secondo le specifiche di progetto.

Le cause di guasto possono essere molteplici: errori di progetto, di fabbricazione, o ancora di cattivo utilizzo. L’individuazione tempestiva di questi è un fattore fondamentale nella realizzazione di circuiti integrati, in quanto il costo del collaudo segue un andamento esponenziale nel passaggio dalla fase di progetto a quella finale di produzione in larga scala. In quest’ottica sembrerebbe che risulti conveniente collaudare un circuito ogni volta se ne presenti l’occasione ed il più possibile, ma è necessario tener presente che testare ha un suo costo e in termini di sviluppo e in termini di tempo di utilizzo dei macchinari utilizzati a questi scopi (ATE : Automatic Test Equipment). Inoltre l’aumento della densità dei transistori per mm2 e l’aumento della frequenza di funzionamento rendono il collaudo sempre più

difficoltoso e costoso.

Si possono distinguere quattro tipi di collaudo [32]: ¾ esaustivo;

¾ pseudo-casuale; ¾ strutturale; ¾ funzionale.

Il collaudo esaustivo prevede l’applicazione, come sequenze (pattern) test, di tutte le possibili combinazioni degli ingressi, in ogni possibile stato del sistema. Questo approccio risulta applicabile solo in caso di circuiti semplici e con pochi ingressi, in caso contrario ne deriverebbero tempi di testing intollerabilmente lunghi2.

Il collaudo casuale prevede la generazione di pattern in modo casuale o pseudo-casuale; questa tecnica risulta largamente utilizzata in quanto di facile applicazione e ne deriva un collaudo non certamente esaustivo ma che può essere arrestato comunque quando la copertura ottenuta è considerata sufficiente. In quest’ottica è quindi importante trovare i pattern che massimizzano la copertura e che siano i più compatti possibile al fine di ridurre i tempi di test.

Il collaudo strutturale prevede che queste sequenze eccitino una serie di guasti contenuti in una lista (fault list) stabilita a priori. In questo modo si ha una elevata conoscenza della copertura ed una elevata capacità diagnostica ma è necessario avere in tal caso una conoscenza dettagliata della struttura fisica del circuito, di conseguenza la lista dei guasti risulta correlata e dipendente dalla realizzazione del progetto.

Infine, il collaudo funzionale tende a verificare il corretto funzionamento del sistema rispetto alle sue specifiche funzionali piuttosto che a certificare l’assenza di guasti. Un test di questo tipo non richiede la conoscenza topologica dell’unità da testare, può essere effettuato alla velocità di clock di effettivo utilizzo e risulta indipendente dai motivi di guasto.

I modelli di guasto tradizionalmente considerati sono sempre applicabili alla realtà fisica del dispositivo e sono sostanzialmente di tre tipi: errori di tipo ‘stuck at’, errori di tipo ‘bridge’ ed errori di ritardo. I primi ipotizzano che un nodo della rete sia fisso ad un determinato livello logico; quelli di tipo ‘bridge’ ipotizzano la presenza di cortocircuiti non voluti tra coppie di

2

Per un sommatore a 32 bit, un test esaustivo realizzato applicando un pattern ogni nanosecondo, comporterebbe un ammontare di tempo pari a più di mille anni.

nodi della rete; infine il terzo tipo tende a rappresentare gli errori che si presentano alla frequenza operativa di clock. Da queste considerazioni deriva che il concetto di testabilità per i circuiti integrati è stato tradizionalmente definito e sfruttato solo a basso livello. D’altra parte, grazie all’evoluzione degli strumenti di sintesi, molte attività si sono spostate dal livello gate a quello RT (Register Transfer); si richiedono, quindi, la validazione e la valutazione delle prestazioni del circuito in esame.

1.4.2

Il collaudo funzionale

Il testing funzionale è orientato alla validazione del corretto funzionamento di un sistema digitale rispetto alle sue specifiche funzionali. In quest’ottica i tradizionali metodi di collaudo, che provvedono a generare dei vettori di test mirati all’individuazione di errori nelle struttura fisica dei dispositivi, risultano inadeguati; offrono infatti una minima garanzia sul fatto che il sistema sia stato correttamente descritto affinché realizzi le funzionalità richieste. I ‘faults’ di progetto sono errori non-fisici provocati da imperfezioni introdotte in un sistema durante la sua descrizione. Di conseguenza è necessario ricercare nella generazione automatica di vettori di test (ATG) quei meccanismi che consentano di validare l’architettura del sistema, scongiurando ‘design errors’ il cui costo risulta esorbitante nell’ambito della progettazione di circuiti digitali.

Attualmente la correttezza dei sistemi è spesso verificata realizzando dei programmi di test

ad-hoc ; in quest’ambito al programmatore è richiesto il compito di scrivere dei programmi, atti

alla validazione del sistema da testare, con linee guida a volte piuttosto vaghe [33], quali l’esercizio di ciascuna istruzione almeno una volta. Questi sono i principi su cui si basano gli algoritmi genetici per la generazione automatica di sequenze di test, ideati imitando i processi osservati nell’evoluzione naturale ed atti alla realizzazione di collaudi ad alto livello. Questi ultimi, sono tipi di collaudo utilizzati in ambiti in cui debbano essere testati circuiti la cui descrizione a livello gate non risulta accessibile ma il cui funzionamento è fornito o facilmente ricostruibile.

Se ad esempio si considera un modello di guasto di tipo stuck-at esso ha certamente un significato ben preciso se si pensa ad un layout di un circuito o ad una sua descrizione

comportamentale a basso livello. Per rilevare questo guasto è necessario fornire alla rete una serie di pattern atti ad ‘eccitare’ il guasto. Ma se si è in presenza di una descrizione ad alto livello non risulta significativo parlare di guasti per istruzioni complesse, che richiedono, per essere implementate, un gran numero di porte logiche, ciascuna delle quali possibile di guasto. D’altra parte se si considera che uno stesso blocco funzionale è spesso utilizzato più volte durante l’esecuzione della descrizione ad alto livello si può pensare che non occorrerà testare completamente il circuito per ciascuno di tali blocchi in quanto si testerebbe più volte lo stesso blocco con una inevitabile perdita di tempo [32]. Da ciò la scelta di scrivere dei programmi che prevedano che ciascuna istruzione, di un linguaggio ad alto livello, sia verificata almeno una volta. Tuttavia questi approcci ‘ad hoc’ potrebbero non dare i risultati sperati [33]. In alternativa, si trovano in letteratura dei metodi di generazione automatica di vettori di test a livello funzionale che sembrano offrire buone qualità e riduzione di tempi e costi di collaudo. Tali sistemi generano vettori di test direttamente dalle specifiche funzionali di un sistema digitale utilizzando modelli di guasto livello e generazione di vettori di test multi-stadio[33].

Nel presente lavoro si è tuttavia scelto di realizzare un sistema di testing dedicato, che stimolasse il sistema sotto test in una modalità di funzionamento quanto più possibile vicina a quella prevista nella sua vita operativa, privilegiando una forma di validazione del sistema globale più che di ciascuna delle sue parti. Si è, di conseguenza, deciso di realizzare un sistema atto ad emulare i segnali provenienti dalla Detection Board e destinati al sistema di acquisizione, ed inserendo opportunamente delle pseudo-aleatorietà, si è fatto in modo di produrre delle sequenze pseudo-random che potessero individuare eventuali ‘faults’ presenti, e fornire una copertura reputata adeguata alle esigenze richieste.